聊到降低 AI 模型复杂度,这事儿现在可是越来越关键了。你想啊,模型做得再厉害,要是复杂到根本没法落地,那有啥用?尤其是现在企业都在喊着要降本增效,AI 模型的轻量化和部署成本控制,简直成了绕不开的坎儿。今天就来好好聊聊,到底有哪些靠谱的途径能让模型 “瘦下来”,还不耽误干活。

🛠️ 模型结构优化:从根上给模型 “减负”

要说降低复杂度,最直接的肯定是从模型本身的结构下手。这就好比盖房子,要是设计不合理,材料用得再多也白搭。现在很多研究都在琢磨怎么简化模型结构,同时还能保住性能。

剪枝技术绝对是这里面的狠角色。你想啊,模型训练的时候,难免会有一些神经元或者权重参数是 “打酱油” 的,平时没啥用,还占地方。剪枝就是把这些没用的 “枝丫” 剪掉,让模型一下子清爽不少。就拿卷积神经网络来说,有些卷积核的输出几乎为零,留着它们干啥?直接剪掉,模型参数能少一大截,计算速度也能提上来。不过剪枝也不是瞎剪,得有策略,比如根据权重大小来判断,或者通过测试看看剪掉哪些不影响精度,不然把有用的剪掉了,那模型可就废了。

还有知识蒸馏,这招也挺巧妙。简单说就是找个 “老师” 模型和一个 “学生” 模型。老师模型复杂但性能好,学生模型简单但能力弱。让学生跟着老师学,把老师的知识 “蒸馏” 到自己身上,最后学生模型能达到和老师差不多的水平,但复杂度却低得多。就像咱们上学的时候,老师把复杂的知识简化了教给我们,我们虽然没老师那么厉害,但也能掌握核心内容。这种方法在图像识别、自然语言处理这些领域用得特别多,效果是真不错。

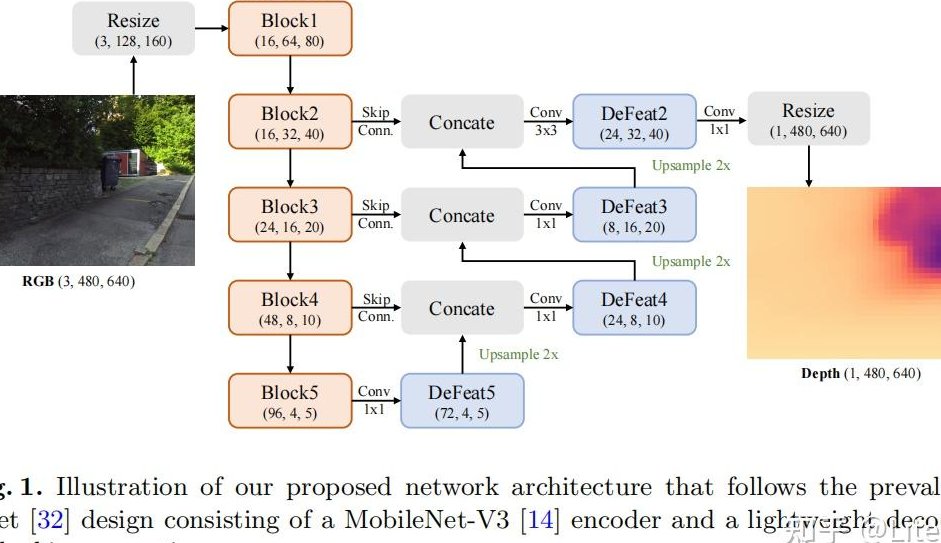

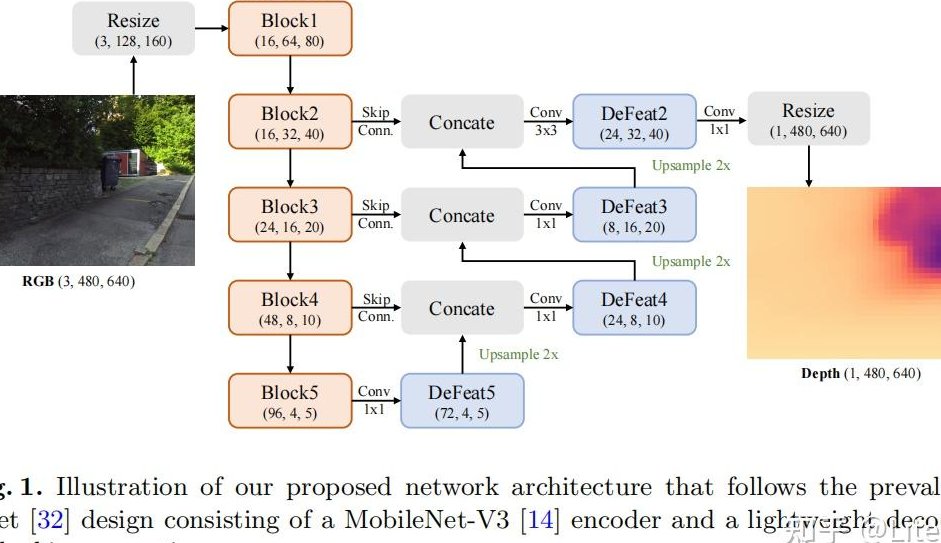

轻量化模型设计也是个大趋势。现在专门为移动端或者边缘设备设计的模型越来越多,比如 MobileNet、EfficientNet 这些。它们用了深度可分离卷积之类的技术,把原来复杂的卷积操作拆解开,既能保证特征提取效果,又能大大减少计算量。你看现在很多手机上的 AI 功能,背后其实都是这些轻量化模型在支撑,不然就凭手机那点算力,根本扛不住复杂模型的折腾。

📊 数据层面优化:用更少的数据办更多的事

模型训练离不开数据,但数据太多太杂,也会让模型变得臃肿。所以从数据层面优化,同样能降低模型复杂度。毕竟,如果数据质量高、数量合适,模型就不用费劲去学习那些没用的噪声,自然就能变得更简洁。

数据清洗和筛选是第一步。很多时候,我们收集到的数据里混了不少错误的、重复的或者和任务无关的内容。这些 “脏数据” 会让模型在训练的时候走弯路,为了拟合这些没用的数据,模型可能会变得越来越复杂。所以,把数据好好筛一遍,留下那些高质量、和任务高度相关的数据,模型训练起来就能更专注,复杂度自然就降下来了。比如做文本分类,要是数据里有很多乱七八糟的广告、乱码,不清理掉,模型肯定得花更多精力去处理,结果还不好。

数据增强虽然是增加数据量,但其实也能帮模型变得更简单。通过对现有数据进行旋转、裁剪、加噪声这些操作,让模型在有限的数据上接触到更多样的情况。这样模型不用学那么多复杂的模式,就能应对各种场景,相当于用更少的 “原始数据” 达到了更好的泛化能力,间接也就降低了对复杂模型结构的依赖。你想啊,模型见多识广了,就不用搞得那么复杂去应付各种意外情况了。

小样本学习更是直接冲着 “少数据” 去的。现在很多场景下,收集大量标注数据成本太高了,比如医疗影像诊断,优质的标注数据少得可怜。小样本学习就是让模型在只有少量样本的情况下也能学好,这就要求模型更高效地利用数据,不能再像以前那样靠堆砌参数来死记硬背。这种情况下,模型本身也得设计得更精巧,复杂度肯定高不了。

🔄 量化技术:给模型 “压缩打包”

量化技术这东西,简直是为模型部署量身定做的。咱们都知道,模型里的参数通常是用 32 位浮点数来表示的,精度是高,但太占内存和算力了。量化就是把这些高精度的参数转换成低精度的,比如 16 位、8 位,甚至是 4 位、2 位。你可别小看这位数的变化,对模型的存储和计算来说,影响太大了。

就拿深度学习模型来说,用 8 位整数代替 32 位浮点数,模型的大小能直接降到原来的四分之一,计算速度也能提升不少。这对于那些内存有限的设备,比如嵌入式设备、智能手表,简直是福音。不过量化也不是没有代价,精度降了,会不会影响模型性能呢?现在的研究越来越成熟了,很多时候通过一些校准方法,能让量化后的模型性能损失控制在很小的范围内,完全能满足实际需求。

现在很多框架都支持量化操作了,比如 TensorFlow Lite、PyTorch Mobile,用起来也越来越方便。可以说,量化技术是平衡模型性能和复杂度的一个非常实用的手段,尤其是在移动端和边缘计算场景,几乎是必备的优化方法。

🌐 部署策略优化:让模型 “因地制宜”

模型训练好了,怎么部署也很关键。不同的部署环境,对模型复杂度的容忍度可不一样。要是能根据部署环境的特点来调整模型,也能大大降低实际应用中的复杂度。

边缘计算就是个好思路。以前很多 AI 任务都得靠云端服务器来处理,模型复杂点没关系,反正服务器算力强。但现在设备越来越智能,把模型部署到边缘设备上,让数据在本地处理,既能减少延迟,又能降低对云端算力的依赖。这时候模型就必须得简单点,不然边缘设备扛不住。所以,针对边缘设备的特点来优化模型,比如根据设备的算力、内存来调整模型大小,是非常必要的。

动态推理也挺有意思。简单说就是让模型在不同的情况下 “灵活应变”。比如面对简单的输入,就用小模型或者模型的轻量版本来处理;面对复杂的输入,再调用大模型。这样平均下来,模型的整体复杂度就降低了。就像咱们处理工作,简单的活儿随便弄弄就行,复杂的活儿再认真琢磨,效率不就上来了吗?这种方法在推荐系统、图像识别这些场景里用得越来越多,既能保证效果,又能节省资源。

还有模型拆分部署,把一个复杂的模型拆成几个部分,分别部署在不同的设备上,比如一部分在边缘设备,一部分在云端。这样每个部分的复杂度都不高,协同工作就能完成原来复杂模型的任务。这就像流水线作业,每个人负责一小块,整体效率反而更高。

💻 算法优化:让模型 “更聪明地学习”

除了模型结构和部署,算法层面的优化也能帮模型 “减负”。有时候不是模型本身不够简单,而是学习方法太笨,导致模型不得不变得复杂。所以,让模型更聪明地学习,也能降低复杂度。

优化器的选择就很重要。不同的优化器,对模型的收敛速度和最终的复杂度影响很大。比如 Adam 优化器,相比传统的 SGD,往往能让模型更快地收敛到较好的状态,可能不需要那么多的参数就能达到目标。还有一些自适应学习率的优化器,能根据参数的重要性来调整学习率,让模型在关键参数上多下功夫,不重要的参数少花精力,间接也就降低了模型的复杂度。

正则化技术也不能少。过拟合是导致模型复杂的一个重要原因,模型为了拟合训练数据中的所有细节,包括噪声,会变得越来越复杂。正则化,比如 L1 正则、L2 正则,能限制模型参数的大小,防止模型过度拟合,让模型更简单、更通用。这就像给模型上了个 “紧箍咒”,不让它在错误的道路上越走越远。

低秩分解也是个好方法。很多模型的参数矩阵其实是低秩的,也就是说可以分解成几个小矩阵的乘积。这样一来,原来需要存储一个大矩阵的参数,现在只需要存储几个小矩阵的参数,参数数量能大大减少,计算量也跟着降下来。在自然语言处理中的 Transformer 模型里,就有不少地方用到了低秩分解,效果还真不错。

📈 成本控制:让模型优化 “有利可图”

说了这么多降低复杂度的技术,最终还是要落到成本上。要是优化的成本比模型本身的成本还高,那谁还愿意做呢?所以,在优化过程中,必须得考虑成本控制。

选择合适的硬件太关键了。不同的硬件对模型的支持程度不一样,比如 GPU 和 TPU 在处理深度学习任务时效率就比 CPU 高得多。如果能根据模型的特点选择合适的硬件,能大大降低部署成本。比如轻量化模型在 ARM 架构的芯片上运行效率很高,那部署的时候就尽量选这类硬件,能省不少钱。

开源工具和框架也能帮上大忙。现在有很多优秀的开源工具,比如 TensorFlow、PyTorch,还有专门做模型压缩的工具库,像 TensorRT、ONNX Runtime。用这些开源工具,不用自己从零开始开发,能节省大量的时间和人力成本。而且这些工具更新迭代很快,总能跟上最新的技术趋势,用起来也放心。

自动化优化流程也很重要。手动优化模型不仅效率低,成本也高。现在很多平台都提供了自动化的模型压缩和优化工具,能自动完成剪枝、量化这些操作,还能根据部署环境自动调整模型参数。这样一来,就算是技术不太强的团队,也能轻松完成模型优化,大大降低了门槛和成本。

降低 AI 模型复杂度,从来都不是单一技术能搞定的事,得从模型结构、数据、算法、部署等多个方面一起发力。而且这事儿也不是一蹴而就的,需要不断地尝试和调整。但不管怎么说,目标都是明确的:让模型变得更简单、更高效、更便宜,能真正在实际场景中发挥作用。毕竟,能落地的 AI 才是好 AI,你说对吧?