🤖 AI 文本检测的现状:准确率是个大问题

现在市面上的 AI 文本检测工具不少,但用过的人都知道,准确率真的让人头疼。有时候明明是自己一字一句写的原创,结果被检测成 “AI 生成”;反过来,有些用 AI 写的内容稍微改改,却能轻松蒙混过关。这种情况不仅让创作者糟心,对平台来说也是个麻烦 —— 误判会打击原创者的积极性,漏判又会让大量低质 AI 内容泛滥。

我前段时间就遇到个事儿。一个朋友做自媒体,辛辛苦苦写了篇关于职场的文章,里面加了不少自己的真实经历,结果平台用的检测工具直接标红,说有 80% 是 AI 生成的。他申诉了好几次才解决,但那篇文章的推荐量已经掉得没法看了。这就是现在 AI 文本检测的尴尬 —— 技术跟不上 AI 生成内容的进化速度,导致误判率居高不下。

为什么会这样?核心原因在于 AI 生成内容的技术迭代太快了。从早期的 GPT-3 到现在的各种大模型,生成的文本越来越自然,甚至能模仿人类的语气、逻辑,连错别字、口语化的表达都能模拟。而检测工具呢?很多还停留在 “找规律” 的阶段,比如统计特定词汇的出现频率、分析句式结构是否 “过于规整”,这种方法对付早期 AI 还行,现在基本不管用了。

🛠️ 算法优化:提升准确率的基础工程

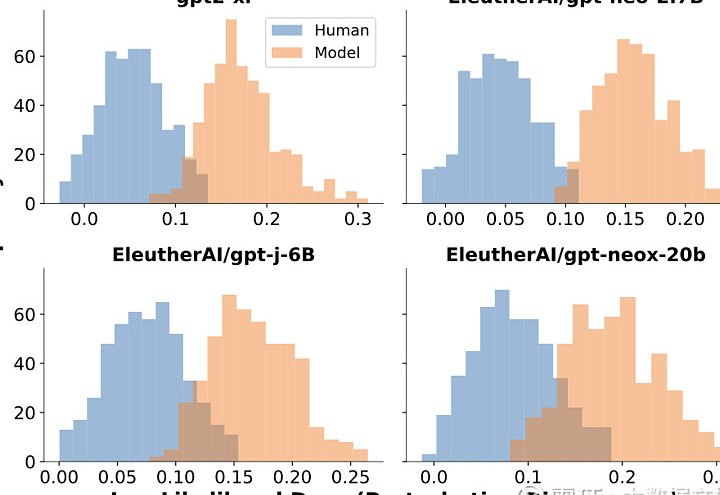

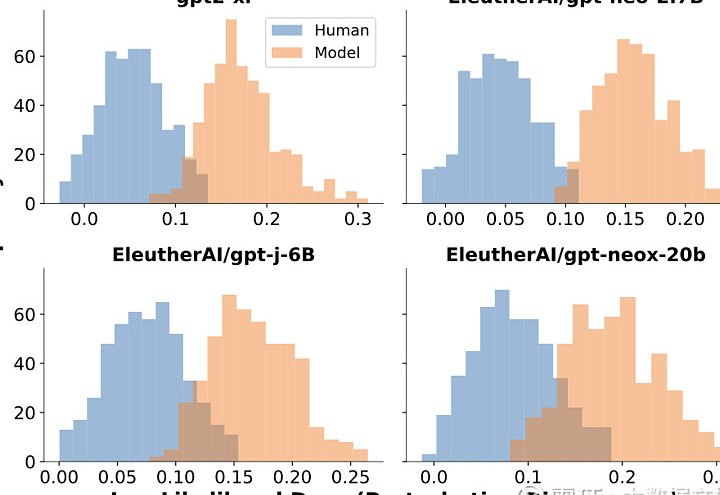

要提高 AI 文本检测的准确率,算法优化是绕不开的坎。现在主流的检测算法大概有两类:一类是基于统计特征的,另一类是基于深度学习的。但这两种都有明显的短板,必须针对性地优化。

先说统计特征算法。它的思路是找 AI 生成文本的 “共性”,比如某些连接词的使用频率、句子长度的分布规律等。但问题是,现在的 AI 模型能轻松打破这些规律。比如以前 AI 爱用 “然而”“因此” 这类词,现在你让它少用,它就真的能少用。所以单纯靠统计特征,很容易被 “反制”。优化的方向,应该是从静态特征转向动态特征。比如不只是看某个词用了多少次,而是看这个词在上下文里是否 “合理”,是否符合人类的思维逻辑。举个例子,人类写东西的时候,可能会突然插入一句 “哦对了,忘了说”,这种 “跳脱” 的表达,AI 很难完美模仿,这就是可以捕捉的动态特征。

再说说深度学习算法。现在很多检测工具开始用神经网络,比如训练一个模型专门学 “人类写作模式”,再用它去对比待检测文本。但这种方法的缺陷是 “过拟合”—— 如果训练数据里的人类文本大多是正式文体,那遇到口语化的内容就容易误判。优化的关键在于扩大训练数据的多样性。不仅要包含新闻、论文这类 “正经” 文本,还要加入微博评论、聊天记录、甚至小学生作文,让模型见过足够多的 “人类表达方式”。另外,还得给模型加入 “对抗训练”,就是用各种 AI 生成的文本去 “攻击” 它,逼着它学会分辨那些被刻意修改过的 AI 内容。

还有个容易被忽略的点:多语言场景的适配。现在很多 AI 模型能生成多语言文本,但检测工具大多只擅长处理英文或中文。比如一篇中英混合的文章,中文部分检测准,英文部分就乱标,这种情况很常见。所以算法优化必须考虑多语言环境,不能只盯着单一语种。

🤝 多模型融合:1+1 远大于 2 的效果

单一算法再怎么优化,能力都是有限的。这就像破案,一个侦探可能有疏漏,多个侦探从不同角度分析,就能更接近真相。AI 文本检测也是一个道理,多模型融合才是提升准确率的关键。

具体怎么融合?不是简单地把几个模型的结果加起来,而是要让它们 “各司其职”。比如可以让一个模型专注于检测语法的 “自然度”,另一个模型专注于分析内容的 “逻辑性”,还有一个模型专门看 “情感表达” 是否真实。最后把这三个模型的结果综合起来,给出一个加权评分。

举个例子,有篇文本被第一个模型判定为 “80% AI 可能”,因为它的语法太 “完美” 了,几乎没有病句。但第二个模型发现,这篇文章的逻辑有问题,前面说 “喜欢吃辣”,后面又说 “从不吃辣”,这种矛盾在人类写作中很常见,但 AI 生成时如果没做好上下文关联,也可能出现。第三个模型则检测到,文章里的情感表达很生硬,比如描述 “开心” 时,只用了 “很高兴”,没有具体的场景和细节。综合这三个结果,可能最终判定 AI 生成的概率其实没那么高,避免了单一模型的误判。

多模型融合还要解决 “权重分配” 的问题。不同场景下,各个模型的重要性不一样。比如检测学术论文时,“逻辑性” 模型的权重应该高一些,因为学术写作对逻辑严谨性要求高;而检测社交媒体内容时,“情感表达” 模型的权重就得加大,因为口语化的内容更看重情感的真实性。这就需要根据实际场景动态调整权重,而不是搞 “一刀切”。

🧐 对抗 AI 生成:道高一尺魔高一丈的博弈

AI 文本检测和 AI 生成内容,本质上是一场 “攻防战”。你这边刚优化了检测算法,那边就会出现新的 “规避技巧”。所以提升准确率,不能只想着 “防守”,还得研究 “进攻方” 的套路。

现在有很多人分享 “如何让 AI 内容通过检测”,比如把 AI 生成的文本打乱段落顺序、故意加几个错别字、替换一些近义词。这些方法看似简单,却能让不少检测工具失效。为什么?因为很多工具太依赖 “句式工整”“用词规范” 这些特征了。针对这种情况,检测算法必须学会 “透过现象看本质”,不管文本被怎么修改,只要核心逻辑、思维模式是 AI 的,就能识别出来。

比如,人类写作时,思维是 “跳跃” 的,可能会突然想到一个新观点,然后补充进去,导致段落结构看起来有点乱。但 AI 生成时,即使打乱段落,整体的逻辑链条还是 “线性” 的,很少有这种 “突发奇想” 的痕迹。检测工具如果能捕捉到这种 “思维痕迹”,就能识破大部分 “小伎俩”。

另外,还可以引入 “溯源机制”。现在很多 AI 生成内容会留下 “数字指纹”,比如特定模型生成的文本,在某些隐藏特征上是一致的。如果检测工具能识别这些指纹,就能直接锁定 “AI 身份”。不过这需要和 AI 模型开发商合作,或者通过大量样本训练来提取指纹,难度不小,但效果会很直接。

🔍 用户反馈:提升准确率的 “隐形助手”

不管技术多先进,最终还是要服务于用户。AI 文本检测的准确率高不高,用户的感受最直观。所以把用户反馈纳入优化流程,是提升准确率的重要一环。

很多检测工具都有 “误判申诉” 功能,但大多只是走个形式,用户反馈后石沉大海。这其实是在浪费宝贵的数据。用户指出 “这篇明明是原创却被误判”,这正好是算法的 “盲区”;用户说 “这篇 AI 写的没检测出来”,这就是算法的 “漏洞”。把这些反馈收集起来,针对性地调整模型参数,比闭门造车有效得多。

比如某平台的检测工具,之前总把 “网络小说” 误判为 AI 生成,因为网络小说里的对话多、句式简单,符合 AI 的某些特征。后来大量用户反馈后,团队专门收集了上万篇网络小说样本,重新训练模型,误判率一下子降了 40%。这就是用户反馈的价值 —— 它能帮你找到算法看不到的 “特殊场景”。

但用户反馈也不能盲目采纳。有些用户自己也搞不清什么是 AI 生成,可能会把别人的原创当成 AI 内容举报。这就需要建立一套 “反馈筛选机制”,比如结合人工审核,先判断反馈是否合理,再把有效的反馈纳入训练数据。

🚀 未来方向:让检测工具更 “懂” 人类

AI 文本检测的终极目标,不应该是 “打败 AI”,而是 “保护人类原创”。所以未来的优化方向,一定是让检测工具更 “懂” 人类 —— 不仅能识别 AI 生成的文本,还能理解人类写作的 “灵魂”。

比如,可以引入 “创作轨迹分析”。人类写作时,会有修改、删减、补充的过程,这些痕迹(比如草稿、修改记录)都能证明内容的原创性。如果检测工具能结合这些轨迹数据,准确率会大大提升。现在有些平台已经在尝试,比如在用户发布内容时,同步上传创作过程中的修改记录,作为辅助判断依据。

另外,跨模态检测也是个趋势。文字只是表达的一种形式,人类创作时往往会结合图片、视频、音频等多种形式。比如一篇游记,配上自己拍的照片、视频,AI 很难模仿这种 “多维度原创”。检测工具如果能综合这些跨模态信息,就能更精准地判断内容是否为人类原创。

当然,技术再先进,也不能完全替代人工。AI 文本检测始终是个辅助工具,最终还是需要人来判断那些 “模糊地带”。比如有些内容半 AI 半原创,检测工具拿不准,这时候就需要人工介入。所以未来的模式,一定是 “AI 初筛 + 人工复核”,既保证效率,又避免误判。

总的来说,提升 AI 文本检测的准确率,不是单一技术能解决的问题,需要算法优化、多模型融合、对抗策略、用户反馈多管齐下。这条路肯定不好走,但只要方向对了,总能一点点进步。毕竟,保护原创者的积极性,让优质内容脱颖而出,才是这个行业该有的样子。