🤖 AI 改写的 “甜蜜陷阱”:为什么准确性总是差一口气

AI 改写工具现在火得不行,打开网页随便搜搜,各种 “一键改写”“智能扩写” 的工具一抓一大把。但用过的人都知道,这些工具改出来的东西,经常看起来顺顺当当,仔细一看全是 “暗坑”。不是数据年份写错了,就是人名职务张冠李戴,更要命的是有些专业术语被改得面目全非。

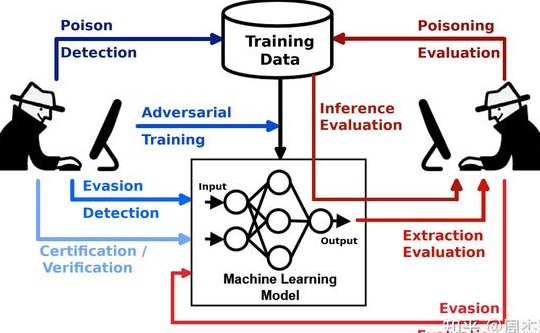

这背后藏着 AI 模型的 “先天缺陷”。现在主流的大语言模型,本质上是在预测 “下一个词该是什么”,它追求的是 “语言流畅度” 而不是 “事实准确性”。就像学生写作文,为了凑字数和通顺,可能会编造细节 ——AI 干的是类似的事,只不过它的 “编造” 更隐蔽,因为它会基于已有数据进行 “合理化推演”。

训练数据的质量直接决定了 AI 改写的底线。如果模型学了太多过时的信息,比如 2020 年之前的疫情数据,改写到 2025 年的文章里就会出大问题。还有那些来源不明的网络内容,里面的错误信息会被 AI 当成 “正确知识” 吸收,再通过改写传递出去。

最麻烦的是专业领域。比如法律条文、医疗知识这些需要精准表述的内容,AI 很容易 “望文生义”。有次帮律所改一篇合同解读,AI 把 “连带责任” 改成了 “共同责任”,这两个词在法律上差着十万八千里,要是直接用出去,麻烦就大了。

🔍 事实核查:给 AI 内容装上 “过滤器”

事实核查不是简单看看对错,得有套固定流程。我见过不少团队,觉得 AI 改完大概看看就行,结果栽过好几次跟头。正经的核查,得像侦探破案一样,一步一步来。

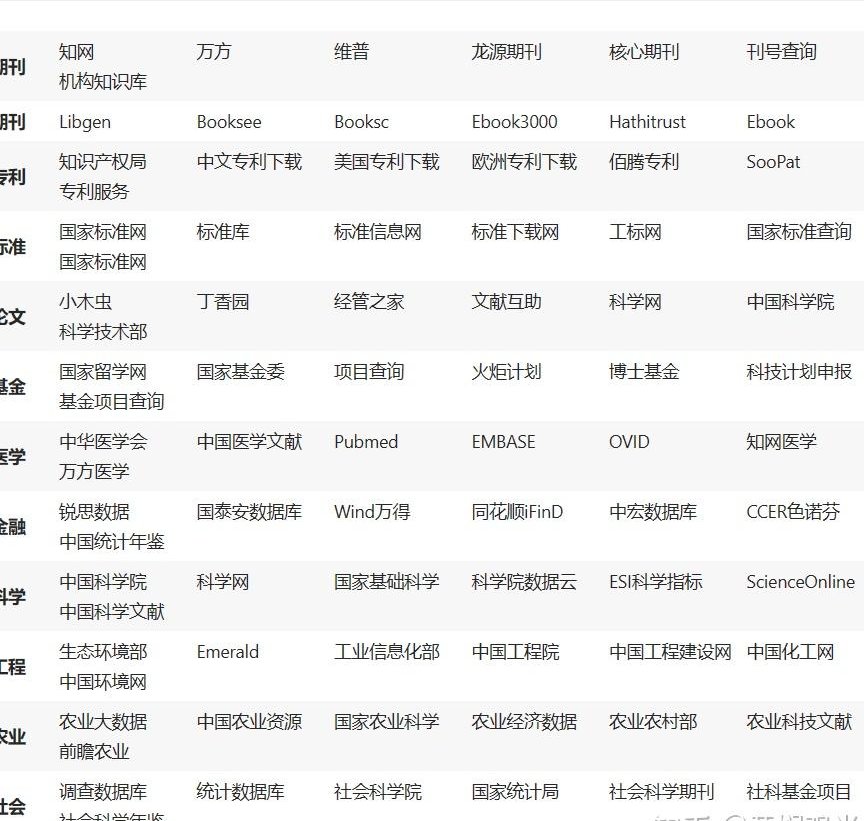

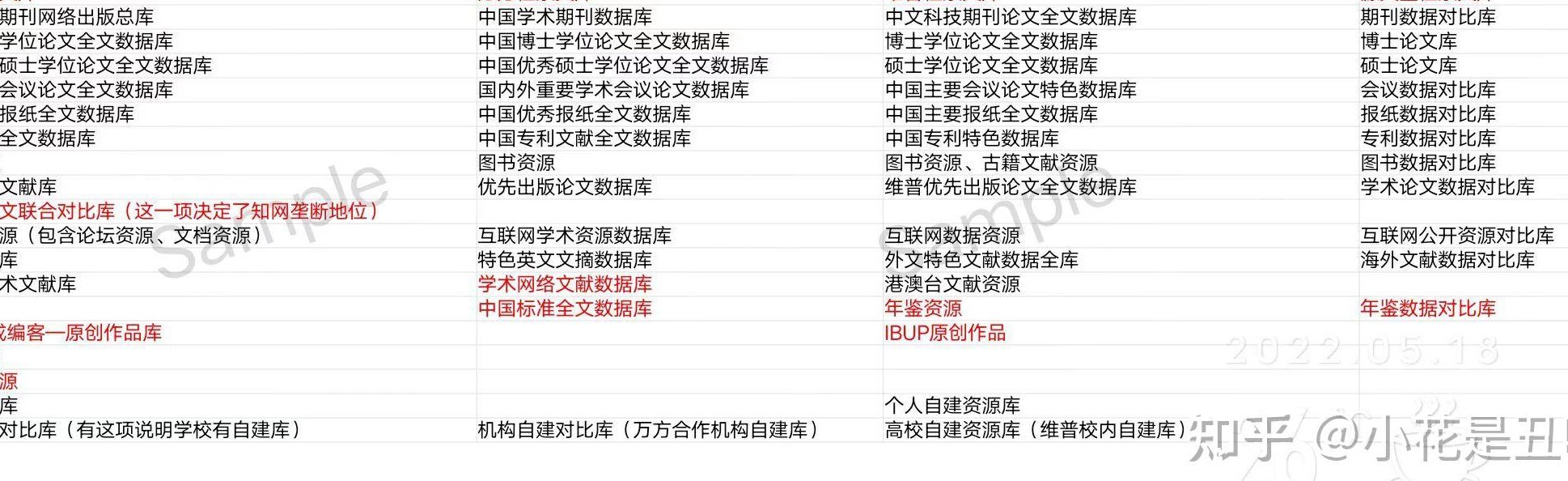

交叉验证是最基础的招。不管 AI 给出什么信息,至少要找三个不同的权威来源核对。比如提到某个行业数据,不能只信 AI 引用的报告,得去统计局官网查原始数据,再找两家行业协会的报告对比。三个来源对得上,才算基本靠谱。

溯源核查更关键。AI 经常会 “引用” 一些听起来很厉害的研究,但你真要去找原文,可能根本不存在。有次改一篇科技文章,AI 说 “2024 年某大学研究显示”,结果我们去查,这所大学根本没做过这个研究,是 AI 自己编的。所以必须从结论倒推,找到最初的信息源头,看是不是真有这么回事。

时效性也不能忽略。很多 AI 的训练数据截止到某个时间点,对最新的变化一无所知。比如改一篇关于政策的文章,AI 用的还是两年前的规定,这时候要是不查最新文件,写出来的东西就是错的。特别是法律法规、行业标准这些,更新很快,必须核对最新版本。

还有个小技巧,对数字、日期、专有名词这些 “硬信息”,要格外较真。AI 最容易在这些地方出错,比如把 “2023 年” 写成 “2032 年”,把 “CEO” 写成 “COO”,看着是小错,影响却可能很大。

✍️ 内容校对:人工干预的 “最后防线”

再智能的工具,也替代不了人工校对。我始终觉得,AI 改写只是第一步,真正的质量把控,还得靠人。尤其是那些重要的内容,必须有严格的校对流程。

我们团队现在用 “三层校对机制”:第一层,改写的人自己先查,重点看逻辑和信息完整性;第二层,专门的校对员核对事实细节,比如数据、人名、事件;第三层,相关领域的同事再看,确保专业术语和行业表述没错。三层下来,出错的概率能降不少。

专业领域的内容,必须让懂行的人把关。之前帮一个医疗客户改文章,AI 把 “心肌梗死” 的症状写错了,我们的校对员没发现,但客户那边的医生一看就指出来了。这说明隔行如隔山,不是自己领域的东西,再仔细也可能漏掉专业错误。

敏感信息得双重校验。涉及到人名、地址、联系方式这些,哪怕一个字错了,都可能造成大问题。有次改一篇人物专访,AI 把受访者的公司名字写错了,还好最后核对的时候发现了,不然发出去人家肯定不高兴。这种信息,最好是找到原始资料,一个字一个字对着看。

校对的时候,还要特别注意 AI “创造” 的连接词和过渡句。有时候为了让文章通顺,AI 会加一些逻辑连接,但这些连接可能和事实不符。比如两件事本来没关系,AI 硬说 “因为 A 所以 B”,这种逻辑错误,机器很难自己发现,得靠人来判断。

📊 错误案例警示:一次疏漏的连锁反应

别以为小错误没关系,有时候一个数字错了,就能造成连锁反应。前两年有个电商平台,用 AI 改写促销文案,把 “满 200 减 50” 写成了 “满 50 减 200”,没校对就发出去了,结果一下亏了好几万。

学术领域更要命。有个研究生用 AI 改写文献综述,AI 把一个重要理论的提出者写错了,答辩的时候被导师指出来,整个论文都得重改,差点延期毕业。学术讲究严谨,这种错误是绝对不能犯的。

新闻报道里的事实偏差,后果更严重。之前看到有家媒体,用 AI 改写一篇社会新闻,把事件的时间地点搞错了,虽然后来更正了,但还是引起了不小的误会。读者对媒体的信任度,就是这么一点点被错误信息消耗掉的。

最麻烦的是那种 “半真半假” 的内容。AI 有时候会把真信息和假信息混在一起,看起来有鼻子有眼,其实藏着错误。这种最容易让人上当,因为大部分内容是对的,偶尔夹杂的错误就很难发现。我们有次改一篇市场分析,大部分数据都对,但有一个关键的增长率写错了,结果整个分析结论都跑偏了。

🛠️ 工具与流程:构建准确性保障体系

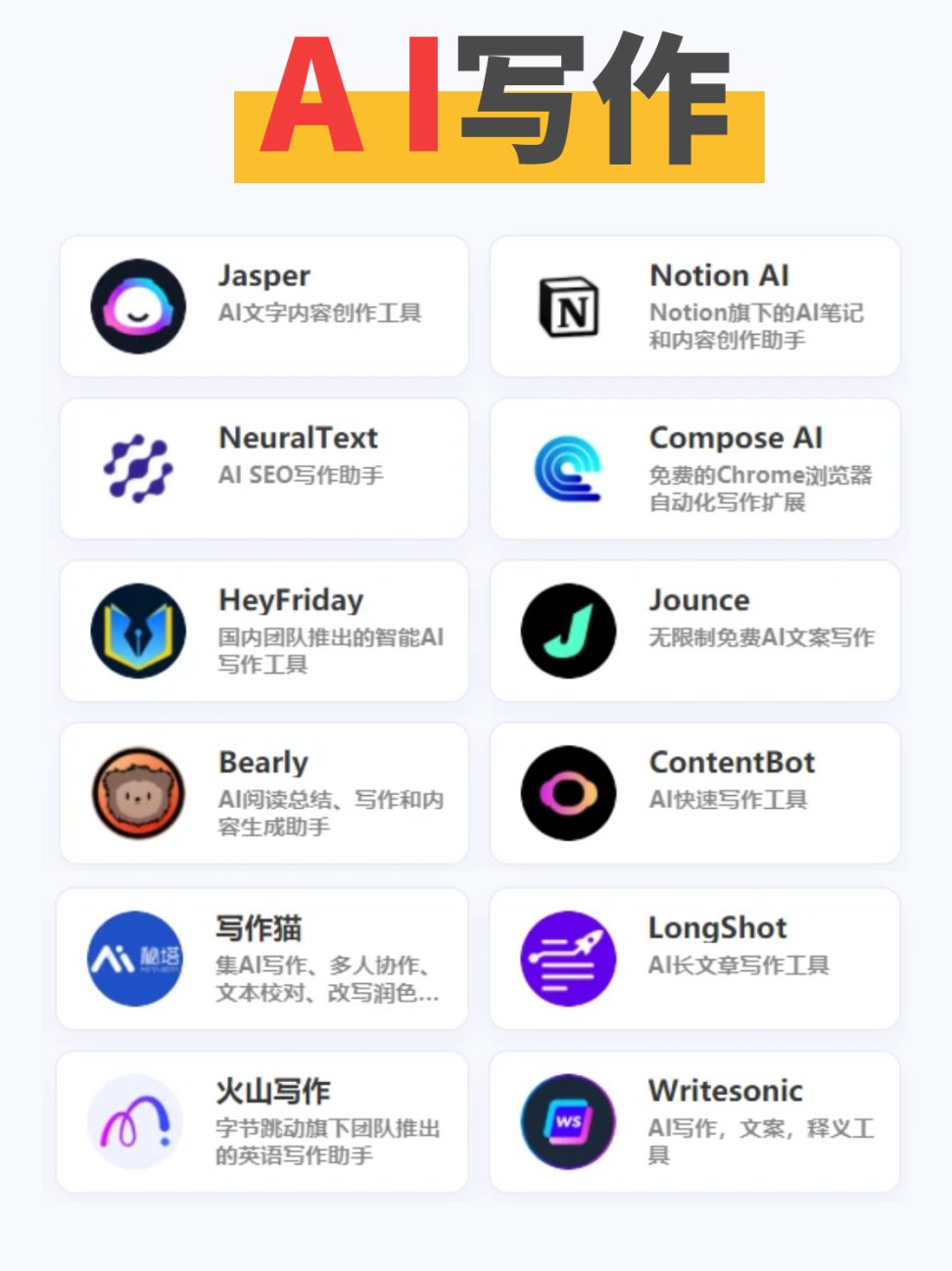

光靠人不够,还得有趁手的工具。现在有不少专门做事实核查的工具,比如 Crossref 可以查学术引用,NewsGuard 能评估新闻来源的可信度,还有 Grammarly 的事实核查插件,虽然不是万能的,但能帮着找出一些明显的错误。

但工具也不能全信,得组合着用。比如先用 AI 改写,然后用事实核查工具初筛,再导出到校对软件查格式和表述,最后人工再过一遍。不同工具各有侧重,配合起来用效果才好。

流程标准化也很重要。我们公司专门制定了《AI 内容处理手册》,里面详细写了从改写、核查到校对的每一步该怎么做,用什么工具,谁来负责。新同事来了照着手册做,就不容易出岔子。

团队分工要明确。谁负责用 AI 改写,谁负责事实核查,谁来最终校对,都得说清楚。出了问题能找到责任人,这样大家才会认真对待。我们还会定期复盘,把出错的案例整理出来,全团队一起分析,避免以后再犯同样的错。

其实说到底,AI 改写就像一把锋利的刀,用得好能提高效率,用不好就容易伤着自己。事实核查和内容校对,就是用刀的 “护手”,再麻烦也不能省。现在行业里对内容质量的要求越来越高,一次错误可能就丢了客户的信任,得不偿失。