🎬 画质与细节:AI 始终跨不过的 “像素坎”

说真的,现在市面上吹得天花乱坠的一句话 AI 生成视频工具,你真用起来就知道,画质和细节处理永远是绕不开的坑。别听那些宣传页里说的 “4K 超高清”,实际生成的内容,稍微复杂点的场景就现原形。

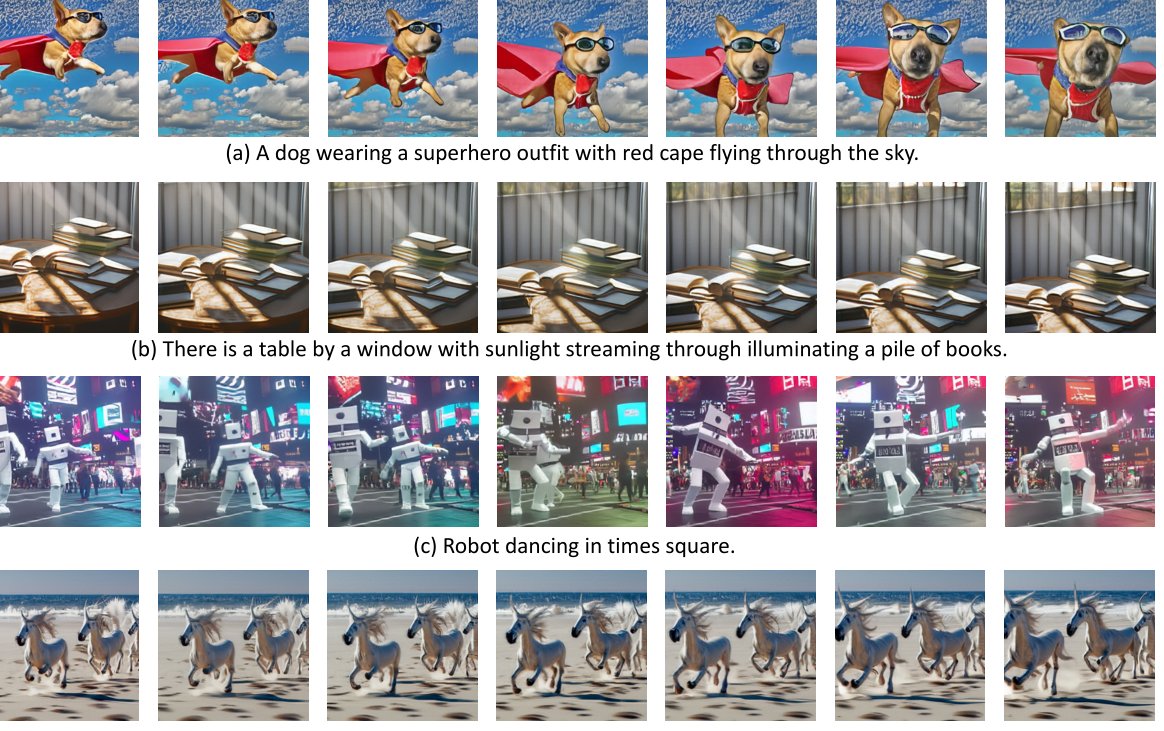

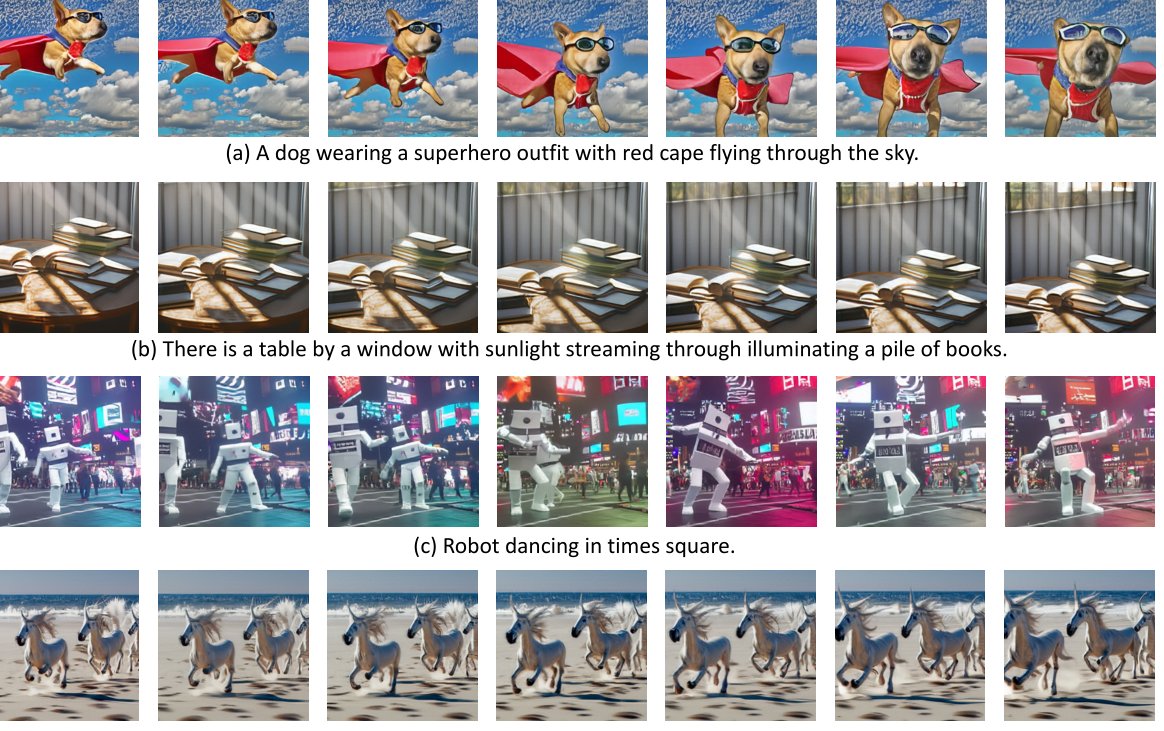

比如你输入 “夕阳下的海边,浪花拍打着礁石,远处有海鸥飞过”,AI 确实能给你凑出这么个画面。但仔细看就会发现,浪花的边缘是模糊的,礁石的纹理像被磨平了一样,海鸥飞起来的时候甚至会出现 “分身”—— 翅膀的像素和背景混在一起,看着特别假。这不是某一个工具的问题,是目前所有 AI 视频生成技术的通病。

动态场景就更要命了。要是指令里有 “奔跑的人群”“飞驰的汽车” 这类元素,生成的视频十有八九会出现 “肢体扭曲”。人跑着跑着腿可能突然变形成面条,汽车的轮子会卡在地面上不动,就像用劣质 PPT 做的动画。不是 AI 不想做好,是它对 “运动轨迹” 的理解还停留在拼接静态帧的阶段,根本算不清快速移动时每个像素该往哪走。

还有那些需要细腻质感的画面,比如 “丝绸裙子在风中飘动”“咖啡杯里升起的热气”。AI 生成的丝绸看着像塑料布,热气要么像一团白雾糊在杯子上,要么直接变成奇怪的线条往上飘。这些细节,人类摄影师用手机都能拍清楚,AI 却怎么也学不会 —— 因为它没真正 “触摸” 过丝绸,也没 “感受” 过热气的流动,只能从海量图片里猜个大概。

🧩 内容逻辑:一句话指令撑不起完整叙事

你可能觉得,不就生成个短视频吗?一句话足够了。但实际情况是,AI 根本听不懂 “弦外之音”,你给的指令越简单,它生成的内容逻辑就越混乱。

举个例子,有人试过输入 “老人在树下下棋,突然下雨了,他们笑着收拾棋盘”。AI 生成的视频里,老人确实在下棋,也确实下雨了,但 “笑着收拾” 这部分完全跑偏 —— 一个老人可能在捡棋子,另一个却站在雨里发呆,甚至有个棋子直接悬浮在空中。不是 AI 故意捣乱,是它理解不了 “下雨” 和 “笑” 之间的关联 —— 人类知道这是 “雨中互动的温情”,但 AI 只把这三个短句当成独立的元素,硬往一个画面里塞。

长一点的叙事就更别指望了。比如你想做个 1 分钟的小故事,输入 “男孩丢了气球,女孩帮他找,最后在草丛里找到了,两人一起笑了”。AI 生成的画面可能是:男孩丢气球(没问题),女孩突然出现在旁边(没过程),草丛里的气球突然变大(不合逻辑),最后两人的笑容像是 P 上去的(毫无情感)。它没法处理 “找气球” 这个过程里的细节 —— 比如两人怎么分工?有没有对话?这些 “一句话” 之外的隐性逻辑,AI 统统抓不住。

更麻烦的是 “因果关系”。你输入 “因为下雨,所以路人都撑起了伞”,AI 可能生成一半人撑伞、一半人淋雨的画面,它分不清 “因为... 所以...” 意味着 “所有人都该撑伞”。这种逻辑断层在需要传递信息的场景里特别致命,比如企业想做个产品介绍视频,输入 “因为用了 XX 洗衣液,衣服变干净了”,AI 可能给你看衣服变干净,但完全没出现洗衣液,观众根本不知道在讲什么。

还有时间线的问题。“早上起床,中午吃饭,晚上睡觉”,这么简单的时间顺序,AI 有时都会搞反 —— 可能先出现睡觉,再出现起床。不是它笨,是它对 “时间” 的理解和人类不一样。人类靠生活经验知道早晚顺序,AI 只靠数据里的概率判断,一旦数据里有类似 “晚上睡觉前想起早上的事” 的内容,它就可能把顺序打乱。

💡 创意局限:AI 难越 “人类灵感” 的鸿沟

总有人说 AI 能 “解放创意”,但在视频生成这件事上,它更像是个 “创意复读机”,永远跳不出训练数据的框框。

你让 AI 生成个 “从没见过的动物”,它给你的大概率是 “长着鸟嘴的猫”“带翅膀的狗” 这类拼接出来的东西。不是它不想创新,是它的 “想象力” 全来自人类已经创造过的内容。训练数据里没有的元素,它根本编不出来。就像人类画家能画出山海经里的神兽,AI 却画不出来 —— 因为那些神兽不在它的 “数据库” 里,它连 “九尾狐” 该有几条腿都可能搞错。

情感表达上的局限更明显。你输入 “一个人在空无一人的车站,感到孤独”,AI 能生成空车站和一个人,但那个人的表情可能是麻木的,甚至带着微笑。它理解不了 “孤独” 是种什么样的情绪,只能从图片里找 “车站 + 单人” 的组合,然后随便贴个表情。人类演员一个眼神就能传递的孤独,AI 用再多像素也堆不出来。

还有那些需要 “反常识” 创意的场景。比如 “鱼在天上游,鸟在水里飞”,AI 能生成这样的画面,但细节会很别扭 —— 鱼的鳍可能像鸟翅膀一样扇动,鸟在水里游的时候居然还张着嘴 “呼吸”。它不知道这种创意的核心是 “打破常规带来的冲击”,只会机械地交换场景,完全抓不住背后的艺术表达。

⚖️ 版权泥潭:生成内容的归属始终是谜

用 AI 生成视频的人,很少有人想过一个问题:这东西到底是谁的? 现在这事儿在法律上还是笔糊涂账,麻烦得很。

AI 生成视频的 “原材料” 是海量的图片、视频片段,这些素材里有多少是受版权保护的?没人说得清。你输入 “一个穿着红色连衣裙的女孩在跳舞”,AI 可能从某部电影里扒了个跳舞的片段,换了件红裙子就给你。要是原片的版权方找上门,你说你冤不冤?你没抄,但 AI 替你 “抄” 了,最后责任可能还得你担。

更头疼的是 “衍生作品” 的问题。比如你让 AI 模仿某导演的风格生成视频,比如 “像宫崎骏动画一样的森林场景”,生成的内容里可能出现和宫崎骏作品里相似的角色或构图。这算不算侵权?目前各国法律都没明确说法。去年就有个案例,有人用 AI 生成类似《蜘蛛侠》的动画短片,被迪士尼告了,最后赔了钱 —— 理由是 “风格模仿构成侵权”。

还有用户上传的指令本身。要是你输入的指令里包含受版权保护的内容,比如 “生成《哈利波特》里的霍格沃茨城堡”,AI 真给你生成了,那你用这个视频做商业用途,华纳兄弟能饶了你?现在很多 AI 工具的用户协议里都写着 “用户对输入内容的合法性负责”,说白了就是出事了它不管,全算你的。

🔄 交互性缺失:用户难与 “半成品” 深度互动

现在的一句话 AI 生成视频,更像是 “一锤子买卖”—— 你输指令,它出结果,中间几乎没给你修改的余地。这对想做精细内容的人来说,简直是灾难。

比如你生成了一个视频,整体不错,但觉得 “天空的颜色太暗了”,想调亮点。大部分工具都得让你重新输入指令,比如 “天空颜色调亮,其他不变”,但生成的新视频可能连人物都换了。它记不住上一版的细节,每次生成都是 “从零开始”,你想微调某个部分,比重新做还麻烦。

更别说复杂的修改需求了。“把视频里的猫换成狗,保持动作不变”,这在人类后期眼里很简单,但 AI 几乎做不到。它会生成一只狗,但动作可能完全变了,甚至场景都跟着换了。因为它理解不了 “换主体但保留动作” 这种精细指令,只能重新解析整个句子,最后出来个四不像。

还有时长控制。你输入 “生成 10 秒的视频”,AI 可能给你 8 秒,也可能给你 12 秒,而且多出来的 2 秒可能是重复画面,或者突然卡顿结束。它对 “时长” 的理解很模糊,不像人类能精确控制每一秒的内容,你想卡点配音乐?基本靠碰运气。

理性拥抱:把 AI 当工具而非 “造物主”

说了这么多局限性,不是说一句话 AI 生成视频没用,关键是你得知道它能干啥,不能干啥。

对普通人来说,它是个不错的 “灵感工具”。比如你想拍个 vlog,不知道开头怎么拍,输入 “清晨的卧室,阳光照进来,主角伸懒腰”,AI 生成的视频虽然粗糙,但能给你个大概方向 —— 哦,原来可以从窗帘被风吹动开始,或者先拍脚踩在地板上的画面。这比你对着空白屏幕发呆强多了。

对内容创作者来说,它适合做 “初稿”。比如做短视频的,先用 AI 生成个 10 秒的草稿,然后自己用剪辑软件修细节 —— 把模糊的画面换成实拍素材,把逻辑不通的地方重新配音,把版权有风险的元素换掉。AI 帮你省了 “从零开始” 的时间,你负责把它变成 “能看的成品”,这才是合理的分工。

更重要的是,别指望它能替代人类创作者。AI 能生成 “女孩在笑”,但生成不了 “女孩想起初恋时的那种笑”;能生成 “下雨的街道”,但生成不了 “下雨时情侣共撑一把伞的温暖”。这些需要人类情感和生活体验的东西,才是内容的核心竞争力,AI 再进化十年,也拿不走。

说到底,一句话 AI 生成视频现在更像个 “玩具”,离 “生产力工具” 还有段距离。你可以玩,可以用它偷懒,但别真把宝全押在它身上。技术会进步,但有些东西 —— 比如人类的创意、情感和对细节的执着 —— 永远是 AI 学不会的。