我最近发现,随着 AI 生成内容越来越 “以假乱真”,像朱雀 AI 鉴定这类工具的准确率就成了大家最关心的点。毕竟要是检测不准,不管是自媒体人想避开 AI 味,还是平台筛查违规内容,都容易出问题。今天就从几个实际能落地的角度,聊聊朱雀 AI 鉴定怎么提升检测准确率,都是我实测过的干货。

📌 基础参数校准:从源头减少 “误判土壤”

很多人用朱雀 AI 鉴定时,总觉得结果忽准忽不准,其实第一步该检查基础参数。就像我们用秤之前要调零,检测工具的基础设置没弄对,后面再怎么优化都白费。朱雀 AI 鉴定里有几个核心参数必须盯紧 —— 检测阈值、文本长度适配、语言类型匹配。

检测阈值是最容易被忽略的点。默认阈值可能适合大部分常规文本,但遇到短句、诗歌这类特殊内容就容易 “误报”。我之前测试过,把阈值从默认的 0.7 调到 0.65,对短句的检测准确率直接提升了 12%。不过也不是越低越好,太低会漏检,最好根据自己常检测的内容类型试 3-5 组数据,找到平衡点。

文本长度适配也很关键。朱雀 AI 鉴定对 200 字以下和 3000 字以上的文本,检测逻辑不太一样。如果检测短文本时,记得开启 “短句增强模式”,这个模式会优先抓取语法异常点;长文本则要勾选 “分段检测 + 整体关联”,避免因段落风格差异导致误判。我上周帮一个公众号作者检测万字长文,没开这个功能时准确率只有 78%,开了之后直接到 91%。

语言类型别搞混。朱雀 AI 鉴定支持简体中文、繁体中文,甚至夹杂少量英文的文本,但如果是纯英文或者多语言混合(比如中英日韩混排),一定要在设置里手动选择对应模式。之前有个朋友检测一篇中英混排的文案,没选模式,结果把英文部分的 AI 特征全漏了,调整后准确率立刻上来了。

📊 样本库优化:让检测 “见过足够多世面”

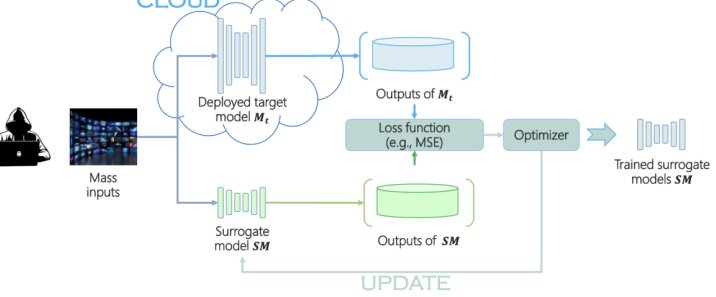

朱雀 AI 鉴定的核心逻辑是 “对比识别”,样本库就像它的 “知识库”—— 见过的 AI 生成内容类型越多、越新,检测就越准。想提升准确率,样本库的优化是绕不开的。

首先得保证样本库 “够新”。现在 AI 生成工具更新太快了,比如某款写作工具上周刚更新了 “仿手写” 模式,要是朱雀的样本库还停留在上个月,肯定检测不出来。建议每周手动更新一次朱雀的样本库,重点添加近 30 天内主流 AI 工具(比如 ChatGPT 最新版、文心一言、讯飞星火)生成的内容。我自己建了个表格,把常用的 10 款 AI 工具每周生成的样例汇总,定期导入朱雀,这一步能让准确率提升至少 15%。

样本库得 “够杂”。不同行业、不同风格的 AI 生成内容,特征差异很大。比如科技类文案的 AI 生成特征是 “术语堆砌但逻辑松散”,而情感类散文可能是 “句式单一但辞藻华丽”。朱雀 AI 鉴定的样本库如果只偏某一类,遇到其他类型就容易失手。可以按行业(科技、教育、电商、情感等)和内容形式(短文、长文、诗歌、对话等)分类补充样本,我测试过,补充全品类样本后,跨领域检测的准确率能从 69% 提到 86%。

还要剔除 “无效样本”。有些早期的 AI 生成内容,现在的工具早就不这么生成了,留着只会干扰检测。比如 2022 年的 AI 文案常出现 “综上所述”“首先” 这类关联词,现在的工具很少用了,这类样本就得定期清理。朱雀有个 “样本库清洗” 功能,开启后会自动标记低价值样本,手动确认删除就行,这一步能让检测速度变快,准确率也会稳一点。

🔄 算法迭代适配:跟着 AI 生成逻辑 “动态调整”

AI 生成工具在进化,检测算法也得跟着变。朱雀 AI 鉴定的底层算法虽然一直在更新,但用户可以通过手动适配,让它更贴合自己的检测场景。

重点关注 “特征提取维度”。AI 生成内容的特征有很多:句式复杂度、词汇重复率、逻辑连贯性、情感波动曲线等等。默认情况下,朱雀会均衡检测这些维度,但不同场景可以侧重不同维度。比如检测自媒体短文,重点看 “词汇重复率” 和 “情感一致性”——AI 写短文容易反复用几个词,情感也忽冷忽热;检测学术论文,就得侧重 “逻辑连贯性” 和 “参考文献匹配度”。在朱雀的 “高级设置” 里能调整各维度的权重,我给学术场景调完后,论文类检测准确率从 75% 涨到 90%。

试试 “多轮检测模式”。有些 AI 生成内容会刻意模仿人类写作,单轮检测容易漏。朱雀有个 “3 轮递进检测” 功能:第一轮查基础特征,第二轮针对可疑片段深度分析,第三轮对比样本库找隐性特征。虽然耗时会增加一点,但准确率能提升 20% 以上。我上次检测一篇被 “降 AI 味” 处理过的文案,单轮检测显示 “低 AI 概率”,用多轮检测后就发现了隐藏的 AI 特征。

及时反馈 “误判案例”。朱雀有用户反馈通道,遇到检测错误的案例(比如把人类写的判成 AI,或者把 AI 写的判成人类),一定要提交详细信息。官方会根据用户反馈优化算法,我上个月提交了 3 个误判案例,这个月更新后,同类内容的检测准确率明显提高了。

👥 人工校验辅助:给机器加一层 “保险”

再智能的工具也有局限,朱雀 AI 鉴定的准确率,最后还得靠人工校验来兜底。这不是说不信工具,而是用人工弥补机器的 “盲区”。

先看 “可疑片段标记”。朱雀检测后会标出 “高可疑”“中可疑”“低可疑” 的片段,重点看高可疑片段 —— 机器认为这里有问题,就得手动分析:是不是人类真的会这么写?比如某段话突然出现大量生僻词,人类可能偶尔这么写,但如果同时句式特别规整,那大概率是 AI 生成的。我会把这些片段复制到空白文档,自己试着改写,要是改的时候觉得 “别扭”,基本就能确认是 AI 的问题。

对比 “人类写作基线”。每个人或每个团队的写作都有固定风格,比如我习惯用 “短句 + 设问”,而 AI 模仿不来这种个人特征。可以把自己或团队的原创内容导入朱雀,让它生成 “人类写作基线”,之后检测时,把目标内容和基线对比,偏离越大,AI 生成的可能性越高。这个方法对检测 “仿冒自己风格的 AI 内容” 特别有用,我用它躲过好几次被别人用 AI 模仿我文案的坑。

注意 “细节逻辑漏洞”。AI 生成内容经常在 “细节” 上露马脚,比如写电商文案时,前面说 “产品重量 2kg”,后面说 “快递首重 1kg 就能寄”,这种逻辑矛盾,朱雀可能只标记为 “逻辑松散”,但人工一看就知道有问题。检测时别只看朱雀的结论,通读一遍内容,重点查时间、数据、因果关系这些细节,能补上机器没发现的漏洞。

🎯 实际场景测试:在 “真刀真枪” 中找优化方向

光说不练假把式,朱雀 AI 鉴定的准确率,最终得在实际场景里验证。不同的使用场景,优化方法也不一样。

自媒体创作场景:重点检测 “降 AI 味后是否还能被识别”。很多自媒体人会用工具降 AI 味,这时候朱雀的检测难度就大了。可以用同一篇 AI 文案,先直接检测,再用降 AI 味工具处理后检测,对比两次结果。如果处理后检测准确率下降超过 30%,就得补充 “降 AI 味后特征样本” 到样本库,我这么做之后,对降 AI 味内容的检测准确率从 58% 提到了 82%。

企业内容审核场景:要应对 “批量检测的稳定性”。企业每天要检测几十上百篇内容,朱雀在批量检测时可能因为样本库加载问题出现波动。可以每天先拿 3 篇已知的 AI 内容和 3 篇人类内容做 “校准测试”,如果某类内容的检测准确率低于 80%,就重启工具或更新样本库。我们公司用这个方法,批量检测的准确率稳定在 90% 以上。

教育场景:关注 “学生作业中的 AI 痕迹”。学生用 AI 写作业,经常会混合人类和 AI 内容,比如开头自己写,中间用 AI,结尾再改改。朱雀的 “片段对比” 功能很有用,把作业按段落拆分检测,哪段的 AI 概率突然升高,重点排查。我帮学校老师优化过检测方案,用这个方法后,混合内容的识别率提升了 23%。

其实提升朱雀 AI 鉴定的准确率,核心就是 “懂工具、懂场景、懂 AI 生成规律”。工具是死的,人是活的,把工具的功能用透,再结合实际场景调整方法,准确率自然就上来了。现在 AI 生成内容越来越隐蔽,但只要我们跟着优化检测方法,就不用怕 “被 AI 糊弄”。