🔍 批量文本相似度检测工具推荐及主流比对算法优缺点分析

在互联网内容爆炸的时代,批量文本相似度检测工具的重要性越来越突出。无论是企业需要查重,还是创作者担心抄袭,都得依靠这些工具。不过,市面上的工具五花八门,不同的比对算法也各有千秋。下面就给大家详细介绍一下主流的比对算法和一些好用的工具。

🔄 主流比对算法大揭秘

🔍 余弦相似度算法

余弦相似度算法是一种很常见的文本相似度计算方法。它的原理是通过计算两个向量之间的夹角余弦值来判断相似度。这种算法的好处是计算速度快,特别适合处理大量文本。比如说,在电商平台上,要快速比较大量商品描述,余弦相似度算法就能派上大用场。但是,它也有缺点,就是可能会忽略词语的顺序。就像 “我爱北京” 和 “北京爱我”,用余弦相似度算法来算,相似度可能会很高,但实际上这两句话的意思是不一样的。

✂️ 编辑距离算法

编辑距离算法,也叫 Levenshtein 距离算法,它是通过计算将一个字符串转换成另一个字符串所需的最少编辑操作次数(插入、删除、替换)来确定相似度。这种算法对短文本的处理效果很好,像在拼写检查、DNA 序列比对等场景中就经常用到。不过,要是遇到长文本,它的计算效率就会变低,而且对于语义的理解也不够到位。比如 “苹果” 和 “萍果”,编辑距离是 1,能很快检测出差异,但对于 “美丽的花朵” 和 “漂亮的鲜花” 这种语义相似但用词不同的句子,它就不太能准确判断了。

🃏 Jaccard 系数算法

Jaccard 系数算法主要是计算两个集合的交集与并集的比值。在文本处理中,就是把文本中的词语看作集合中的元素。它的优点是简单易懂,对于处理短文本或者关键词匹配的场景很合适。比如在论文查重中,通过比较关键词的交集和并集来判断相似度。但它的问题是对文本的顺序不敏感,而且当文本长度差异较大时,结果可能不太准确。比如 “小猫钓鱼” 和 “钓鱼小猫”,Jaccard 系数会很高,但如果是 “长篇大论” 和 “简短描述”,结果就可能不太靠谱。

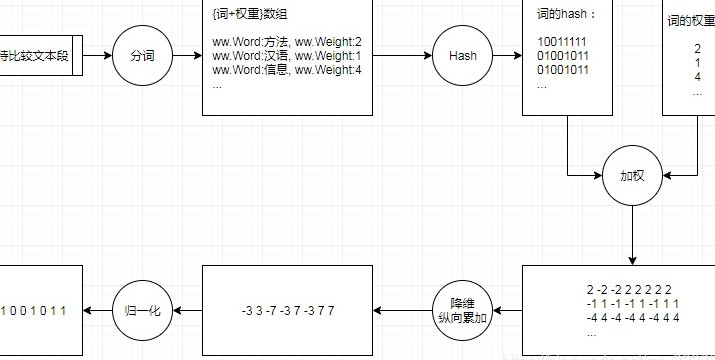

🔢 SimHash 算法

SimHash 算法是一种局部敏感哈希算法,它能将文本转换成一个固定长度的哈希值,然后通过比较哈希值的汉明距离来判断相似度。这种算法的优势是可以快速处理海量文本,并且对文本的局部变化比较敏感。在网页去重、垃圾邮件过滤等方面应用广泛。不过,它也有局限性,当文本差异较大时,可能无法准确反映语义的相似度。比如 “今天天气很好” 和 “明天天气不错”,SimHash 值可能差异较大,但语义是相似的。

💻 主流批量文本相似度检测工具推荐

🚀 OpenAI Embedding

OpenAI Embedding 是一款非常强大的文本相似度检测工具。它基于深度学习模型,能够将文本转换成高维向量,然后通过计算向量之间的相似度来判断文本的相似程度。它的优点是语义理解能力强,对于长文本和复杂语义的处理效果很好。比如在学术论文查重、法律文书比对等场景中表现出色。不过,它也有一些缺点,比如需要 API 调用,可能会有一定的使用成本,而且对中文的支持可能还不够完善。

🧠 CLIP

CLIP 是 OpenAI 开发的多模态模型,它不仅可以处理文本,还能处理图像。在文本相似度检测方面,它通过将文本和图像映射到同一个嵌入空间来进行比较。这种方法的优势是能够捕捉到文本和图像之间的关联,对于多模态内容的相似度检测很有帮助。比如在电商平台上,商品的描述和图片可以通过 CLIP 来进行更精准的匹配。但是,CLIP 对纯文本的处理可能不如专门的文本相似度检测工具,而且模型的体积较大,使用起来可能需要一定的计算资源。

🤖 Google BERT

Google BERT 是一种基于 Transformer 的预训练模型,它在自然语言处理领域有着广泛的应用。在文本相似度检测方面,BERT 能够深入理解文本的语义和上下文信息,从而更准确地判断文本的相似度。它的优点是对中文的支持较好,而且有大量的预训练模型可供选择。比如在中文的学术论文查重、新闻内容比对等场景中,BERT 表现得都不错。不过,BERT 的计算量较大,对于实时性要求较高的场景可能不太适用。

📚 Hugging Face Transformers

Hugging Face Transformers 是一个开源的自然语言处理工具库,它提供了多种预训练模型,如 BERT、GPT、RoBERTa 等。在文本相似度检测方面,用户可以根据自己的需求选择合适的模型,并进行微调。这种工具的优点是灵活性高,用户可以根据自己的实际情况进行定制。比如,对于特定领域的文本,用户可以通过微调模型来提高检测的准确性。但是,对于新手来说,使用 Hugging Face Transformers 可能需要一定的技术门槛。

🔧 Textdistance

Textdistance 是一个开源的文本相似度计算库,它支持多种比对算法,如编辑距离、余弦相似度、Jaccard 系数等。它的优点是使用简单,而且可以根据不同的需求选择不同的算法。比如,在需要快速计算短文本相似度时,可以选择编辑距离算法;在处理大量文本时,可以选择余弦相似度算法。不过,Textdistance 的功能相对较为基础,对于复杂的语义理解可能还不够。

🐾 FuzzyWuzzy

FuzzyWuzzy 是一个基于 Python 的模糊字符串匹配库,它主要用于计算字符串之间的模糊匹配度。它的优点是对拼写错误和轻微的文本变化比较敏感,能够很好地处理一些不精确的匹配场景。比如在数据清洗、姓名匹配等方面应用广泛。但是,FuzzyWuzzy 的算法效率可能较低,对于长文本的处理速度可能会比较慢。

⚖️ 主流比对算法优缺点大比拼

🔍 余弦相似度算法

- 优点:计算速度快,适合处理大量文本。

- 缺点:忽略词语顺序,可能无法准确反映语义差异。

✂️ 编辑距离算法

- 优点:对短文本处理效果好,能准确检测文本差异。

- 缺点:处理长文本效率低,对语义理解不足。

🃏 Jaccard 系数算法

- 优点:简单易懂,适合短文本和关键词匹配。

- 缺点:对文本顺序不敏感,文本长度差异大时结果不准确。

🔢 SimHash 算法

- 优点:快速处理海量文本,对局部变化敏感。

- 缺点:文本差异较大时无法准确反映语义相似度。

🛠️ 如何选择适合的批量文本相似度检测工具

在选择批量文本相似度检测工具时,需要考虑以下几个因素:

📊 检测需求

首先要明确自己的检测需求,是需要检测长文本还是短文本,是需要处理大量文本还是少量文本,是需要高精度的检测还是可以接受一定的误差。如果是处理大量长文本,可能需要选择计算速度快、语义理解能力强的工具,如 OpenAI Embedding 或 Google BERT;如果是处理短文本,可能可以选择编辑距离算法或 FuzzyWuzzy。

💻 技术能力

如果自己有一定的技术能力,可以选择开源工具如 Hugging Face Transformers 或 Textdistance,进行定制化开发;如果技术能力有限,可能需要选择一些易用的工具,如 OpenAI 的 Embedding 或 CLIP。

💰 成本预算

不同的工具可能有不同的使用成本,有些工具需要付费 API 调用,有些工具则是开源免费的。在选择时,需要根据自己的成本预算来进行选择。如果预算有限,可以选择开源工具;如果预算充足,可以选择一些功能更强大的付费工具。

⏱️ 实时性要求

如果对检测的实时性要求较高,可能需要选择计算速度快的工具;如果对实时性要求不高,可以选择一些精度更高但计算速度较慢的工具。

🚀 未来批量文本相似度检测工具的发展趋势

随着人工智能技术的不断发展,批量文本相似度检测工具也在不断进步。未来,这些工具可能会在以下几个方面有所突破:

🧠 更强大的语义理解能力

未来的工具可能会更加注重语义理解,能够更好地捕捉文本的深层含义,而不仅仅是表面的词语匹配。这将使得检测结果更加准确,能够更好地满足用户的需求。

📱 多模态融合

除了文本,未来的工具可能会融合图像、语音等多种模态的信息,进行更全面的相似度检测。比如,在电商平台上,不仅可以比较商品的描述文本,还可以比较商品的图片和视频,从而更准确地判断商品的相似度。

🌐 跨语言检测

随着全球化的发展,跨语言的文本相似度检测需求也在增加。未来的工具可能会更好地支持多语言检测,能够准确地比较不同语言之间的文本相似度。

🚀 实时性和效率提升

为了满足日益增长的实时性需求,未来的工具可能会在计算速度和效率上进行优化,使得即使处理海量文本也能快速得到结果。

📝 总结

批量文本相似度检测工具在互联网时代扮演着重要的角色,选择合适的工具和算法对于提高检测的准确性和效率至关重要。不同的算法和工具各有优缺点,用户需要根据自己的实际需求进行选择。同时,随着技术的不断发展,未来的工具也将不断进步,为用户提供更好的服务。希望这篇文章能够帮助大家更好地了解批量文本相似度检测工具和主流比对算法,从而选择到最适合自己的工具。