学者三年田野调查被判 AI 代笔,十款工具实测:老舍原作误判的深层原因分析

最近有个事特别让人哭笑不得,一位学者花了三年时间做的田野调查论文,竟然被 AI 检测工具判定为 AI 代笔。更离谱的是,连老舍先生的经典作品都能被误判。这背后到底藏着啥玄机呢?咱们今天就来好好唠唠。

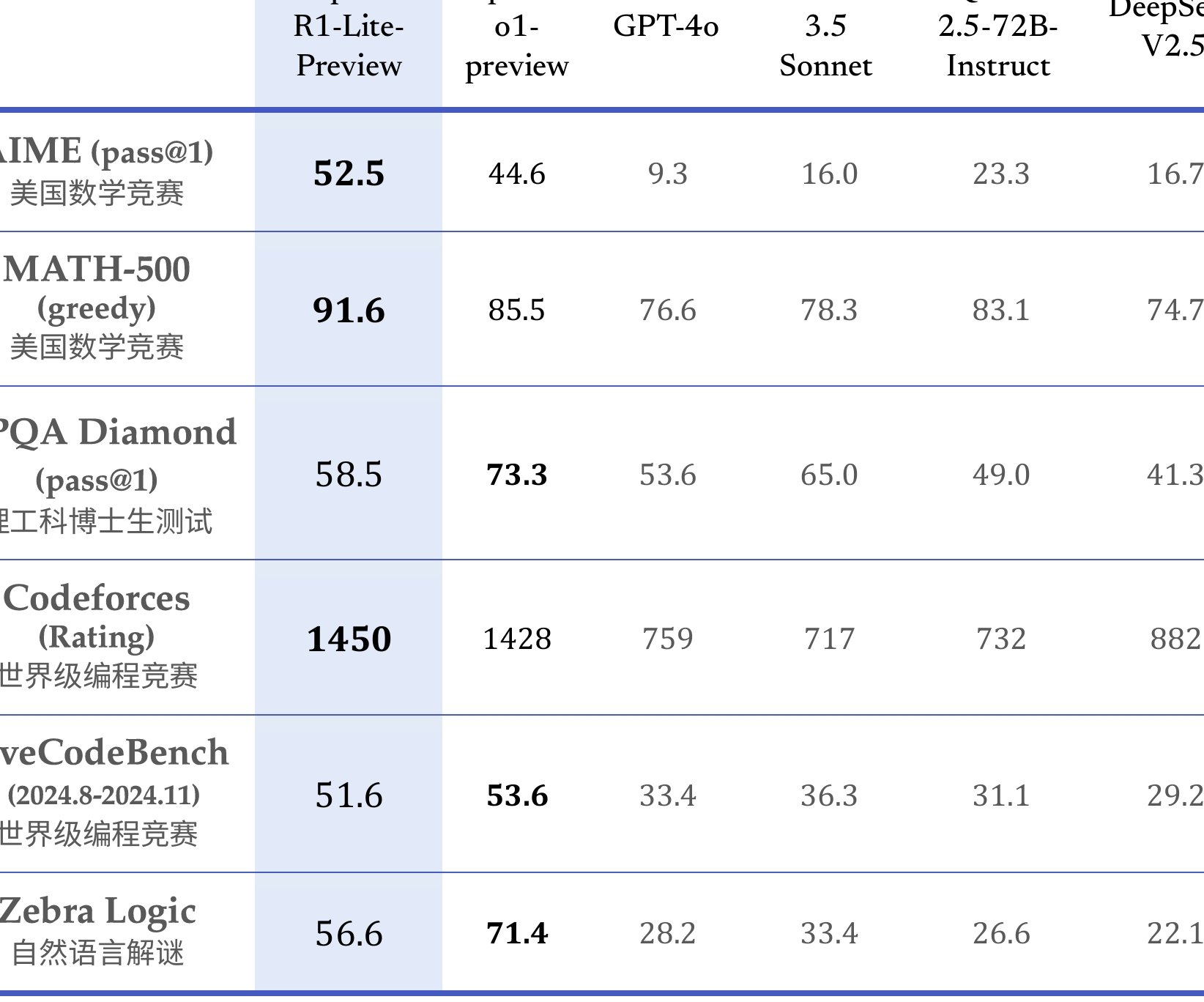

先来说说这十款工具的实测情况。在测试中,不同工具的表现简直天差地别。像知网、朱雀这些工具,对老舍原作《林海》的检测结果还挺靠谱,AI 检测率能达到 0 或者趋近于 0。可茅茅虫就太夸张了,误判率高达 99.9%,万方也把 1300 多字里的近 500 字标注成了 AI 生成。这是为啥呢?其实啊,这和这些工具的检测机制有很大关系。

📚 检测工具的技术局限是个大问题。现在很多 AI 检测工具是靠机器学习和自然语言处理技术来工作的。比如说词袋模型,它就只关注词的出现频率,不管词的顺序。要是一篇文章里某些词汇出现得比较频繁,就容易被误判。还有深度学习模型,虽然能自动学习文本中的语义和句法信息,但面对像老舍作品这种复杂的文学文本,就有点力不从心了。老舍的作品里经常用比喻、排比这些修辞手法,这些在工具眼里可能就成了 AI 生成的模式。

🔍 训练数据不足也是个关键因素。好多检测工具的训练数据可能根本没覆盖到经典文学作品。老舍的作品语言很有特点,口语化、还带着地方方言,像《林海》里就有不少北京方言词汇。可检测工具的训练数据里要是没有这些内容,自然就容易误判。就好比你让一个没见过大熊猫的人去识别大熊猫,他肯定认不出来。

再说说学术写作这一块。学者的田野调查论文一般都写得特别严谨,结构清晰、逻辑性强。可这在 AI 检测工具眼里,可能就成了 AI 生成的特征。你想啊,AI 生成的内容往往也比较工整、有条理。所以,当工具检测到这种结构化的文本时,就容易犯迷糊。董晨宇教授的论文就是个典型例子,他的论文是团队耗时三年扎根基层写出来的,结果就因为太严谨被误判了。

话说回来,AI 检测工具本身也在不断进化。现在的 AI 模型生成的文本越来越接近人类写作水平,这就让检测工具更难区分了。而且,不同的 AI 模型输出结果也不一样,检测工具的训练样本可能根本跟不上 AI 进化的速度。就拿 OpenAI 来说,它之前就因为难以准确检测 AI 生成内容暂停了相关工具服务,可国内一些商业公司还在开发类似工具。

那面对这种情况,我们该咋办呢?首先,高校和学术机构在使用 AI 检测工具的时候,可不能把它当成唯一的评判标准。毕竟工具还不够成熟,误判的风险太大。可以多结合同行评议、专家审核这些传统方式,综合考量论文的原创性和学术价值。

对于我们普通用户来说,写文章的时候也得留个心眼。要是担心被误判,可以试着调整一下写作风格,别太刻意追求工整和结构化。比如把长句改成短句,用一些更口语化的表达。当然啦,也不用为了降 AI 率把文章改得面目全非,那样就得不偿失了。

总的来说,AI 检测工具虽然有一定的作用,但目前还存在不少问题。我们得客观看待它,不能过分依赖。只有这样,才能在 AI 时代更好地保护原创,维护学术的尊严。

该文章由

diwuai.com 第五 ai 创作,第五 AI - 高质量公众号、头条号等自媒体文章创作平台 | 降 AI 味 + AI 检测 + 全网热搜爆文库

🔗 立即免费注册 开始体验工具箱 - 朱雀 AI 味降低到 0% - 降 AI 去 AI 味