🔥 移动端与 PC 端 AI 模型推理成本优化大揭秘

📱 移动端:轻量化与边缘计算双管齐下

现在手机上跑大模型已经不是什么新鲜事了,但怎么让它既快又省成本呢?模型压缩是关键。上海交大张林峰团队提出的 NFCM 方法,通过数据蒸馏和特征缓存,让移动端模型显存占用降到原来的 1/300,速度提升 20 倍。就像把大象塞进冰箱,通过巧妙的结构设计,模型体积缩小了,性能还没丢。

再看硬件加速,高通骁龙 X Elite 平台支持 FP8 精度计算,配合 AI Hub 优化,模型推理速度直接提升 4 倍,能耗降低不少。比如在手机上运行 Stable Diffusion,以前可能要等半分钟,现在不到 10 秒就能出图。

边缘计算也派上大用场。中国电信的云边协同方案,把部分计算任务放到边缘节点,高丢包网络下延迟降低明显,特别适合工业物联网这类实时性要求高的场景。想象一下,工厂里的设备故障预警,通过边缘节点快速处理,比传回云端节省大量时间和流量成本。

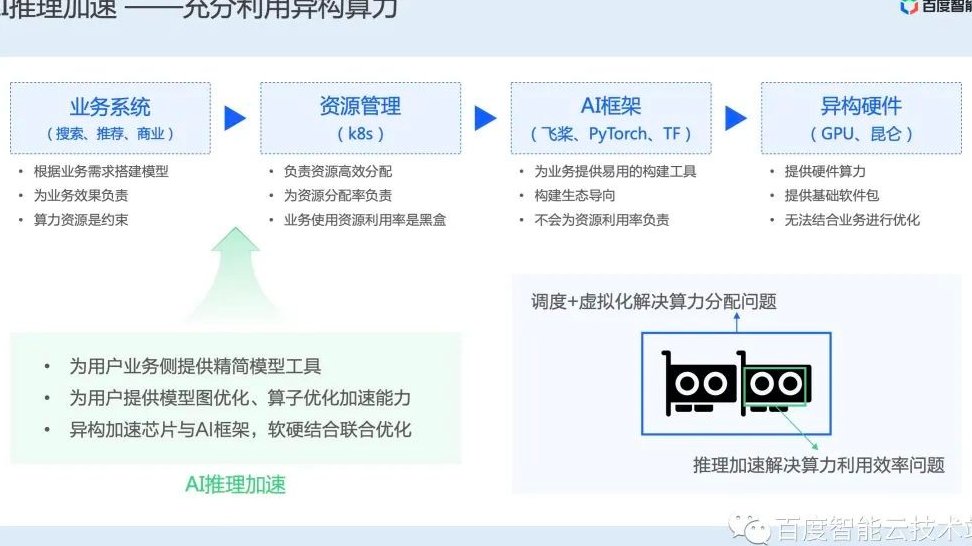

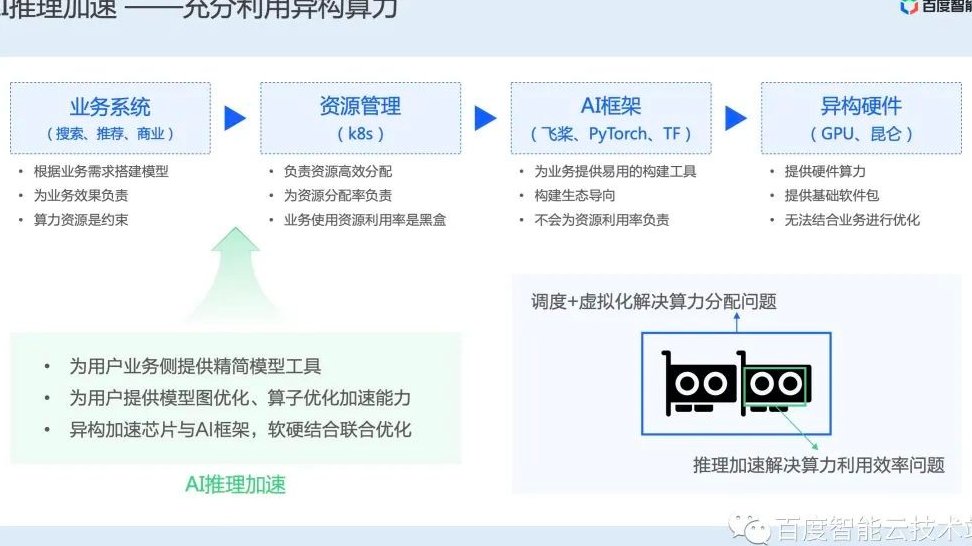

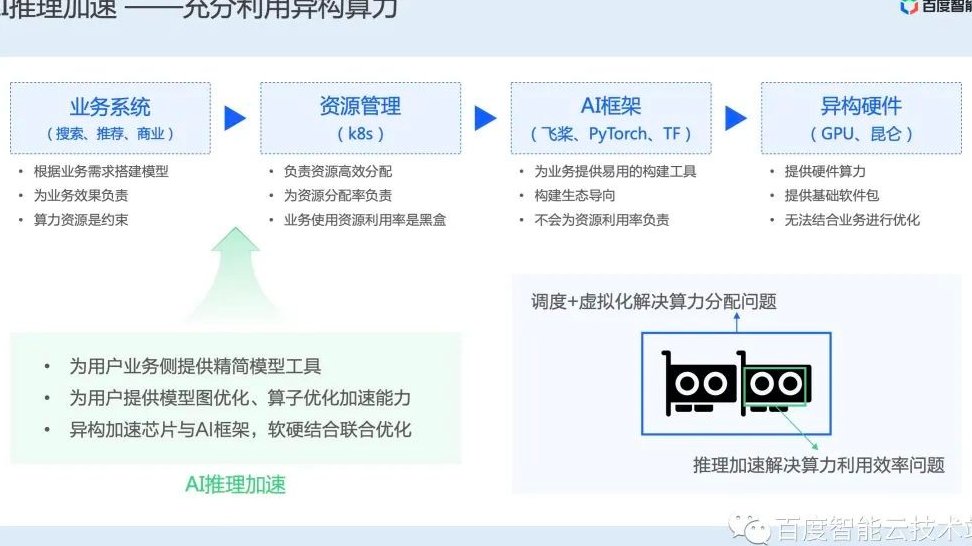

💻 PC 端:高性能与异构计算的较量

PC 端追求的是极致性能,异构算力管理成了突破口。京东云 JoyBuild 引擎支持统一管理 GPU/CPU 集群,通过细粒度切分技术,GPU 利用率最高提升 70%,MoE 模型推理成本降低 90%。这就像把不同工种的人合理分配任务,效率自然上去了。

硬件架构创新也很关键。英伟达 GB10 超级芯片结合 Blackwell CPU 和 Grace CPU,专为 AI 计算设计,算力强劲。联想的新款笔记本搭载 N1 芯片,算力达到 180-200TOPS,本地就能处理复杂模型,不用依赖云端。

软件优化同样重要。微软 T-MAC 技术利用查找表优化 CPU 推理,在 Surface AI PC 上,3B 模型生成速率可达每秒 48 个 token,甚至超过 NPU 性能。这意味着普通 PC 也能高效运行大模型,不用非得买昂贵的显卡。

📊 成本与性能的终极对决

从成本来看,移动端优势明显。斯坦福 HAI 报告显示,达到 GPT-3.5 水平的推理成本两年下降 280 倍,移动端能耗优化策略让每千次推理成本低至几分钱。而 PC 端虽然单次成本较高,但适合处理复杂任务,长期来看规模化应用更划算。

性能方面,PC 端依然领先。比如在视频生成任务中,搭载骁龙 X Elite 的 PC 生成速度是竞品的 3 倍,处理 4K 视频毫无压力。但移动端在实时性和隐私保护上更胜一筹,像医疗影像分析这类敏感数据,本地处理更安全。

🌟 未来趋势:端云协同与自主进化

端云协同会成为主流。摩尔线程的 E300 计算模组,结合边缘生成式 AI 和计算机视觉,能快速开发云边端协同应用,在教育、医疗等行业落地。就像快递配送,中心仓库和网点协同,效率最大化。

模型自主进化也值得期待。DeepSeek 的 R1 大模型通过动态量化和存算一体技术,让终端设备能自主优化模型,不断提升推理效率。这意味着未来的 AI 设备会越来越聪明,成本还越来越低。

总的来说,移动端和 PC 端各有优势,根据具体需求选择合适的方案才是关键。无论是追求便携性和隐私的移动端,还是追求高性能的 PC 端,降低推理成本的核心都是软硬件协同优化和架构创新。随着技术发展,两者的界限会越来越模糊,端云协同的混合模式将成为主流,让 AI 真正融入生活的方方面面。

该文章由

diwuai.com第五 ai 创作,第五 AI - 高质量公众号、头条号等自媒体文章创作平台 | 降 AI 味 + AI 检测 + 全网热搜爆文库

🔗立即免费注册 开始体验工具箱 - 朱雀 AI 味降低到 0%- 降 AI 去 AI 味