🔥 降低 AI 训练能耗的最新策略:模型轻量化与费用节省技巧全攻略

AI 训练的能耗问题,这几年可真是越来越受关注了。国际能源署预测,人工智能的能源消耗可能大幅增长,这可不是小事儿。咱们今天就来好好聊聊降低 AI 训练能耗的最新策略,特别是模型轻量化和费用节省的那些实用技巧。

🚀 模型轻量化:从笨重到轻盈的蜕变

模型轻量化是降低 AI 训练能耗的关键一步。以前的大模型参数动不动就几百亿甚至上万亿,训练和运行都得耗费大量计算资源和能源。现在可不一样了,各种轻量化技术不断涌现,让模型在保持性能的同时变得更小巧、更高效。

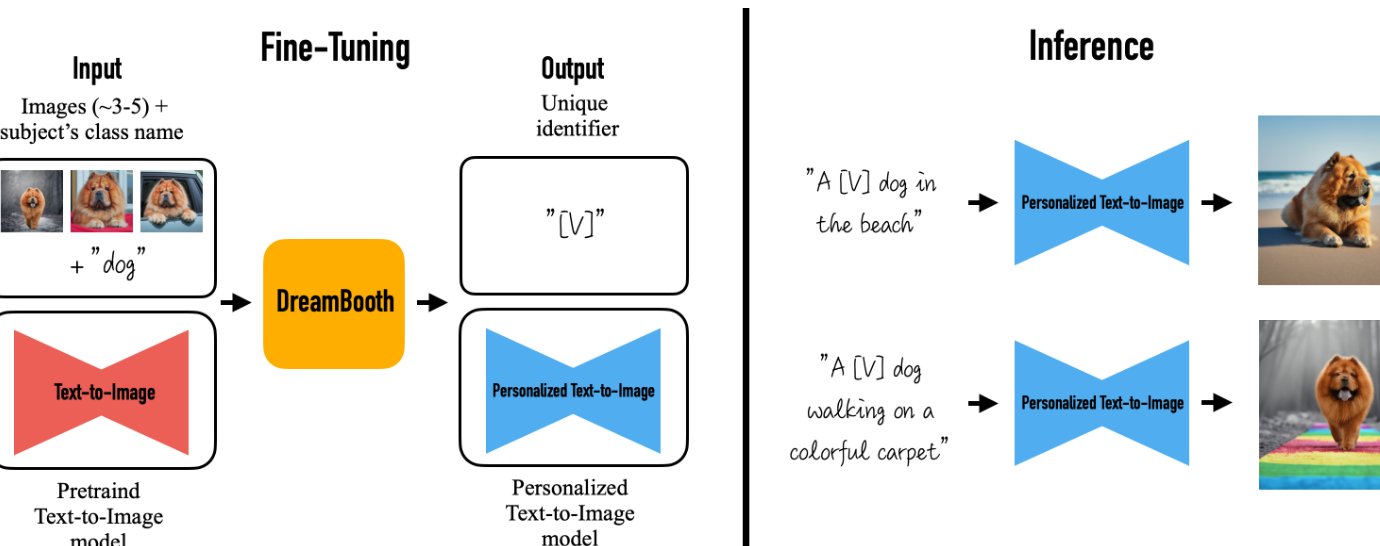

🌟 知识蒸馏:让小模型传承大智慧

知识蒸馏是一种很有意思的技术。简单来说,就是让一个复杂的 “教师模型” 把知识传授给一个相对简单的 “学生模型”。学生模型不仅学习原始数据的硬标签,还学习教师模型输出的 “软概率分布”。通过这种方式,学生模型可以在性能上接近教师模型,同时显著降低计算资源的消耗。

比如,网易有道开源的 “子曰 3 数学模型”,参数量仅为 14B,却在数学推理任务中超越了 DeepSeek-R1 等通用模型。腾讯混元开源的轻量级 MoE 模型 Hunyuan-A13B,仅需 1 张中低端 GPU 就能部署。这些都是知识蒸馏技术的成功应用。

🔍 模型剪枝:去除冗余,轻装上阵

模型剪枝就是直接删除模型中冗余或不重要的参数,比如权重、神经元、通道等。结构化剪枝可以删除整个卷积核、通道或层,让模型结构更紧凑,便于硬件加速。非结构化剪枝则是随机删除单个权重,不过这需要依赖稀疏矩阵运算库,硬件优化难度相对较大。

以 LLaMA-2-7B 为例,使用 Hugging Face 的 optimum 工具包进行结构化剪枝后,模型参数减少至 3.5B,推理速度提升 2.3 倍,虽然在 MMLU 基准上的精度从 67.2% 降至 64.8%,但整体性能还是相当不错的。

📊 模型量化:精度与效率的平衡

模型量化是降低模型权重和激活值的数值精度,比如从 32 位浮点数转换为 8 位整数。动态量化可以在推理时动态转换精度,不需要重新训练;静态量化则是基于校准数据转换精度,需要离线计算;量化感知训练(QAT)则是在训练过程中模拟量化误差,优化模型对低精度的适应性。

量化技术能大幅减少模型体积,存储空间可降低 75% 以上,同时还能加速推理速度。例如,INT8 量化后模型体积从 14GB 降至 3.5GB,推理速度提升 1.8 倍,虽然 MMLU 精度会下降 1.2%,但在很多场景下还是可以接受的。

🛠️ 架构优化:设计更高效的神经网络

除了上述技术,架构优化也是模型轻量化的重要手段。比如,百度文心 4.5 系列首次实现多模态异构 MoE 架构,其 28B 视觉语言模型在感知与推理任务上超越 OpenAI o1,同时支持端云一体部署。阿里巴巴的 LLaVA-MoD 创新性地采用 “逆向蒸馏”,仅用 0.3% 的训练数据,使 2B 小模型性能反超 7B 大模型 8.8%,参数效率提升 3.2 倍。

华为与中科大提出的 CBQ 量化算法,通过跨块依赖机制动态生成量化位宽,仅需 0.1% 训练数据便将模型压缩至原体积 1/7,性能保留 99%。这些架构优化技术,让模型在轻量化的同时,还能保持较高的性能。

💸 费用节省:精打细算,让每一分钱都花在刀刃上

除了模型轻量化,费用节省也是降低 AI 训练成本的重要方面。通过合理选择硬件、优化资源调度、利用云计算等策略,可以在保证训练效果的同时,大幅降低费用。

🖥️ 硬件选择:性价比才是硬道理

选择性价比高的硬件是节省费用的第一步。优先使用最新一代 GPU 实例,比如 AWS 的 P4d/P5,单位算力成本比旧型号低 20%~40%。如果训练任务允许中断,可以考虑使用 Spot 实例,成本能降低 70%。不过要注意,Spot 实例适合批量推理等允许中断的任务。

另外,混合精度训练也是个好办法。FP16 混合精度训练可减少 50% 显存占用,间接降低实例规格需求。DeepSeek 通过自动混合精度(AMP)与动态精度缩放技术,在训练 DeepSeek-V3 时,将显存占用降低 40%-60%,计算吞吐量提升 2-3 倍,硬件成本降低了不少。

⚙️ 资源调度:按需分配,避免浪费

合理调度资源可以避免资源闲置和浪费。通过 AWS Batch 或 SageMaker Training Jobs 自动创建 / 销毁实例,根据训练任务的需求动态调整资源。比如,在训练任务开始时自动启动实例,任务结束后自动销毁,这样就不会在空闲时段浪费资源。

阿里云的容器服务 Kubernetes 版 ACK 也能有效提升资源利用率。它支持自动扩缩容集群 GPU 节点,还提供共享 GPU 方案,在模型推理场景可以实现多个容器运行在同一个 GPU 设备上,有效降低使用 GPU 的经济成本。同时,共享 GPU 方案支持显存隔离,避免因为一个容器资源用量超标影响其他容器的正常工作。

💾 存储优化:精打细算每一个字节

存储优化也是节省费用的重要环节。将模型参数分片存储至 S3 Intelligent-Tiering,自动冷热分层,这样可以根据数据的访问频率自动调整存储级别,降低存储成本。使用 EFS 共享存储减少数据冗余,避免重复存储相同的数据。

在数据传输方面,使用 AWS Direct Connect 专线可以降低跨区域流量费用。阿里云的对象存储 OSS 提供超过 10Tbps 的吞吐能力,10 倍读带宽提速,从 OSS 下载 270GB 模型文件用时 21 秒,通过低延时高吞吐的方式快速把模型文件传输到容器节点,减少 GPU 等待时间。

💰 长期规划:锁定折扣,稳定成本

如果有稳定的训练需求,可以考虑长期节省计划。AWS 的 Savings Plans 承诺 1/3 年消费额度,折扣率最高 72%。阿里云也提供了多种长期使用的优惠方案,比如包年包月实例,价格比按需实例更划算。

另外,监控与告警也很重要。通过 CloudWatch 警报设置每日成本阈值,当成本超过阈值时触发 SNS 通知,及时调整训练策略,避免成本超支。

🌐 硬件与软件协同优化:全方位降低能耗

除了模型轻量化和费用节省,硬件与软件的协同优化也能有效降低 AI 训练能耗。

🚦 硬件创新:从底层提升能效

硬件技术的不断创新为降低能耗提供了新的方向。明尼苏达大学开发的 CRAM,能让数据完全在内存阵列内处理,无需离开计算机存储信息的网格,打破了传统冯・诺依曼体系结构中计算与内存之间的壁垒,可将人工智能计算应用中的能耗至少降低 1000 倍。

自旋电子器件利用电子的自旋而不是电荷来存储数据,相比传统的晶体管芯片,只需很少的能量就能实现相同的功能,速度更快,且能适应恶劣环境。量子计算虽然还处于发展阶段,但具有并行处理能力强、能耗低等优点,未来有望为 AI 系统带来更高的性能和更低的能耗。

🖥️ 软件适配:让硬件发挥最大效能

根据硬件的特点和性能,优化人工智能算法,使其能更好地在硬件上运行。比如,针对特定的硬件架构,设计专门的卷积神经网络算法,提高计算效率,降低能耗。

在分布式训练中,合理选择通信策略也很重要。DeepSeek 在训练 DeepSeek-V3 时,通过 FP16 梯度压缩技术将节点间通信量降低 50%,梯度稀疏化后通信量进一步减少。H800 的异步任务调度机制可将多 GPU 集群的通信延迟压缩至 18μs 级别,配合动态编程器的实时资源分配,使整体训练周期缩短为前代系统的 1/5。

📱 端侧智能:轻量化模型的新战场

模型压缩技术的飞速发展,使得原本需要庞大计算资源的 AI 能力成功 “瘦身”,适应端侧设备的有限资源。轻量级模型在端侧的成功部署正在深刻改变多个行业的智能化路径。

🚗 智能汽车:全离线极速语音的实现

斑马智行于 2025 年 6 月底联合高通、通义发布基于高通 8397 芯片的行业首个端侧多模态大模型方案。其 “元神 AI 智舱・端原生智能体” 通过纯车端方式实现智能座舱 90% 的 “感知 - 决策 - 执行” 服务闭环,能实现全离线极速语音、离线大模型音色等能力,并已在智己、宝马等车型推进量产计划。

📱 移动设备:秒级生成高分辨率图片

湖南汇视威的视觉基座大模型 V1 端侧版本在安卓和 iOS 端实现秒级生成高分辨率图片,用户可在手机上直接完成高质量图像 AI 创作,摄影、设计、娱乐等场景的用户体验被重新定义。

🏭 工业领域:本地小算力运行大模型

深思考的轻量化大模型技术已在工业检测、AI 摄像头等高精度场景落地应用,通过本地小算力运行大模型,在保障性能的同时显著降低功耗。移远通信基于边缘计算模组 SG885G 成功运行 DeepSeek 模型,生成速度超过每秒 40 个 token,为机器人、智能座舱、智能工业等场景提供强大支持。

📚 总结

降低 AI 训练能耗和费用是一个系统工程,需要从模型轻量化、费用节省、硬件与软件协同优化、端侧智能等多个方面综合施策。模型轻量化技术如知识蒸馏、剪枝、量化、架构优化等,让模型在保持性能的同时变得更高效;费用节省策略如硬件选择、资源调度、存储优化等,帮助我们精打细算每一分钱;硬件创新和软件适配则从底层和上层全方位提升能效;端侧智能的发展更是让轻量化模型在各个行业落地生根。

随着技术的不断进步,相信未来还会有更多更高效的策略和技术涌现。我们要紧跟行业动态,不断探索和实践,让 AI 训练变得更加绿色、高效、经济。

该文章由

diwuai.com第五 ai 创作,第五 AI - 高质量公众号、头条号等自媒体文章创作平台 | 降 AI 味 + AI 检测 + 全网热搜爆文库

🔗立即免费注册 开始体验工具箱 - 朱雀 AI 味降低到 0%- 降 AI 去 AI 味