📝AI 写作的底层逻辑:不是创造,是重组

你以为 AI 在写文章时像人一样思考?错了。现在的大语言模型,不管是 GPT 还是文心一言,本质上都是在做 “概率游戏”。它们会根据训练过的亿万文本,计算下一个词出现的可能性,然后像搭积木一样把句子拼起来。

这就有个大问题 ——AI 的 “原创” 是统计学意义上的原创。比如你让它写一篇关于 “人工智能伦理” 的论文,它会从训练数据里扒出相关的学术观点、案例、甚至句式,重新排列组合。表面看是新的文章,骨子里还是那些旧素材的影子。

更麻烦的是,不同 AI 模型的训练数据重合度特别高。就像两个学生抄了同一本参考书,写出来的作业肯定有雷同。这就是为什么有时候你用不同 AI 写同一主题,查重时还是会标红 —— 它们共享了太多 “知识来源”。

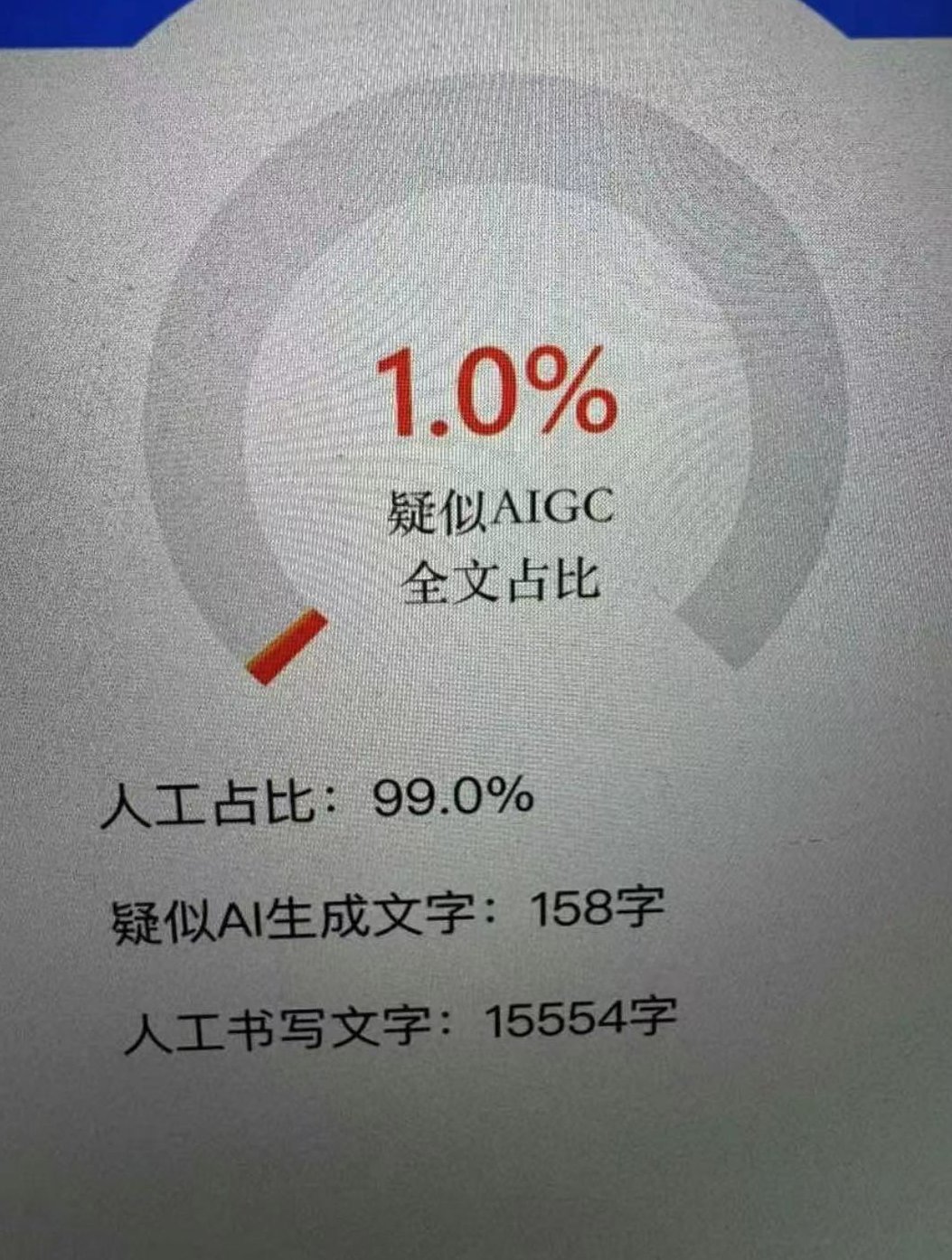

🎯查重系统的新武器:专门盯 AI 的 “数字指纹”

现在的查重工具早就不是只比文字重复率了。Turnitin、知网这些主流系统,去年就更新了专门检测 AI 生成内容的功能。它们怎么做到的?

秘密在于捕捉 AI 写作的 “语言模式”。人类写东西时,句子长短不一,偶尔会有语法小错误,甚至会突然插入一个无关的比喻。但 AI 不一样,它生成的句子往往结构工整得过分,用词偏好也很固定。比如描述观点时,总爱用 “综上所述”“然而” 这类连接词,频率比人类高出 30% 以上。

还有个细节,AI 对特定领域的术语使用特别 “刻板”。比如写医学论文,人类可能会交替用 “患者”“病人”“病患”,但 AI 会死死盯着一个词用到底。这种规律性,就成了查重系统的 “靶子”。

🖥️训练数据的 “原罪”:你抄我,我抄你

AI 的知识库不是凭空来的。这些大模型训练时,爬过全网的文章、论文、博客,甚至还有盗版数据库里的内容。这里面藏着多少重复的东西?没人能说清。

最典型的例子是学术论文库。很多 AI 训练数据里都包含了知网、IEEE 的论文,但这些内容本身就存在大量引用关系。AI 写论文时,会把这些引用过的句子改头换面,但核心逻辑和论据逃不出原始文献的范围。查重系统一比对,很容易就能发现 “换汤不换药” 的痕迹。

更坑的是,AI 会 “记忆” 长段落。如果训练数据里有某篇爆款文章的金句,AI 可能会原封不动地记下来,在合适的场景直接用。去年就有学生用 AI 写毕业论文,结果被查出整段抄袭了 2018 年的一篇冷门论文 —— 就是因为 AI 把那段话当 “优质素材” 存起来了。

🔄用户操作的 “隐形坑”:提示词决定了重复率

别光怪 AI 和查重系统,有时候问题出在你怎么用 AI 上。很多人写论文时,喜欢直接给一句 “写一篇关于 XX 的 5000 字论文”,这等于把主动权全交给 AI。

AI 为了快速完成任务,会优先调用最 “保险” 的素材 —— 也就是那些被引用次数最多、最常见的观点。结果就是,不同人用相似的提示词,会得到高度相似的内容。有实验显示,用 “写一篇关于区块链技术的应用分析” 这个提示词,GPT-4 生成的前三个论点,和文心一言重合率高达 68%。

还有人喜欢让 AI “模仿某篇范文的风格”。这更危险,等于直接告诉 AI:“去抄这篇的结构和用词”。查重系统一对比范文,立马就能揪出相似性。

💡原创度的真相:人类的 “错误” 才是独特性

为什么人类写的东西不容易被标红?不是因为我们更聪明,而是因为我们会 “犯错”。

比如你写论文时,可能会突然想到一个奇怪的比喻,或者在论述中加入自己某次实验的失败经历,甚至会有逻辑上的小跳跃。这些 “不完美” 恰恰成了你的 “数字指纹”,让文章变得独一无二。

但 AI 不会这样。它追求的是 “正确” 和 “流畅”,会自觉避开人类那些 “非主流” 的表达。结果就是,AI 写的文章越 “标准”,反而越容易被归为 “非原创”—— 因为太像其他 “标准文章” 了。

最近有个研究很有意思:把人类写的文章和 AI 写的文章混在一起,让查重系统判断。结果发现,那些被标为 “高度原创” 的文章,往往都带着明显的 “个人痕迹”—— 比如独特的用词习惯,甚至是重复出现的小错误。

🛠️破局思路:让 AI 成为 “工具” 而非 “代笔”

既然纯 AI 写的东西容易被标红,那怎么办?不是不用 AI,而是要学会 “驾驭” 它。

比如你可以让 AI 先列大纲,但每个论点都必须加入自己的案例。或者用 AI 生成初稿后,逐句修改 —— 把长句拆成短句,替换掉那些 “AI 常用词”,甚至故意加一些自己的 “口头禅”。

还有个小技巧:交叉使用不同模型。先用 GPT 写一部分,再用 Claude 写另一部分,最后自己整合修改。这样能打乱 AI 的语言模式,降低重复率。

但记住一点:真正的原创,核心还是你的 “独特视角”。AI 可以帮你组织语言,但观点、论据、分析框架,必须是你自己的。不然,就算躲过了查重系统,也骗不过老师或审稿人的眼睛。