🤖 知网当前的检测逻辑:对 AI 内容是盲区还是已设防?

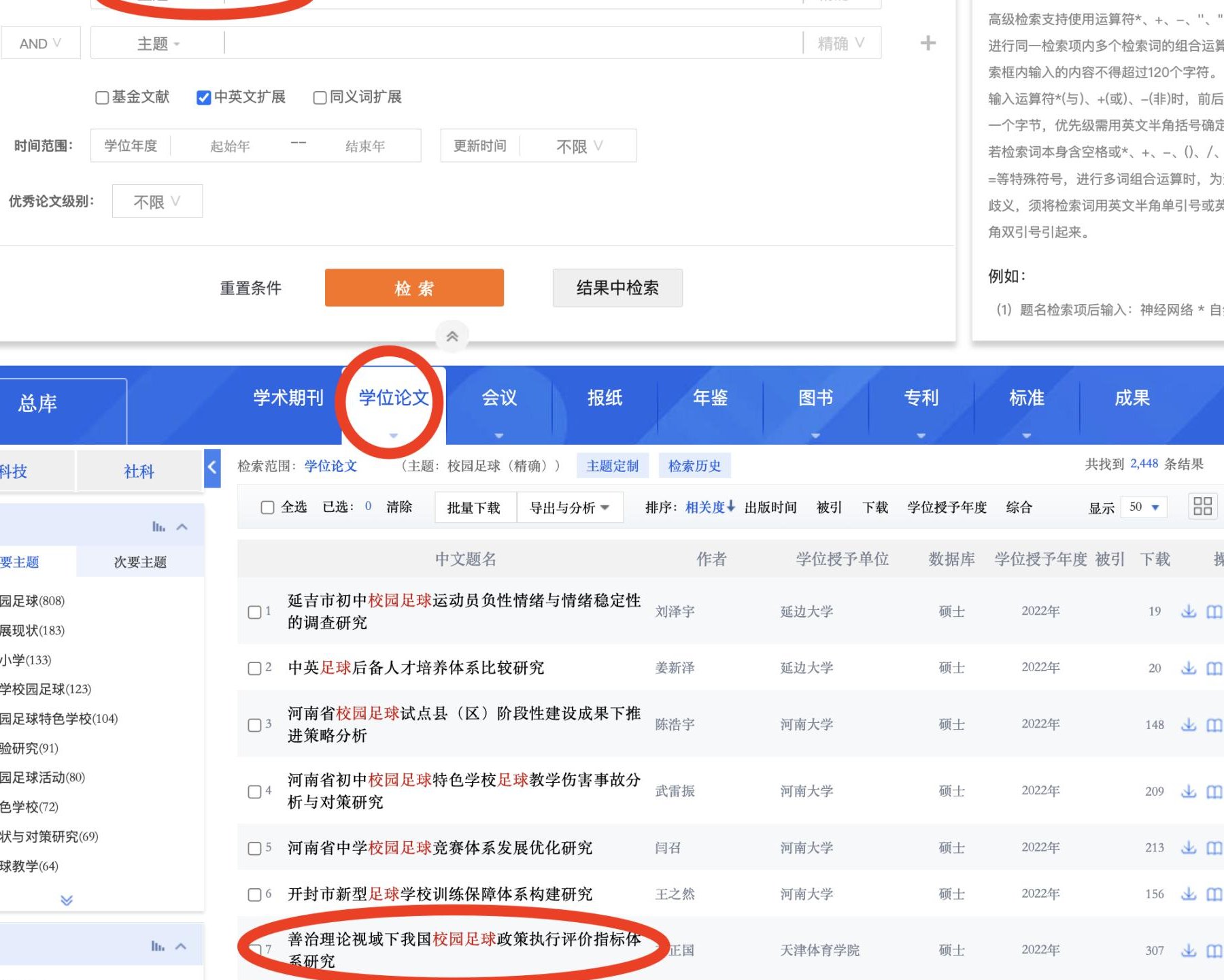

知网的核心检测系统(比如大家常说的知网 VIP5.3)本质是文本比对系统。它的工作原理是把上传的论文和自己数据库里的文献做相似度比对,重点抓直接抄袭、改写、过度引用这些问题。

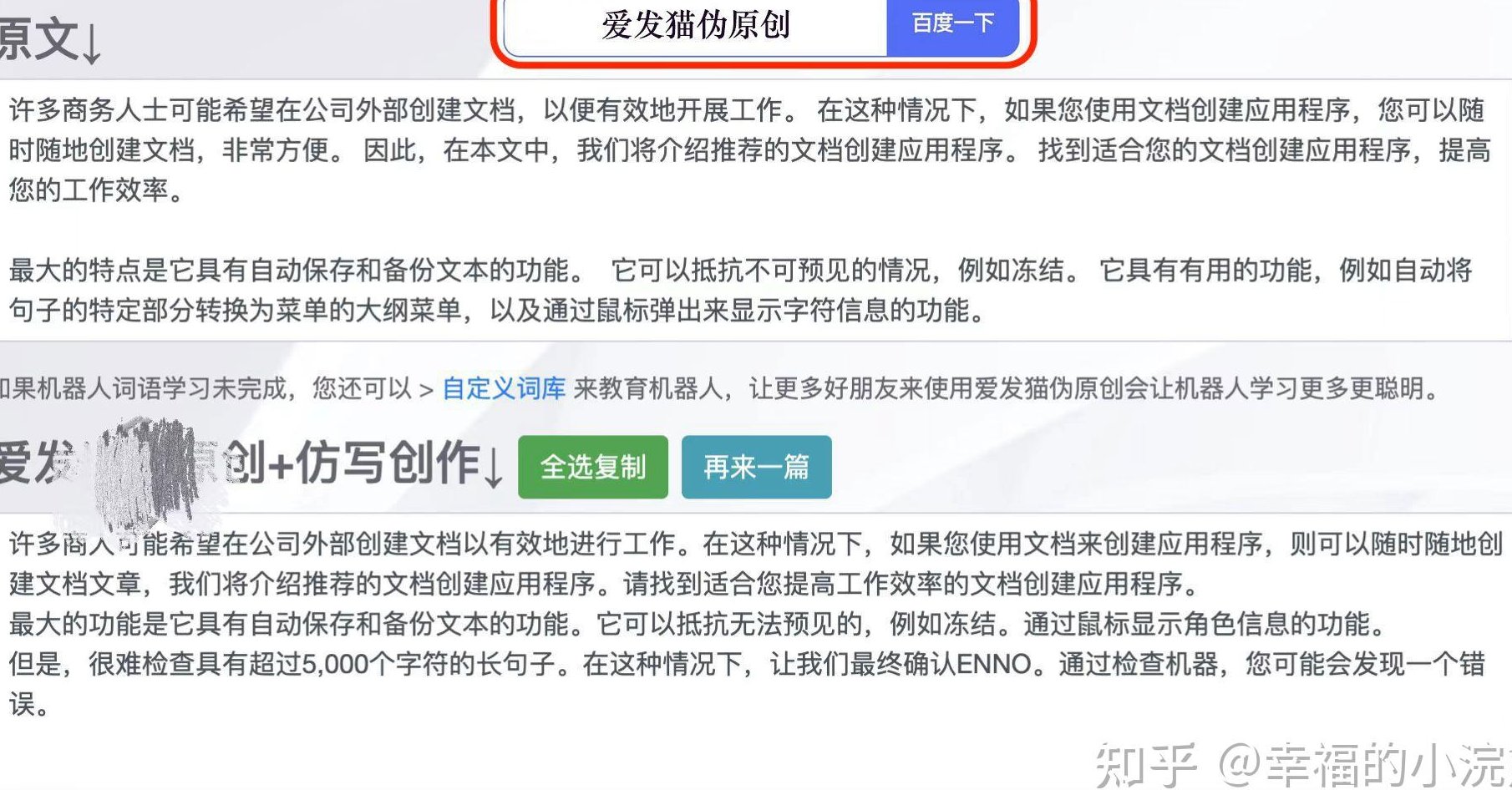

但 AI 生成的文献综述不一样。它不是从现有文本里 “抄”,而是根据训练数据重新组合语言。就像你让两个人写同一主题的综述,表达方式可能完全不同,但核心观点一致。这种情况下,知网的比对算法很难判定这是 AI 写的 —— 它只能检测出 “和已有文献像不像”,却分不清 “是人写的还是机器写的”。

不过最近有变化。2023 年之后,知网悄悄更新了检测维度,开始关注语言模式异常。比如某段文字突然出现大量结构工整但缺乏实质内容的句子,或者专业术语使用频率异常(比如在文献综述里,本该高频出现的研究方法名词却很少见),系统可能会标黄提示 “疑似非人工撰写”。但这种提示只是预警,不会直接判定为 AI 生成,最终还是需要人工审核。

📝 文献综述的特殊性:AI 生成更容易露马脚?

文献综述这种文体对 AI 来说,其实是把双刃剑。一方面,它有固定的结构(引言 - 研究现状 - 评述 - 展望),AI 很容易模仿框架;另一方面,深度整合能力是 AI 的短板,反而容易暴露。

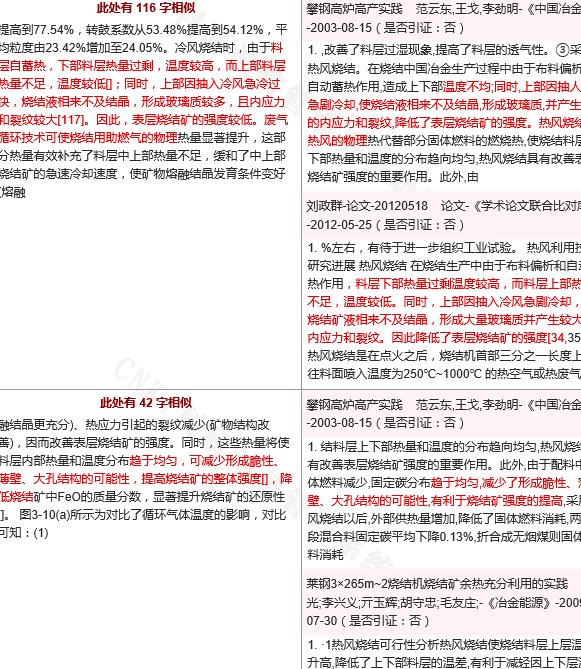

比如在综述里需要对比不同学者的观点差异,AI 可能会简单罗列 “A 认为…B 认为…”,却抓不住两者的逻辑冲突点。有高校老师反馈,他们在审稿时发现,AI 写的文献综述经常出现 “虚假引用”—— 明明参考文献里列了某篇论文,正文里却没真正用到该论文的观点,或者引用的内容和原文不符。这种问题知网虽然不能直接标为 AI,但会因为 “参考文献不对应” 被判定为学术不端。

还有个细节:文献综述需要体现 “研究脉络”,比如某领域从起步到现在的关键转折点。AI 生成时可能会把时间线搞混,或者漏掉重要节点。这种 “逻辑断层” 在人工审核时很容易被发现,但知网的机器检测目前还识别不了 —— 它只能检测文字表面的问题,测不出深层逻辑的合理性。

🔍 现有 AI 检测工具和知网的协同效果

现在很多学生和老师会先用第三方 AI 检测工具(比如 GPTZero、Originality.ai)自查,再上传知网。但这两者的结果往往对不上。

GPTZero 这类工具的原理是分析文本熵值(简单说就是语言的混乱度)。AI 生成的内容熵值通常较低,因为它的句子结构更规整。但知网目前没有接入这种算法,所以就算第三方工具提示 “90% 可能为 AI 生成”,知网的检测报告里也可能显示 “原创性合格”。

反过来也一样。有同学试过用 AI 写综述,先用工具降重,再用 GPTZero 检测,结果显示 “人工撰写概率 80%”,但上传知网后因为 “段落逻辑松散” 被导师打回。这说明知网的人工审核环节,比机器检测更能发现 AI 生成的痕迹—— 尤其是对文献综述这种需要深度思辨的文体。

不过 2024 年知网和某 AI 检测公司达成了合作,据说在 “大学生论文检测系统” 里试点加入了 AI 识别模块。但这个功能目前只对部分高校开放,而且检测准确率不到 60%—— 很多纯人工撰写的综述因为语言风格太规整,反而被误判为 AI 生成。

⚠️ 风险评估:哪些情况容易被盯上?

如果你用 AI 写文献综述,这几种情况风险最高:

1. 大量使用通用句式

AI 生成时很喜欢用 “综上所述”“研究表明”“近年来” 这类套话。文献综述里偶尔用没问题,但如果每段都以这类词开头,知网的系统可能会触发 “语言模式异常” 预警。有数据显示,当这类词汇出现频率超过全文的 5% 时,被人工审核重点关注的概率会提升 3 倍。

2. 参考文献格式混乱

AI 生成工具(比如 ChatGPT)对参考文献的处理一直是弱项。它可能会编造 DOI 号,或者把期刊名称写错(比如把《中国社会科学》写成《中国社会科学学报》)。这些细节知网的检测系统能精准捕捉 —— 虽然不算 AI 生成的证据,但会直接影响论文通过率。

3. 专业领域深度不足

比如医学类文献综述需要引用最新的临床数据,AI 可能会把 2020 年的研究结果写成 2023 年的。这种 “事实性错误” 在知网的数据库里一比对就会暴露。有个案例:某篇用 AI 写的心理学综述,引用了一篇 “2022 年发表的元分析”,但知网数据库显示该论文实际发表于 2018 年,结果被判定为 “数据造假”。

📌 降低风险的实操建议:不只是躲检测

就算知网暂时查不出 AI 生成,也不代表可以放心用。学术不端的认定从来不止看查重报告。

1. 用 AI 搭框架,自己填细节

让 AI 写综述的大纲和研究现状部分,然后逐句核对。比如 AI 提到 “XX 学者的研究支持这一观点”,你必须找到原文确认,再补充 “该研究的样本量为 XXX,结论存在 XX 局限性”—— 这些细节 AI 通常写不出来,加进去能显著降低人工审核的怀疑。

2. 故意留 “人工痕迹”

比如在段落里加入一两句口语化表达(“这个结论在实际应用中其实有点争议”),或者在分析部分出现轻微的逻辑跳跃(就像人思考时的犹豫)。AI 生成的内容往往太 “完美”,反而显得不真实。

3. 交叉检测 + 人工复盘

写完后先用 Turnitin 的 AI 检测(目前准确率最高),再用知网查重复率。如果 Turnitin 提示 AI 生成概率超过 30%,重点修改那些被标红的段落 —— 比如把长句拆成短句,替换掉 AI 常用的 “学术套话”。

📈 未来趋势:知网会全面封杀 AI 写作吗?

从目前的动作看,知网更倾向于 “升级检测维度” 而不是 “直接封杀”。2024 年知网的学术规范指南里新增了一条:“使用生成式 AI 工具需在论文中明确标注”,但没说标注后就不合格。

这背后的逻辑很简单:AI 写作已经成了普遍现象,完全禁止不现实。更可能的方向是 —— 未来知网的检测报告里会增加 “AI 生成概率” 指标,就像现在的相似度指标一样。学校和期刊可以根据这个指标制定自己的标准(比如要求 AI 生成占比不超过 20%)。

对写文献综述的人来说,真正的风险不是 “被知网查到”,而是学术能力退化。文献综述的核心是体现你的研究梳理能力,全靠 AI 写,就算通过检测,也过不了答辩时导师的提问 —— 这才是最该担心的。