最近刷社交平台,总能刷到一些 “一眼假” 却又让人难辨真假的内容。比如有人用 AIGC 生成 “某明星官宣结婚” 的新闻截图,配上模仿该明星语气的文案,几小时内转发量就破万。等粉丝们炸开锅,才有人发现这是 AI 合成的。这种 AIGC 虚假信息现在越来越多,已经从娱乐领域渗透到新闻、电商、甚至政务信息领域。

🚨AIGC 虚假信息:比你想象的更 “懂” 欺骗

AIGC 虚假信息之所以难防,核心在于它抓住了人类认知的弱点。普通造假可能会出现逻辑漏洞,比如时间线对不上、细节矛盾,但 AI 生成的内容会模仿真实信息的 “语境逻辑”。比如生成一篇 “某地暴雨引发灾害” 的虚假新闻,它会参考历史真实灾害报道的结构 —— 先讲时间地点,再描述现场情况,甚至会加入 “目击者描述”“气象部门提示” 这类细节,让整个内容看起来 “有根有据”。

更麻烦的是它的传播速度。以前一条谣言可能需要人工编写、找素材、排版,现在用 AIGC 工具,输入关键词 “某品牌奶粉检测不合格”,10 分钟就能生成带数据、带 “专家观点” 的文章。这些内容一旦被别有用心的人利用,在母婴群里转发,半天就能让一个品牌的销量暴跌。有数据显示,2024 年第三季度,国内因 AIGC 虚假信息引发的品牌维权事件同比增长了 217%,其中 80% 的虚假内容在被举报前已传播超过 10 万次。

它还在不断 “进化”。早期的 AI 生成文本容易出现 “重复表达”“逻辑断层”,现在的大模型已经能避免这些问题。甚至能模仿特定人的写作风格 —— 比如模仿某财经博主的语气写股市分析,连常用的口头禅、标点习惯都能复制。这就导致很多老粉丝也可能被骗,以为真是博主本人发布的内容。

🔍朱雀 AI 检测助手:它是怎么 “拆穿” 虚假信息的?

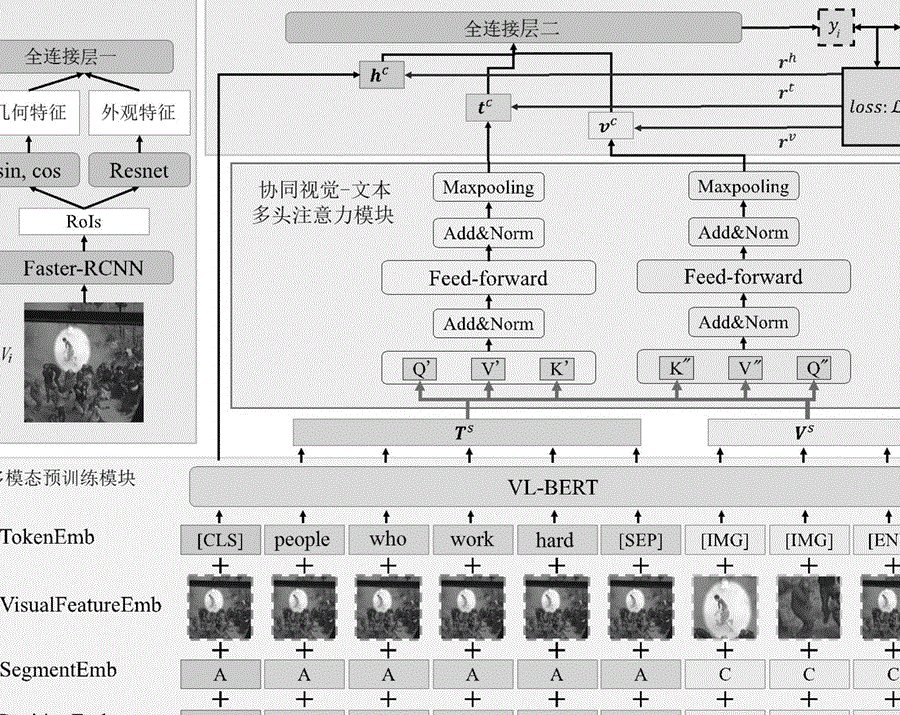

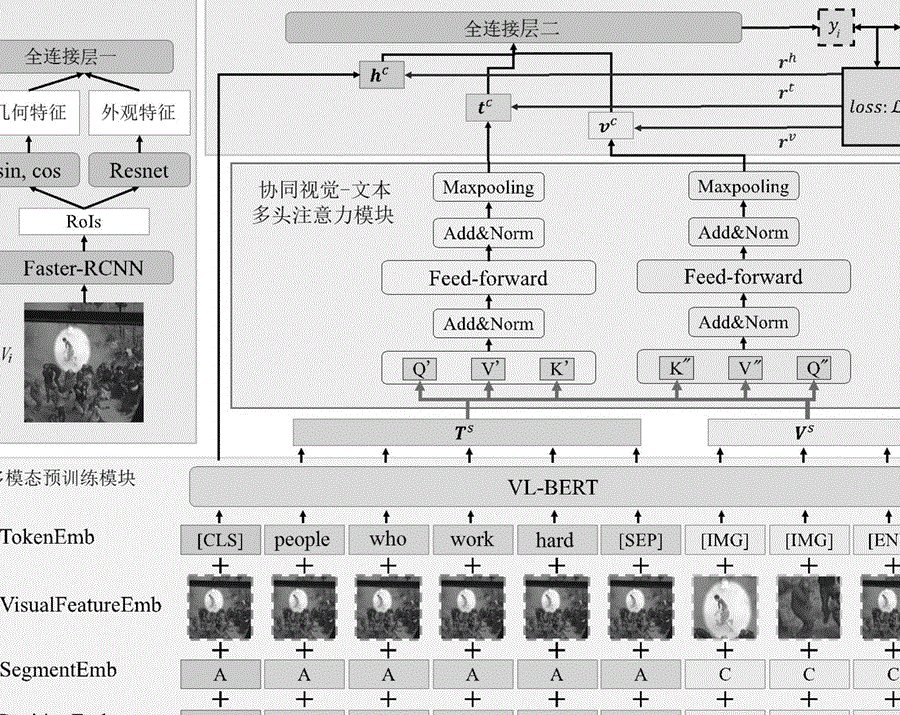

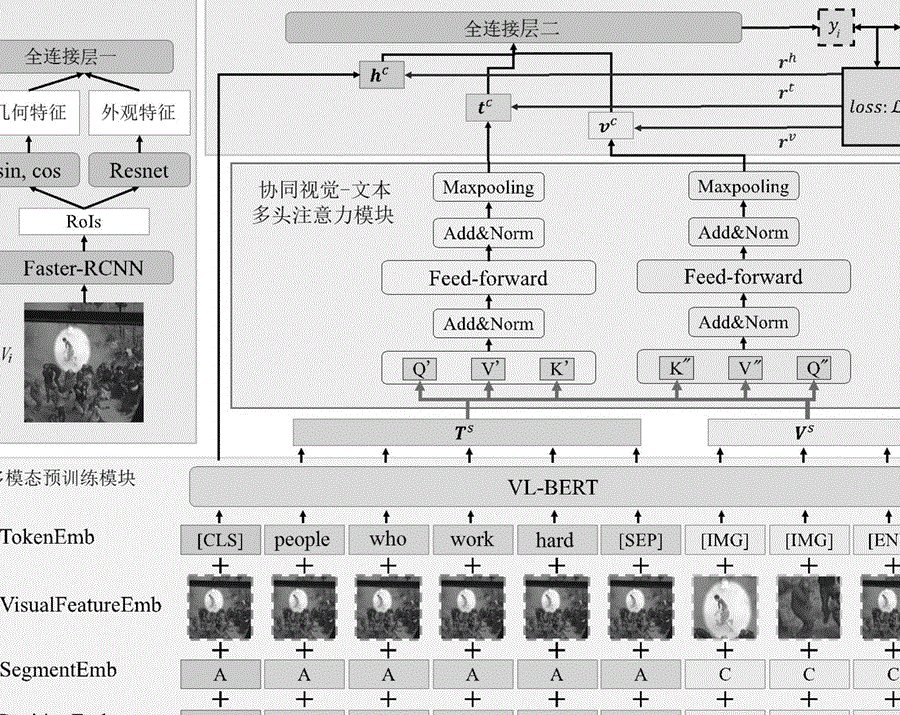

朱雀 AI 检测助手能在众多检测工具中脱颖而出,关键在于它不只用 “单一维度” 判断。普通检测工具可能只看文本的 “通顺度” 或 “词汇重复率”,但朱雀用的是 “多层级特征比对” 技术。简单说,它会像侦探破案一样,从多个角度验证内容的真实性。

首先是 “文本基因分析”。真实内容不管是谁写的,都会带有 “人类思维痕迹”—— 比如偶尔出现的口语化表达、特定领域的专业术语使用习惯,甚至是 “笔误”。AI 生成的内容虽然流畅,但在这些细节上会露出马脚。朱雀会提取文本中的 “非结构化特征”,比如某个行业术语的使用频率、短句和长句的搭配比例,再和真实文本数据库比对。如果某篇 “专家访谈” 里,专业术语的出现频率比真实专家访谈高出 30%,且几乎没有口语化短句,就会被标记为 “高风险”。

其次是 “多模态溯源”。现在很多 AIGC 虚假信息是 “图文结合” 的 —— 比如生成一张 “某景区突发事故” 的图片,再配一段文字。朱雀能同时分析图片和文本的关联性。它会检查图片的像素分布是否符合真实拍摄规律(AI 生成的图片在边缘过渡处容易有异常像素),同时比对文本描述和图片内容的逻辑是否匹配。比如文本说 “下午 3 点发生事故”,但图片里的光影却显示是正午,这种矛盾点会被立刻捕捉到。

最核心的是 “动态更新机制”。AIGC 技术在变,虚假信息的生成手法也在变。朱雀的检测模型每 7 天就会更新一次,接入最新的 AIGC 生成样本库。比如上个月出现了 “用 AI 生成政府公告格式” 的造假手法,朱雀在 3 天内就新增了 “公文格式特征库”,专门识别模仿政府文风的 AI 文本 —— 包括特定的标题层级、落款格式、常用表述等,现在对这类虚假信息的识别准确率能达到 92% 以上。

📌朱雀 AI 检测的 “实战场”:这些场景已经离不开它

现在很多平台已经把朱雀 AI 检测助手当成 “标配工具”。媒体行业是最早用起来的。一家地方新闻网站之前遇到过麻烦 —— 有人用 AI 生成 “本地化工厂爆炸” 的新闻,配上合成的浓烟图片,发布后 1 小时内接到了上百个市民咨询电话。接入朱雀后,编辑在发布前先过一遍检测,系统会自动标出 “可疑点”:比如 “爆炸时间与工厂开工时间冲突”“图片像素异常”。现在这家网站的虚假信息拦截率从之前的 65% 提升到了 91%。

电商平台也很需要它。有商家发现,竞争对手用 AIGC 生成 “该品牌产品检测出有害物质” 的 “检测报告”,配上模仿权威机构的抬头,在评论区和社群里传播。这种虚假信息对销量打击极大,而且人工核实需要 3-5 天。用朱雀之后,平台能在信息发布后的 10 分钟内完成检测 —— 通过比对 “检测报告” 的格式、公章特征、数据表述方式,快速判断是否为 AI 生成,第一时间下架并溯源。某电商平台用了 3 个月,这类恶意竞争投诉量下降了 78%。

甚至普通人也能用上。朱雀有个轻量化版本,集成在浏览器插件里。刷朋友圈时看到 “某地出现新型诈骗” 的提醒,不确定真假,点一下插件就能检测。它会给出 “可信度评分” 和具体理由,比如 “文本中‘紧急通知’类表述占比过高,符合 AI 生成谣言的特征”“未找到对应官方渠道发布记录”。有用户反馈,之前差点转发一条 AI 生成的 “地震预警” 信息,被插件提醒后去官方平台核实,才发现是假的。

🤔伦理关:检测工具也需要 “边界感”

但朱雀 AI 检测助手在使用中,也遇到了一些绕不开的伦理问题。最常见的是 “误判” 争议。有自媒体作者抱怨,自己写的文章被标记为 “疑似 AI 生成”,原因是 “逻辑过于严谨,几乎没有口语化表达”。这其实是因为有些严谨的作者本身就有 “零口语” 的写作习惯,和 AI 生成文本的特征重合了。虽然朱雀的误判率已经控制在 3% 以内,但一旦发生在个人创作者身上,就可能影响内容发布。现在团队正在优化 —— 新增 “人工申诉通道”,作者可以上传写作过程记录(比如草稿修改痕迹),系统会结合这些信息二次判断。

还有隐私问题。检测文本时,会不会涉及内容背后的用户信息?比如某企业用朱雀检测内部文档,担心敏感信息被泄露。朱雀的解决办法是 “本地检测模式”—— 企业可以把检测模型部署在自己的服务器上,文本不会上传到云端。这样既保证了检测效果,又避免了数据外泄。但这种模式成本较高,目前主要面向中大型企业,中小企业还只能用云端检测,这方面还需要进一步优化。

更值得思考的是 “技术中立性”。如果有人用朱雀去检测正常的 AIGC 创作内容,比如设计师用 AI 生成的插画、作者用 AI 辅助写的小说,会不会被误当成 “虚假信息”?其实朱雀早就考虑到这一点 —— 它有 “场景模式” 选择。用户可以指定检测场景是 “新闻资讯” 还是 “创意创作”。在 “创意创作” 模式下,系统会放宽判断标准,只识别 “明确带有虚假事实陈述” 的内容,不会干涉正常的 AI 辅助创作。

🌱对抗 AIGC 虚假信息:不只是技术的事

光靠朱雀这样的检测工具还不够,还需要形成 “技术 + 规则 + 用户意识” 的三重防线。技术层面,检测工具要和 AIGC 生成工具 “赛跑”。现在有些 AIGC 工具已经开始加 “水印”—— 在生成内容中嵌入普通人看不到但机器能识别的标记。朱雀正在和这类工具合作,通过识别水印快速判断内容来源,未来准确率可能再提升 15% 左右。

规则层面,平台需要明确责任。比如要求 AIGC 生成的内容必须标注 “由 AI 生成”,否则一旦被检测出是虚假信息,平台要对发布者进行处罚。现在某短视频平台已经这么做了 —— 用朱雀检测出的 AI 虚假内容,除了下架,还会对账号进行 “信用分扣除”,累计 3 次就限制发布功能。实施后,平台上的 AI 虚假信息发布量下降了 63%。

用户意识也很重要。哪怕有检测工具,也不能完全依赖。平时看到 “劲爆消息”,可以多做一步 —— 去官方渠道核实。比如看到 “某政策出台”,去政府官网查;看到 “某产品出事”,去监管部门的公示平台看。朱雀的插件也在加新功能,未来会直接在检测结果里附上 “官方核实渠道链接”,降低用户的核实成本。

AIGC 技术本身是中性的,它能帮我们高效创作,但也可能被用来造假。朱雀 AI 检测助手这样的工具,本质上是在给 AIGC 技术 “划边界”—— 既不扼杀创新,又能守住真实的底线。当然,这条路还很长,技术会迭代,规则会完善,我们每个人的判断能力也需要跟着提升。毕竟,对抗虚假信息,最终靠的还是 “技术防得住、规则管得住、大家辨得清”。

【该文章由diwuai.com第五 ai 创作,第五 AI - 高质量公众号、头条号等自媒体文章创作平台 | 降 AI 味 + AI 检测 + 全网热搜爆文库🔗立即免费注册 开始体验工具箱 - 朱雀 AI 味降低到 0%- 降 AI 去 AI 味】