要搞明白 AI 检测工具的准确率怎么算、怎么评,得从它的底层逻辑说起。这些工具本质上是通过算法模型对输入内容进行分析,然后给出判断结果。而准确率,就是衡量这些判断和真实情况吻合程度的指标。但这里面的门道可不少,不是简单算个百分比那么简单。

📊准确率计算的底层逻辑:从数据样本到判断标准

计算准确率的第一步,是确定 “什么是对的”。几乎所有 AI 检测工具都会先设定一个 “真实标签”—— 通常是人工标注的结果。比如检测一篇文章是不是 AI 生成的,会先让专业编辑团队手动判断,把这些结果当成 “标准答案”。

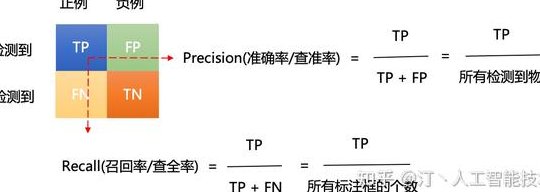

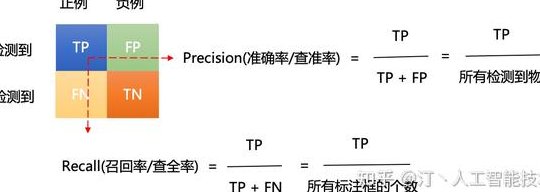

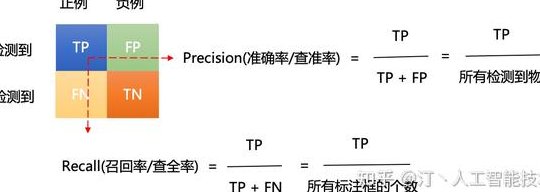

然后,工具会对同样的样本进行检测,得出自己的判断。这时候就有了四个基础数据:真正例(TP),也就是工具判断为 AI 生成,实际也是 AI 生成的样本;假正例(FP),工具判断为 AI 生成,实际是人工创作的样本;真负例(TN),工具判断为人工创作,实际也是人工创作的样本;假负例(FN),工具判断为人工创作,实际是 AI 生成的样本。

最基础的准确率计算公式,就是(TP + TN)÷(TP + FP + TN + FN)×100%。这个公式看起来简单,但它的可靠性完全依赖于 “真实标签” 的质量。要是人工标注的样本本身就有误差,比如不同标注者对同一内容有不同判断,那算出来的准确率就会失真。

还有一种情况容易被忽略 ——样本分布。如果测试集中 90% 都是 AI 生成内容,哪怕工具把所有样本都判为 AI 生成,准确率也能达到 90%。但这种结果在实际应用中毫无意义,因为真实场景里 AI 和人工内容的比例可能完全不同。

🔍评估维度:不止于 “准”,还要看 “全” 和 “稳”

光看准确率远远不够,行业里更看重几个核心指标的组合。精确率(Precision) 是说,工具判断为 AI 生成的内容里,真正是 AI 生成的比例有多高。这个指标对内容平台很重要,要是精确率低,会误判很多人工创作,引起用户不满。

召回率(Recall) 则相反,它衡量的是所有真实 AI 生成内容中,被工具成功识别出来的比例。对于需要严格过滤 AI 内容的场景,比如学术论文检测,召回率低就意味着有漏网之鱼,风险很大。

这两个指标常常会 “打架”。想提高精确率,可能会让工具变得更 “谨慎”,结果漏掉更多 AI 内容,召回率下降;反过来追求高召回率,又可能把一些人工内容误判,精确率降低。所以通常会用F1 分数来综合评估,它是精确率和召回率的调和平均数,能更全面反映工具的平衡能力。

另一个关键维度是鲁棒性。就是看工具在面对 “对抗性样本” 时表现如何。比如有人故意修改 AI 生成内容的标点、替换同义词,让它看起来更像人工创作。好的检测工具应该能抵御这类干扰,准确率不会大幅波动。要是换个数据集,准确率就掉一大截,说明工具的泛化能力太差。

📝评估方法:从实验室到真实场景的落差

实验室里的评估结果,和实际使用中往往有差距。最常见的评估方法是交叉验证,把数据集分成几部分,轮流用不同部分做训练和测试,能减少偶然因素的影响。但这种方法用的还是固定数据集,和真实世界的复杂情况比,还是太理想。

人工复核抽样更贴近实际。随机抽取工具判断过的内容,让专业人员重新标注,计算两者的吻合度。这种方法成本高,但能发现工具在特定场景的问题。比如某工具在检测短文本时准确率很高,碰到长文章就频繁出错,这种细节在批量评估中容易被平均数据掩盖。

还有一种新兴的评估方式是动态监测。连续跟踪工具在实际使用中的准确率变化,因为网络上的 AI 生成内容风格一直在变。比如某个 AI 写作工具更新了算法,生成的内容更像人工了,检测工具要是没及时迭代,准确率肯定会下降。动态监测能及时发现这种问题。

值得注意的是,不同行业的评估标准天差地别。社交媒体平台可能更容忍低精确率,只要能把大部分 AI 垃圾内容挡在门外就行;而出版行业对误判的容忍度极低,哪怕漏检一点 AI 内容,也可能引发版权纠纷,所以对精确率要求极高。

🔗影响准确率的核心因素:算法、数据和 “对手” 的博弈

算法模型是基础。基于 Transformer 架构的检测工具,通常比传统的统计方法准确率更高,因为它能捕捉到更细微的语言模式。但模型越大、越复杂,计算成本也越高,对硬件要求也更高,小公司很难负担。

训练数据的质量比数量更重要。如果训练时用的 AI 生成内容,都是某一个模型的早期版本产出的,那工具对新模型生成的内容就可能 “认不出来”。现在 AI 生成技术更新太快,检测工具的训练数据必须跟着迭代,否则准确率会快速下降。

还有个容易被忽视的点 ——多模态内容的挑战。现在很多内容是文字加图片、音频的混合形式,单纯检测文字部分的准确率再高,也可能因为其他模态的干扰,导致整体判断失误。比如 AI 生成的图片配人工写的文字,工具可能误判整个内容为 AI 生成。

🧐行业现状:准确率宣传背后的猫腻

不少 AI 检测工具宣称准确率超过 95%,但仔细看说明会发现,它们用的测试集是自己构建的,里面的 AI 内容都是用特定模型生成的,而且人工内容风格单一。这种 “量身定做” 的评估,结果肯定好看,但参考价值不大。

更夸张的是,有些工具会选择性公布指标。只说准确率多高,绝口不提精确率和召回率。比如某工具在宣传时说准确率 98%,但实际使用中,100 篇被它标为 AI 生成的内容里,可能有 30 篇是人工写的,精确率只有 70%,只是因为测试集里 AI 内容占比极高,才显得准确率好看。

行业里缺乏统一的评估标准,这是最大的问题。不同公司用不同的数据集、不同的指标组合来宣称自己的准确率,用户根本没法横向比较。这也是为什么很多用户觉得 “测了跟没测一样”,换个工具结果就完全不同。

🚀提升准确率的方向:技术迭代与场景适配

未来提高 AI 检测工具的准确率,得从几个方面发力。多模型融合是个趋势,让不同原理的检测算法互相补充。比如有的模型擅长分析语法模式,有的擅长捕捉语义逻辑,把它们的结果结合起来,能减少单一模型的盲区。

实时学习机制也很关键。让检测工具能在线上实时收集新的 AI 生成内容特征,不断更新模型。就像杀毒软件需要不断更新病毒库,AI 检测工具也得跟着 “对手” 的进化而进化。

更重要的是场景化定制。不同行业的需求差异太大,通用型工具很难在所有场景都保持高准确率。针对学术写作、营销文案、社交媒体帖子等不同场景,开发专用的检测模型,才能真正提升实际使用中的准确率。

当然,最根本的还是建立行业公认的评估基准。就像衡量手机拍照效果有 DxOMark,AI 检测工具也需要一个中立的第三方机构,用统一的数据集和评估方法来打分,让用户能明明白白选择。

AI 检测工具的准确率计算和评估,远不止表面看到的一个百分比那么简单。从数据样本的选择,到多个指标的综合考量,再到真实场景中的动态监测,每个环节都可能影响最终结果。作为用户,不能只看宣传的数字,得了解背后的评估逻辑,结合自己的使用场景去判断。而对于开发者来说,提高准确率的关键,不在于实验室里的漂亮数据,而在于能否经得起真实世界复杂场景的考验。

【该文章由diwuai.com第五 ai 创作,第五 AI - 高质量公众号、头条号等自媒体文章创作平台 | 降 AI 味 + AI 检测 + 全网热搜爆文库