AI 检测工具如今在内容行业里几乎成了标配,但只要你真的用过就知道,它们压根做不到 100% 准确。不少原创作者都遇到过这种糟心事:自己一字一句敲出来的东西,被系统标上 “AI 生成” 的标签;有的团队花几周做的深度报道,因为某个段落的句式 “太规整”,直接被平台限流。这种误判带来的损失可不小 —— 流量缩水、账号权重下降,甚至还会影响创作者的职业信誉。

面对这种情况,咱们不能光抱怨工具不行,得主动想办法应对。毕竟 AI 检测技术还在进化,平台的审核规则也在变,与其等着技术完美,不如先掌握一套能保护自己的方法论。

🛠️ 先搞懂 AI 检测为啥会 “看走眼”

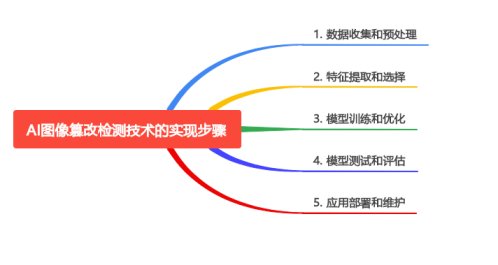

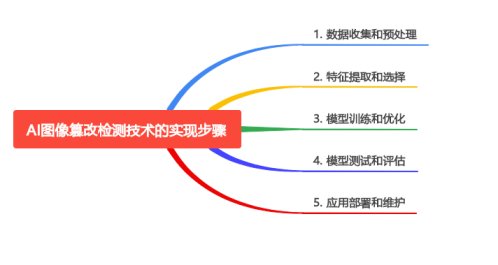

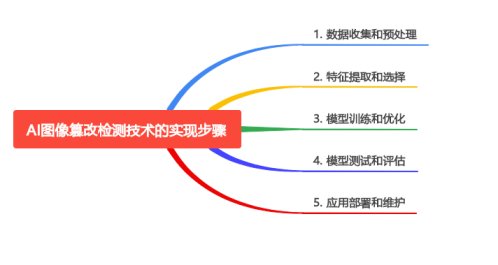

要应对误判,首先得明白 AI 检测工具是怎么工作的。现在主流的检测工具,本质上都是在做 “模式比对”。它们会先收集海量的 AI 生成文本(比如 ChatGPT、文心一言的输出内容),提取这些文本的语言特征 —— 比如特定词汇的出现频率、句式结构的规律性、逻辑跳转的模式等,然后拿待检测的文本和这些特征库做比对,最后给出一个 “AI 概率值”。

但问题就出在这个 “特征库” 上。人类创作的文本里,也可能出现和 AI 相似的语言模式。比如学术论文里常见的严谨句式,自媒体作者常用的爆款标题结构,甚至某些作家标志性的重复修辞,都可能被系统误判。去年有个案例,某科普博主写量子物理文章时,因为频繁使用 “薛定谔的猫”“叠加态” 等专业术语,且逻辑链条清晰,被某检测工具判定为 85% AI 生成 —— 但这些内容明明是他参考了十多篇论文后总结的原创。

还有个更麻烦的点:不同检测工具的标准不一样。你把同一篇文章分别放进 Grammarly、Originality.ai 和国内的某些检测平台,可能会得到三个完全不同的结果。有的工具对 “长句” 特别敏感,有的则盯着 “关联词密度” 不放,甚至还有工具会因为你用了某个 AI 训练库里常见的比喻,就给你扣分。这种标准的混乱,让创作者根本摸不着北。

✍️ 从创作源头降低误判概率

既然 AI 检测盯着 “语言模式” 不放,那咱们就在创作过程中主动打破这种 “规律性”。这不是说要故意写得颠三倒四,而是在保持可读性的前提下,加入更多 “人类专属” 的创作痕迹。

加入个性化表达是个好办法。AI 生成的内容往往追求 “普适性”,很少有强烈的个人印记,而人类创作时总会带上自己的经历、情绪和独特视角。比如写美食测评,别只说 “这道菜味道鲜美,层次感丰富”,可以加一句 “咬下去第一口就想起外婆做的红烧肉,但多了点陈皮的清苦,后劲很特别”;写职场文章时,在分析通用规律后,补一个自己踩过的坑:“我前公司就是这么搞的,结果三个月内走了三个核心员工,后来才发现问题出在……” 这些具体的个人元素,AI 很难模仿,也能让检测工具识别出 “人类温度”。

刻意制造 “不完美” 也有用。AI 写东西通常太 “顺” 了,很少有重复、修正或者口语化的插入语,而人类写作时难免会有这种自然的 “瑕疵”。比如在长段落里突然加个短句:“这点很重要,真的”;或者在分析完一个观点后,补一句 “可能我这么说有点绝对,不过就我接触的案例来看……”。这些看似 “不规整” 的表达,反而能降低被误判的概率。

还有个小技巧:混合使用不同风格的句式。AI 容易陷入 “长句循环”,尤其是在解释复杂概念时。咱们可以有意识地交替使用长短句,比如用一个长句讲清楚背景,接一个短句强调重点,再用一个反问句引发思考。这种节奏变化,能让文本的 “人类特征” 更明显。

📝 被误判后,怎么有效申诉?

就算再小心,也可能遇到误判。这时候能不能顺利申诉,直接决定了内容的 “生死”。很多创作者申诉失败,不是因为内容不行,而是没找对方法。

关键是要提供 “创作轨迹证据”。平台审核人员在判断内容是否为原创时,最看重的是 “创作过程是否可追溯”。你可以在申诉时附上这些材料:草稿记录(比如带修改痕迹的 Word 文档、石墨文档的历史版本)、素材来源(参考的书籍、采访录音、现场照片)、创作时间线(比如在社群里和同行讨论思路的聊天记录,甚至是写稿时的屏幕录制)。这些东西 AI 很难伪造,说服力远大于一句 “这是我自己写的”。

申诉话术也有讲究。别上来就指责平台工具不行,而是先说明自己的创作逻辑:“这篇文章是针对 XX 事件的深度分析,我花了三天时间采访了 5 位当事人,文中提到的 XX 数据来自 XX 机构的公开报告,之所以用 XX 结构,是为了让读者更容易理解……” 把 “为什么这么写” 讲清楚,再指出检测结果的矛盾点:“我注意到检测工具认为第 3 段 AI 概率高,但这段其实是直接引用了受访者的原话,附上采访录音佐证……” 这种理性沟通的方式,更容易让审核人员重视你的申诉。

另外,要搞清楚不同平台的申诉通道。有的平台有专门的原创保护入口,有的需要发邮件给审核团队,还有的得通过账号后台的 “反馈” 功能。提前记好这些渠道的要求 —— 比如是否需要填写原创声明、是否要提供身份证等信息,避免因为流程问题耽误申诉时机。

🧰 善用工具,但别被工具绑架

面对 AI 检测,完全不用工具肯定不行,但过度依赖也会出问题。聪明的做法是建立一套 “工具组合策略”,让工具为你服务,而不是反过来限制你的创作。

先用 “反 AI 检测” 工具做初步筛查,但别迷信结果。现在有不少工具声称能 “降低 AI 检测概率”,比如改写句式、调整词汇密度等。你可以在初稿完成后用它们扫一遍,看看哪些段落被标红,然后手动修改 —— 但记住,修改的目的是让表达更自然,而不是硬套 “反检测模板”。有个作者为了降低 AI 概率,故意在文中加了很多无意义的口头禅,结果内容读起来晦涩难懂,反而丢了读者。

更重要的是建立自己的 “原创校验库”。平时把自己的原创文章分类存档,标注清楚创作时间、背景和核心观点。等遇到检测纠纷时,这些历史作品就是最好的 “风格证明”—— 你可以告诉平台:“我过去三年发表的 XX 篇文章,风格一直是这样,检测工具之前都判定为原创,这次的内容和我的一贯风格一致……” 这种长期积累的 “创作指纹”,比单次检测结果更有说服力。

还可以试试 “小范围测试”。如果是重要的内容,发布前先发给几个信任的同行,或者发到小社群里收集反馈。如果有人说 “这段读起来不像你写的”,那可能真的存在容易被误判的风险,及时调整后再正式发布。这种 “人肉校验” 虽然原始,但在 AI 检测不靠谱的情况下,反而很有效。

🔍 长期来看,要培养 “抗风险能力”

AI 检测技术肯定会越来越完善,但只要它还是 “机器判断”,就难免有局限性。对创作者来说,更重要的是建立不依赖单一平台、不依赖单一检测标准的生存能力。

打造个人 IP 是最好的 “抗误判保险”。当你的账号有了明确的人设和固定的受众,读者会因为 “认可你这个人” 而相信你的内容。比如一个坚持手写日记体的博主,就算某篇文章被 AI 检测标红,他的粉丝也会留言 “这就是他平时说话的样子”,这种用户自发的 “背书”,平台是看得到的。而且有个人 IP 的账号,在申诉时也更容易获得平台的重视。

多平台分发能降低风险。别把所有鸡蛋放在一个篮子里,同一篇内容可以根据不同平台的规则稍作调整后发布。比如某平台对 AI 检测特别严格,你就多放些个人案例和口语化表达;另一平台更看重内容深度,你就保持严谨的逻辑结构。就算某个平台误判了,其他平台的流量还能撑住,不至于一下子陷入被动。

还要关注行业动态。AI 检测技术的更新、平台审核规则的变化,这些信息对创作者来说很重要。可以加入一些内容创作者社群,和同行交流最新的 “踩坑案例”;关注科技媒体对 AI 检测技术的解读,了解不同工具的原理差异;甚至可以花点时间研究平台发布的 “内容规范更新说明”—— 里面往往藏着避免误判的关键信息。

说到底,AI 检测只是个工具,它的存在是为了规范内容生态,而不是扼杀原创。对创作者来说,与其害怕被误判,不如把精力放在 “怎么写出 AI 替代不了的内容” 上 —— 那些带着个人温度的经历、深入行业的洞察、独特的叙事视角,才是最安全的 “反检测武器”。

毕竟,读者最终认的是内容的价值,而不是某个检测工具给出的分数。只要你的内容能真正帮到别人,就算偶尔被 AI “冤枉”,也总会有发光的机会。

【该文章由diwuai.com第五 ai 创作,第五 AI - 高质量公众号、头条号等自媒体文章创作平台 | 降 AI 味 + AI 检测 + 全网热搜爆文库