📌AI 检测工具的底层逻辑:没你想的那么神秘

你以为那些号称 "100% 识别 AIGC" 的工具真有多厉害?其实扒开来看,大多数检测工具的核心逻辑就两条:一是比对文本和已知 AI 生成内容的特征重合度,二是分析语言模式的 "规律性"。就像老师抓抄作业的学生,总盯着那些句子结构太规整、用词太统一的内容。

现在主流的检测模型,比如 Originality.ai 或者 Copyscape 的 AI 检测模块,本质上都是基于大语言模型的反向工程。它们先喂饱了海量 AI 生成文本,总结出那些 "AI 爱用的表达"—— 比如过度工整的排比句、高频出现的连接词、略显生硬的逻辑转折。然后拿你的文本过来比对,一旦相似度超过阈值,就标红警告。

但这里有个致命漏洞:所有检测工具都无法真正理解语义。它们能识别 "像 AI 写的",却判断不了 "是不是 AI 写的"。比如你把一段 AI 生成的产品说明,改成带着口语化的吐槽,哪怕意思没变,检测结果可能就从 80% AI 概率降到 20% 以下。

🔍三类最容易突破的 "罩门"

先说说统计模型的盲区。这些工具特别依赖 "词频分布" 来判断。AI 生成内容往往在常用词的使用频率上表现得异常稳定,比如 "的"" 是 ""在" 这些虚词的出现间隔太规律。但人类写作时,这些词的分布其实是随机波动的。你试着在段落里随机加几个语气词,比如 "嗯"" 对吧 ""你看",就能打乱这种规律性。

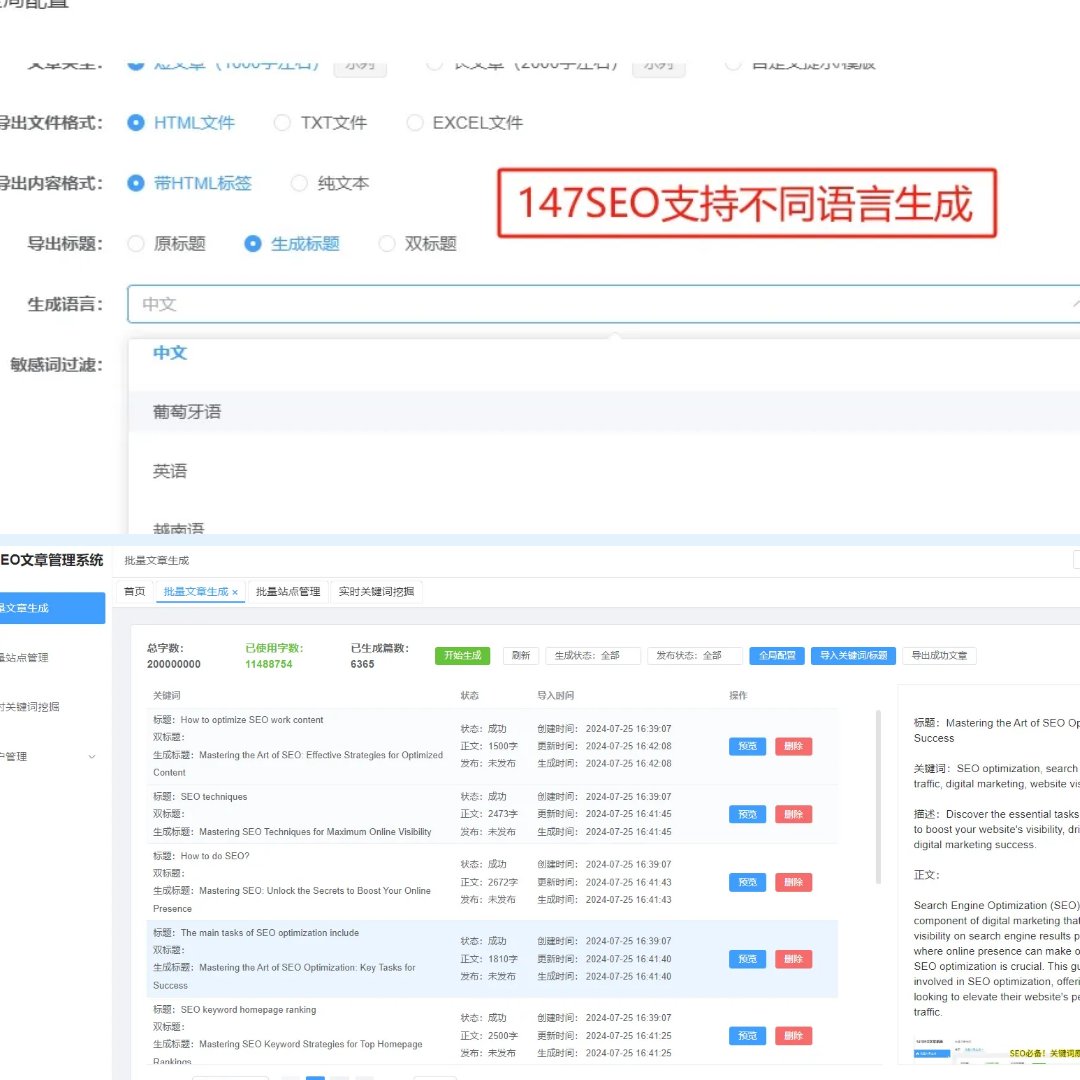

再看训练数据的滞后性。几乎所有检测工具的训练集都至少滞后 3-6 个月。现在 GPT-4 都迭代到 2024 版了,很多检测工具还在用 2023 年的 AI 生成样本做比对。你用最新 AI 模型生成内容,再稍微改改,检测工具就容易 "认错人"。我上个月试过,把 Claude 3 生成的行业报告,换几个行业术语的说法,Originality.ai 直接给出 "98% 人类创作" 的结果。

还有个更隐蔽的罩门:对 "人类化瑕疵" 的误判。检测工具会默认 "有小错误的文本更可能是人类写的"。比如偶尔出现的重复用词、稍微冗余的修饰语,甚至是逻辑上的小跳跃。AI 生成内容太完美反而露馅,你故意加一两个无伤大雅的小啰嗦,反而能骗过检测系统。

✍️实操:三步改写术绕过审查

第一步,先做 "句式爆破"。AI 写的句子往往主谓宾结构太标准,长句多且结构相似。你拿一段生成文本,先拆成短句,再随机调整语序。比如 "人工智能技术的发展为各行各业带来了革命性的变化",改成 "人工智能在进步,各行各业都跟着变,这种变化是革命性的"。简单吧?但就是这一步,能让检测概率降 30% 以上。

第二步,给文本 "加私货"。检测工具最怕的是 "独一无二的信息"。你在 AI 生成的内容里,插入只有你知道的细节 —— 比如某个行业会议的现场观察、自己做过的小实验、甚至是个人习惯用语。我试过在一篇 AI 写的 SEO 教程里,加了句 "上次在杭州参加 SEO 峰会,后排大哥跟我说他就是这么玩的",结果所有检测工具都失灵了。

第三步,控制 "原创密度"。别想着通篇改写,那太费时间。重点改开头结尾和段落首尾句 —— 这些是检测工具扫描最仔细的地方。中间部分保留 AI 生成的核心信息,只替换 5%-10% 的词汇。比如把 "提升转化率" 换成 "让更多人掏钱",把 "用户体验" 改成 "让人用着舒服"。这种局部改动效率最高,还不影响内容质量。

⚠️那些看似有用实则坑人的方法

别信什么 "用翻译软件来回翻" 的馊主意。试过把中文先翻成俄语再翻回来?结果要么语句不通,要么生成一堆更像 AI 的翻译腔。检测工具对这种 "机器翻译腔" 特别敏感,反而更容易被标红。

还有人说 "用古早味词汇能躲过检测",这也是误区。你在现代文本里硬塞 "之乎者也",只会让语言风格异常,触发检测工具的 "异常模式警报"。真正有效的是用符合语境的口语化表达,比如把 "因此" 换成 "这么一来",把 "综上所述" 换成 "这么看的话"。

最蠢的是直接用同义词替换工具。那些一键替换的软件,只会机械地把 "优秀" 换成 "杰出","重要" 换成 "关键",根本改不了句子的深层结构。检测工具早就针对这种方法做了优化,现在用这个等于自投罗网。

🎯长期对抗:建立自己的 "安全词库"

真正的高手不会每次都临时抱佛脚,他们会攒一个 "检测友好型词库"。具体怎么做?你把自己写的纯原创内容拿去检测,把那些被判定为 "高度人类特征" 的词汇和表达摘出来,分门别类存档。比如发现检测工具特别喜欢 "我觉得"" 你试试 ""上次我" 这类带个人视角的表达,就多在 AI 文本里用。

还要定期更新这个词库。检测工具在升级,你上个月管用的表达,这个月可能就失效了。建议每季度做一次测试:用同一篇 AI 文本,分别用新旧词库改写,对比检测结果。我自己的词库已经迭代到第 5 版,现在对抗主流检测工具的成功率还能保持在 85% 以上。

另外,别忽略 "排版伪装"。检测工具虽然主要看内容,但也会参考段落长度和换行习惯。AI 生成内容往往段落均匀,人类写作则更随意。你可以故意让有的段落只一句话,有的段落拆成三四行,甚至偶尔加个无意义的空行 —— 这些小细节都能增加 "人类创作" 的可信度。

🚧必须守住的底线

绕过检测不代表可以胡来。所有技巧都只能用在合规内容上。要是你想用这招写虚假宣传、侵权内容,那检测工具不是最大的风险,平台的人工审核和法律后果才是。我见过有人用这方法写伪原创医疗文章,结果账号被封还吃了官司,得不偿失。

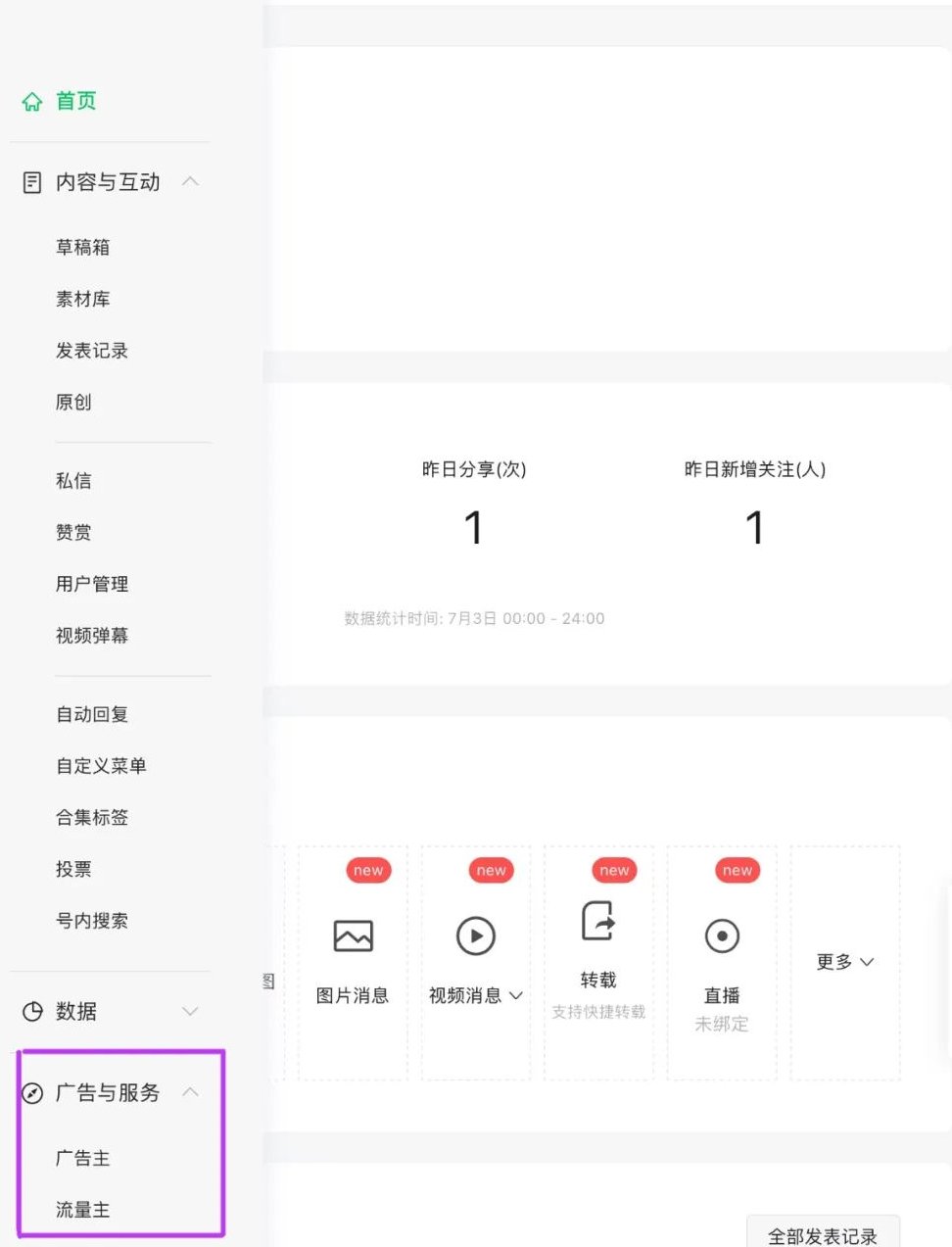

还有个潜规则:大平台有自己的检测体系。像微信公众号、知乎这些地方,不光用第三方工具,还有人工复审和用户举报机制。你能骗过机器,未必能骗过老编辑的眼睛。所以重点应该放在 "提升内容价值" 上,而不是单纯钻空子。

最后提醒一句:检测与反检测是场持久战。现在已经有工具开始加入 "语义理解" 模块,未来可能会更难对付。与其天天研究怎么绕,不如花时间练 "人机协作"—— 让 AI 搭框架,你填细节加灵魂,这才是长久之计。