🚨 数据污染正在毁掉你的 AI 模型 —— 这些坑 90% 的团队都踩过

做 AI 训练的都知道,数据就像模型的 “食材”。新鲜干净的食材才能做出好菜,发霉变质的只会让人拉肚子。但现在多少团队拿着满是 “烂菜叶” 的数据喂模型?

见过一个电商平台的案例,用爬来的用户评论训练推荐模型。结果数据里混了大量刷单刷的垃圾评论,模型学完直接疯了 —— 把 9.9 包邮的垃圾袋推荐给刚买完奢侈品的客户。老板气得当场把数据负责人叫到办公室,据说谈话声整层楼都听得见。

更要命的是数据污染会直接导致 AI 模型产生 “幻觉输出”。你让它分析市场趋势,它给你编出根本不存在的竞品数据;你用它做风控模型,它把优质客户标成高风险。这些问题追根溯源,都是源头数据里的重复值、错误标签、逻辑矛盾在作祟。

别觉得数据量够大就万事大吉。现在很多团队迷信 “大数据”,以为百万级、千万级数据堆上去总能出效果。实际上,100 万条脏数据的危害,比 1 万条干净数据的价值大得多。模型训练就像拼图,拼错一块可能整张图都废了。

🕵️ 揪出数据里的 “老鼠屎”—— 常见污染类型大盘点

先搞清楚敌人是谁。数据污染不是单一问题,是一堆乱七八糟的毛病凑在一起。

最常见的是重复数据。爬虫没做好去重,同一条用户信息在库里存了十几遍。模型训练时反复 “学习” 这部分内容,等于把个别案例当成了普遍规律。有个做舆情分析的团队,就因为某条重复了 200 多次的极端言论,让模型误以为某品牌的负面情绪占比超过 60%,差点误导客户撤掉 entire 营销 campaign。

然后是标签错乱。人工标注图省事,把 “好评” 标成 “差评”,把 “猫” 标成 “狗”。AI 学得一脸懵,后续预测能准才怪。见过更离谱的,医疗数据里把 “良性肿瘤” 标成 “恶性”,这种数据训练出的诊断模型,谁敢用在临床上?

缺失值也是个大麻烦。不是简单的空字段,是关键信息 “半遮半掩”。比如用户行为数据里,缺失了 “停留时长” 却保留了 “点击次数”,模型根本算不出真实的用户兴趣。有些团队图省事,直接用平均值填充,结果把特殊用户群体的特征全磨平了。

还有逻辑矛盾的数据。年龄填着 “12 岁”,职业却写 “退休教师”;收入标注 “月入 5000”,却频繁购买奢侈品。这种数据会让模型陷入认知混乱,就像教孩子数学时同时告诉他 “1+1=2” 和 “1+1=3”。

🔍 专业工具怎么挑?这 5 个硬指标缺一不可

别指望用 Excel 筛选能解决问题。面对百万级以上的数据量,手动处理效率低到感人,还容易出错。专业的数据质量审核工具,才是正经解法。

处理速度必须跟上。训练数据动不动就上 TB 级,工具跑半天出不来结果,团队只能干等着。见过某自动驾驶公司,用老旧工具审核路测数据,光是检查一遍就花了 3 天,错过整周的模型迭代窗口。现在主流工具像 Talend,处理百万级数据基本能做到分钟级响应。

支持多类型数据格式也很关键。AI 训练数据来源杂,文本、图片、音频、结构化表格都有。工具要是只能处理表格数据,那图片里的错误标注(比如把 “红灯” 标成 “绿灯”)根本查不出来。Informatica 这类工具就做得不错,能跨格式做一致性校验。

自动化程度决定了团队效率。好工具能自动识别重复值、异常值、逻辑矛盾,还能给出修复建议。上次跟一个 AI 实验室的负责人聊,他们用 Trillium 之后,数据审核的人力成本降了 60%。以前 5 个人盯一周的活,现在 1 个人加工具半天搞定。

可定制化规则不能少。不同行业的数据标准不一样,电商的用户数据和医疗的病例数据,审核重点天差地别。工具得支持团队自定义校验规则,比如金融领域可以加 “身份证号与年龄匹配度” 校验,教育领域可以加 “成绩与年级合理性” 校验。

最后看是否能联动标注平台。很多数据污染出在标注环节,工具如果能直接对接标注系统,在标注时就实时检查错误,能从源头减少问题。Labelbox 最近就加了这个功能,标注员标错的时候会自动弹窗提醒。

🛠️ 手把手教你用工具做数据 “体检”——3 步净化流程

光选对工具还不够,得有章法。分享一套经过验证的审核流程,照着做至少能过滤掉 80% 的脏数据。

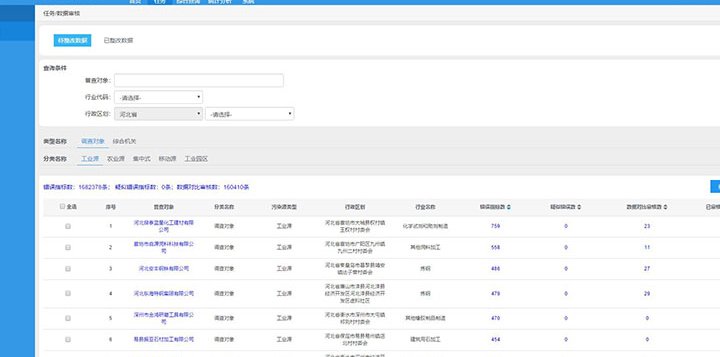

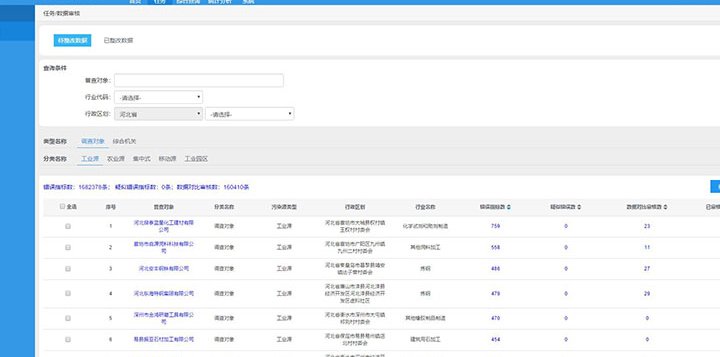

第一步是全量扫描建 “问题档案”。用工具对原始数据集做完整扫描,把重复数据、缺失值、格式错误这些基础问题先筛出来。记得让工具生成可视化报告,哪些类型的错误最多,集中在哪些字段,一目了然。有个做智能客服的团队,扫描后发现 30% 的对话数据里 “用户意图” 字段是空的,这才意识到之前爬数据时漏了关键参数。

第二步是深度校验逻辑一致性。基础问题解决后,重点查逻辑矛盾。比如用工具跑 “用户注册时间晚于下单时间” 这种时间悖论,或者 “收入 1000 却月消费 10 万” 的经济矛盾。某银行的信贷模型团队就靠这一步,揪出了大量伪造的贷款申请数据 —— 申请人填的 “工作年限” 和 “公司成立时间” 对不上。

第三步是抽样人工复核。工具再智能也有盲区,特别是文本、图片这类非结构化数据。建议按 5%-10% 的比例抽样,人工检查工具没识别出的问题。比如文本数据里的 “反讽” 内容(像 “这产品真棒,我这辈子不会再买了”),工具可能误判为正面情绪,这时候就得靠人来修正。

这里有个小技巧:把每次审核出的问题类型录进工具的 “知识库”,下次它就能自动识别同类错误。用得越久,工具越 “懂” 你的数据特点。

📈 长期主义者的做法 —— 建立数据质量监控体系

数据审核不是一锤子买卖。模型在迭代,数据源在变化,今天干净的数据,明天可能就被新加入的脏数据污染了。

得设定关键质量指标(KQI)。比如 “重复数据占比<1%”“标签错误率<0.5%”“逻辑矛盾数<500 条 / 百万条”。用工具把这些指标做成仪表盘,实时监控。一旦超标就自动报警,别等模型出问题了才后知后觉。

建立数据准入机制也很重要。新数据进库前必须过 “审核关”,不符合标准的直接打回。某自动驾驶公司就规定,新采集的路测数据必须通过 Trillium 的 3 项核心校验(标注准确率>99%、无重复帧、关键目标无遗漏)才能进训练库。

定期做 **“回头看” 复查 **。哪怕是已经用过的数据,隔 3 个月也要用工具再扫一遍。因为模型迭代后,对数据质量的要求可能变高。以前能容忍的小错误,现在可能会严重影响精度。有个做图像识别的团队,半年后复查发现早期数据里有大量 “模糊图片”,之前模型简单没暴露问题,换了更复杂的模型后,这些图片成了精度瓶颈。

🌟 案例:这家公司靠数据净化让模型准确率提升 40%

最后说个真实案例,看看做好数据审核能带来多大改变。

某智能家居公司的语音控制模型,之前用户总抱怨 “听不懂”。团队排查了半天,发现训练数据里混了大量带方言的普通话(比如把 “关灯” 说成 “闭灯”),但标注时都标成了 “无效指令”。

他们用 Talend 做了全量审核,先把这些被误标的方言数据找出来,重新标注;又发现 20% 的音频数据有严重杂音,直接剔除。同时加了自定义规则:审核 “指令与执行结果” 的匹配度,确保模型学的都是正确反馈。

三个月后,模型的指令识别准确率从 55% 涨到了 92%,用户投诉降了 70%。老板在庆功会上说,这比换个更复杂的模型架构管用多了。

数据干净了,模型才能真正发挥作用。别再迷信 “大力出奇迹”,与其花大价钱买更先进的算法,不如先把数据里的 “烂菜叶” 挑干净。现在就打开你的数据审核工具,给你的数据集做个全面体检吧 —— 早一天净化,模型早一天出成果。