说到 AI 内容识别,现在已经不是什么新鲜词了。刷短视频时系统自动过滤的违规画面,公众号文章发布前的原创检测,甚至你收到的垃圾邮件被自动拦截,背后都有它的影子。但你有没有想过,机器是怎么判断一段文字是不是 AI 写的?一张图片是不是 AI 生成的?更让人好奇的是,那些宣称准确率能达到 98% 的技术,到底靠不靠谱?

📝文本识别:从字符到语义的层层解码

文本识别的第一道关,是捕捉 AI 写作的 “语言指纹”。人类写东西,难免会有重复的口头禅,会在长句里突然插入短句,甚至偶尔出现语法错误。AI 不一样,它的语言模型是基于海量数据训练出来的,自带一种 “过度规范” 的特质。比如 GPT 系列生成的文本,句子结构往往更工整,词汇选择更偏向 “平均水平”,很少会用生僻词,也很少有真正的 “废话”。现在的识别系统,能通过分析这些特征,初步判断文本的 “人工度”。

但光看表面还不够。进阶的技术会深入到语义逻辑层面。人类写作时,思路可能会跳脱,前面说的观点后面可能补充新角度,甚至偶尔自相矛盾。AI 则不同,它的逻辑链条更 “线性”,像沿着预设轨道前进,很少出现 “意外转折”。比如写一篇影评,人类可能先夸画面,突然想到剧情漏洞又吐槽两句,AI 则更可能按 “画面 - 剧情 - 演员 - 总结” 的固定框架推进。识别系统会给文本的 “逻辑跳跃度” 打分,分数太低就可能被标记为 AI 产物。

还有一个关键指标是 **“信息熵”**。简单说,就是文本包含的 “意外信息” 的多少。人类聊天时,可能突然从天气说到早餐,信息熵波动大。AI 生成的内容,信息熵往往更平稳,因为它总是基于前文的语境做 “最可能的延续”。现在的识别工具能通过计算信息熵的变化曲线,揪出那些 “过于平稳” 的文本。

不过文本识别也有难点。要是有人故意模仿 AI 的风格写东西,或者把 AI 生成的内容改得七零八落,识别准确率就会下降。这也是为什么很多平台会结合 “写作行为分析”,比如记录用户的打字速度、修改频率,来辅助判断是不是真人操作。

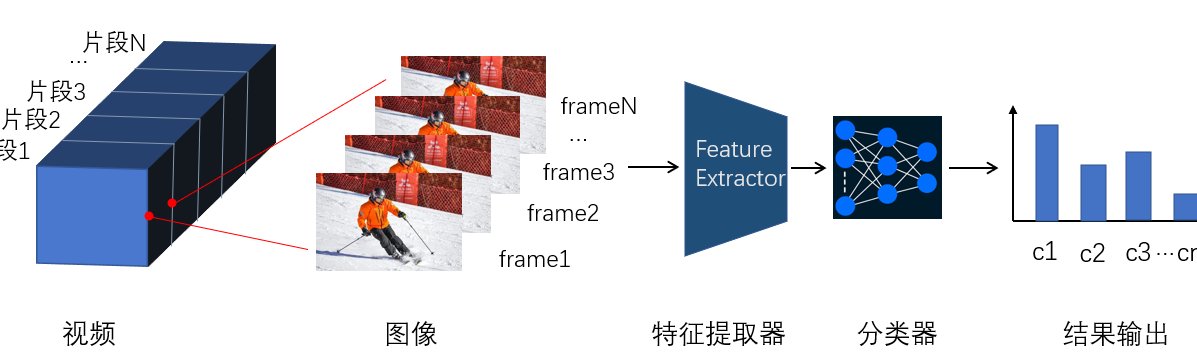

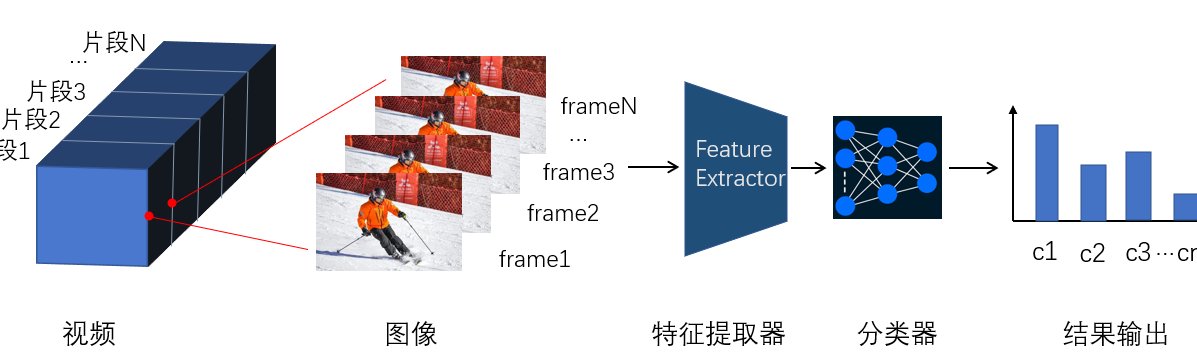

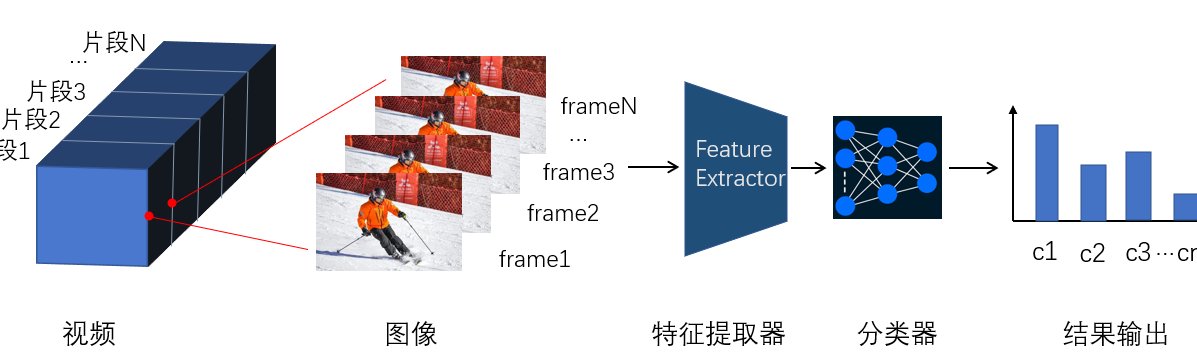

🖼️图片识别:像素背后的特征密码

图片识别的逻辑,和文本完全不同。像素级的 “不自然” 是首要线索。AI 生成图片时,虽然看起来很逼真,但放大到细节处总会露马脚。比如生成的头发,可能在某个角落突然变成模糊的色块;生成的文字,笔画可能扭曲或者多出来一截;甚至水面的倒影,光影逻辑和真实世界对不上。这些 “局部异常”,人类肉眼可能忽略,机器却能通过像素对比一一捕捉。

更高级的技术会分析 **“物理规律一致性”**。真实世界的物体,都要遵守重力、光影、透视这些基本规律。AI 生成图片时,偶尔会出现 “违反物理” 的情况。比如一只手有 6 根手指,或者人物的影子方向和光源矛盾,甚至远处的山比近处的树还清晰。识别系统里预装了这些物理规则模型,能像 “找茬游戏” 一样找出这些破绽。

还有个独门武器是 **“训练数据残留检测”**。AI 画图的模型,是用海量图片训练出来的,难免会在生成内容里留下 “记忆碎片”。比如某个画家的风格,某个摄影作品的构图,甚至特定的水印图案。现在的识别技术能比对生成图片和训练数据集的特征,一旦发现高度相似的 “残留痕迹”,就会发出警报。

但图片识别也有 “软肋”。如果生成的图片分辨率很低,或者经过多次压缩、裁剪,很多细节特征会丢失,识别准确率就会打折扣。这也是为什么现在的 AI 绘画工具,会主动加入一些 “反识别” 设计,比如故意在不起眼的地方加一些随机噪点。

🎯98% 准确率的底气:技术组合拳如何炼成

宣称 98% 的准确率,不是单靠一种技术撑起来的。多模型融合是核心策略。就像医生诊断病情会结合 CT、验血、心电图,AI 识别也会同时调用好几个模型。文本识别会同时跑 “语法分析模型”“语义逻辑模型”“信息熵模型”,图片识别会联动 “像素检测模型”“物理规律模型”“数据残留模型”,最后通过算法综合打分。只要有两个以上的模型给出 “AI 生成” 的判断,系统就会判定结果,这样能大大减少误判。

动态更新的 “特征库” 是关键。AI 生成技术一直在进化,上个月能识别的特征,这个月可能就失效了。好的识别系统,背后都有一个庞大的团队,每天收集最新的 AI 生成内容,提取新特征,更新到识别模型里。比如 ChatGPT 每次大更新后,识别系统会在一周内完成针对性调整,确保不会被 “新套路” 蒙骗。

“人机协同” 弥补技术盲区。机器识别完之后,会把 “疑似 AI 生成” 的内容推给人工审核。人类审核员会重点看那些机器拿不准的案例,比如风格特别像人类的 AI 文本,或者经过精心修改的 AI 图片。这些人工判断的数据,又会反过来训练机器,形成一个正向循环。很多宣称 98% 准确率的系统,其实是 “机器初筛 + 人工复核” 的综合结果。

不过这个 98% 也有前提。通常是在 “标准测试集” 里的表现,也就是用已知的 AI 生成内容和人类原创内容做对比。到了真实场景,因为干扰因素太多,实际准确率可能会降到 90% 左右。但即便如此,也比纯人工审核效率高太多了。

🌐真实世界的试炼:AI 识别的应用与边界

现在 AI 识别技术用得最广的,是内容平台的风控系统。抖音、快手这类短视频平台,每天要处理上亿条内容,单靠人工根本审不过来。AI 识别能在几秒内判断一段视频有没有违规画面,一句台词有没有敏感信息,大大降低了人工成本。据业内人士透露,有了 AI 识别后,大型平台的内容审核效率提升了至少 10 倍。

版权保护领域也离不开它。很多设计师、摄影师最怕自己的作品被 AI “学习” 后生成相似内容。现在有工具能比对 AI 生成图片和原创作品的特征,一旦发现抄袭痕迹,就能出具检测报告,作为维权证据。前段时间就有摄影师靠这个工具,成功起诉了用 AI 生成其作品风格图片的公司。

但它的边界也很明显。过度依赖可能会 “误杀” 原创。有些人类作者的风格本来就很规整,写出来的东西被 AI 识别误判为机器生成,导致内容被下架。还有些小众艺术创作,故意打破常规物理规律,比如超现实主义绘画,很容易被图片识别当成 AI 生成的。

另外,对抗性攻击让识别技术很头疼。有人专门研究怎么修改 AI 生成的内容,让它刚好能逃过识别系统的检测。比如在 AI 文本里故意加几个错别字,在 AI 图片的像素里藏一些微小的干扰信号。这些 “小动作” 人类很难察觉,却能让识别系统的准确率暴跌。

🚀下一代技术:突破现有瓶颈的可能路径

未来的 AI 识别,会朝着 **“多模态融合”** 的方向走。现在文本和图片识别是分开的,下一步会把两者结合起来。比如分析一篇带图片的文章,不仅看文字是不是 AI 写的,还要看图片和文字的匹配度 ——AI 生成的图文,往往在逻辑关联上不如人类原创紧密。这种 “交叉验证” 能进一步提高准确率。

因果推理能力也会成为新的突破口。现在的识别技术主要靠 “找特征”,未来可能会升级成 “讲道理”。比如看到一张图片,机器不仅能发现 “影子不对”,还能推理出 “因为光源在左边,所以影子应该朝右,而不是朝上”。这种基于因果关系的判断,对抗性攻击就很难奏效了。

还有个有趣的方向是 **“反向模拟”**。就是让识别系统自己学 AI 生成技术,知道对方的 “套路” 后,再去识别就更容易了。有点像警察学小偷的作案手法,知己知彼才能百发百中。现在已经有团队在尝试让识别模型和生成模型 “互相学习”,效果据说还不错。

不过技术再先进,也离不开伦理规范。怎么避免 AI 识别被用来监控个人创作?如何保护那些被误判的原创者?这些问题比技术突破更重要。毕竟技术是工具,用得好能净化网络环境,用不好可能会扼杀创造力。

AI 内容识别技术的发展,就像一场猫鼠游戏。一边是不断进化的生成技术,一边是紧追不舍的识别技术。98% 的准确率不是终点,而是这场较量中的一个里程碑。对我们普通人来说,了解这些技术原理,不仅能帮我们辨别信息的真伪,也能让我们更理性地看待 AI 带来的变化。毕竟,在这个 AI 越来越懂人类的时代,人类也该多懂一点 AI 才行。

【该文章由diwuai.com第五 ai 创作,第五 AI - 高质量公众号、头条号等自媒体文章创作平台 | 降 AI 味 + AI 检测 + 全网热搜爆文库🔗立即免费注册 开始体验工具箱 - 朱雀 AI 味降低到 0%- 降 AI 去 AI 味】