🔍 数据污染:模型训练路上的 “隐形炸弹”

在 AI 模型训练的世界里,数据就像给模型投喂的 “粮食”。要是这 “粮食” 被污染了,模型不仅长不壮,还可能 “生病”。好多团队辛辛苦苦练模型,最后效果却拉胯,很大一部分原因就是没躲过数据污染的坑。你想啊,数据里藏着各种奇奇怪怪的问题,错误标注、重复内容、偏见信息,这些就跟混入粮食里的杂质一样,模型吃多了,自然没法好好干活。

就说错误标注吧,比如训练图像识别模型,本来是辆卡车,标注成了轿车,模型看多了这种错误数据,以后再遇到真的卡车,说不定就认不出来了。还有重复数据,一大堆一模一样的内容塞给模型,模型就会觉得这东西特别重要,结果导致训练出来的模型对真实场景的判断出现偏差。更麻烦的是偏见数据,要是数据里对某类人群有不合理的描述,模型学了这些,就可能在应用时产生歧视性的输出,这可不是小事儿。

🚫 数据污染对模型训练的三大 “致命伤”

数据污染对模型训练的影响可不小,首当其冲的就是训练效率大打折扣。你想,模型在一堆垃圾数据里打转,就像在迷雾里走路,每一步都得小心翼翼,本来可以快速掌握的规律,现在得花更多时间去分辨。而且,模型的预测准确率也会跟着遭殃。就拿自然语言处理模型来说,如果训练数据里有很多语法错误或者语义模糊的句子,模型生成的内容就会经常让人摸不着头脑,要么逻辑混乱,要么答非所问。

还有更严重的伦理风险。前面提到的偏见数据,如果模型学进去了,在实际应用中,比如招聘筛选、信用评估这些场景,就可能不公平地对待某些群体。之前就有案例,有的 AI 招聘系统对女性求职者存在偏见,这就是数据污染带来的可怕后果。所以啊,别小看数据污染,它影响的可不只是模型的性能,还可能涉及到社会公平正义的问题。

⚙️ 专业工具:数据质量审核的 “得力帮手”

好在现在有不少专业工具能帮我们进行数据质量审核,把这些污染数据揪出来。咱们可以把这些工具分成几类来看。首先是自动检测工具,这类工具擅长处理大规模数据,能快速找出重复数据、缺失值、异常值等问题。比如 OpenRefine,它操作简单,功能却很强大,能对数据进行清洗和转换,还支持多种数据格式,不管是 CSV、Excel 还是 JSON,都能轻松处理。还有 Great Expectations,它可以自定义数据验证规则,比如数据类型是否正确、数值是否在合理范围内等,一旦数据不符合规则,就会发出警报。

然后是人工审核工具,虽然自动检测工具很高效,但有些细节问题还得靠人工来把关。比如数据标注的准确性,机器可能很难分辨一些模糊的标注,这时候就需要人工来仔细检查。像 Label Studio,它支持多种标注任务,图像、文本、音频都能标,而且还能方便地进行团队协作,多个标注人员可以同时工作,互相审核标注结果,提高标注质量。还有 Hive AI,它不仅能进行数据标注,还能对标注过程进行监控,确保标注人员按照规定的标准来工作。

最后是综合平台工具,这些工具集合了自动检测和人工审核的功能,还能提供数据分析和报告生成等服务。比如 AWS Glue Data Quality,它可以和 AWS 的其他服务集成,对数据进行全方位的质量检查,从数据采集到数据存储,每个环节都能监控。还有 Dataiku,它是一个一站式的数据科学平台,里面的数据质量模块能帮助用户快速识别数据中的问题,并提供解决方案,适合那些需要进行复杂数据处理的团队。

🔧 建立数据质量审核流程:从源头堵住污染漏洞

要想彻底避免数据污染,光靠工具还不够,还得建立一套完整的数据质量审核流程,从数据采集开始,每个环节都严格把关。首先是数据采集阶段,要尽可能从多个可靠的数据源获取数据,避免单一数据源带来的偏差。比如做用户行为分析,不能只盯着一个平台的数据,多个平台的数据结合起来,才能更全面地了解用户。而且在采集数据的时候,要做好数据记录,比如数据的来源、采集时间、采集方式等,这样方便后续的追溯和审核。

接下来是数据清洗环节,这一步就是把采集到的数据里的 “杂质” 去掉。先用自动检测工具找出重复数据、缺失值、异常值,然后根据具体情况进行处理。重复数据直接删除,缺失值可以用平均值、中位数或者其他合理的方法填充,异常值要分析原因,是数据录入错误还是真实存在的特殊情况,如果是错误就修正,要是特殊情况就单独处理。比如在销售数据里,出现一个异常高的订单金额,可能是输入错误,也可能是大客户的订单,这时候就得仔细核查。

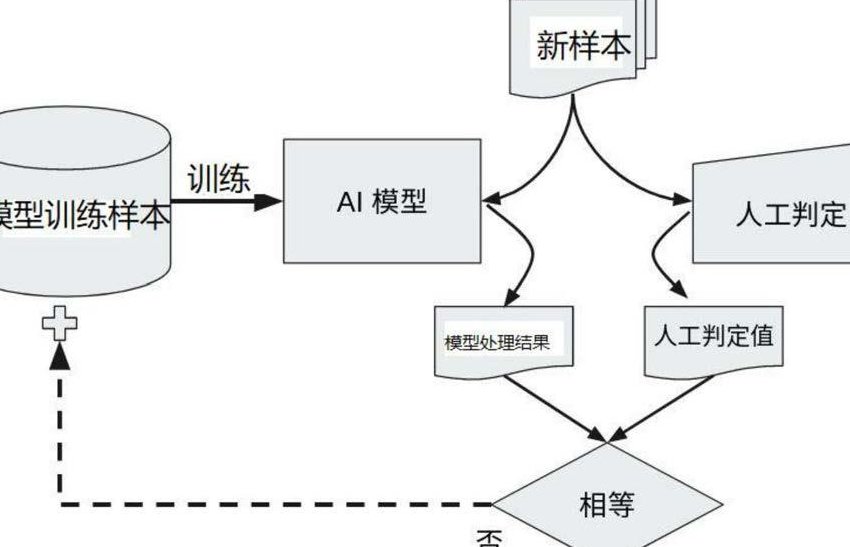

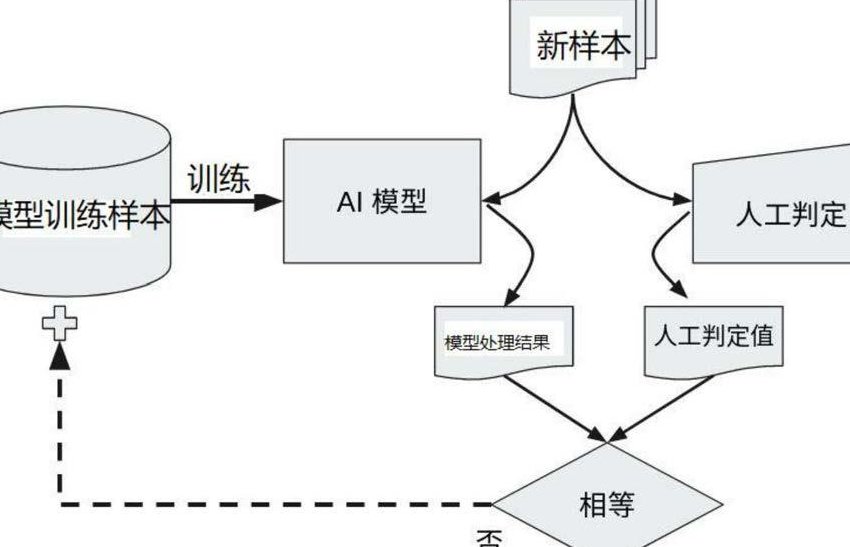

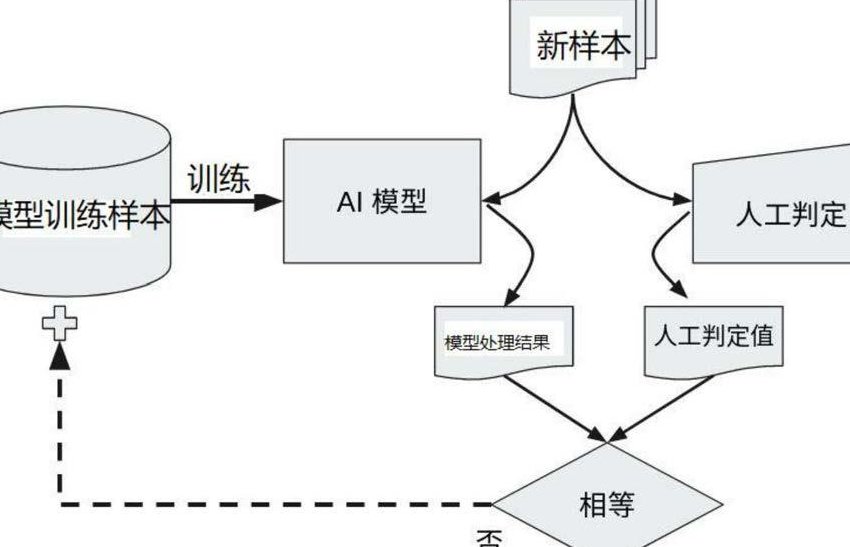

然后是数据标注环节,标注质量直接影响模型训练的效果。首先要制定明确的标注规则,让标注人员清楚每个标签的定义和标注标准。然后安排专业的标注人员进行工作,并且进行标注培训,确保大家对规则的理解一致。在标注过程中,要进行交叉验证,比如让两个标注人员对同一批数据进行标注,然后对比他们的结果,不一致的地方再由资深标注人员进行裁定。这样可以有效提高标注的准确性,减少错误标注的数据进入训练集。

最后是数据验证环节,在数据进入模型训练之前,要进行最后的检查。可以通过统计分析,看看数据的分布是否合理,比如数值型数据的均值、方差是否在正常范围内,分类数据的各个类别的比例是否符合实际情况。还可以进行小样本的模型训练,看看模型在这些数据上的表现,如果出现异常,就说明数据可能存在问题,需要重新审核。另外,人工抽查也很重要,随机抽取一部分数据,亲自检查数据的质量,确保没有遗漏的问题。

做好数据质量审核,是模型训练成功的关键一步。别觉得这事儿麻烦,前期多花点时间和精力把数据处理好,后面训练模型的时候就能省心很多,模型的效果也会让你惊喜。记住,数据是 AI 的基础,只有干净、高质量的数据,才能训练出强大、可靠的模型。