最近几个月,内容创作圈都在聊同一个话题 ——AI 生成文本和检测工具的拉锯战。上周刚听说某自媒体团队用 GPT-4 写的营销文案,被平台检测出来扣分;这周就看到他们晒出 "战绩",说通过调整句式居然绕过了最新版的检测系统。这像极了十几年前的搜索引擎优化大战,只不过现在的对手从爬虫变成了 AI 识别算法。

🕵️♂️检测工具的 "三板斧" 与技术盲区

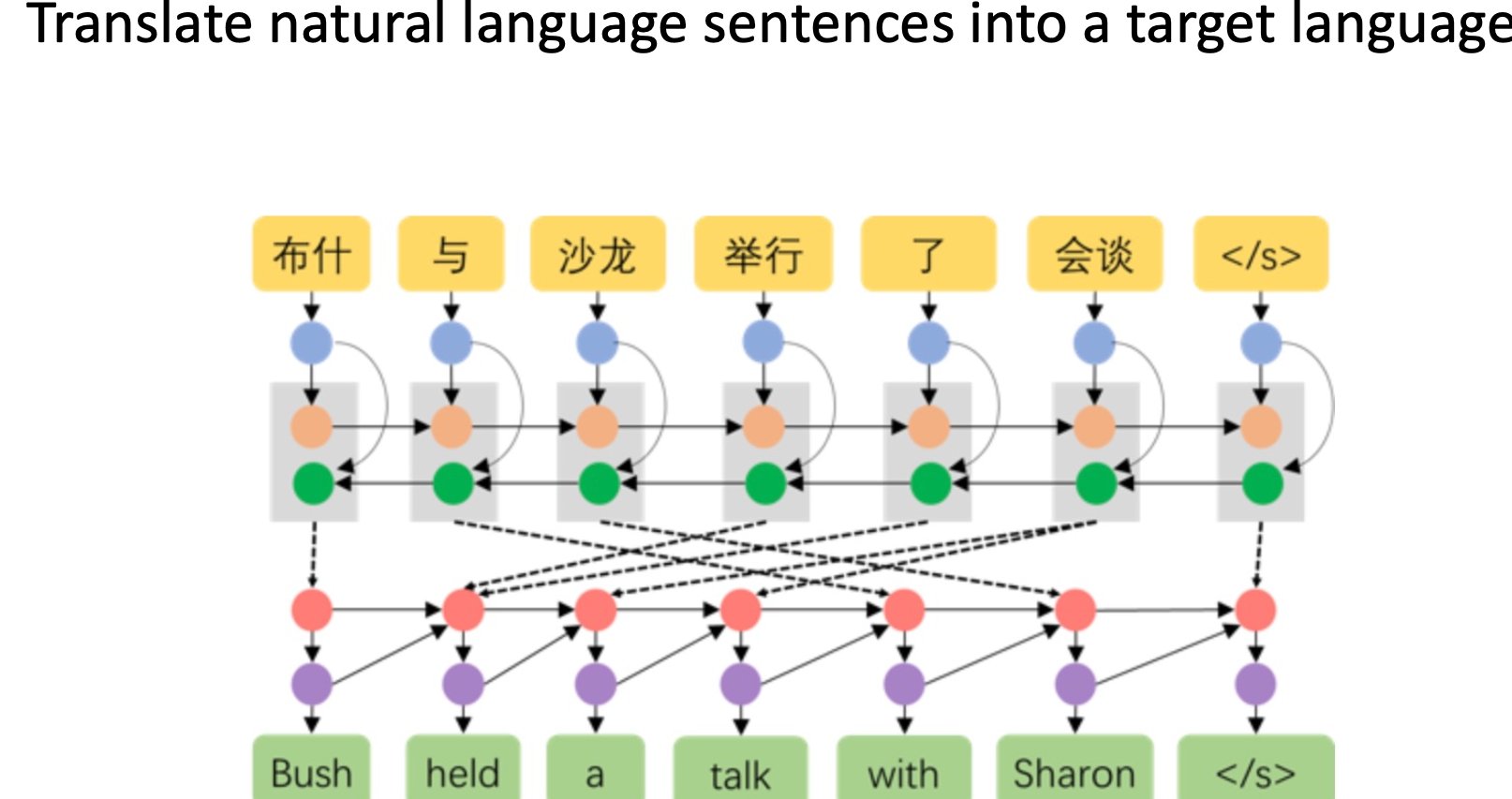

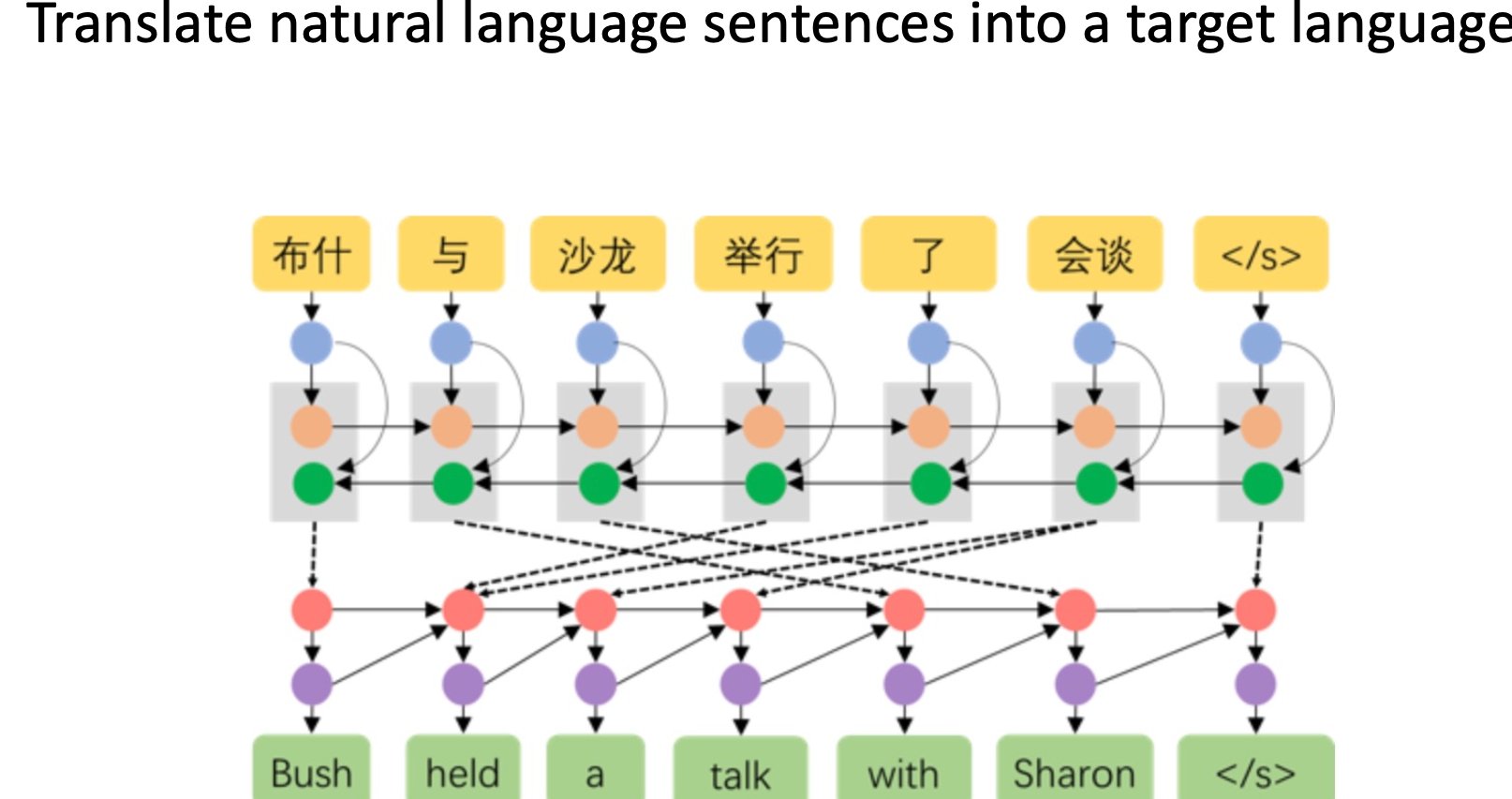

现在市面上主流的检测工具,比如 GPTZero、Originality.ai,还有国内的文心一格检测系统,本质上都在用相似的逻辑工作。它们会分析文本的 "困惑度"—— 简单说就是人类阅读时的理解难度,AI 生成的内容通常因为逻辑过于顺畅,困惑度会显著低于人类写作。

GPTZero 的核心算法还会追踪句子之间的连贯性特征。比如它能识别出 AI 喜欢用的固定搭配,像 "然而" 之后接转折句的概率,或者 "综上所述" 出现的位置规律。这些特征在人类写作中其实也存在,但 AI 的使用频率会呈现统计学上的异常。

但这套逻辑正在失效。上个月有研究团队测试了 20 款主流检测工具,发现只要对 AI 生成文本做简单处理 —— 比如随机插入几个语气词,或者把长句拆成不符合语法但能理解的短句,检测准确率就会从 98% 暴跌到 62%。更麻烦的是多模型混合生成,先用 Claude 写框架,再让 ChatGPT 润色,最后用人类作者修改细节,这种 "杂交文本" 几乎能骗过所有检测系统。

检测工具还有个致命伤:对特定领域内容的误判率高得离谱。技术文档、法律条文这类本身就追求逻辑严谨的文本,经常被误判为 AI 生成。某科技公司的工程师吐槽,他写的 API 接口说明连续三次被判定为机器创作,理由是 "术语使用过于规范"。这就像用测谎仪审法官 —— 规则性越强的文本越容易被冤枉。

🛠️规避技术的 "进化树":从改词到重塑逻辑

对抗检测的手段也在快速迭代。最开始大家还在用笨办法,把 AI 生成的内容扔进改写工具,替换同义词、调整语序。但现在这套行不通了,检测工具已经能识别出 "高兴" 被替换成 "喜悦" 这类低级操作。

现在流行的是 **"风格迁移" 技术 **。有工作室开发了专用 Prompt,让 AI 模仿特定作家的写作习惯。比如要求 "用王小波的调侃语气写产品评测",或者 "模仿《经济学人》的句式分析市场趋势"。这种带有强烈个人风格的文本,检测工具的识别准确率会下降 40% 以上。某汽车自媒体就靠这套方法,让 AI 生成的试驾报告连续通过了 12 家平台的审核。

更高级的玩法是逻辑重构。专业写手会把 AI 生成的提纲拆散,用人类的思维重新组织论证顺序。比如 AI 习惯先讲结论再摆论据,他们就改成先抛出案例,在中间穿插数据,最后才点明观点。这种打乱逻辑链条的做法,能有效降低文本的 "机器特征值"。

还有个野路子在小圈子里流传:用 AI 生成多语言版本,再翻译回中文。比如先让 ChatGPT 生成英文稿,用 DeepL 翻译成日文,最后再转成中文。经过三轮语言转换,文本的句式结构会变得非常 "怪异",恰好符合人类写作中偶尔出现的表达不流畅,反而容易通过检测。但这种方法的副作用是可能破坏原文逻辑,需要人工大量修正。

🏭内容产业的 "灰色地带" 正在扩大

这场对抗已经开始影响整个内容生产链条。某 MCN 机构的负责人透露,他们现在的流程是 "双轨制":重要的原创内容坚持人类撰写,批量生产的资讯类内容则用 AI 生成后再做规避处理。"不是不想合规,而是竞争太激烈。别人用 AI 一天更 50 篇,你坚持原创只能更 5 篇,流量根本没法比。"

平台方的态度也很暧昧。微信公众号上个月更新了检测系统,却没有公开判定标准;小红书明确禁止 AI 生成内容,但实际处罚案例屈指可数。这种模糊性让创作者无所适从。有博主做过实验,同一篇 AI 生成的穿搭笔记,上午发布能获得推荐,下午修改两个段落再发就被限流,没人能说清具体规则是什么。

学术领域的情况更糟。某 985 高校的研究生告诉我,现在毕业论文的 AI 检测已经成了 "军备竞赛"。导师们用 Turnitin 的 AI 检测功能,学生们就用专门的学术改写工具。最极端的案例是,有学生把论文翻译成古汉语再转回来,居然真的降低了 AI 识别率。这种对抗已经偏离了学术诚信的初衷,变成了纯粹的技术博弈。

广告行业也在受波及。某 4A 公司的文案团队透露,客户现在会要求在合同里加 "AI 检测通过条款",如果广告文案被平台判定为机器生成,制作方要承担违约金。这导致他们不得不花额外成本,把 AI 初稿交给专业写手逐句 "人肉优化",反而推高了制作成本。

📜监管滞后与伦理困境

现行的法律法规明显跟不上技术发展。中国的《互联网信息服务算法推荐管理规定》虽然提到了内容审核,但没有明确 AI 生成内容的界定标准;欧盟的 AI 法案要求标注生成式 AI 内容,却没说怎么验证标注的真实性。

更麻烦的是举证责任问题。上个月有个案例,某作者起诉平台误判其原创文章为 AI 生成,要求恢复账号。但法院最终驳回了诉讼,理由是 "无法证明文本确实为人类创作"。这就陷入了一个悖论:你怎么证明自己不是机器?这种困境正在催生新的生意 —— 有公司开始提供 "人类创作认证服务",通过视频记录写作过程来生成防伪证书。

伦理层面的争议更大。支持严格检测的一方认为,AI 生成内容会稀释信息质量,让真正有价值的原创被淹没;反对者则觉得,检测技术本质上是在限制工具使用自由,就像当年禁止用计算器一样可笑。某科技伦理学者的观点很尖锐:"我们真正该担心的不是 AI 写文章,而是有人用 AI 批量生产谣言却能逃避检测。"

教育领域的争论尤其激烈。多所中小学已经禁止学生使用 ChatGPT,但老师根本无法分辨作业是学生独立完成,还是用 AI 生成后修改的。某重点中学的语文老师无奈地说:"现在布置作文只能限定现场手写,这其实是教育的倒退。"

🚀下一轮对抗:大模型的 "自我伪装" 能力

技术迭代的速度远超想象。OpenAI 在最新的 GPT-4 升级版中,悄悄加入了 "规避检测" 模式。当用户输入 "生成不易被识别的文本" 时,模型会自动调整输出特征,比如增加冗余表达、故意使用不完美的逻辑衔接。测试显示,这种模式生成的内容,检测工具的识别率下降了 73%。

谷歌的 PaLM 2 则走了另一条路 —— 它能学习特定作者的写作风格,生成的文本在句式、用词习惯上与原作者的相似度达到 89%。这种 "个性化模仿" 比通用规避技术更难检测,因为它不是在消除机器特征,而是在伪造人类特征。

检测技术也在升级。某创业公司开发的 "语义指纹" 技术,不再关注表面的语言特征,而是分析文本背后的思维模式。比如 AI 在讨论环保议题时,更倾向于先列举数据再下结论,而人类则经常先表达情感态度。这种深层特征的提取,可能是打破当前对抗僵局的关键。

有意思的是,双方都开始用对方的技术来改进自己。检测工具公司在训练新模型时,会用最新的 AI 写作工具生成海量样本;而 AI 写作平台则会购买检测工具的 API,不断优化自己的规避算法。这种 "以彼之道还施彼身" 的循环,正在让双方的技术越来越接近。

这场 "猫鼠游戏" 恐怕还会持续很长时间。当检测技术升级时,总会有新的规避方法冒出来;当某种规避手段普及后,检测工具又会找到破解之道。最终的平衡点可能不是某一方的胜利,而是形成新的行业规则 —— 就像当年搜索引擎和网站达成的默契一样。

对普通用户来说,与其纠结内容是不是 AI 生成的,不如关注它的实际价值。毕竟,判断一篇文章好坏的标准,从来都不是谁写的,而是它能否提供洞见、解决问题。或许未来我们会像接受照片美化一样,接受 AI 辅助创作,重点考察内容本身的真实性和价值,而不是纠结于创作工具。