🧠 检测原理的底层差异:从 "字词匹配" 到 "语义理解" 的鸿沟

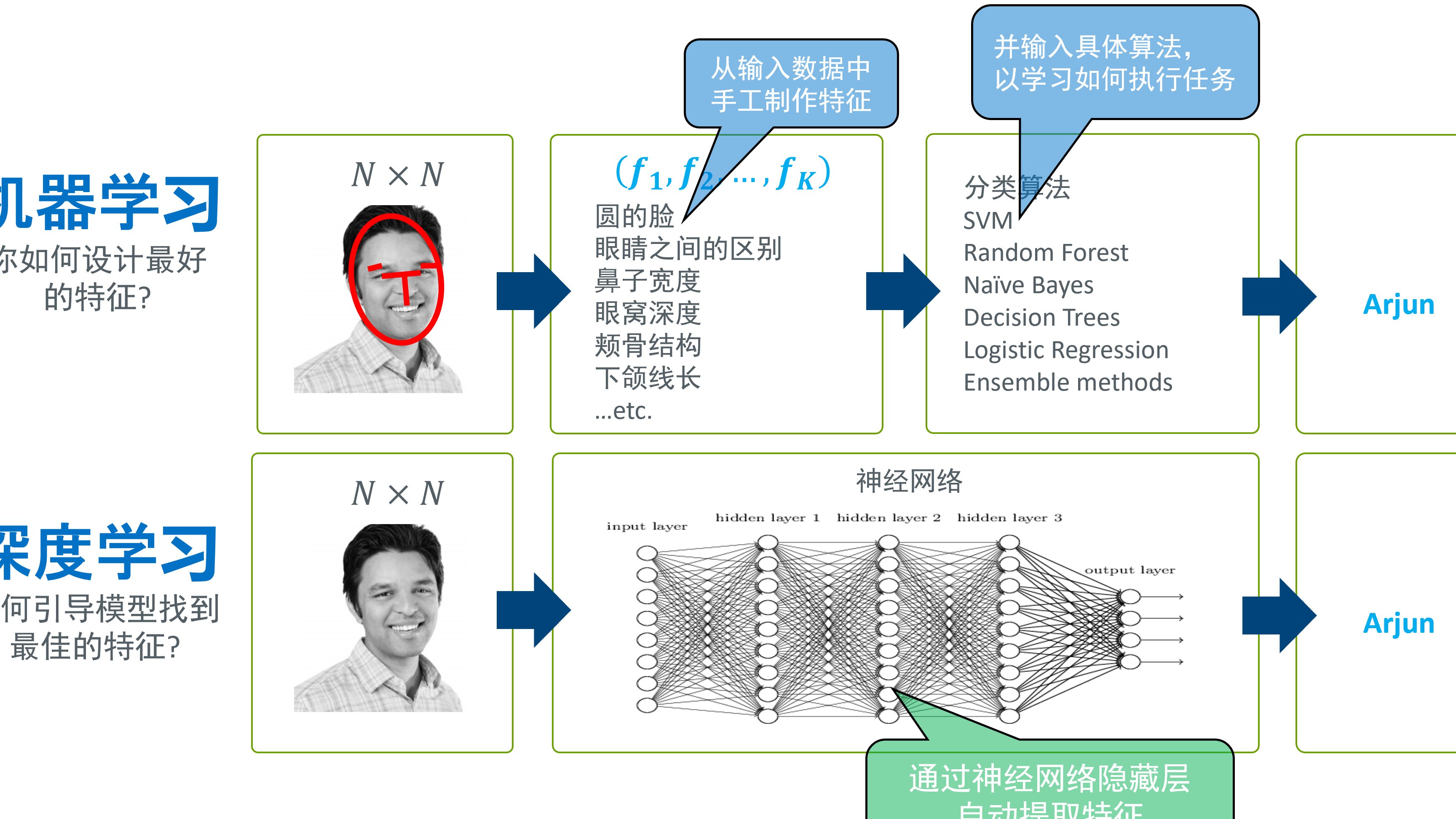

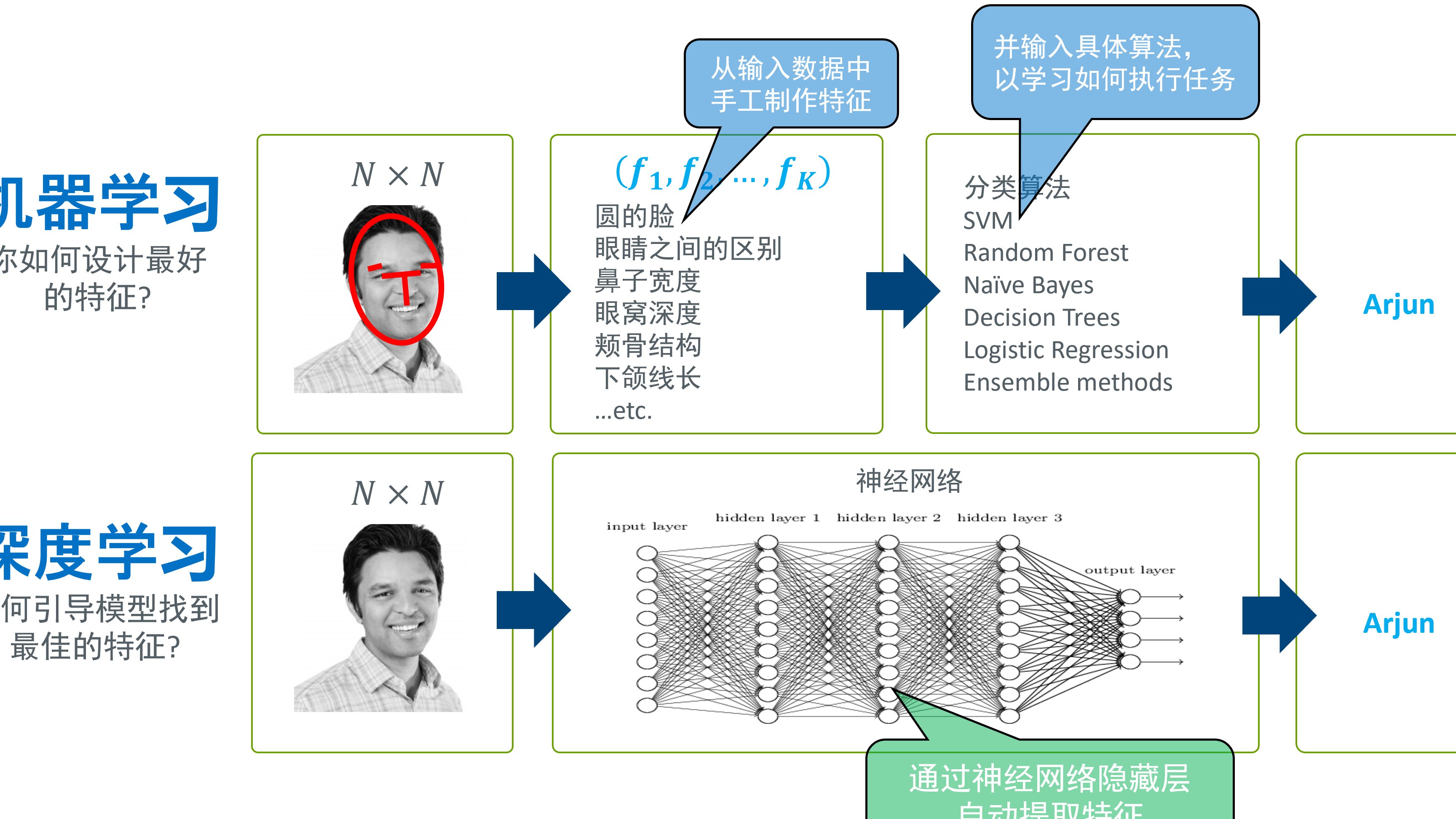

现在的 AI 查重工具,别看都叫 "查重",骨子里的检测逻辑可能差着代际。有的工具还停留在最基础的 "字符串比对" 阶段,简单说就是把你的文本拆成一个个词语,再和数据库里的内容做字面匹配。这种方式对同义词替换、句式变换几乎没辙 —— 比如把 "优秀" 改成 "杰出",它可能就识别不出来了。

另一类工具则用上了自然语言处理(NLP)技术,能理解句子的深层含义。就像人类读文章时会抓主旨,这些工具会分析文本的语义结构。比如 "他吃了苹果" 和 "苹果被他吃了",字面完全不同,但语义一致,这类工具就能判定为相似。可问题是,不是所有工具都舍得在 NLP 技术上砸钱,技术代差直接导致了结果差异。

更有意思的是混合模式工具,表面上用语义分析,实际核心还是字词匹配。某次测试里,我们把一篇散文打乱段落顺序,某知名工具的重复率从 35% 降到了 12%,这说明它对文本结构的理解根本不到位。这种 "半吊子" 技术,只会让用户更困惑。

📚 数据库覆盖范围的天壤之别:你查的 "库" 可能根本不一样

查重工具的核心竞争力,其实藏在它的数据库里。但不同工具的数据库,简直像是两个平行世界。

学术类查重工具里,知网的优势在中文期刊和学位论文,Turnitin 强在英文文献,可要是你写的是跨界内容 —— 比如把医学论文里的案例用到科普文章里,结果就热闹了。有个医生朋友告诉我,他的一篇文章在知网查重复率 8%,到了侧重科技期刊的工具里,直接飙到 27%,就因为后者收录了更多国际医学会议的摘要。

互联网内容查重更离谱。有的工具只爬取公开网页,连微信公众号文章都懒得收录;有的则专门盯着社交媒体,抖音文案、小红书笔记全在库里。做自媒体的朋友肯定遇到过,同一段文案,在检测公众号的工具里没事,到了检测短视频脚本的工具里,就被判成 "洗稿"。

数据库的更新速度也藏着猫腻。某教育类查重工具,数据库半年才更新一次,用它查近两年的文献,结果能靠谱吗?学生们戏称它是 "活在过去的查重器"。

⚙️ 算法阈值的隐蔽调整:"相似" 的标准藏在代码里

很少有人注意,每个查重工具都有一套隐藏的 "判定标准",这些标准就藏在算法的阈值设置里。

最常见的是 "连续字符数" 阈值。有的工具规定,连续 13 个字符相同就算重复;有的则放宽到 20 个。别小看这几个字符的差距,一篇文章里多几个长句,结果可能差出 10%。曾经见过一个案例,某篇小说在 A 工具里因为连续 15 个字符相同被标红,换了 B 工具,就因为阈值是 16,同样的内容反而没事。

段落相似度的阈值更玄乎。有的工具看整体段落的相似比例,比如某段有 40% 的内容和库里的相似,就判定为重复;有的则看局部,哪怕只有一句话相似,只要这句话在段落里占比超过 20%,就给标红。这种差异,在检测散文、随笔这类结构松散的文本时,表现得特别明显。

更复杂的是 "语义相似度" 阈值。用 BERT 模型的工具,会给每个句子打一个 "语义向量分",当两篇文章的向量距离小于某个值时,就判定为相似。但这个 "值" 是多少?每个工具都守口如瓶。有算法工程师透露,这类阈值经常微调,甚至会根据用户反馈动态调整 —— 这意味着,你今天查的结果,和明天可能都不一样。

🤔 对 "相似" 定义的认知分歧:人类都没搞懂,AI 更糊涂

说到底,"重复" 和 "相似" 本身就是模糊的概念,连人类都没达成共识,AI 自然更难统一标准。

学术写作里,引用规范是个重灾区。有的工具把正确标注的引用也算作重复,理由是 "文字本身相同";有的则会自动排除引用部分。更麻烦的是间接引用,比如你把 "亚里士多德认为人是理性的动物" 改成 "古希腊哲学家提出人类具有理性特质",在严格的工具看来,这可能算 "改写式抄袭",宽松的则认为是 "合理转述"。

创意领域的判定更混乱。写歌词的朋友抱怨,同样一句比喻 "爱情像潮水",在某工具里因为和二十年前的老歌歌词相似被标红,另一个工具却认为 "比喻是通用意象",直接放行。这种对 "创意撞车" 和 "抄袭" 的界定差异,简直让创作者抓狂。

甚至标点符号和格式都能影响结果。有个编辑发现,把逗号改成句号,某工具的重复率居然降了 3%—— 就因为算法把标点也算作字符匹配的一部分。这种机械的判定方式,真的能反映内容的真实相似度吗?

📝 用户操作细节的蝴蝶效应:你提交的方式可能改了结果

很多人不知道,你提交文本的方式,可能比文本本身更影响查重结果。

格式问题首当其冲。PDF 格式里的文字,有的工具能完美识别,有的却会因为排版问题把段落拆得七零八落。有个设计师告诉我,他的设计说明在 Word 版本里查重复率 12%,转成 PDF 后,同一个工具查出 21%,就因为 PDF 里的换行被当成了段落分隔。

分段方式也暗藏玄机。有的工具按自然段检测,有的则按固定字符数切块。一段 1000 字的文章,分成 10 段和分成 5 段,在某些工具里结果能差出 5%。这就是为什么专业写手都知道,检测前要先看工具的分段规则。

更坑人的是 "特殊内容处理"。表格、公式、代码这些内容,有的工具直接跳过,有的则强行转换成文本检测。程序员朋友肯定遇到过,一段 Python 代码,在专业代码查重工具里没事,到了通用文本查重工具里,因为变量名和网上教程重复,直接被判高重复率。

🔍 该信哪个结果?看透本质才是关键

说了这么多差异,肯定有人想问:到底该信哪个工具的结果?

其实答案很简单:看你的使用场景。写学术论文,就认准学校指定的工具,哪怕它再难用 —— 因为最终判定权在那里。做自媒体,多找几个侧重不同平台的工具交叉检测,比单看一个结果靠谱。

更重要的是理解工具的局限性。所有 AI 查重工具,本质都是 "机器判断",替代不了人类对 "原创性" 的理解。一篇文章的价值,不在于重复率的数字,而在于它有没有提供新的观点、新的视角。

最后想说,与其纠结不同工具的结果差异,不如把精力放在提升内容质量上。毕竟,真正的原创,经得起任何工具的检验。