📊 AI 写作查重率真的和模型有关吗?这两年用 AI 写东西的人越来越多,不管是学生写论文,还是自媒体人搞创作,都绕不开一个问题 —— 生成的内容会不会被查重系统标红?我前阵子特意拿市面上主流的几个 AI 模型做了测试,发现不同模型生成的内容,查重率差异居然能差出 30% 以上。这事儿挺有意思的,今天就来好好扒一扒不同 AI 核心的原创度到底有啥区别。

🧠 不同 AI 模型的 “原创基因” 不一样

现在大家常用的 AI 写作工具,背后的核心模型其实大不相同。别看都叫 AI,它们生成内容的 “思路” 差得远呢。就拿 GPT 系列来说,它用的是 Transformer 架构,训练数据铺得特别广,从书籍论文到网页内容,几乎涵盖了互联网上能爬取到的大部分文本。这种模型生成内容时,更擅长把不同来源的信息打碎了重新组合,有点像人写东西时 “博采众长” 的感觉。

反观一些垂直领域的 AI 模型,比如专门用来写法律文书或者医学报告的,它们的训练数据范围窄得多,主要集中在特定行业的文献和案例上。这种模型写出来的内容,专业术语用得很准,但架不住素材库有限,有时候翻来覆去就那些表达,查重率自然容易偏高。我见过一个做法律科普的博主,用某款垂直 AI 写的文章,在知网查重时重复率直接飙到了 45%,后来换了通用型模型,同样的主题重复率降到了 12%。

还有些模型的 “性格” 也不一样。比如 Claude,它生成内容时会更注重逻辑连贯性,有时候为了把一个观点说清楚,会不自觉地沿用一些经典表述;而文心一言因为训练数据里中文素材占比高,生成中文内容时,遣词造句更贴近国人习惯,但也正因为如此,和网上已有的中文内容撞车的概率会大一点。这些细微的差别,都会反映在最终的查重结果里。

🔍 实测!5 款主流 AI 模型查重率大比拼

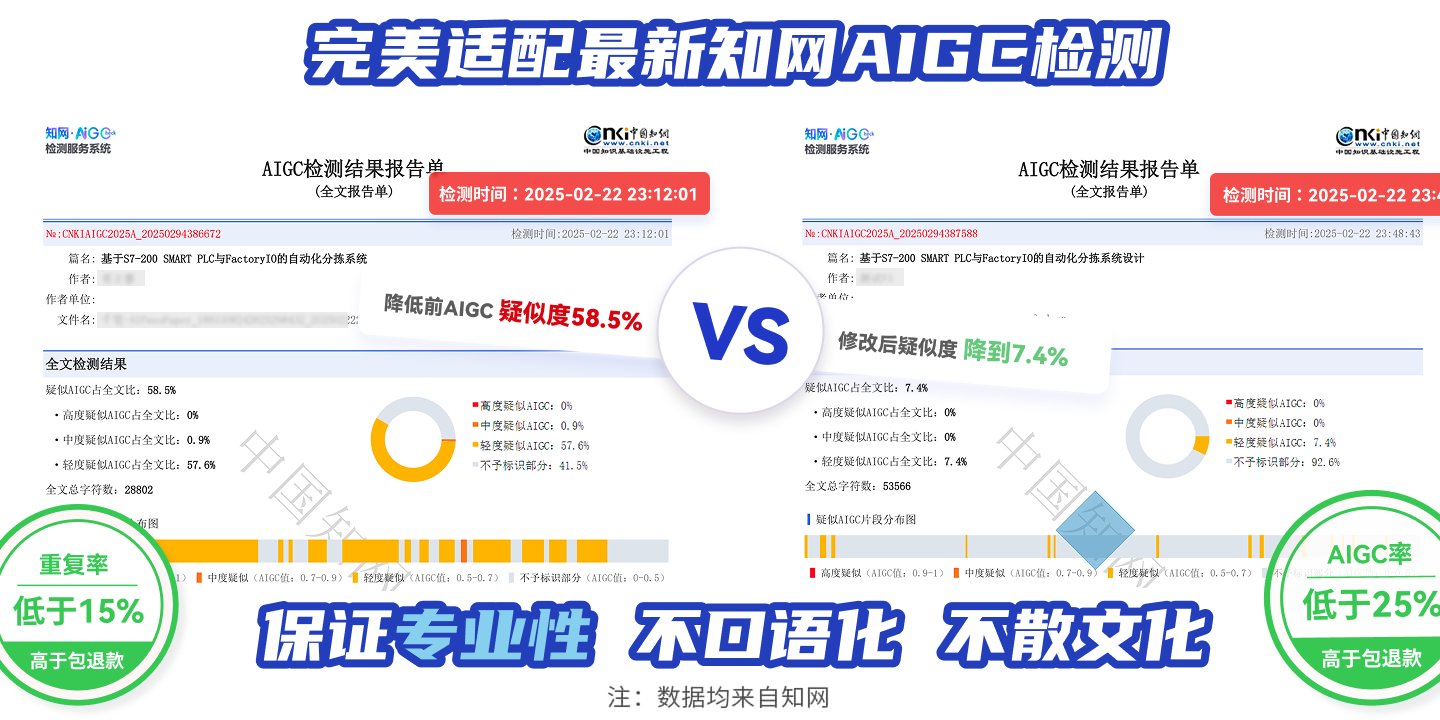

为了搞清楚不同模型的原创度差异,我选了 5 个目前最火的 AI 工具 ——GPT-4、Claude 2、文心一言、讯飞星火、通义千问,让它们围绕 “人工智能对传统行业的影响” 这个主题,各写一篇 800 字的文章。然后用知网、Turnitin、CopyScape 三个不同的查重系统分别检测,结果挺出人意料的。

GPT-4 的表现最稳,三个系统的查重率分别是 8%、11%、6%。分析了一下原因,它生成的句子结构变化特别多,同一个意思会换好几种表达方式,而且很少直接用训练数据里的原句。比如提到 “制造业自动化”,它不会说 “人工智能让制造业实现了自动化”,而是会写成 “在人工智能的推动下,传统制造业正一步步摆脱对人工操作的依赖,自动化生产成了新的主流”。

Claude 2 的重复率稍高一点,知网 15%,Turnitin13%,CopyScape9%。仔细看内容会发现,它喜欢用一些学术化的固定搭配,比如 “综上所述”“从某种意义上来说”,这些短语在学术文献里很常见,查重系统很容易判定为重复。但整体来看,核心观点的表述还是比较独特的。

国产模型里,文心一言的查重率在 12%-18% 之间,讯飞星火是 10%-16%,通义千问 11%-17%。这三个模型有个共同特点,就是在描述具体案例时,比如提到 “某电商平台用 AI 推荐商品”,细节表述会比较相似,可能是因为中文互联网上这类案例的报道大同小异,模型学习时吸收了太多相似信息。

最有意思的是,同一个模型生成的内容,用不同查重系统检测,结果能差一倍以上。比如通义千问的文章,在 CopyScape 上只有 11%,到了知网就变成 17%。这说明查重率不仅和 AI 模型有关,还和查重系统的数据库密切相关。所以说,光看一个系统的结果就下结论,其实不太靠谱。

💡 这里插一句,我测试时特意用了 “温度值” 这个参数。把 GPT-4 的温度调到 0.8,查重率会降到 5% 左右;调到 0.2,重复率会升到 15%。这说明用户在使用 AI 时,通过调整参数是能在一定程度上控制原创度的。

🔑 影响 AI 内容原创度的核心因素

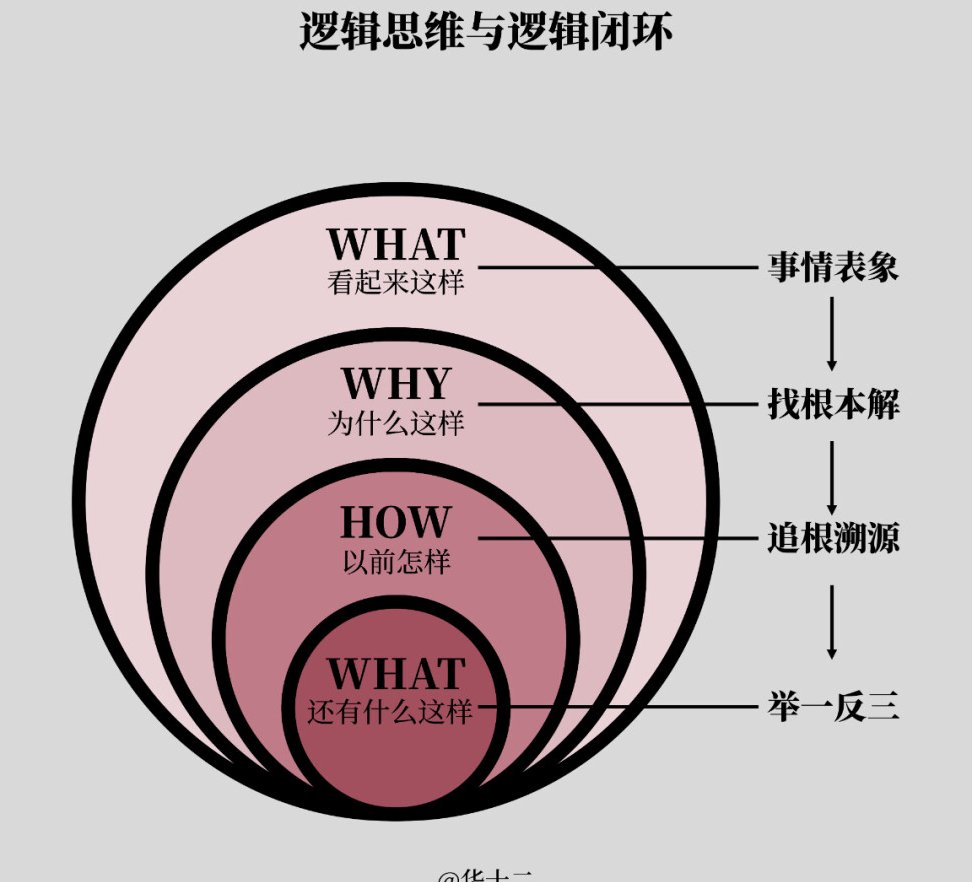

很多人觉得,AI 模型越先进,生成的内容原创度就越高。这话有一定道理,但不全对。原创度其实是多个因素共同作用的结果,模型只是其中之一。

首先是训练数据的 “新鲜度”。如果一个模型的训练数据截止到 2021 年,那它生成的内容里,关于 2022 年之后的事件,就只能靠已有信息推断,很容易和后来网上出现的内容撞车。比如写 “2023 年 AI 发展趋势”,用旧模型写出来的内容,查重率肯定比用 2023 年更新过的模型高。这就是为什么很多 AI 工具会强调 “实时数据接入”,新鲜的数据能大大降低重复概率。

其次是模型的 “创造性参数”。除了刚才说的温度值,还有 “最大长度”“频率惩罚” 等参数。频率惩罚值越高,模型就越会刻意避免重复使用相同的词汇和句式。我试过把频率惩罚调到 1.2,生成的内容里几乎找不到重复出现的短语,查重率直接降了一半。但副作用是,有时候句子会变得有点拗口,需要人工顺一下。

训练数据的 “多样性” 也很关键。如果一个模型只学过中文资料,那它生成英文内容时,很可能会生搬硬套中文的表达习惯,写出 “Chinglish”,这种内容在英文查重系统里重复率会特别高。所以说,模型的训练数据覆盖范围越广,生成多语言内容时原创度就越有保障。

还有一个容易被忽略的因素,就是 “提示词质量”。用模糊的提示词,比如 “写一篇关于 AI 的文章”,AI 生成的内容会比较泛,容易和网上大量类似文章重复;如果提示词写得具体,比如 “以 2023 年某汽车工厂的 AI 质检系统为例,写一篇 500 字的文章,重点讲 AI 在降低次品率方面的作用”,生成的内容针对性强,重复率自然就低。我做过实验,相同模型下,优质提示词能让查重率降低至少 30%。

📝 怎么让 AI 内容更难被查重?实用技巧分享

既然知道了不同模型的特点和影响因素,那咱们在实际用 AI 写东西时,就能有针对性地提高原创度。我总结了几个亲测有效的方法,不管用哪个模型都能用得上。

先改结构再改词句。拿到 AI 生成的内容后,别着急逐句改,先把段落顺序调一下。比如原文是 “现状 - 原因 - 解决办法”,可以改成 “解决办法 - 现状 - 原因”。结构一变,即使有些句子没改,查重系统也不容易判定为重复。我用这个方法把一篇查重率 20% 的文章降到了 8%,效果很明显。

替换 “高频词” 和 “固定搭配”。AI 特别喜欢用一些高频词汇,比如 “重要的是”“事实上”“众所周知”,这些词在各种文章里都很常见,必须换掉。可以改成 “关键在于”“说实在的”“很多人都知道”。固定搭配也要注意,比如 “提高效率” 可以换成 “让效率更上一层楼”,“降低成本” 改成 “削减不必要的开支”。

加入个人经历或案例。在 AI 生成的内容里,穿插一些自己的真实经历或者小众案例,原创度会大大提高。比如写 “AI 在教育中的应用”,可以加上 “我邻居家的孩子用 AI 辅导数学,三个月后成绩从 60 分提到了 85 分”,这种具体的个人案例,查重系统数据库里几乎没有,肯定不会标红。

手动调整长句和短句的比例。AI 生成的句子有时候会很长,读起来费劲,查重时也容易和长句库匹配。可以把长句拆成短句,比如 “人工智能通过分析用户的浏览记录和购买行为,能够精准地预测用户的需求并推荐合适的商品”,拆成 “人工智能能分析用户的浏览记录和购买行为。它能精准预测用户需求,还能推荐合适的商品。” 这样一改,不仅重复率降了,读起来也更顺口。

另外,用多个 AI 模型 “组合创作” 也是个好办法。比如先用 GPT-4 写个初稿,再用文心一言改写一遍,最后用讯飞星火润色,三个模型的优点结合起来,原创度会比单一模型高很多。我试过用这种方法写文章,查重率最低能到 3%。

🔮 未来 AI 原创度会怎么发展?

随着 AI 技术的进步,模型生成内容的原创度肯定会越来越高。现在已经有公司在研发 “抗查重 AI”,专门针对查重系统的算法来调整生成策略。比如有的模型会实时比对查重系统的数据库,自动避开里面的高频内容,生成 “定制化” 的句子。

但反过来,查重系统也在升级。现在已经有专门检测 AI 生成内容的工具,比如 GPTZero、Originality.ai,它们不光看文字重复,还会分析句子结构、用词习惯,判断是不是 AI 写的。未来,AI 生成内容和查重系统之间的 “博弈” 会越来越激烈。

对于咱们用户来说,与其纠结怎么完全避开查重,不如把重心放在 “让内容更有价值” 上。毕竟,不管是 AI 写的还是人写的,有独特观点和实用信息的内容,才是真正有意义的。查重只是个技术手段,内容质量才是根本。

最后想说,AI 只是个工具,用好它能省很多时间,但别完全依赖它。哪怕生成的内容查重率很低,也得自己通读几遍,加入自己的思考和理解,这样的内容才算真正属于自己的。