训练自己的 AI 写作模型听起来挺酷的吧?但真要动手做起来,可不是拍脑袋就能成的事儿。这里面涉及到数据、技术、耐心,还有对结果的合理预期。咱们今天就掰开揉碎了说,普通人到底有没有可能搞出自己的 AI 写作模型,以及个性化定制这事儿到底靠不靠谱。

📊 先搞清楚:训练 AI 写作模型的前提条件有哪些?

别一上来就想着敲代码调参数,先看看自己手里有啥 “本钱”。训练 AI 写作模型,最核心的两个东西 —— 数据和技术储备,缺了哪样都玩不转。

数据这块,说难听点就是 “喂给模型的饭”。你想让模型写出什么样的东西,就得给它吃对应的 “食材”。比如你想做个写诗歌的模型,总不能天天喂它新闻稿吧?高质量的数据得满足几个条件:相关性强、风格统一、没有太多噪音。相关性好理解,写散文就找散文,写文案就找文案;风格统一是说别今天喂文言文明天喂网络段子,模型会懵的;噪音就是那些错字、乱码、逻辑混乱的内容,必须提前清干净。

数量上也有讲究。现在主流的大模型动辄几十亿参数,背后都是以 TB 为单位的数据堆出来的。普通人肯定达不到这规模,但至少也得有几万到几十万字的高质量文本。我见过有人用自己公众号三年的文章(大概 50 万字)训练出小模型,虽然比不上商用的,但写出来的东西确实有内味儿了。

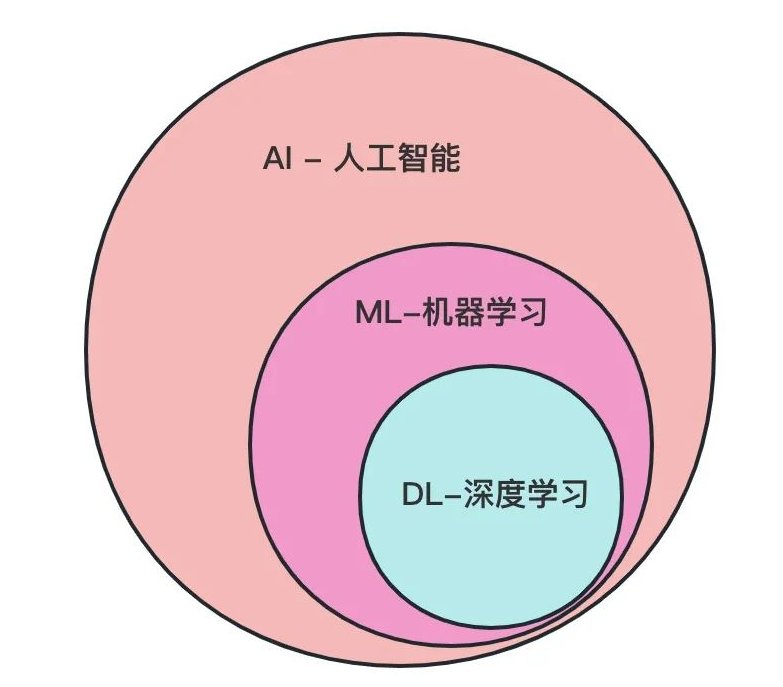

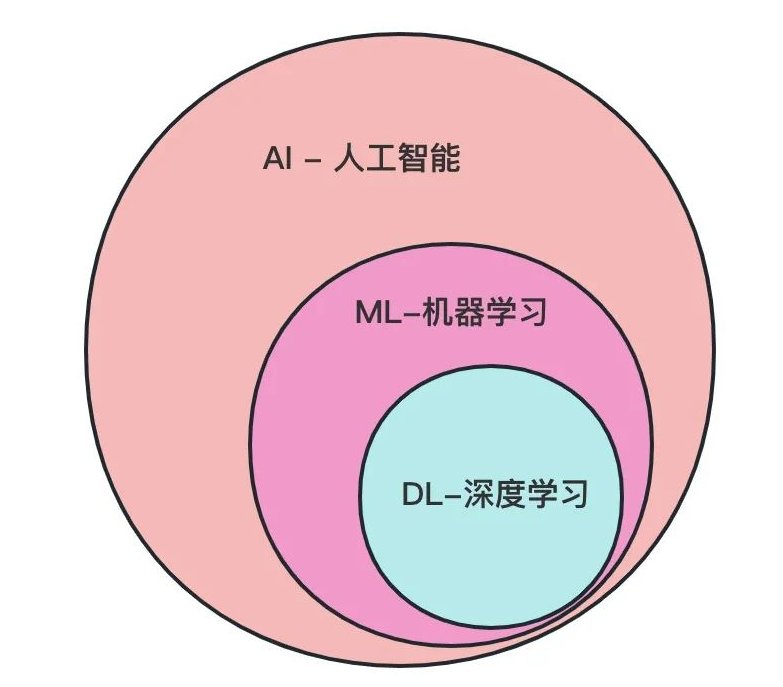

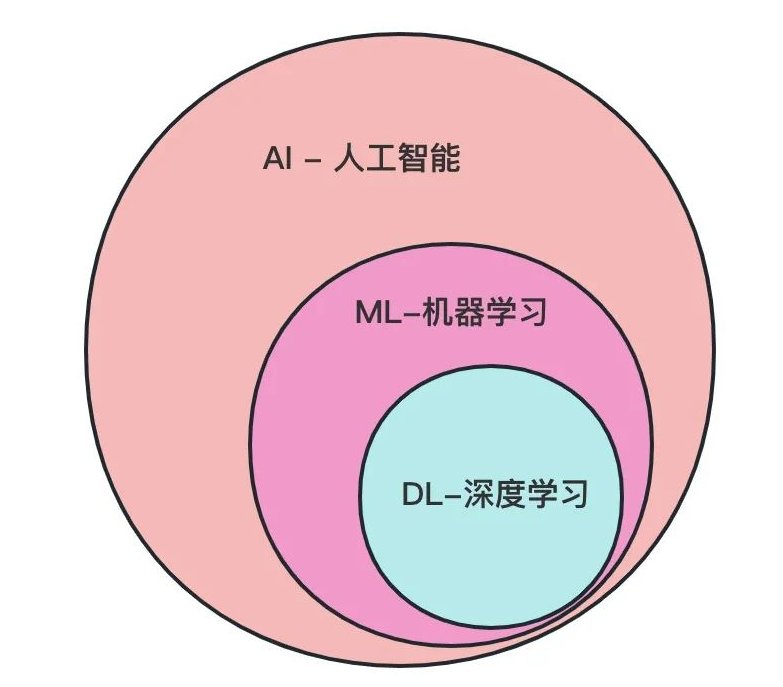

技术这块就更现实了。你不用像算法工程师那样精通深度学习,但至少得懂点基础。比如知道什么是 Transformer 架构(现在主流写作模型基本都用这个),会用 Python 调个库(比如 Hugging Face 的 Transformers),能看懂简单的训练日志。要是连命令行都怕,那还是先从基础学起,或者找个懂技术的朋友搭伙。

还有个绕不开的东西 —— 算力。普通电脑跑个小模型还行,想训个稍微像样点的,比如基于 GPT-2 微调,没个好显卡根本扛不住。我之前用一块 RTX 3090 跑一个 100 万字的数据集,光微调就花了 3 天,中间还崩了两次。嫌麻烦的话可以租云服务器,像阿里云、AWS 都有现成的机器学习环境,按小时收费,普通人也能承受。

✂️ 数据预处理:决定模型上限的关键一步

很多人以为数据越多越好,其实不然。一堆乱七八糟的数据喂进去,模型只会学出四不像。预处理这步做不好,后面再怎么调参都是白搭。

第一步是 “清洗”。拿到数据先别急着训练,先把里面的垃圾清掉。比如网页爬下来的内容里可能混着广告、代码片段、重复段落,这些必须删掉。还有标点符号混乱、中英文夹杂(除非你特意要这种风格)的文本,也得统一处理。我见过最离谱的案例,有人把带水印的 PDF 转成文本就直接用,结果模型学了一堆 “某某公司版权所有”,写啥都带这句。

然后是 “结构化”。写作模型吃的是 “序列数据”,得把文本切成合适的长度。比如写短文就切成 200-300 字的片段,写小说可以放长到 500 字。切的时候要注意保持句子完整,别把一句话拦腰斩断。有个小技巧:用句号、感叹号作为分割点,比单纯按字数硬切效果好得多。

还有个进阶操作 —— 标注。如果想让模型更 “懂” 你,比如知道什么时候该分段、什么时候用加粗,就得给数据做标注。最简单的是加特殊符号,比如用【标题】【段落】这样的标签区分结构。我认识一个做自媒体的,给所有文章标上了 “开头钩子”“案例引入”“观点总结”,训出来的模型写起推文框架来比助理还靠谱。

数据不平衡也是个坑。比如你喂的文本里 80% 都是严肃分析,突然想让模型写段幽默段子,它肯定写不出来。解决办法是刻意补充对应类型的数据,或者在训练时调整采样权重,让模型多学薄弱的部分。我之前为了让模型会写对话,特意找了 10 万字的小说对话片段混进去,效果确实明显。

最后别忘了做 “验证集” 和 “测试集”。简单说就是把数据分成三份:80% 用来训练,10% 用来验证(训练时看效果),10% 用来测试(训完了看最终结果)。千万别把所有数据都拿去训,不然模型可能会 “死记硬背”,换个话题就露馅了。

🛠️ 模型训练:从 “微调” 开始更靠谱

普通人想从头训练一个模型,基本上等于天方夜谭。现在哪怕是个小模型,也得几千万参数,没有团队和资金根本玩不转。最现实的路子是 “站在巨人肩膀上”—— 用现成的开源模型做微调。

选基础模型很关键。新手建议从中小模型入手,比如 GPT-2(有不同大小版本,小的才 1.2 亿参数)、BART、T5 这些。这些模型在海量数据上预训练过,已经具备基本的语言理解能力,你只需要用自己的数据让它 “学你的风格”。我第一次尝试时用的是 GPT-2 的 small 版本,对电脑要求不高,调试起来也方便。

微调的过程其实就是 “让模型忘记通用知识,记住你的特点”。核心是调整参数,比如学习率不能太高(一般设 1e-5 到 5e-5 之间),不然模型学太快容易 “走火入魔”(过拟合);训练轮次也得控制,我一般看验证集的损失值,一旦开始上升就赶紧停,免得把噪音也学进去了。

这里有个小窍门:用 “少样本学习” 辅助。比如你想让模型学写产品文案,就在训练数据里加入一些 “示例”—— 前面放产品信息,后面接你写的文案。模型会慢慢学会这种 “输入 - 输出” 的对应关系,比单纯喂文案效果好得多。我用这个方法给一个电商朋友训的模型,现在写产品短评基本不用改,直接能用。

训练过程中一定要盯着日志。看损失值(Loss)降没降,降得快不快;看生成的样本有没有跑偏,是不是越来越像你的风格。我之前训一个情感类写作模型,中途发现生成的内容越来越消极,查了才知道训练数据里负面文章占比太高,赶紧调整数据比例才救回来。

训完之后别急着用,先做测试。随便给个开头,让模型续写;或者输入一个主题,看它能不能写出符合要求的内容。重点看这几点:逻辑通不通?有没有重复啰嗦?风格统一吗?有没有 “胡说八道”(比如编造事实)?有问题就回去检查数据或参数,再训一轮。

🎯 个性化定制:到底能做到多 “像”?

这可能是大家最关心的问题 —— 能不能训出一个 “迷你版自己”,写的东西跟自己一模一样?答案是:很难完全一样,但能做到 “神似”。

风格模仿是最容易实现的。比如你写文章爱用短句,模型学多了也会跟着用;你总爱用某个梗(比如 “懂的都懂”),模型也会时不时冒出来。我见过一个美食博主,用自己的文章训出来的模型,连 “咬下去那口酥脆,像踩碎了秋天的落叶” 这种比喻都学得有模有样。

但想让模型学会你的 “思考方式” 就难了。写作不只是文字堆砌,还有逻辑链条、观点输出、情感表达。这些深层的东西,光靠文本数据很难完全传递给模型。我之前帮一个律师朋友训模型,合同格式、常用条款学得很快,但遇到复杂的法律逻辑,写出来的东西还是会有漏洞,必须人工把关。

领域专精倒是可以做得不错。如果你专注某个细分领域,比如宠物医疗、古典音乐,用领域内的专业数据去训,模型能比通用大模型更 “懂行”。我认识一个做汉服科普的博主,她的模型不仅能写形制考据,还能准确区分 “马面裙” 和 “百褶裙” 的区别,比很多人类小编都专业。

还有一种个性化是 “功能定制”。比如让模型只写开头,或者只写结尾;让它能根据关键词生成大纲;甚至让它学会用特定结构(比如 “问题 - 原因 - 解决方案”)来写文章。这些通过调整训练数据的格式就能实现,技术难度不高,但实用性很强。

不过要认清现实:个性化程度和数据量成正比。你给的东西越独特、越丰富,模型学得就越像。但普通人能拿出来的独特数据其实有限,所以别指望训个模型就能替代自己,它更像是个 “高级助手”—— 帮你写初稿、列提纲、找灵感,最后还得你来把关润色。

🚧 普通人玩这个,难点在哪?

别被前面说的 “能做到” 冲昏头,这事儿没那么容易。普通人想搞个性化 AI 写作模型,至少要跨过这几道坎。

数据不够是最大的痛点。要么量不够,要么质量不行。我接触过很多自媒体人,说自己有 “很多内容”,真导出来一看,要么是碎片化的短评,要么是转载的文章(没版权,不能用),真正能用来训练的原创长文没多少。这种情况训出来的模型,写短句子还行,写长文就露馅。

技术门槛还是有点高。就算用现成的工具,调参、改代码、处理报错这些事儿,对纯文科背景的人来说还是挺劝退的。我见过有人跟着教程一步一步做,到 “安装依赖库” 那步就卡壳了,因为电脑缺个系统组件,折腾了半天也没搞定。

效果预期容易跑偏。总有人觉得 “我训个模型,以后就不用写了”。其实根本不是这样。现在的小模型,写点套路化的东西(比如产品说明、活动通知)还行,遇到需要深度思考、情感共鸣的内容(比如观点文、散文),还是得人来主导。把它当工具用,别当 “替身” 用,才是正确的打开方式。

还有算力和成本问题。虽然云服务器能租,但长期用也不便宜。我大概算过,训一个中等规模的模型(基于 GPT-2 medium),算上调试和多次训练,成本大概在几百到一千块。对个人来说不算多,但要是训了效果不好,就容易觉得不值。

🔮 未来可能性:门槛会越来越低吗?

肯定会。这两年 AI 工具发展太快了,以前想都不敢想的事情,现在普通人也能碰一碰了。

工具会越来越傻瓜化。现在已经有不少平台(比如 Hugging Face Spaces、Google Colab)提供现成的训练模板,你只需要上传数据,调几个简单参数就行,不用自己写代码。我估计再过一两年,可能会出现 “一键训练” 的工具,连参数都不用调,直接给结果。

小模型会更受重视。大模型虽然强,但太 “通用”,而且贵。以后肯定会出现更多针对个人、小团队的轻量化模型,比如 “小红书风格写作模型”“公众号短文案模型”,甚至可以直接在手机上运行,随用随训。

个性化和版权会更规范。现在用别人的文章训模型,到底算不算侵权还没定论。未来可能会有专门的 “授权数据市场”,你可以买到合法的训练数据;也可能出现 “风格授权”—— 比如你喜欢某个作家的风格,付点钱就能用他授权的风格模型。

但有一点不会变:AI 始终是辅助工具。写作的核心是观点、情感、创造力,这些东西目前还没法完全交给机器。就算模型写得再像你,最终的判断、修改、升华,还得靠人来做。

所以如果你问我 “普通人该不该试试训自己的 AI 写作模型”,我的答案是:可以试试,但别抱太高期望。把它当成一个提升效率的工具,用来处理那些重复、基础的写作工作,让自己有更多精力琢磨更重要的东西 —— 这才是它最实际的价值。

【该文章由diwuai.com第五 ai 创作,第五 AI - 高质量公众号、头条号等自媒体文章创作平台 | 降 AI 味 + AI 检测 + 全网热搜爆文库🔗立即免费注册 开始体验工具箱 - 朱雀