最近后台总有人问,用 AI 写公众号会不会被平台处罚?这个问题其实挺有意思的。毕竟现在 AI 写作工具越来越火,不少人都想靠它提高更新频率,但又怕触碰平台红线。今天就来好好聊一聊这个话题,结合实际案例和审核规则,给大家说透这里面的门道。

🤖 平台真的在 “封杀” AI 写作吗?先看三组真实案例

去年下半年,有个做职场号的朋友跟我说,他连续三篇用 AI 生成的文章被微信标记为 “低质内容”,推荐量直接掉了 80%。他当时特别慌,以为平台开始针对 AI 写作了。但仔细看他的文章,发现问题根本不在 “AI 生成” 这个标签上 —— 那三篇文章全是把网上的职场鸡汤打乱重组,连案例都是十年前的旧闻,甚至有两段文字重复出现。

再看另一个案例。科技领域的大号 “量子位” 去年发过一篇分析 AI 绘画的文章,开头就明说 “部分内容由 GPT-4 辅助撰写”。那篇文章不仅没被限流,反而因为观点新颖,还被微信推荐到了 “看一看” 首页。这说明什么?平台其实并不排斥 AI 写作本身。

还有个更典型的例子。某情感类公众号用 AI 批量生成 “星座运势”,每天更新 12 篇,内容大同小异,就是把日期和星座名称换了换。结果不到一个月,账号就被限制了 “原创声明” 功能。客服给出的理由是 “内容缺乏独创性,对用户无实质价值”。

这三个案例放在一起看就很清楚了:平台处罚的从来不是 “用了 AI”,而是 “用 AI 生产低质内容”。现在主流内容平台的规则里,根本没有 “禁止 AI 写作” 这一条。微信公众号的《运营规范》、头条号的《创作规范》里,核心要求始终围绕 “原创性”“信息量”“用户价值” 这几个点。

🔍 内容审核的底层逻辑:机器比你更懂 “内容本质”

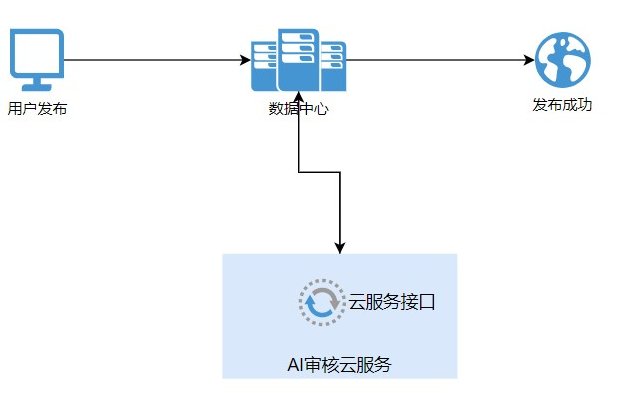

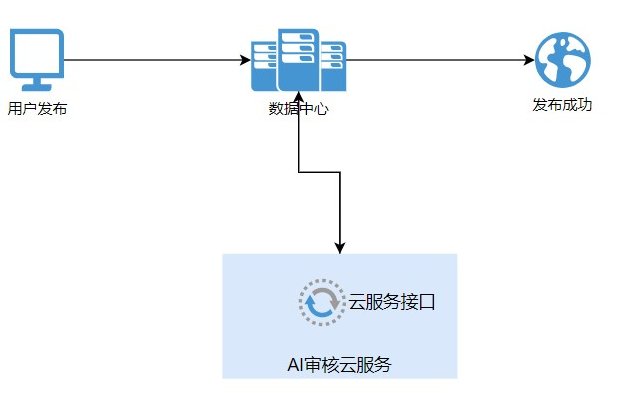

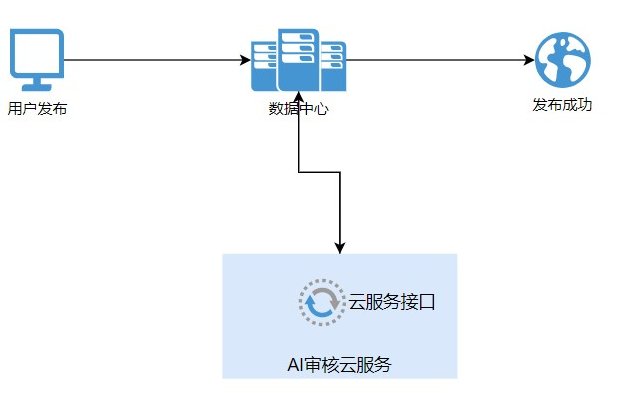

很多人以为内容审核是人工一篇篇看,其实现在 90% 以上的初审都是机器完成的。这些审核系统的底层逻辑,比我们想象的更 “聪明”—— 它们不关心内容是怎么生产出来的,只在乎内容本身有没有价值。

机器审核首先会扫描 “重复率”。这里的重复率不只是跟全网内容比,还会跟你自己账号的历史内容比。有个做美食号的博主,用 AI 改写自己过去的文章,换个标题就重新发布,结果被判定为 “洗稿”。原因很简单,系统能识别出两篇文章的语义相似度超过 70%,就算换了句式也没用。

然后看 “信息密度”。审核系统会分析文章里有多少新观点、新数据、新案例。如果一篇文章翻来覆去就说一个道理,或者全是正确的废话,比如 “努力就能成功”“要好好生活” 这种,不管是不是 AI 写的,都会被打上 “低质” 标签。有数据显示,信息密度低于 30% 的文章,推荐量会比正常文章低 60% 以上。

还要看 “用户反馈”。机器会实时监控文章的完读率、点赞、在看、留言这些数据。如果一篇文章打开后 3 秒内就被关掉的人超过 50%,系统就会认为内容不符合用户预期,自然会减少推荐。这也是为什么有些 AI 生成的 “标题党” 文章,看着阅读量高,后续推荐却断崖式下跌。

可能有人会问,机器怎么判断内容是不是 AI 写的?其实现在的技术还做不到 100% 识别,但系统会捕捉一些 AI 写作的典型特征,比如句式过于工整、用词过于 “标准”、缺乏口语化表达。这些特征本身不违规,但如果同时伴随着低信息密度,就容易被重点审核。

✍️ 安全使用 AI 写作的四个实操技巧

既然平台不封杀 AI 写作,那怎么用才能既提高效率,又不踩坑?分享几个经过验证的方法。

首先,一定要做 “人格化改造”。AI 生成的内容往往太 “中立”,缺乏个人特色。你可以在文章里加入自己的经历,比如 “上周我试了这个方法,结果发现……”;也可以加入具体的场景,比如 “昨天在地铁上看到有人这么做,突然想到……”。这些细节 AI 很难凭空生成,却是增加内容独特性的关键。

其次,控制 AI 的 “创作比例”。最好的方式是用 AI 做素材整理和初稿撰写,然后人工做二次创作。比如写一篇产品测评,你可以让 AI 列出产品参数和用户评价,然后自己来分析这些数据背后的意义,加入对比案例和使用体验。这样既提高了效率,又保证了内容的独创性。

再者,一定要检查 “事实准确性”。AI 经常会编造数据、案例甚至名人名言。有个健康号用 AI 写文章,说 “某权威机构研究发现,每天喝八杯水会伤肾”,结果被读者举报。后来查证,根本没有这个研究,是 AI 瞎编的。这种错误一旦出现,不仅会被平台处罚,还会毁掉账号的公信力。

最后,避开 “高风险领域”。像医疗、财经、法律这些需要专业资质的领域,最好别用 AI 写核心内容。AI 生成的医疗建议可能存在错误,财经分析可能涉及虚假信息,这些都容易触发平台的严格审核。就算你自己是专业人士,用 AI 辅助也要格外小心,最好逐句核对。

这里有个小技巧,发布前可以用 “微信官方的原创检测工具” 自查一下。虽然这个工具主要查抄袭,但如果检测结果显示 “与多篇文章语义相似”,那就要小心了,很可能是 AI 生成的内容太 “模板化” 了。

📈 未来一年,AI 写作的合规性会发生哪些变化?

行业内有个共识,未来平台不会禁止 AI 写作,但会出台更明确的规则。比如现在已经有平台在测试 “AI 内容标记功能”,要求创作者注明哪些部分是 AI 生成的。这个功能一旦普及,可能会影响用户对内容的信任度,但对合规性来说是好事。

另外,审核系统肯定会升级。现在已经有团队在研发专门针对 AI 低质内容的识别模型,未来那些纯粹用 AI 拼凑、毫无价值的内容,生存空间会越来越小。反而那些用 AI 提高创作效率,同时保持高原创性和信息量的账号,可能会获得更多扶持。

还有个趋势是 “垂直领域的 AI 写作规范”。比如教育类账号用 AI 生成课程内容,可能需要提供更严格的资质证明;新闻类账号用 AI 写报道,可能要遵守更严格的事实核查流程。不同领域的规则可能会细化,不会再是一刀切的标准。

对我们创作者来说,与其担心 “会不会被处罚”,不如把精力放在 “怎么用好 AI” 上。记住一点,平台的核心目标是给用户提供有价值的内容,不管用什么工具,只要能达到这个目标,就不用担心合规问题。

最后想说,AI 其实就像十年前的美图秀秀,一开始大家也担心 “修图过度会不会被平台限制”,但后来发现,真正受欢迎的还是那些修得自然、有美感的内容。AI 写作也是一样,工具本身没有对错,关键看怎么用。把 AI 当成助手,而不是替代品,才能在提高效率的同时,保住账号的生命力。

【该文章由diwuai.com第五 ai 创作,第五 AI - 高质量公众号、头条号等自媒体文章创作平台 | 降 AI 味 + AI 检测 + 全网热搜爆文库🔗立即