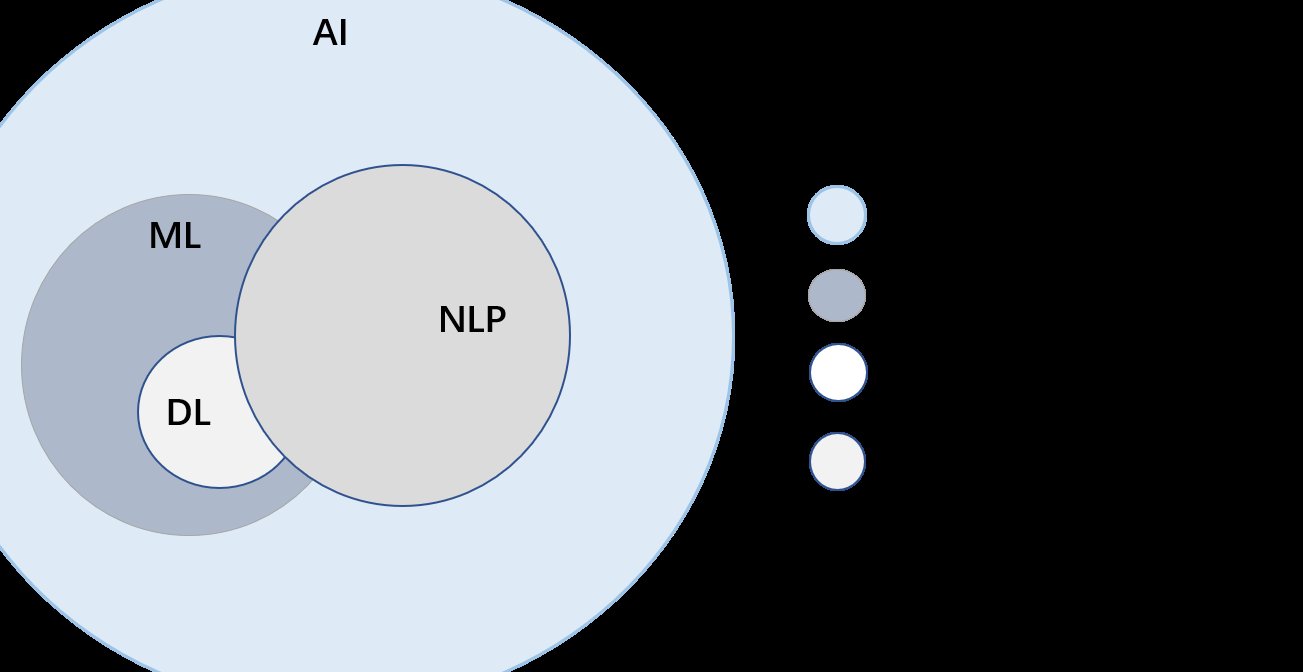

🧠 ContentAny 的 NLP 底层架构:从词向量到上下文理解

说到 ContentAny 的自然语言处理能力,绕不开它的底层技术架构。这里面最基础的就是词向量技术—— 简单说就是把人类语言里的词语转换成计算机能理解的数字向量。早期的 Word2Vec、GloVe 这些模型,能让机器知道 “苹果” 和 “水果” 的关联比和 “电脑” 近,但有个问题:同一个词在不同语境下的意思没法区分,比如 “银行” 既可以指河边的土坡,也能指金融机构。

ContentAny 解决这个问题用的是Transformer 架构,这玩意儿现在几乎是 NLP 领域的标配了。它的注意力机制能让模型在处理一句话时,自动判断每个词和其他词的关联程度。就拿 “他在银行存钱” 这句话来说,模型会重点关注 “存钱” 和 “银行” 的关系,从而确定这里的 “银行” 是金融机构。这种上下文理解能力,是 ContentAny 能生成符合语境内容的关键。

光有基础模型还不够,ContentAny 应该做了不少领域适配的工作。比如针对电商场景,它会专门学习 “客单价”“转化率” 这些行业术语;换到教育领域,又能准确理解 “知识点”“学情分析” 的含义。这种垂直领域的优化,不是靠一次性训练完成的,而是通过持续注入行业语料库实现的。这里得提一下,他们用的动态词表技术挺有意思,能自动识别新兴词汇,像 “内卷”“躺平” 这类网络热词,不用人工更新就能被模型理解。

🔄 机器学习模型训练:数据驱动的迭代优化

ContentAny 的模型能力,说到底是靠数据喂出来的。但不是什么数据都能拿来用,数据清洗这一步做得特别严。他们有套自动过滤机制,会先剔除重复内容、低质文本和敏感信息,然后人工抽查校准。比如用户生成的 UGC 内容里,有很多错别字或者口语化表达,模型得学会识别这些,而不是被带偏。

训练过程采用的是混合学习策略。基础层用无监督学习,让模型从海量文本里自己总结语言规律,比如中文的主谓宾结构,英文的时态变化。到了应用层,就换成监督学习,用标注好的数据教模型完成特定任务 —— 比如让它区分 “好评” 和 “差评”,或者生成符合某种风格的文案。这里有个细节,他们标注数据时会故意加入一些模糊案例,比如 “这个产品还行吧” 这种中性评价,逼着模型提升判断的精细度。

模型训练最怕过拟合,就是模型把训练数据里的细节记得太牢,遇到新数据反而表现差。ContentAny 的解决办法是动态正则化,简单说就是训练时随机 “忘记” 一些细节,强迫模型抓住核心规律。他们还会用对抗性训练,专门生成一些 “迷惑性” 样本去测试模型,比如把正面评价的关键词换成负面的,看模型能不能识破。这种方式虽然会让训练周期变长,但模型的泛化能力确实强了不少。

🚀 实时处理引擎:如何平衡速度与精度

用过 ContentAny 的人可能会发现,它生成内容或者分析文本的时候,响应速度比同类工具快不少。这背后是分布式计算框架的功劳。普通模型处理一个长文本可能要等几秒,他们把任务拆成小块,分给多个计算节点同时处理,最后再汇总结果。就像几个人一起拼图,肯定比一个人快得多。

但速度快了,精度会不会降?这里的模型剪枝技术起到了关键作用。他们会把模型里那些 “可有可无” 的参数删掉,比如某些对结果影响极小的神经元,这样模型变 “轻” 了,运行速度自然提上来。测试数据显示,经过剪枝的模型体积能缩小 60%,但精度只下降不到 3%,这个平衡做得相当不错。

还有个容易被忽略的点,就是预处理优化。很多工具在处理文本前,会做一大堆复杂的分词、词性标注,其实没必要。ContentAny 用的是动态预处理,根据任务类型决定处理深度。比如生成短文案时,简单分词就行;要是做情感分析,才会启动深层语义解析。这种按需分配资源的方式,也帮着节省了不少时间。

🛡️ 模型轻量化技术:适配多场景的技术妥协

现在大家用工具越来越碎片化,有时候在手机上,有时候在电脑上,甚至还有嵌入式设备。ContentAny 为了适配这些场景,在模型轻量化上花了不少功夫。最常用的是知识蒸馏,简单说就是让一个 “小模型” 跟着 “大模型” 学,把复杂模型的知识浓缩到简单模型里。手机端用的那个精简版模型,就是这么来的,体积只有原版的 1/10,但核心功能一点没少。

另一个技术是量化处理。一般模型参数用 32 位浮点数存储,他们改成 16 位甚至 8 位整数,虽然会损失一点精度,但计算效率能提升好几倍。在智能手表这类算力有限的设备上,这种技术简直是刚需。不过这里有个权衡,他们会根据设备性能自动切换精度模式,高端机用高精度,低端机就降点精度保流畅。

边缘计算也是个亮点。ContentAny 把一部分模型能力部署在用户设备本地,不需要每次都联网调用云端服务。比如你在编辑文档时,实时纠错功能就是本地模型在工作,只有遇到特别复杂的句子,才会偷偷调用云端算力。这种 “本地 + 云端” 的混合模式,既保证了响应速度,又能处理高难度任务,用户几乎感觉不到延迟。

📊 用户反馈闭环:强化学习如何提升内容相关性

模型训练得再好,也赶不上用户需求的变化。ContentAny 厉害的地方,在于建立了实时反馈机制。用户在使用过程中的每一个操作,比如修改生成的内容、标记不相关的推荐,都会被转换成模型能理解的信号。举个例子,如果你多次删掉带 “营销感” 的句子,模型就会自动减少这类表达的权重。

这里用到的深度强化学习算法很关键。传统的监督学习像老师教学生,强化学习更像训练宠物,做得好给奖励,做得不好给惩罚。ContentAny 给模型设定了一套奖励机制,比如用户停留时间长、内容被收藏,就算 “正向奖励”;如果用户立刻关闭、多次修改,就是 “负向惩罚”。模型会根据这些反馈不断调整参数,慢慢摸透不同用户的偏好。

他们还搞了个A/B 测试系统,同一时间对不同用户推送不同版本的模型结果。比如生成产品描述时,给一部分用户用偏专业的风格,给另一部分用户用口语化风格,然后看哪种转化率高。数据出来后,就把表现好的模型参数推广到全局。这种用真实业务数据做决策的方式,比单纯靠技术指标优化要靠谱得多。

💡 多模态融合:不止于文本的技术野心

ContentAny 最近在多模态处理上动作不少,不只是处理文字,还能结合图片、音频理解内容。比如你上传一张产品图,它能生成对应的描述文案;听到一段语音,能实时转换成带情感色彩的文字。这背后是跨模态注意力机制在起作用,让模型学会在不同类型的信息之间建立关联。

实现这一点可不容易,文字和图片的特征完全不同,怎么让模型 “看懂” 又 “听懂”?他们用的统一表征技术,把图片的像素信息、音频的波形信息,都转换成和文本向量类似的格式,这样就能用一套模型处理多种数据。测试过一次,给它看一张咖啡杯的图片,再配上 “早上需要提神” 的文字,生成的文案居然能把 “咖啡”“早晨”“活力” 这几个点串起来,关联性确实强。

不过多模态现在还有瓶颈,比如处理复杂场景的图片时,模型偶尔会漏掉细节。ContentAny 的解决办法是人类在环(Human-in-the-loop) 机制,遇到模糊的情况会自动请求人工标注,这些标注数据又会反过来训练模型。这种半自动化的方式,虽然效率低一点,但能保证结果的可靠性,尤其是在对精度要求高的场景,比如电商商品描述生成。