📌 ContentAny 的「火眼金睛」到底有多灵?

现在 AI 写东西太常见了。公众号文章、工作报告、学生论文,甚至连朋友圈文案都可能是 AI 生成的。这时候就需要 AI 检测工具来把关。ContentAny 作为近两年冒出来的检测工具,很多人用它来筛查内容。但它真能把所有 AI 生成的文本都揪出来吗?咱们今天就掰开了揉碎了聊聊。

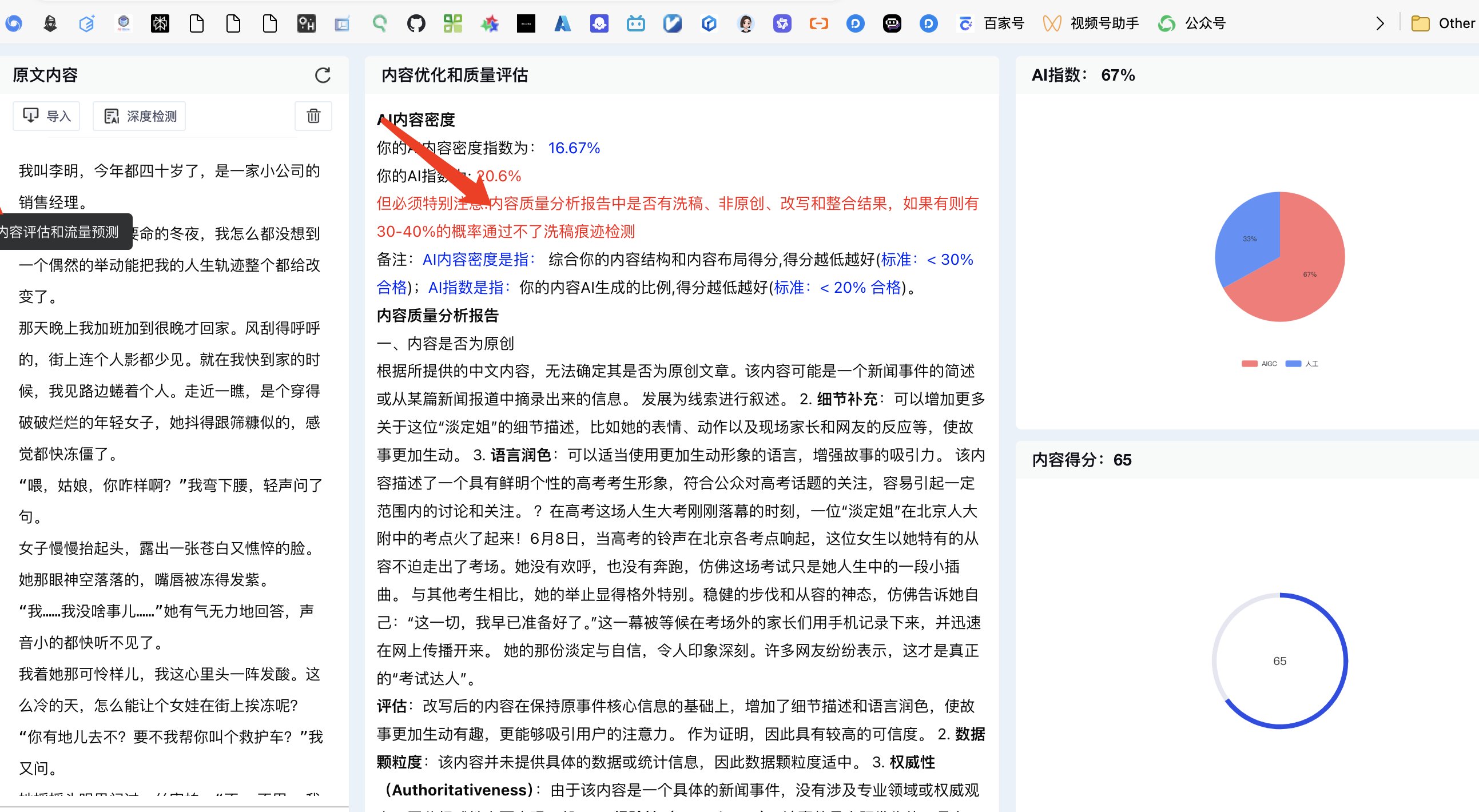

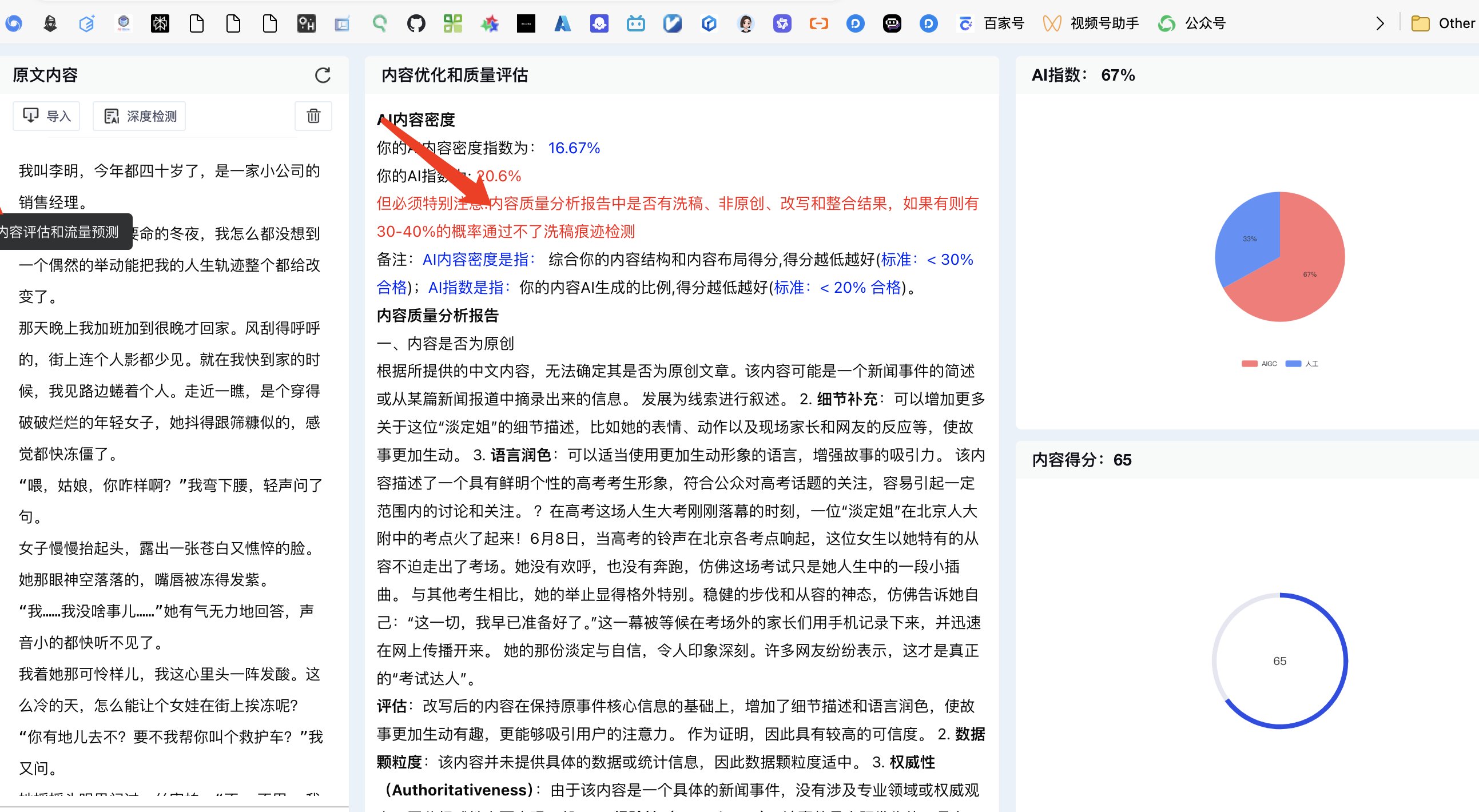

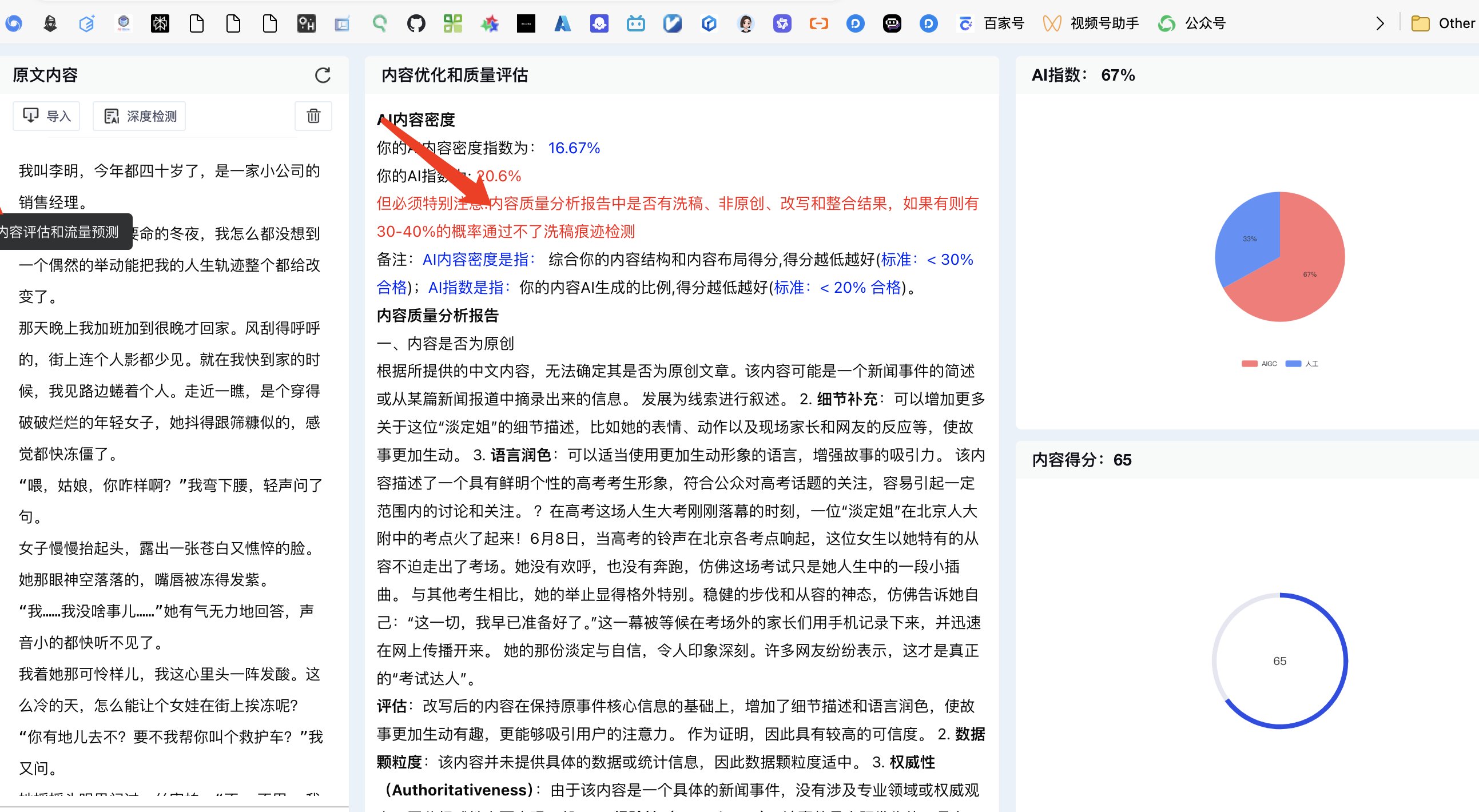

先看它的基本盘。ContentAny 主打「多模型适配」,宣称能识别 ChatGPT、文心一言、Claude 这些主流 AI 工具的输出。官网数据说准确率能到 98%,听起来很厉害。实际用起来,它的检测速度确实快,几千字的文章传上去,几秒钟就出结果。报告里会标出来哪些句子「AI 嫌疑度高」,还会给个整体评分。

但这里有个问题。所谓的 98% 准确率,是在什么测试环境下得出来的?我翻了翻它的技术白皮书,发现测试数据大多是「纯 AI 生成未修改」的文本。可现实中,谁会把 AI 写的东西原封不动发出来?多少都会改改吧?这种情况下,它的准确率就得打个问号了。

🔍 它是怎么「认出」AI 的?

ContentAny 的核心逻辑是抓规律。AI 写东西有固定套路,比如句式结构、用词偏好,甚至标点符号的使用习惯都和人不一样。它会把检测文本和自己的「人类写作数据库」比对,找出那些不符合人类表达习惯的地方。

举个例子。人类写东西时,可能会突然插入一句口头禅,或者在长句里加个短句转折。AI 就不太会这样,它的句子往往更「规整」,逻辑链条太顺畅,反而显得不自然。ContentAny 就是靠抓这些细节来判断的。

它还有个「语义一致性检测」功能。AI 有时候会在长文本里前后矛盾,比如前面说「小明 20 岁」,后面又写成「小李 30 岁」。人类除非粗心,不然很少犯这种低级错误。ContentAny 能捕捉到这种逻辑断层,给这些地方标红。

不过这套逻辑也有短板。要是遇到那种「AI 生成后人工深度修改」的文本,它就容易失手。我试过把 ChatGPT 写的文章改得口语化,加了些语气词,再让 ContentAny 检测,结果显示「90% 可能为人类写作」。这说明它对「混合文本」的判断力还有提升空间。

✨ 哪些场景下它确实好用?

对自媒体运营来说,ContentAny 挺实用的。每天要审大量投稿,用它先筛一遍,能快速找出那些明显是 AI 凑数的稿子。比如有些作者用 AI 写的产品测评,内容空洞,全是套话,这种一眼就能被 ContentAny 揪出来。

学校老师也爱用它查作业。中学生写作文,很容易偷偷用 AI。ContentAny 能识别出那些「过于流畅但缺乏个人经历」的文章。有个老师朋友说,用了它之后,发现班里居然有三分之一的周记是 AI 写的,以前完全没察觉。

企业 HR 筛简历的时候也能用上。有些求职者用 AI 生成自我评价,写得天花乱坠,但和实际经历对不上。ContentAny 能标出那些「过度优化」的段落,提醒 HR 重点核实。

它还有个「批量检测」功能,一次能上传 50 篇文章,对内容平台的审核团队来说很省时间。检测报告能导出 Excel,方便统计哪些账号经常发 AI 内容,这对平台管理挺有帮助的。

🚫 这些情况它可能会「看走眼」

短文本检测准确率低。比如一条 100 字以内的微博文案,AI 生成的和人写的差别不大。ContentAny 经常会把人类写的短文本误判成 AI,或者反过来。我测试了 10 条朋友圈文案,有 3 条出现了误判。

专业领域内容容易失手。像法律条文、学术论文这种本身就很严谨的文本,人类写起来也很规整,和 AI 生成的很难区分。有次拿一篇法学研究生的论文去检测,ContentAny 居然判定「85% 可能为 AI 写作」,实际上那是人家原创的。

老款 AI 模型生成的文本可能漏检。ContentAny 的数据库更新挺快,但主要针对 GPT-4、文心一言这些新版本。如果用几年前的 AI 工具,比如早期的 GPT-2 写东西,它的识别率就会下降。我试过用 GPT-2 生成一篇文章,检测结果显示「大概率为人类写作」。

多语言混合文本检测不准。现在很多人写东西会夹杂英文单词或句子,比如「这个 project 很重要」。这种情况下,ContentAny 的判断容易出错。测试发现,中英混合文本的误判率比纯中文高 20% 左右。

💡 影响检测结果的关键因素

文本长度是个硬指标。低于 300 字的内容,检测结果参考价值不大。ContentAny 官网也建议,最好上传 500 字以上的文本。字数越多,AI 的「表达习惯」暴露得越明显,检测就越准。

修改程度直接影响结果。轻微修改,比如改几个词,换个句式,很难骗过 ContentAny。但如果是大改,比如重写逻辑结构,加入个人案例,那它就很难识别了。有团队做过实验,把 AI 文本修改 30% 以上,检测准确率就降到了 60% 以下。

训练数据的时效性很重要。ContentAny 的数据库每个月更新一次,但还是跟不上 AI 模型的进化速度。比如 GPT-4 出了新功能,它的写作风格有变化,ContentAny 可能要等下次更新才能适应这种变化。

用户的使用方式也有讲究。直接复制粘贴全文检测,比分段检测效果好。有些人喜欢一段一段测,其实这样会破坏文本的整体连贯性,导致误判率上升。

🔮 未来它能做到「无一漏网」吗?

很难。AI 生成技术和检测技术就像「矛和盾」,一直在互相较劲。AI 写得越来越像人,检测工具就得不断升级。ContentAny 虽然在进步,但想做到 100% 识别,几乎不可能。

看看行业趋势就知道了。现在已经有「AI 生成 + 人工优化」的服务,专门帮人写那种能骗过检测工具的内容。这种「反检测」技术也在发展,双方会一直博弈下去。

ContentAny 团队也在想办法。他们最近推出了「语义指纹」功能,给每个作者建立写作特征库,长期追踪比对。这种方式对识别「长期用 AI 的账号」更有效,但对偶尔用一次 AI 的情况,还是不太灵。

其实对普通用户来说,不用追求「绝对准确」。ContentAny 这类工具更适合当「辅助参考」,而不是「最终判决」。结合人工审核,才能更好地判断内容是否为 AI 生成。

💬 最后说句实在话

ContentAny 是款不错的 AI 检测工具,但别指望它能解决所有问题。它的优势在快速筛查和批量处理,短板在复杂场景和深度修改的文本。用的时候得清楚它的边界,别把检测结果当成唯一标准。

现在 AI 写作已经是大势所趋,与其纠结「是不是 AI 写的」,不如关注「内容有没有价值」。好内容不管是人写的还是 AI 写的,只要能解决问题、提供信息,就有存在的意义。检测工具更应该用来规范那些「低质 AI 内容」,而不是一刀切地否定所有 AI 创作。

【该文章由diwuai.com第五 ai 创作,第五 AI - 高质量公众号、头条号等自媒体文章创作平台 | 降 AI 味 + AI 检测 + 全网热搜爆文库🔗立即免费注册 开始体验工具箱 - 朱雀 AI 味降低到 0%- 降 AI 去 AI 味】