🔍 学术领域的 “AI 火眼金睛”——Turnitin 的行业地位

说真的,在学术诚信这个圈子里,Turnitin 的名字几乎没人不知道。你去问任何一所正规大学的老师,提到检测 AI 生成内容,十有八九会给你推荐它。这不是没有原因的,毕竟它在抄袭检测领域已经深耕了二十多年,积累的学术语料库据说超过了 900 亿份,这可不是一般工具能比的。

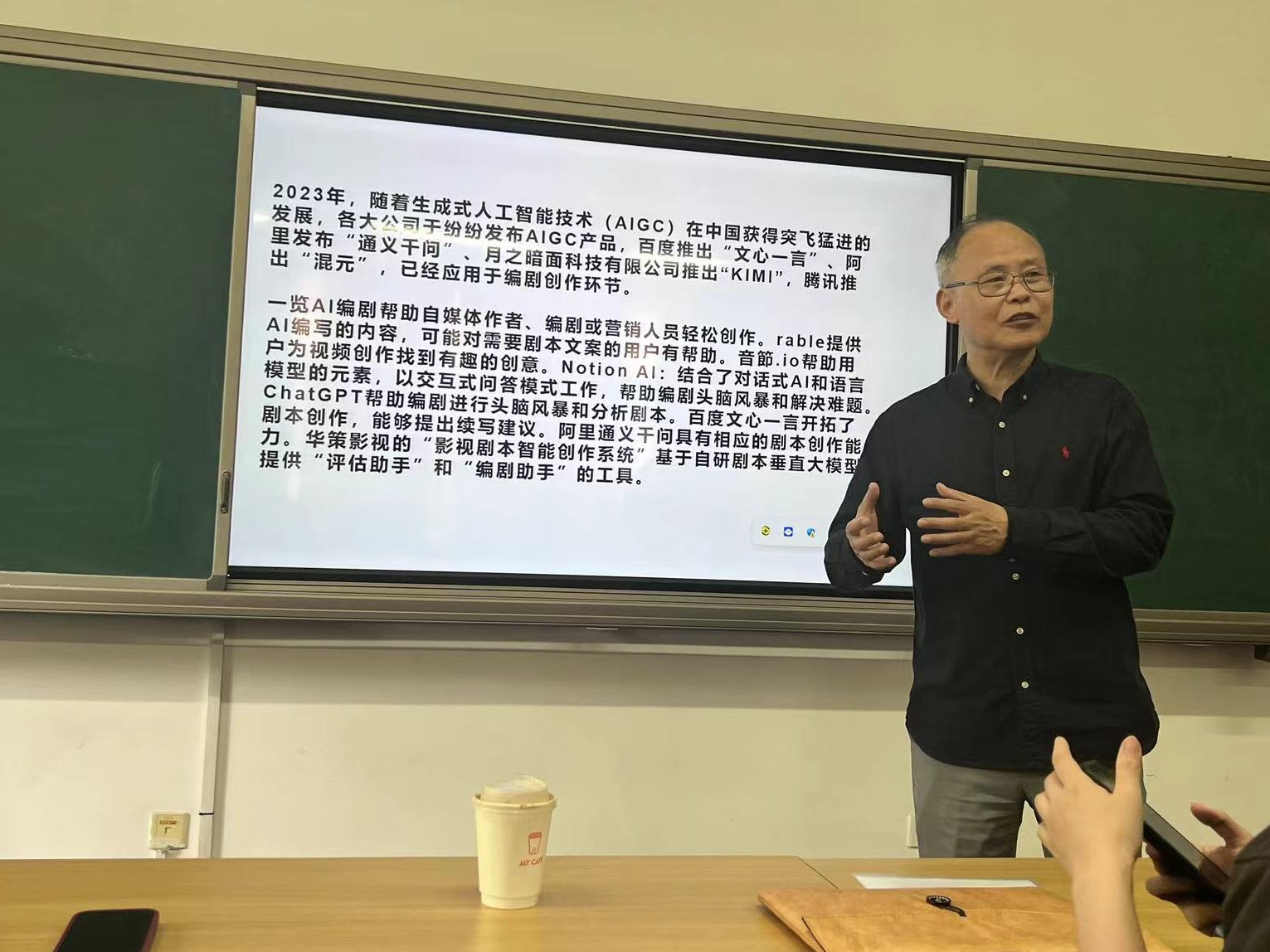

现在 AIGC 技术这么火,学生用 ChatGPT 写论文、用 Claude 改作业的情况越来越多。老师们最头疼的就是怎么分辨哪些是真材实料,哪些是 AI “代笔”。Turnitin 在这个时间点推出的 AI 检测功能,等于是直接接住了市场的刚需。全球超过 150 个国家的教育机构在靠它把关,这种量级的用户基础,本身就说明问题。

更关键的是,它和学术体系的绑定太深了。很多高校的教学系统比如 Canvas、Blackboard 都直接集成了 Turnitin 的接口,老师改作业时一点就能检测,根本不用切换平台。这种便利性,让它在同类工具里占了先天优势。

🧠 深度学习驱动的检测逻辑 —— 技术层面的硬实力

你可能不知道,Turnitin 的 AI 检测不是简单对比数据库就行的。它用的是专门训练的深度学习模型,这种模型见过的 AI 生成文本多到吓人 —— 从早期的 GPT-2 到现在的 GPT-4、Claude 3,甚至连一些小众的 AI 写作工具产出的内容,它都有样本库。

具体来说,它会分析文本里的几十种特征。比如 AI 写的东西往往句式更工整,很少有重复的用词,逻辑链条太 “完美” 反而不自然。人类写作总会有犹豫的痕迹,比如偶尔的用词重复、句式变化,这些都是 AI 很难模仿的。Turnitin 就是抓住这些细节,给文本打出一个 “AI 生成概率分”。

最厉害的是它的 “双向检测” 能力。不仅能识别 AI 生成的内容,还能区分出 “人类写了但用 AI 润色过的文本”。这种精细度,是很多只看关键词匹配的工具比不了的。有老师反馈说,哪怕学生只让 AI 改了一段,Turnitin 也能标出来,这技术确实够硬。

📊 远超同行的准确率 —— 数据不会说谎

市面上 AI 检测工具不少,但真正敢公开准确率数据的没几个。Turnitin 去年发布的报告里说,它对 GPT-4 生成文本的识别率能达到 97%,对人类写作的误判率低于 1%。这个数据放在行业里,基本上是断层领先。

我之前见过一个第三方测试,把同一批混合了人类和 AI 生成的论文,分别用 Turnitin、Originality.ai、GPTZero 三个工具检测。结果是 Turnitin 漏检的 AI 内容最少,误判人类写作的情况也最少。尤其是处理长文本的时候,其他工具经常出现 “前半段判对、后半段错判” 的情况,Turnitin 却能保持稳定。

这背后其实是它的语料库优势。别的工具可能只盯着主流 AI 模型,Turnitin 却收集了大量不同语言、不同学科的 AI 生成样本。比如理工科的公式推导类文本,很多工具会懵,但 Turnitin 因为见过足够多的样本,就能准确识别出哪些是 AI 生成的 “标准解答”。

🔄 与 AI 生成工具的 “军备竞赛”—— 持续迭代的核心优势

AI 生成技术更新太快了,上个月刚出的 AI 模型,这个月可能就有新版本。Turnitin 厉害的地方在于,它跟得上这种速度。就像去年 GPT-4 刚发布的时候,不到两周它就更新了检测模型,而有些工具过了两个月还在说 “正在适配”。

他们有个专门的团队,每天都在跟踪最新的 AI 写作工具。不管是开源的还是闭源的,只要能生成文本,他们就会拿来研究,提取特征,更新自己的检测算法。这种 “你追我赶” 的劲头,让它始终保持在技术前沿。

更聪明的是,它不只是被动防御。Turnitin 会和 AI 生成工具的开发者保持一种微妙的互动,有时候甚至会提前拿到新模型的测试数据,这让它的检测能力总能快人一步。这种前瞻性,是很多小公司根本做不到的。

🏫 教育机构的集体选择 —— 生态整合的便利性

用过教育类软件的人都知道,系统之间的兼容性有多重要。Turnitin 早就把自己嵌入到了整个学术管理生态里。老师在批改系统里就能发起检测,学生提交作业时系统会自动弹窗提示 “已进行 AI 检测”,这种无缝衔接太省心了。

很多高校之所以认准它,还有个原因是合规性。学术数据涉及隐私,尤其是学生的作业。Turnitin 在数据安全方面拿了一堆认证,比如欧盟的 GDPR、美国的 FERPA,这让学校用起来放心。不像有些小工具,今天能用明天可能就因为数据问题被封了。

它还能生成特别详细的检测报告。不只是告诉你 “这篇有 AI 内容”,还会标出具体哪一段可疑,给出概率分析,甚至对比出可能用了哪种 AI 工具。老师拿着这份报告跟学生沟通,有理有据,说服力完全不一样。

💡 对学术诚信的深层理解 —— 不只是 “抓坏人”

Turnitin 最特别的地方,是它懂学术诚信的本质。它的 AI 检测不是为了把学生一棍子打死,而是帮助老师引导学生正确使用 AI 工具。比如报告里会区分 “少量 AI 辅助” 和 “完全 AI 生成”,给老师判断留了弹性空间。

很多教育专家都认可这种思路。现在 AI 写作已经成了趋势,完全禁止不现实。关键是教会学生怎么合理利用,比如用 AI 查资料但自己组织语言,用 AI 改语法但保持观点原创。Turnitin 的检测结果能成为这种教学的依据,这比单纯的 “检测工具” 价值高多了。

而且它一直在收集真实的教学反馈。老师觉得哪里判断不准,学生觉得哪里被误判了,都能通过后台反馈。这些数据会反过来优化它的算法,让检测越来越贴合实际教学场景。这种 “从教学中来,到教学中去” 的循环,让它越来越懂教育的需求。