🔍 先搞懂:AI 降重到底在处理什么数据?

你以为 AI 降重只是把文字改改语序换个词?其实没那么简单。这类工具处理的核心是用户上传的原始文本 —— 可能是论文、合同、甚至是包含个人信息的文档。这些数据进入系统后,第一步要经过分词和语义解析,机器得先明白每句话的核心意思,才能在不改变原意的前提下调整表达。

这里有个关键问题:你的文本会被存在哪里?多数在线工具会把数据传到云端服务器处理,少数本地部署的工具则在你的设备上直接运算。别小看这个区别,云端处理意味着数据要经过传输、存储、运算、删除这几个环节,每个环节都可能出岔子。而本地处理呢?理论上数据不会离开你的电脑,但对设备性能要求更高,现在主流工具里真正做到全本地的其实没几个。

还有个容易被忽略的点:降重过程中产生的 “中间数据”。比如机器生成的改写版本、对比原文的差异标记,这些临时文件如果没及时清理,就可能成为隐私泄露的隐患。有些平台为了优化算法,会悄悄保留这些中间数据用于训练,这在隐私政策里往往写得很隐晦,不仔细看根本发现不了。

⚠️ 风险藏在哪?数据处理的 3 个高危环节

传输阶段最容易被 “盯上”。如果平台用的是普通 HTTP 协议,你的文本在上传过程中就像裸奔,黑客很容易截获。现在正规点的工具会用 HTTPS 加密,但加密强度也有差别 —— 有的用 TLS 1.2,有的已经升级到 TLS 1.3,后者抗破解能力强得多。你可以在浏览器地址栏看一眼,锁头图标旁边显示的加密方式能说明不少问题。

存储环节的坑更多。有些平台声称 “72 小时自动删除”,但实际上可能备份到了多个服务器。去年就有个学术工具出了丑闻,说是数据定期清理,结果被扒出把用户论文存在了第三方云存储里,还忘了设访问权限。更糟的是,有些小平台为了节省成本,服务器安全配置根本不到位,防火墙跟摆设似的,很容易被攻破。

算法训练环节的猫腻最隐蔽。很多 AI 工具的改进依赖用户数据,虽然会做匿名化处理,但 “匿名” 不等于 “安全”。比如把论文里的姓名、学号删掉,但通过文本风格、研究领域这些特征,还是可能反推出作者身份。更狠的是有些平台,在用户协议里藏了一句 “授权平台永久使用上传内容用于算法优化”,等于你主动把数据送出去了。

🛡️ 真能保护隐私?主流技术手段靠谱吗?

端到端加密是目前最硬核的保护措施。简单说,你的文本在上传前就加密了,只有你的设备能解密,平台服务器拿到的只是一堆乱码。这种技术难度高,用的平台不多,但一旦用上,就算服务器被黑,黑客也拿不到有用信息。像一些付费的专业降重工具,比如 Grammarly 的高级版,就采用了类似技术。

本地计算模式正在慢慢流行。有些工具推出了桌面客户端,宣传 “数据不上云”,处理过程全在用户电脑里完成。这种模式确实从源头减少了泄露风险,但也有缺点 —— 对电脑配置要求高,而且算法更新得靠用户自己下载补丁。如果你经常处理敏感内容,这种工具值得优先考虑,就是价格可能比在线版贵不少。

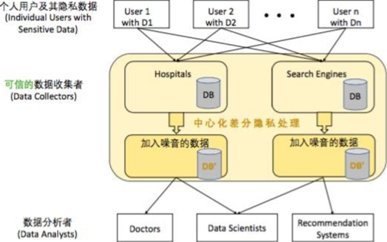

差分隐私技术听起来复杂,其实原理很简单:在处理数据时故意加入一些 “噪音”,让机器无法反推出原始信息。比如处理一篇论文时,算法会随机替换几个无关紧要的词,既不影响降重效果,又让这篇文本无法被精准识别。谷歌在某些 AI 服务里就用了这种技术,但在降重工具里还不算普及。

🕵️ 教你 3 招:判断一个 AI 降重工具安不安全

先翻隐私政策,重点看这几条:数据存储多久?会被用于什么用途?有没有共享给第三方?别嫌麻烦,真正重视隐私的平台,政策里会写得清清楚楚。比如明确说 “仅为完成降重服务临时存储,处理完毕后 24 小时内删除,不用于任何算法训练”,这种就比那些含糊其辞的靠谱。

查平台背景也很重要。大厂旗下的工具相对更可信,毕竟一旦出问题,品牌损失太大。而那些没听说过的小平台,尤其是连公司信息都查不到的,风险就比较高。你可以在天眼查之类的平台搜一下运营主体,看看有没有过数据安全相关的纠纷。

试试 “小剂量测试”。先用一篇无关紧要的文本试试水,比如一段公开的新闻稿,处理完后观察工具的行为 —— 有没有弹出奇怪的权限请求?有没有在后台偷偷上传其他文件?如果一切正常,再考虑处理重要内容。这虽然麻烦,但能帮你避开不少坑。

🚫 这些雷区千万别踩!用户最容易犯的 3 个错

别什么都往里面传。身份证号、银行卡信息、商业机密这些内容,绝对不能用在线降重工具处理。就算平台宣称再安全,也难保万无一失。之前就有企业员工图省事,把合同初稿用免费工具降重,结果核心条款被泄露给了竞争对手。

免费工具要格外小心。很多免费平台靠广告和数据变现,你用它的免费服务,可能就默许了数据被用于其他用途。天下没有免费的午餐,处理非敏感内容可以偶尔用用,但重要文本还是花钱买个安心更划算。

用完不检查缓存就关页面。有些浏览器会自动保存表单数据,就算工具删了服务器上的数据,你电脑的浏览器缓存里可能还留着副本。处理完敏感内容后,最好手动清理一下浏览器缓存和历史记录,彻底断了泄露的可能。

🔮 未来会更好吗?AI 降重的安全趋势

监管会越来越严是肯定的。现在各国对数据安全的要求都在收紧,比如欧盟的 GDPR,中国的《个人信息保护法》,都对这类工具提出了明确要求。未来不合规的平台会被逐步淘汰,剩下的会更注重隐私保护。

技术层面还有提升空间。比如联邦学习技术,多个用户的数据联合训练算法,但彼此看不到对方的原始数据,这种模式可能会在降重工具里普及。到时候既能优化算法,又不泄露隐私,算是个两全其美的办法。

用户的安全意识也在提高。以前大家用工具只看效果和速度,现在越来越多人开始关注隐私问题。这种需求变化会倒逼平台改进安全措施,毕竟谁也不想因为安全问题丢了用户。

说到底,AI 降重本身只是个技术,安全与否主要看平台怎么设计数据流程。选对工具,做好防护,既能享受技术带来的便利,又能把风险降到最低。记住,敏感内容处理,谨慎永远没错。