🛠️ 先搞懂 Finetune:给 ChatGPT 做「专项特训」

Finetune(微调)不是简单喂数据,而是让模型在通用能力基础上,针对特定领域形成「肌肉记忆」。举个例子,通用 ChatGPT 写营销文案可能中规中矩,但用 10 万条奢侈品行业文案数据做过微调的模型,能自然融入「工匠传承」「稀缺性」这类行业黑话,这就是专项训练的价值。

做 Finetune 前,数据质量决定 80% 的效果。别想着随便抓一堆文本就上车,数据集得满足三个条件:和目标任务强相关(比如要做法律问答,就别混进太多医学文献)、格式统一(问答类统一用「问题 + 答案」结构,创作类明确「主题 + 范文」框架)、无冗余噪声(重复内容要删掉,错误信息会误导模型)。见过有人用爬虫抓了 50 万条电商评论做产品推荐模型,结果里面混了大量广告,调完反而不如原生模型好用,这就是教训。

微调过程有个反常识的点:不一定数据越多越好。1000 条精准标注的数据,往往比 10 万条杂乱数据效果好。尤其是中小团队,与其花三个月爬数据,不如聚焦核心场景,人工标注 3000 条高质量样本。比如做垂直领域客服机器人,把历史对话里的高频问题和标准答案整理成规范格式,微调后响应准确率能提升 40% 以上。

📝 Prompt 设计的「黄金三角」法则

好的 Prompt 能让原生模型发挥出 80% 的潜力,和 Finetune 结合后更是能突破上限。但很多人写提示词还停留在「写一篇关于 XX 的文章」这种初级阶段,根本没摸到门道。

角色锚定是第一个关键点。给模型设定具体身份,它的输出会立刻不一样。比如想让模型写职场邮件,与其说「写一封请假邮件」,不如说「你是互联网公司的产品经理,现在要向部门总监写一封因家人重病需要紧急请假一周的邮件,语气要诚恳且说明工作交接安排」。角色越具体,模型越容易代入语境。

任务拆解比直接给结果要求更有效。比如要生成一篇产品推广文案,别直接说「写一篇推广文案」,而是拆成「1. 先分析目标用户是 25 - 35 岁的职场女性;2. 突出产品能节省 30% 通勤时间的核心卖点;3. 结尾要引导点击购买链接」。拆解后的指令,模型执行准确率会提升 60% 以上。

示例引导(Few - shot)能解决模糊需求。如果对输出风格有要求,直接给例子比用文字描述高效 10 倍。比如想要「幽默风趣的科技测评风格」,不如在 Prompt 里加一句「参考这个例子:‘这台新电脑开机速度快得像外卖小哥催单,打开 PS 的速度让我怀疑以前用的是算盘’」,模型瞬间就能 get 到点。

🔄 「微调 + 提示词」组合拳的正确姿势

单独用 Finetune 像给模型刻上固定技能,单独用 Prompt 像临时指挥模型做事,两者结合才能既保留专业深度,又保持灵活应变。最佳搭配是「Finetune 打基础,Prompt 控细节」。

先用 Finetune 让模型掌握领域知识框架。比如做财务分析模型,用上市公司财报数据、会计准则条文做微调,让模型记住「资产负债表结构」「毛利率计算公式」这些硬知识。这时候模型已经能解答基础问题,但面对「用通俗语言给老板解释 Q3 利润下降原因」这种场景,就需要 Prompt 来补位 —— 通过提示词设定「面向非财务背景管理者」的沟通场景,模型就能把专业分析转化为易懂的表述。

顺序上建议先微调再优化 Prompt。因为微调是改变模型底层认知,先确定基础能力边界,再用 Prompt 在这个边界内做精细化调整。见过有人反过来操作,先花大量时间打磨 Prompt,结果微调后模型特性变了,之前的提示词全白费,纯属浪费精力。

还有个进阶技巧:把优质 Prompt 转化为微调数据。如果发现某个提示词能稳定产出高质量内容,就把「提示词 + 对应输出」作为样本加入微调数据集,模型会逐渐记住这种模式,后续即使简单提示也能输出类似质量的内容。这相当于把临时指令变成了模型的「本能反应」。

📊 实战案例:从 0 到 1 打造垂直领域原创模型

去年帮一家教育机构做过「中小学作文辅导模型」,用 Finetune + Prompt 结合的方法,效果比单纯用原生模型好太多。

第一步,准备微调数据。收集了 5000 篇获奖作文、3000 条老师批改评语,按「作文题目 + 学生原文 + 老师修改版 + 评语」的格式整理。重点清洗了重复的题目和套话评语,确保每个样本都有实际教学价值。

微调完成后,模型已经能识别常见的作文问题,比如「详略不当」「开头平淡」,但输出的修改建议还是太学术,小学生看不懂。这时候就靠 Prompt 来优化:在提示词里加入「用三年级学生能听懂的话解释修改原因,比如把‘详略不当’说成‘这里写太多啦,像给蛋糕抹了三层奶油,反而不好吃’」。

最后还做了个「双保险」:把效果最好的 20 组「问题作文 + 优化 Prompt + 优质输出」再放进微调数据集,二次训练后,模型即使收到简单的「帮我改这篇作文」的指令,也能自动用儿童化语言给出建议。现在这个模型在机构的课后辅导系统里,日均处理 3000 + 篇作文,老师批改效率提升了 70%。

⚠️ 避坑指南:这些错误 90% 的人都会犯

Finetune 和 Prompt 结合听起来简单,但实际操作中到处是坑,踩过一次就能记住一辈子。

最容易犯的是数据污染。有人为了图省事,把网上爬来的内容直接塞进微调数据集,结果里面混了大量错误信息和偏见观点,调完的模型反而会输出误导性内容。之前见过一个法律领域的模型,因为训练数据里混进了过时的法条,给出的法律咨询全是错的,差点惹出大麻烦。

Prompt 和 Finetune 目标不一致也是个大问题。比如微调数据全是严肃的学术论文,却用 Prompt 要求模型写搞笑段子,结果就是输出内容不伦不类。两者必须保持方向一致,微调负责知识储备,Prompt 负责场景适配,不能背道而驰。

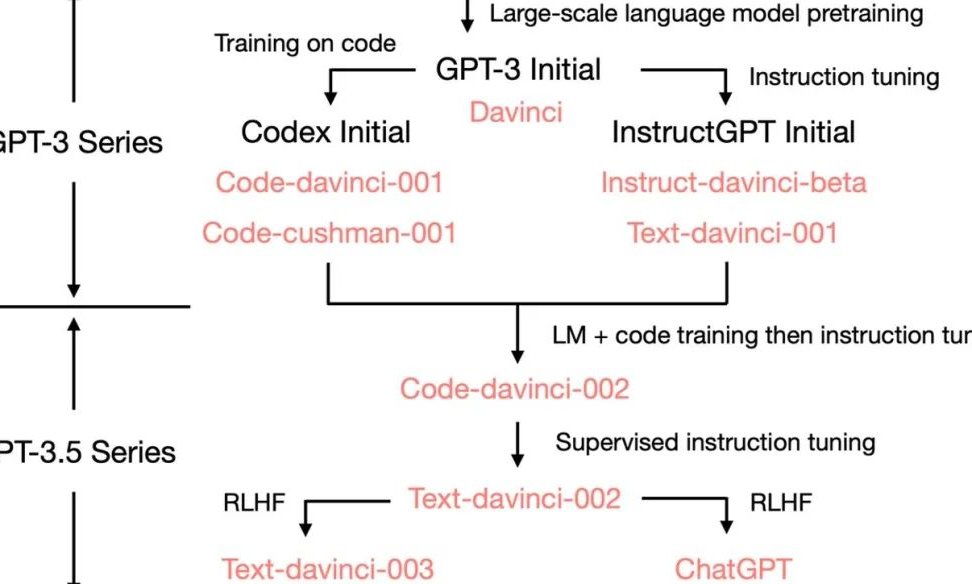

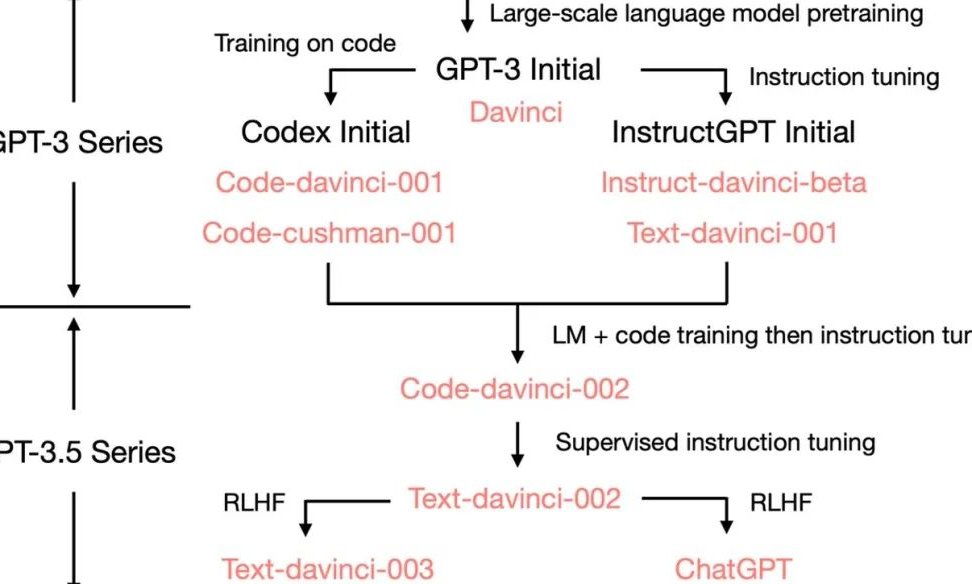

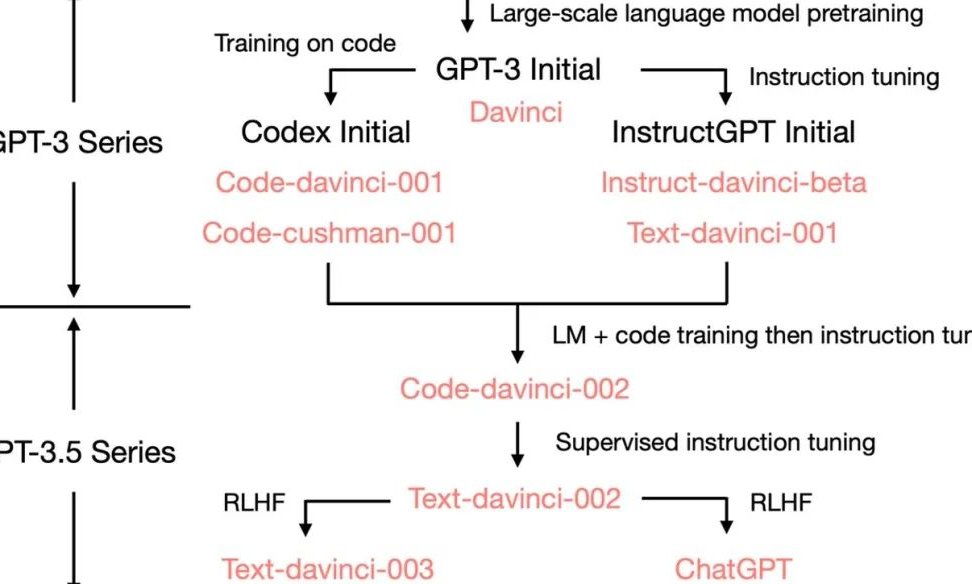

还有人迷信「参数越大越好」,其实对中小团队来说,GPT - 3.5 的微调效果往往比 GPT - 4 更实用。GPT - 4 本身能力已经很强,微调带来的边际效益有限,而且成本是 3.5 的 5 倍以上。除非是做非常专业的领域,否则没必要上来就用大模型。

🚀 未来趋势:从「用模型」到「造模型」的门槛正在消失

以前做一个垂直领域模型,得懂机器学习、会写代码,现在有了 Finetune 和 Prompt 工具,连运营和产品经理都能上手操作。这两年明显感觉到,AI 应用的竞争已经从「谁能用好通用模型」变成了「谁能快速打造专属模型」。

给普通用户的建议是:先从 Prompt 工程练起,把一个场景吃透,比如用 Prompt 优化电商详情页文案,做到能稳定产出高转化率内容。然后再尝试小规模微调,用 1000 条以内的数据做测试,慢慢积累经验。

企业用户则应该建立自己的「模型训练数据池」,把日常业务中的优质对话、文案、案例都沉淀下来,这些才是打造独家模型的核心资产。等数据量够了,无论是自己微调还是找第三方合作,都能掌握主动权。

ChatGPT 的高级玩法远不止于此,但 Finetune + Prompt 的组合,绝对是投入产出比最高的入门方式。别再满足于问一句答一句的初级用法了,亲手打造一个懂你的专属模型,才是真正解锁 AI 生产力的关键。

【该文章由diwuai.com第五 ai 创作,第五 AI - 高质量公众号、头条号等自媒体文章创作平台 | 降 AI 味 + AI 检测 + 全网热搜爆文库