大模型生成内容的过程,其实和人类写作有本质区别。很多人以为 AI 在 "思考",实际上它更像个超级拼图玩家 —— 用训练过的数十亿参数,根据你给的提示词(Prompt),从海量文本碎片里拼出最可能的答案。这背后的核心逻辑,是概率预测而非逻辑推理。

就拿常见的 ChatGPT 来说,当你输入 "写一篇关于春天的短文",它不会像人类那样回忆经历过的春天。它做的是快速检索训练库里所有和 "春天" 相关的文本,计算每个词出现的概率,然后按顺序拼接。比如 "春天" 后面接 "来了" 的概率是 37%,接 "的脚步" 是 22%,最终选概率最高的组合。这种机制决定了它天生就有重复的倾向 —— 毕竟高频出现的搭配,总是更容易被优先选中。

更有意思的是,大模型没有 "记忆" 概念。每次生成内容都是全新计算,看似连贯的长文本,其实是一句句 "摸着石头过河" 拼出来的。前半句用了 "鸟语花香",后半句可能因为概率叠加,不知不觉又用了类似意境的词。这就是为什么你经常会发现,同个主题多生成几次,总会有似曾相识的句子反复出现。

为什么大模型总爱说车轱辘话?深层原因藏在三个环节里。

训练数据的 "马太效应" 影响最大。互联网上重复出现的内容,比如 "创业要坚持" 这类鸡汤,在训练库里的权重会被放大。模型会默认这些是 "安全答案",遇到相关主题就优先调用。你让它写 "如何提高效率",十有八九会出现 "制定计划"" 拒绝拖延 " 这类高频短语,就像人说话时总会不自觉用上口头禅。

模型的 "安全机制" 也在推波助澜。为了避免输出违规内容,开发者给大模型加了很多限制。遇到敏感或模糊的问题,它会自动切换到 "保险模式",用通用化的表达来回避。比如问 "某产品好不好",如果训练数据里评价两极,它很可能说 "各有优劣,需根据需求选择"—— 这种万能句式用多了,自然显得重复。

还有个容易被忽略的点:参数规模和创造力的矛盾。模型参数越多,处理复杂任务的能力越强,但也越容易陷入 "平均化陷阱"。就像班级里的中等生,回答问题总往标准答案靠,不敢冒险。你让 1000 亿参数的模型写故事,它更倾向于用大众熟悉的叙事结构,而不是剑走偏锋的创意 —— 这就是为什么有时候小模型反而能写出更独特的句子。

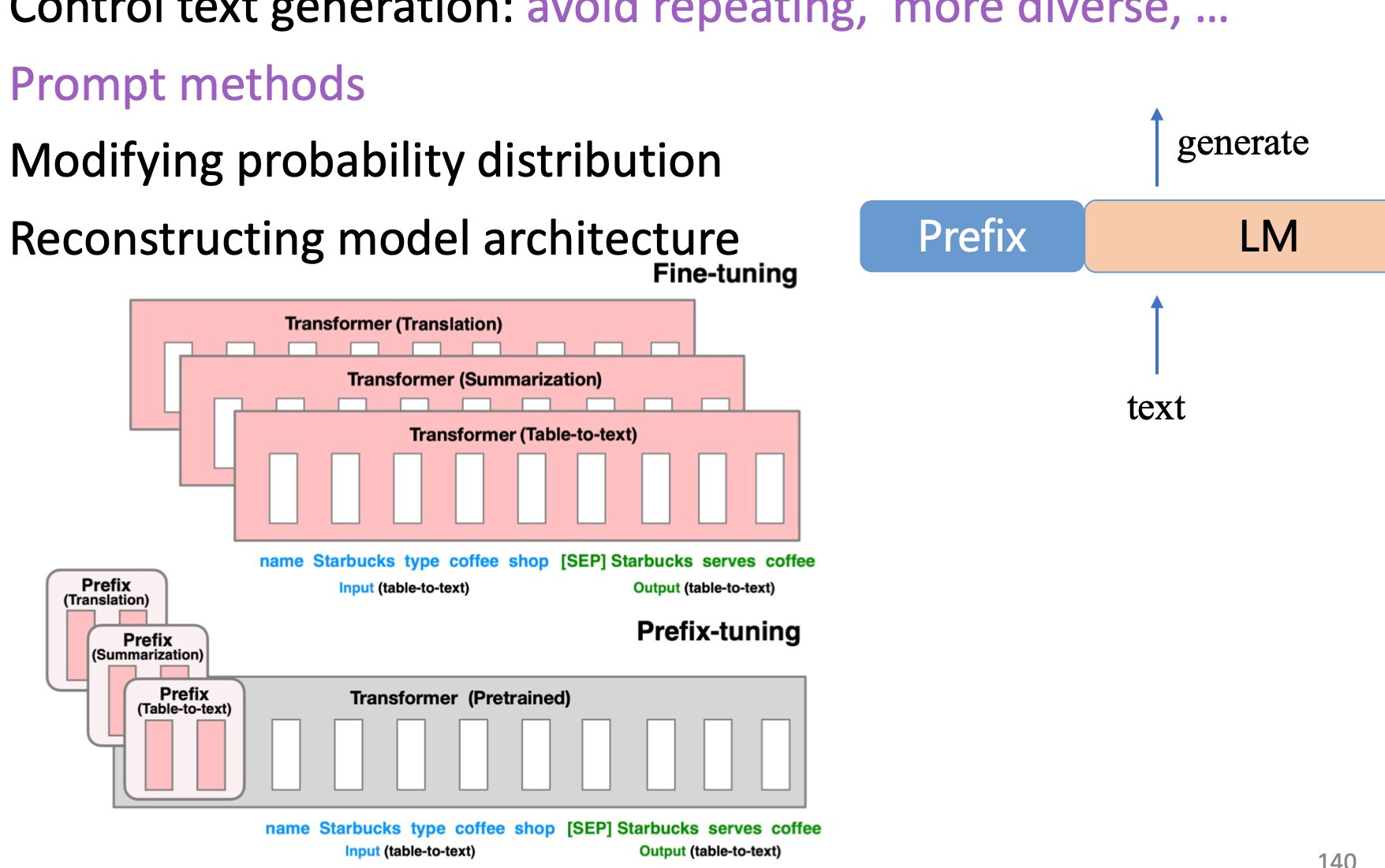

Prompt 工程,简单说就是给 AI 画路线图的技术。不是随便丢个问题就完事,而是通过精心设计提示词,引导模型避开重复陷阱,产出更独特的内容。这就像给导游明确要求:"不要带我们去常规景点,找三个本地人常去的小巷子,每个地方讲个老故事"—— 目标越具体,结果越可能超出预期。

它的核心作用体现在两个层面。表层是约束输出范围,比如限定 "用武侠小说风格写产品测评",模型就会自动规避常见的营销话术。深层是激活特定参数,大模型里藏着很多 "冷门知识",但默认状态下不会启用。精准的 Prompt 能像钥匙一样,打开这些被尘封的参数模块。比如问 "用 17 世纪航海日志的语气写篇旅游攻略",就能激活模型里关于古英语表达和航海术语的参数组合。

做 Prompt 工程时,有个反常识的技巧:少用抽象词,多用具体约束。比如想让模型写一篇关于咖啡的文章,与其说 "写得有创意点",不如说 "以咖啡师的视角,描述三款冷门豆子的烘焙差异,要提到其中一款带有蓝莓发酵的味道"。后者给出的细节越多,模型调用重复短语的概率就越低。

做 Prompt 工程,就像给 AI 设定角色和剧本,几个关键技巧能让内容重复率降一半。

角色绑定法特别好用。给模型指定一个具体身份,比如 "十年经验的汽修工""19 世纪的探险家 ",它会自动调用该角色对应的语言体系。试过让模型以" 民国小报记者 " 的身份写科技新闻吗?出来的文字带着电报体的简洁和市井气,和默认的说明文风格截然不同。角色越具体,用词越可能跳出常规套路。

输出格式约束也很关键。很多人忽略了格式对内容的影响。比如让模型写产品卖点,与其说 "列出五个优点",不如说 "用 ' 痛点 + 解决方案 ' 的结构,每个卖点前加 emoji,最后加一句用户吐槽的反话"。这种结构化要求会迫使模型调动更多参数组合,减少对现成模板的依赖。

加入时间 / 场景锚点能显著提升独特性。比如写关于 "阅读" 的内容,加上 "2008 年夏天在图书馆躲雨时读的那本书" 这样的具体场景,模型就很难套用通用句子。时间和场景细节会像钩子一样,勾出训练数据里那些不常被调用的小众表达。

还有个进阶操作:反向提示。故意告诉模型 "不要用以下词汇:高效、便捷、智能",它会主动避开这些高频词,逼出更有新意的表达。但要注意别列太多禁忌词,否则模型会陷入混乱,反而生成更简单的句子。

Prompt 工程不是一次性工作,需要像调相机焦距一样反复优化。

先做 "最小可行性测试"。写一个基础版本的提示词,让模型生成内容后,标记出重复出现的短语。比如发现总出现 "综上所述",下次就加一句 "结尾不用总结性短语"。这种针对性调整比盲目修改效率高得多。

学会拆解需求层次。比如想让模型写一篇关于 "职场沟通" 的文章,不要直接丢主题,而是拆成:目标读者是 "刚入职的实习生",核心场景是 "和跨部门同事对接工作",要解决的问题是 "避免信息传递偏差",最后加一个风格要求 "用三个职场段子穿插其中"。层次越细,模型的输出就越难和别人重复。

动态调整参数权重也很重要。现在很多平台允许调整 "温度值"(temperature),数值越高,输出越随机;越低则越稳定。写严谨内容时调低温度,避免胡言乱语;想创新时调高温度,再配合精准提示,能平衡独特性和准确性。试过把温度调到 0.8,同时要求 "用植物生长的比喻讲数据分析",出来的内容确实让人眼前一亮。

还要注意避免过度引导。有些人为了追求独特,把提示词写得像论文大纲,反而限制了模型的发挥。好的 Prompt 应该像放风筝 —— 给出方向,但留足飞翔的空间。比如 "写一段关于深夜食堂的文字,要有食物的温度和陌生人的故事,不用超过 300 字",这种既有框架又有弹性的要求,往往能产出惊喜。

未来的 Prompt 工程会越来越简单,但核心逻辑不会变 ——理解模型的 "思维方式",用它能听懂的语言提要求。

现在已经出现不少 Prompt 生成工具,能自动分析你的需求并优化提示词。但这些工具只能处理常规场景,遇到复杂需求还是得靠人工调整。就像翻译软件再强,文学翻译依然需要人来把握语感。

大模型在进化,Prompt 工程的技巧也得跟着升级。下一代模型可能会有更强的 "抗重复" 机制,但这不代表不需要提示词优化。反而会要求更精细的引导 —— 比如让模型 "用量子物理的概念类比爱情,要包含三个公式的隐喻",这种高难度组合依然需要人类来设计。

普通人其实不用学太复杂的技巧,记住一个核心原则就行:把抽象需求变成具体问题。与其说 "写一篇好文章",不如说 "写给刚失恋的朋友,劝她振作但不要说教,要提到你们小时候爬树摔下来的事"。越具体的私人化需求,越难被模型用套路应付。

说到底,Prompt 工程的本质不是 "控制 AI",而是和 AI 合作。理解它的局限,善用它的优势,才能既避免重复,又发挥出大模型的创造力。这就像和一个记忆超群但不善表达的朋友聊天 —— 你问得越清楚,它才能说得越精彩。

【该文章由diwuai.com第五 ai 创作,第五 AI - 高质量公众号、头条号等自媒体文章创作平台 | 降 AI 味 + AI 检测 + 全网热搜爆文库🔗立即免费注册 开始体验工具箱 - 朱雀 AI 味降低到 0%- 降 AI 去 AI 味】