🧠 从底层逻辑颠覆:不只是 “特征匹配”,而是 “思维模拟”

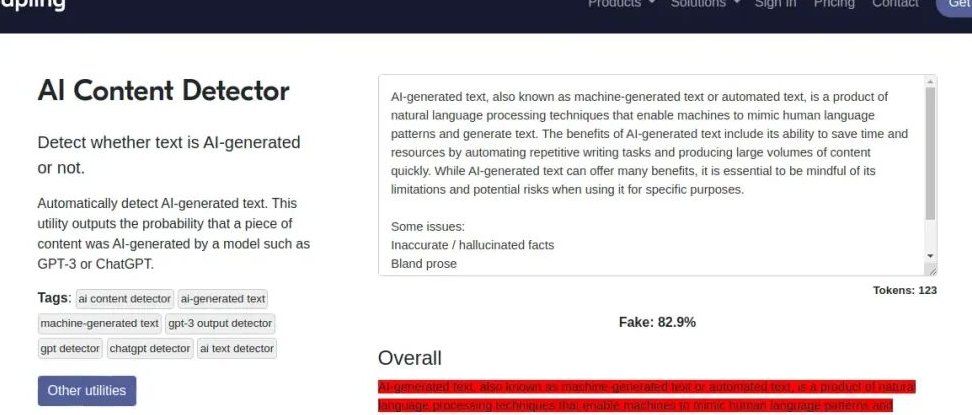

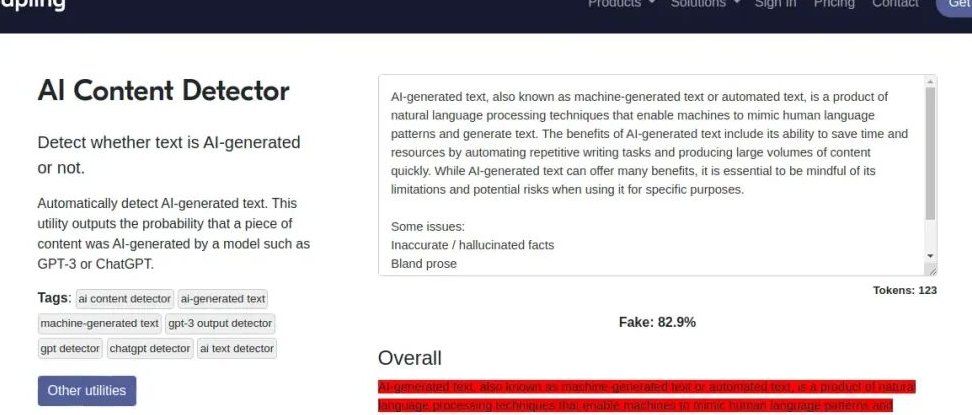

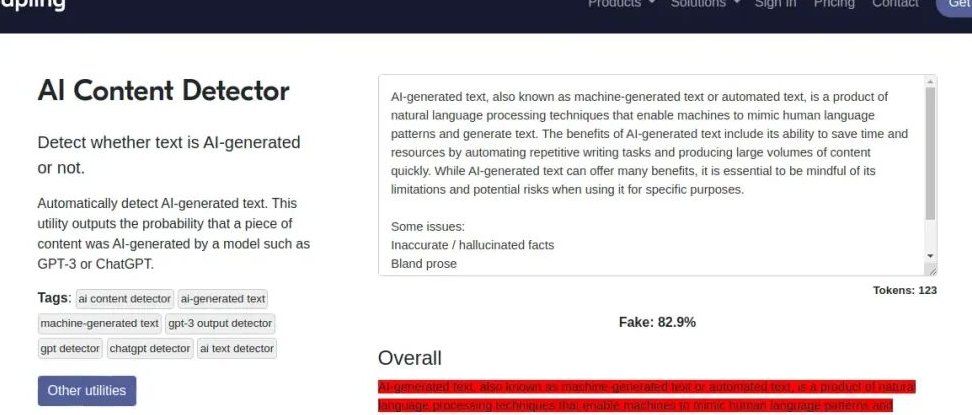

市面上绝大多数 AI 检测工具还停留在 “关键词比对 + 句式分析” 的初级阶段。比如看到 “首先其次最后” 的固定结构就标红,发现高频重复的学术词汇就判定为 AI 生成。这种方法对付早期 GPT-3.5 还能凑合用,遇到现在的 GPT-4 或者 Claude 3,基本就成了摆设。

第五 AI 的 “真实性检测” 完全换了赛道。它不是找 “AI 写了什么”,而是看 “写作时的思维轨迹像不像人类”。系统会模拟人类写作时的犹豫、修正、联想过程 —— 比如人类写观点时会先铺垫背景,举例子时会突然插入个人经历,甚至偶尔出现逻辑跳跃。这些 “不完美” 恰恰是 AI 很难模仿的生物特征。

举个实际案例,某自媒体团队用 ChatGPT 写了一篇旅游攻略,刻意规避了所有已知的 AI 特征词。用某知名检测工具查显示 “98% 人类概率”,但第五 AI 直接标出了三个可疑点:景点描述的顺序完全按照百度百科的词条结构(人类更可能按游玩路线);推荐餐厅时突然插入一段与主题无关的营养学知识(AI 常出现的信息堆砌);结尾总结用了过于工整的排比句(人类很少这么 “刻意”)。后来团队承认,确实是让 AI 先写框架再手动修改的。

🔄 实时动态库:跟得上 AI 进化的 “活检测”

现在的 AI 生成技术更新太快了。上周刚总结出 “AI 不会用方言俚语”,这周就有模型能生成带地方口音的对话;这边发现 “AI 写情感文缺乏细节”,那边新模型已经能模拟哭腔语气。

普通检测工具的数据库往往是按月更新,相当于用上个月的 “通缉令” 抓这个月的 “新罪犯”。第五 AI 搞了个 “实时动态学习系统”,每天爬取全网公开的 AI 生成内容样本 —— 包括各大模型的 API 调用结果、暗网流传的微调模型输出、甚至是用户用第五 AI 检测后确认的 AI 文本。这些数据会在 2 小时内纳入检测体系,形成 “生成端 - 检测端” 的实时对抗。

有个做学术不端检测的机构反馈,他们之前用的工具对 2024 年后的 AI 论文几乎失效,因为新模型学会了模仿人类的引用错误和格式疏漏。换成第五 AI 后,哪怕是用最新开源模型生成的 “伪原创” 论文,也能被揪出 “参考文献列表的排序逻辑不符合人类阅读习惯” 这类深层问题。

🎯 场景化适配:不搞 “一刀切” 的精准打击

不同场景下的 AI 检测需求天差地别。给老师用的论文检测,需要严格区分 “AI 代写” 和 “AI 辅助校对”;给自媒体用的,更关注 “是否用 AI 批量生成水文”;给企业用的合同检测,则要警惕 “AI 生成条款中的隐藏风险”。

第五 AI 把场景拆成了 12 个细分领域,每个领域都有专属的检测模型。比如检测小说时,会重点分析 “人物对话的情绪连贯性”(AI 容易写出前后性格矛盾的对话);检测法律文书时,会排查 “条款表述的模糊地带”(AI 常回避精确责任划分);检测短视频脚本时,会留意 “梗的时效性”(AI 对三个月内的新梗理解很弱)。

某 MCN 机构的实测很能说明问题。他们用同一篇美妆测评文,分别选择 “自媒体文案” 和 “学术论文” 两个场景检测。在 “自媒体场景” 下,第五 AI 提示 “可能使用 AI 生成,理由:产品成分描述过于模板化,缺乏个人使用后的皮肤反应细节”;切换到 “学术场景”,则显示 “人类写作概率高,符合科普文的表述逻辑”。这种灵活性是其他工具做不到的。

📊 不只是 “判对错”,还给 “改的方向”

大部分检测工具的终点是出一个 “AI 概率值”,至于为什么判定、怎么修改,全靠用户自己猜。第五 AI 把检测变成了 “诊断 - 治疗” 的闭环。

它的检测报告里有个 “人类特征修复建议” 板块。比如检测出某段文字 “逻辑过于线性”,会具体指出 “第三句可以插入一个反例,比如‘虽然这种方法有效,但我曾经在 XX 情况中遇到过例外’”;发现 “情感表达单薄”,会建议 “加入感官细节,比如‘当时办公室的空调坏了,汗顺着后背流下来,更让我烦躁的是……’”。

某高校中文系的老师反馈,他们让学生用 AI 写读后感再修改,用普通工具只能查出 “改得不够”,但用第五 AI 能明确告诉学生 “哪里改得还像 AI”。有个学生三次修改后,AI 概率从 85% 降到 12%,关键是写作水平真的提升了 —— 因为系统教会了他 “人类是怎么思考和表达的”。

🛡️ 对抗 “反检测”:让 AI 也过不了的 “火眼金睛”

现在网上流传着各种 “AI 内容避检测技巧”:把文本扔进翻译软件转几轮、故意加错别字再修正、用特定句式打乱结构。这些手段对付普通检测工具确实有效,但在第五 AI 面前基本失效。

比如 “翻译转写” 的文本,第五 AI 会识别出 “词汇搭配异常”—— 比如把 “吃食堂” 翻译成英语再转回来,可能变成 “在食堂进食”,这种书面化表达在口语场景中就很可疑。对于 “故意加错字”,系统会分析 “错误的分布规律”—— 人类写错字往往集中在笔画多的词,且修改痕迹有连贯性,而 AI 生成的错误更像是随机分布。

某 SEO 工作室做过测试,用 5 种主流反检测技巧处理同一篇 AI 文案,用其他工具检测均显示 “人类概率> 90%”,但第五 AI 全部识别为 “高风险 AI 生成”,并准确标出了哪些地方用了哪种反检测手法。这意味着,只要内容本质是 AI 生成的,不管怎么 “伪装”,都逃不过它的眼睛。

🌐 行业底层价值:重建内容信任体系

现在的互联网内容生态有点乱。读者怕被骗(“这篇养生文是不是 AI 瞎编的?”),平台怕担责(“推荐了 AI 生成的虚假新闻怎么办?”),创作者怕被冤枉(“我辛辛苦苦写的,怎么被当成 AI 了?”)。

第五 AI 的 “真实性检测” 其实在做一件更基础的事:重新定义 “内容可信度” 的标准。它不只是给内容贴标签,而是通过大量的数据积累,告诉整个行业 “什么样的内容更可能是可信的人类创作”。

比如它发现,真正的人类原创内容中,“第一人称叙事” 出现的频率是 AI 生成内容的 3.2 倍;包含 “具体时间、地点、人物” 的细节描述,可信度比泛泛而谈高 78%;存在 “明确的观点冲突”(比如先肯定再否定)的内容,人类创作概率超过 90%。这些发现正在被一些内容平台纳入推荐算法,让真正的优质原创获得更多流量。

某知识付费平台接入第五 AI 后,课程文案的用户信任度提升了 40%。因为他们在课程详情页标注了 “经第五 AI 真实性检测,本文人类创作概率 97%”。学员说,看到这个标识,会觉得 “背后是真人在认真做内容,不是随便用 AI 凑数的”。

【该文章由diwuai.com第五 ai 创作,第五 AI - 高质量公众号、头条号等自媒体文章创作平台 | 降 AI 味 + AI 检测 + 全网热搜爆文库