🤖 为什么 AI 生成内容容易触发查重警报?

很多人用 AI 写东西,最后查重率高得吓人。这事儿不怪你操作有问题,得从 AI 的工作原理说起。现在的大语言模型,本质上是在海量文本数据里找规律。你输入一个需求,它就从训练库里扒拉相似的表达,重新排列组合。就像你让两个人写同一主题,读过的书差不多,写出来的句子难免撞车。

更麻烦的是,同一个 AI 模型生成的内容,重复率会更高。比如你和同事都用 ChatGPT 写 "新媒体运营技巧",模型可能会反复用 "用户画像"、"转化率优化" 这些词,句式结构也大同小异。查重系统一比对,很容易判定为相似内容。

还有个容易被忽略的点:AI 生成的内容缺乏 "个性化表达"。人写东西会带口头禅、独特的比喻,甚至偶尔的笔误。这些看似不完美的细节,恰恰是区分原创性的重要标志。AI 写出来的东西太 "标准",反而显得千篇一律。

🔍 查重系统如何识别 AI 生成的重复内容?

现在的查重工具早就不是简单比关键词了。像知网、Turnitin 这些主流系统,用的是 "语义指纹" 技术。它会把文本拆成无数个语义单元,再和数据库里的内容做比对。哪怕你改了几个词,只要核心意思和结构没变,照样能查出来。

AI 生成的内容有个明显特征:句式结构的规律性。比如描述因果关系时,总爱用 "由于... 因此...";举例子时频繁出现 "例如..."。这些固定模式会被查重系统标记为 "高风险特征",尤其当多篇 AI 内容都出现类似模式时,重复率会飙升。

还有个新趋势,现在有些查重工具开始专门针对 AI 生成内容优化算法。比如 GPTZero,它能通过分析文本的 "熵值" 判断是否为 AI 创作。人类写的东西熵值更高,也就是更混乱、更不可预测。AI 写的则更规整,熵值低,一测一个准。

✍️ 手动优化:降低 AI 内容重复度的核心技巧

拿到 AI 初稿后,先别急着用。第一步是逐句读,遇到觉得 "眼熟" 的表达立刻改写。比如 AI 写 "随着互联网的发展",你可以改成 "这些年互联网跑得飞快",既保留意思,又加入口语化表达。

改变叙事视角是个好办法。如果 AI 用第三人称 "企业应该怎么做",你可以换成第一人称 "我们试过这么做,效果是..."。加入个人经验或案例,既能降低重复率,又能增加内容价值。

长句拆短句,短句扩长句。AI 特别爱写复杂长句,比如 "在当前市场环境下,企业若想实现可持续发展,就必须重视用户需求的变化并及时调整策略"。你可以拆成 "现在市场变快了。企业想活得久,得盯着用户需求。变了就得赶紧调策略,不然容易掉队。"

多加入具体数据和案例。AI 生成的内容经常泛泛而谈,你可以补充 "去年我们做过一次测试,转化率提升了 23%" 这类具体信息。真实数据不仅能降低重复度,还能增强说服力。

🛠️ 辅助工具:这些神器能帮你搞定重复率问题

Paraphrase Tool 这类改写工具可以用,但别全信。它能帮你替换同义词、调整句式,但改完一定要自己读一遍。我试过用它处理 500 字的 AI 内容,直接用的话重复率能降 30%,但有些地方改得不通顺,还得手动调整。

Grammarly 的 "改写句子" 功能值得试试。它比普通改写工具更懂语境,能在保持原意的前提下优化表达。尤其适合处理那些 AI 写得太书面化的句子,改完会更自然。

原创度检测工具要备一个。比如 Copyscape,能帮你查出内容和哪些已发布文章相似。重点看相似度超过 80% 的段落,这些是必须修改的高危区域。记住,检测只是辅助,最终还是得靠自己判断。

还有个小技巧,把 AI 生成的内容放进不同的翻译工具里转几圈。比如中译英再英译中,机器翻译的误差会自然产生新的表达方式。但这招不能多用,用多了容易让内容变味,适合局部处理。

📝 内容重构:让 AI 文字真正 "为我所用" 的实战方法

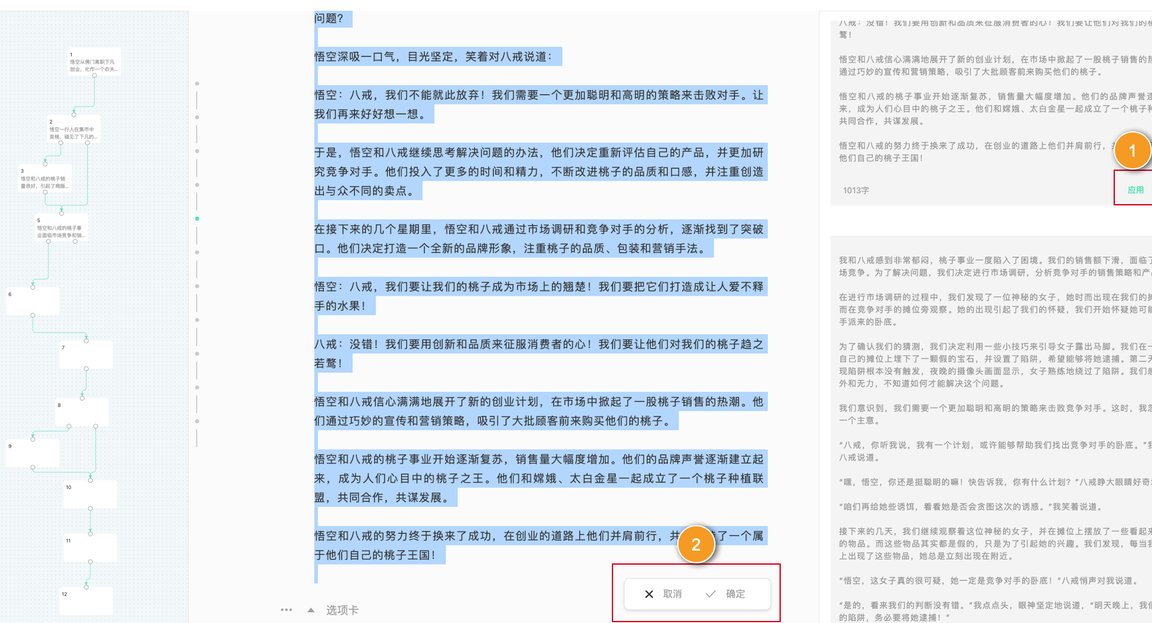

先把 AI 生成的内容拆成几个核心观点,像搭积木一样打乱顺序。比如原来的结构是 "定义 - 原因 - 解决办法",你可以改成 "解决办法 - 原因 - 定义"。逻辑顺序一变,整体感觉就不一样了。

加入个人经历和观点是关键。读 AI 写的 "用户留存的三个方法",你可以在每个方法后面加一句自己的实践:"这个方法我们试过,在 30 岁以下用户群体里效果特别好,但对 50 岁以上用户作用不大"。这样既降低重复率,又让内容有独特价值。

用自己的话重新解释专业概念。AI 经常会用行业黑话,比如 "私域流量池构建",你可以换成 "把客户拉进微信群,经常互动着"。用大白话解释专业词,既能降低重复度,又能让内容更易懂。

适当加入反问和互动。比如在段落结尾加一句 "你们有没有遇到过这种情况?",或者 "这一步操作起来可能有点麻烦,不知道你们有什么好办法?"。这种互动性的表达很少出现在纯 AI 生成内容里,能有效降低重复率。

🚫 这些误区会让你的重复率越来越高

只改关键词不改结构是最常见的错误。比如把 "提高转化率" 改成 "提升转化效率",看着换了词,其实句子结构没变,查重系统照样能认出来。记住,改词的同时一定要调整句式。

过度依赖改写工具也不行。有些人为了省事儿,直接把 AI 内容扔进改写工具,一键生成就用。但现在很多查重系统已经能识别这种 "机器改写" 的文本,结果可能更糟。工具只是辅助,最终还得靠人来把控。

不检查上下文连贯性也是个大坑。有些人改完一段就不管了,导致前后文衔接生硬。比如前一段说 "这个方法不好",下一段突然说 "这个方法的优点是...",这种逻辑断层很容易被看出是修改过的,而且可能让重复率计算出现偏差。

忽视查重系统的数据库更新。不同的查重系统数据库不一样,今天查重复率低,不代表明天也低。最好的办法是,重要内容多在几个不同的查重工具里测一测,确保都没问题再用。

最后想多说一句,降低重复率不是目的,写出有价值的内容才是。AI 只是个工具,真正让内容独一无二的,是你的经验、思考和独特视角。与其纠结怎么改才能通过查重,不如多想想怎么让内容对读者更有用。毕竟,读者不会因为你的内容重复率低而点赞,只会因为内容有价值而收藏。