📊 优质数据源:AI 生成内容的 “原材料” 质量决定上限

提到 AI 生成文章,很多人第一反应是算法多厉害。但行内人都清楚,数据源才是真正的 “地基”。就像做菜,再好的厨艺,碰到不新鲜的食材也白搭。AI 模型训练用的数据集,直接决定了它能生成内容的天花板。

优质数据源首先得保证 “杂”。你想啊,AI 要写科技文章,也得能写情感散文,还得会编故事,这就要求数据里既有学术论文、新闻报道,也得有小说、论坛帖子。单一类型的数据喂出来的模型,写东西跟复读机似的,翻来覆去就那几种腔调。现在头部模型都在拼命扩充数据类型,从文字到图片、音频的多模态数据都往里塞,就是为了让生成的内容更立体。

然后是 “新”。去年的热点事件,今年 AI 还在用旧数据解读,读者一看就觉得过时。某测评机构做过实验,用 2021 年数据训练的模型,写 2023 年的新能源汽车文章,居然还在提早已停产的车型。这就是数据时效性的锅。现在好的 AI 平台都会建立动态更新机制,每月甚至每周补充最新数据,保证模型 “知道” 最近发生了什么。

更关键的是 “真”。数据里掺了太多垃圾信息,比如重复内容、错误事实、偏见言论,AI 学了这些,生成的东西能靠谱吗?有次看到某 AI 写的历史文章,把朝代年份都搞混了,查了才知道,它训练数据里混进了不少错误的自媒体文章。所以正规平台都会花大功夫做数据清洗,人工审核加机器过滤,就为了把这些 “毒瘤” 清出去。

💻 先进算法:让数据 “活起来” 的核心引擎

有了好材料,还得有好厨艺。算法就是 AI 的 “烹饪技巧”。同样一批数据,不同算法处理出来的结果天差地别。现在最火的大语言模型,本质上都是在玩算法的迭代。

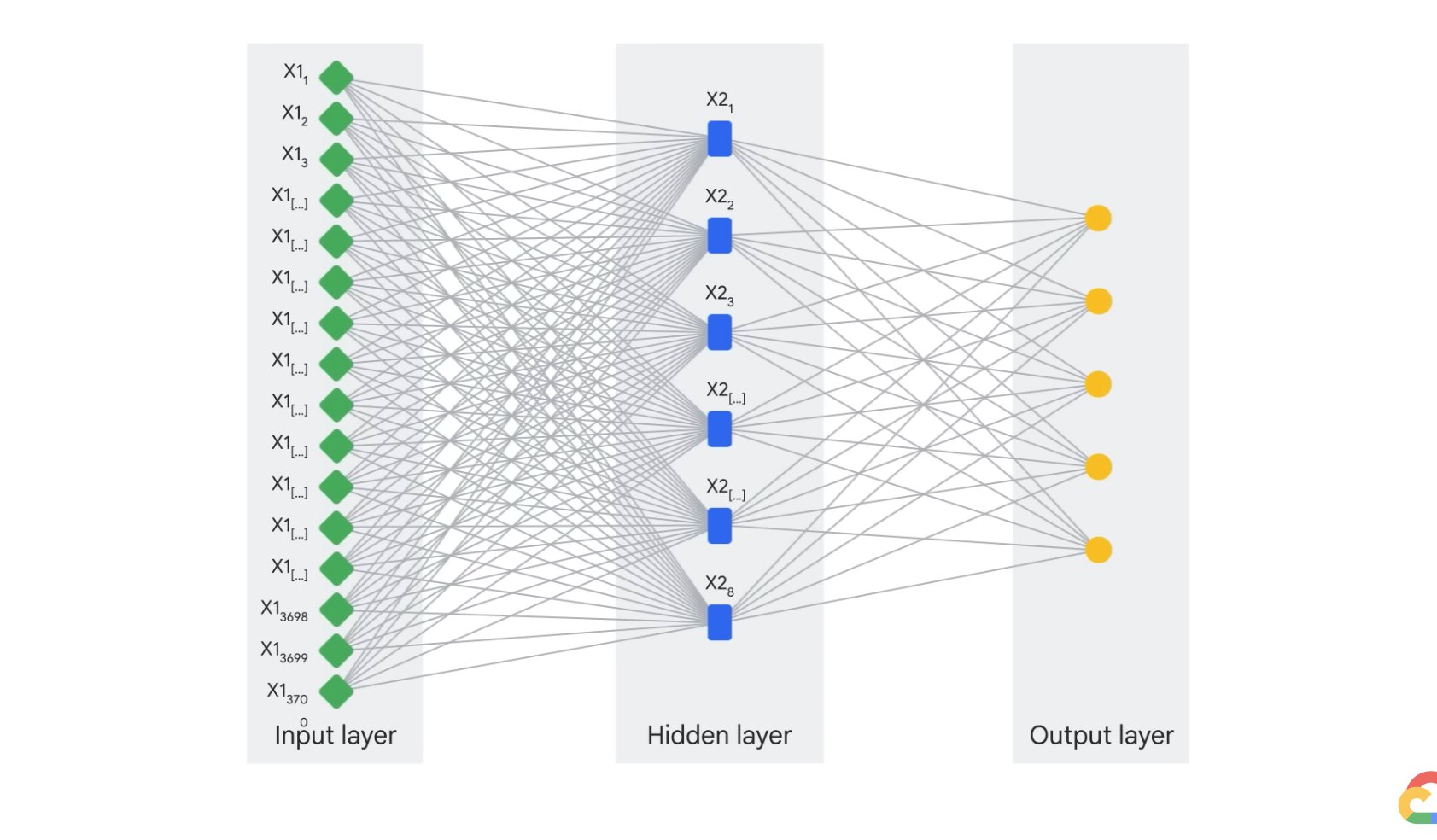

Transformer 架构的出现算是个里程碑。它的注意力机制太关键了 —— 能让 AI 在生成内容时,重点关注上下文里的关键信息。比如写一篇产品测评,提到 “续航” 时,算法会自动关联前面提到的电池容量、使用场景,不会说半截话。之前老一代的 RNN 模型就没这本事,经常写着写着就跑偏,前后矛盾。

微调技术也不能忽视。通用大模型就像个全科医生,啥都懂点但不精。想让它专精某个领域,就得用垂直数据做微调。比如写法律文书的 AI,得用海量判例和法条做针对性训练。某法律咨询平台透露,他们的 AI 经过 6 个月的法律数据微调,生成的合同条款准确率从 65% 提到了 92%,这就是算法针对性优化的效果。

还有个容易被忽略的点 —— 算法的 “自我纠错” 能力。好的模型会根据用户反馈不断调整。用户指出某段内容有误,算法不仅会改,还会记住这个错误类型,下次避免。这种闭环优化机制,比单纯堆数据更能提升质量。见过有些小平台的 AI,同一个错误能犯好几次,就是因为缺了这套纠错算法。

🔄 数据源与算法的协同:1+1>2 的关键机制

别以为数据源和算法是两码事,它们其实是互相成就的关系。数据喂饱算法,算法反哺数据,这才是 AI 生成优质内容的真谛。

算法能帮着 “榨干” 数据的价值。一堆杂乱无章的数据,经过算法处理,能提炼出隐藏的规律。比如分析十万篇爆款公众号文章,算法能找出标题的共性、段落的节奏、关键词的分布,再用这些规律指导内容生成。这时候,数据不再是死的文字,而是能被复用的 “创作模板”。

反过来,新生成的内容又能变成新数据,让算法更聪明。某 AI 写作工具搞了个 “用户共创” 机制,作者用 AI 生成初稿后修改的版本,会被匿名收录进数据库,用来优化算法。半年下来,模型生成的内容需要人工修改的比例下降了 40%。这就是数据和算法形成了正向循环。

协同的关键还在于 “动态平衡”。数据太多,算法处理不过来,会导致生成速度慢;数据太少,算法再强也巧妇难为无米之炊。聪明的平台会根据算法能力动态调整数据源规模。比如某模型的单次处理上限是 500 亿参数,他们就把数据源控制在这个范围内,保证每一条数据都能被充分学习,而不是贪多嚼不烂。

🚫 行业痛点:数据源污染与算法僵化的双重挑战

说点扎心的,现在 AI 生成内容的质量参差不齐,根源还是出在数据和算法上。这俩要是出问题,生成的东西能看吗?

数据源污染是重灾区。不少小平台为了省成本,直接爬取网上的低质内容,里面错字连篇、观点偏激,甚至还有抄袭的。用这种数据训练出来的 AI,写东西就像在 “吃别人嚼过的饭”,原创性根本无从谈起。更要命的是版权问题,前两天就有平台因为用了盗版书籍训练模型,被起诉赔偿了几百万。

算法僵化也很头疼。有些模型上线后就没怎么更新过算法,还在用两年前的技术。用户需求在变,写作风格在迭代,算法跟不上,生成的内容自然就显得过时。比如现在流行短平快的短视频文案,老算法还在按长篇文章的逻辑生成,结果就是用户看一眼就划走。

还有个隐蔽的问题 ——“算法偏见”。如果数据源里性别、地域相关的内容带有偏见,算法会把这种偏见放大。有测试显示,某 AI 写 “护士” 角色时,80% 都会默认是女性;写 “工程师” 时,90% 会描述成男性。这就是数据里的刻板印象被算法强化了,最后生成的内容自然就不够客观。

🌟 实战案例:那些把 “数据 + 算法” 玩明白的平台

别光说问题,也看看做得好的。真有平台把数据和算法的结合玩出了花,他们的经验值得借鉴。

先看国外的 Claude,它的数据源筛选就很严格,只收录经过版权授权的书籍、论文和新闻,而且会定期剔除过时信息。算法上,它用了 “Constitutional AI” 技术,简单说就是给算法定了一套 “写作准则”,保证生成内容符合伦理、逻辑自洽。用户反馈,Claude 写的分析类文章,论据扎实度比同类产品高 30%。

国内的 “第五 AI” 也挺会玩。他们搞了个 “三层数据过滤机制”:第一层机器去重,第二层人工审核事实性,第三层用户反馈修正。算法上,针对中文语境做了专项优化,比如解决了多音字、语义歧义的问题。有自媒体博主说,用它生成的头条文章,过原创的概率比其他工具高不少,这就是数据和算法双重优化的效果。

还有个专注于学术写作的 AI,它的做法更绝。数据源只认核心期刊和名校论文,算法上开发了 “学术规范校验” 功能,能自动检查引用格式、术语使用是否符合学科要求。现在不少研究生用它来写开题报告,据说导师的修改意见少了一半还多。

这些案例都证明了一点:优质数据打底,先进算法赋能,再加上持续的协同优化,AI 生成高质量文章完全不是空话。那些还在靠噱头炒作的平台,真该好好学学这种扎实做事的态度。

说到底,AI 生成内容的质量竞争,到最后就是数据和算法的竞争。你手里有多少好料,有多大本事把这些料做成好菜,直接决定了你能不能在这个赛道上跑赢。对于用户来说,选 AI 写作工具时,别光看宣传,多问问它的数据源来自哪里,算法最近一次更新是什么时候 —— 这俩才是硬道理。