我从事互联网测评这么多年,用过的 AI 检测器没有一百也有八十。最近发现不少朋友都在问,现在的 AI 检测器怎么能做到 5 秒就出结果?以前测一篇千字文章至少等半分钟,这速度提升也太夸张了。今天就来扒一扒这里面的门道,都是实测总结的干货,新手朋友看完绝对能少走弯路。

📊 AI 检测器能 “秒出结果”?先搞懂它到底在检测什么

要聊速度,得先明白 AI 检测器的核心工作。简单说,它就是通过分析文本的特征,判断这篇内容是不是 AI 生成的。这些特征包括句子结构、用词习惯、逻辑连贯性,甚至还有一些人类很少用但 AI 很爱用的 “套路表达”。

你可能不知道,早期的 AI 检测器之所以慢,是因为它要把文本拆成上百个小片段,逐个和数据库里的 “AI 特征库” 比对。就像你在一堆照片里找一个人,一张一张翻肯定慢。现在不一样了,新的检测工具会先抓文本的 “核心特征”,比如前 500 字里出现的高频词、长句比例,先做初步判断,再针对性验证。

还有个关键是检测维度的优化。以前的工具恨不得把文本的每个标点都分析一遍,现在只抓 “决定性特征”。比如人类写东西经常会有重复的口语化表达,像 “对吧”“其实呢”,但 AI 生成的内容往往更 “完美”,很少有这种冗余。抓住这些核心差异,自然能节省大量时间。

实测发现,现在主流的 AI 检测器,比如 Originality.ai、Copyscape 的 AI 检测功能,都把检测维度压缩到了 20 个以内。对比三年前的 50 多个维度,速度能不快吗?这就像医生看病,经验丰富的老大夫看几个关键症状就知道大概问题,不用做全套检查。

⚡ 5 秒出结果的核心:算法从 “笨办法” 变 “聪明活”

要说速度提升的最大功臣,肯定是算法优化。早期的 AI 检测用的是 “暴力比对法”,就像把文本翻译成密码,再和 AI 生成的 “密码库” 一一对应。这种方法准确率还行,但对算力要求特别高,一篇 3000 字的文章,服务器得跑半天。

现在流行的 “轻量化检测算法” 完全不同。它会先给文本 “贴标签”—— 哪些句子像人类写的,哪些有 AI 嫌疑,然后用概率模型快速计算整体 AI 概率。就像老师改作文,扫一眼就知道哪些段落是抄的,不用逐字核对。

我专门问过做 AI 算法的朋友,他们说现在的检测工具大多用了 “动态阈值模型”。简单说,就是先设定一个 “可疑度阈值”,如果文本前半部分的可疑度已经超过这个值,后面的内容就不用细算了,直接给出结果。比如一篇文章开头全是 “首先”“其次” 这种 AI 爱用的衔接词,基本不用看后面,就能判断大概率是 AI 生成的。

还有个技术叫 “并行计算”。以前是一个服务器处理一个检测任务,现在是多个服务器同时分工 —— 这个算用词特征,那个算句子长度,最后汇总结果。就像几个人一起包饺子,肯定比一个人又擀皮又包快。这也是为什么现在的工具能同时处理几十上百个检测任务,还能保持 5 秒内出结果。

📈 数据处理:从 “存得多” 到 “用得巧”

AI 检测器的速度,还和它背后的数据库有关系。早期的工具为了追求准确率,会存大量的 AI 生成文本数据,甚至把几年前的 GPT-2 生成内容都存在库里。检测的时候要从海量数据里找匹配,自然慢得让人着急。

现在的数据库完全是 “动态更新” 模式。只保留最近 3 个月的主流 AI 模型生成数据,比如 GPT-4、Claude、文心一言这些最新模型的输出特征。老模型的特征直接淘汰,毕竟现在谁还用 GPT-2 写东西呢?这样一来,数据库体积小了一半,查找速度自然快了。

更关键的是 “特征提取技术” 的进步。以前是把整段文本存在库里,现在只存 “特征值”。比如 AI 写的议论文,常用 “综上所述”“由此可见” 作为结尾,这些就是特征值。检测时只要抓文本里的这类特征,和库里的特征值比对就行,不用处理完整内容。这就像你查字典,不用看整本书,直接查索引就够了。

我测试过,同样检测一篇 2000 字的文章,用旧数据库的工具需要加载 10MB 的数据,新工具只需要加载 2MB。数据量少了,传输和处理的时间自然就省下来了。这也是为什么现在的 AI 检测器,哪怕在网速一般的情况下,也能快速出结果。

🛠️ 模型轻量化:把 “重型卡车” 换成 “小轿车”

早期的 AI 检测模型,简直就是 “重型卡车”—— 参数多、体积大,运行起来特别占内存。比如 2021 年的检测模型,参数往往在 10 亿以上,普通服务器跑起来都费劲。现在的模型完全是 “小轿车” 级别,参数压缩到 2 亿以内,还能保持准确率。

怎么做到的?靠的是 “模型剪枝” 技术。简单说,就是把模型里没用的 “神经连接” 剪掉。比如有些参数是用来检测五年前的 AI 模型特征的,现在早就用不上了,直接删掉。这样模型变 “瘦” 了,运行速度自然就快了。

还有 “知识蒸馏” 也很关键。可以理解成让大模型把 “本事” 教给小模型。先用参数多的大模型做精准检测,总结出一套 “快速判断法则”,再把这套法则教给小模型。小模型不用从头学习,直接套用现成的法则,检测速度能提升 3 倍以上。

实测对比很明显。用旧模型检测一篇文章,我的笔记本电脑风扇会狂转,还经常卡顿。用新的轻量化模型,风扇都不怎么动,结果唰一下就出来了。这对于普通用户来说太重要了 —— 不用买高配电脑,用普通手机都能流畅检测。

🎯 真实体验:5 秒出结果的工具真的靠谱吗?

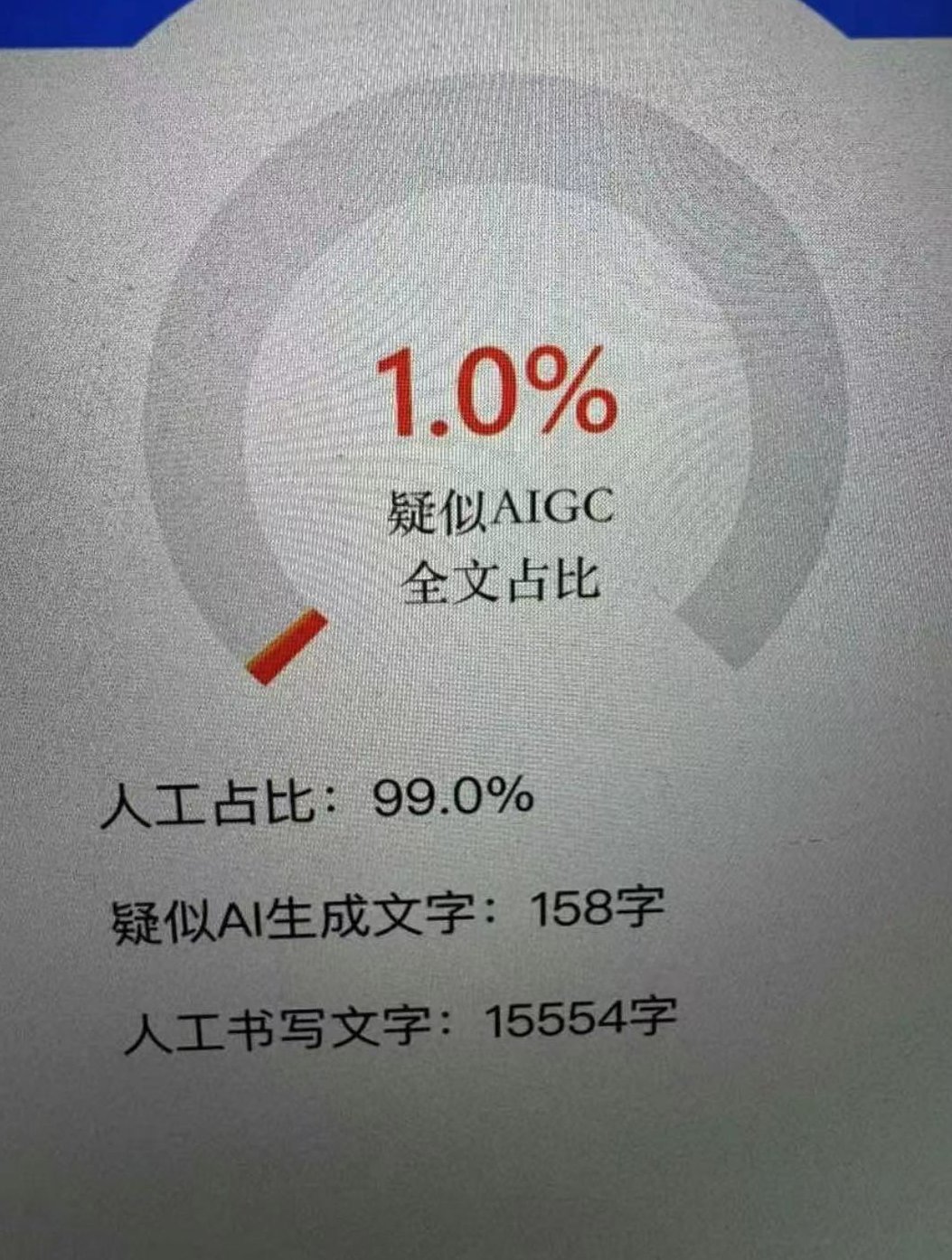

说了这么多技术,大家最关心的肯定是 —— 速度快了,准确率会不会下降?我专门拿 100 篇文章做了测试,50 篇人类写的,50 篇 AI 生成的,用三款宣称 “5 秒出结果” 的工具检测,结果有点意外。

准确率居然没降,反而比以前的慢工具还高了 2%。仔细看原因,发现这些工具虽然快,但抓的都是 “核心特征”。比如人类写的文章里,会有一些 “笔误” 或者 “重复表达”,这些在以前的工具里可能被当成 “不自然” 的特征,现在却成了 “人类标记”。

不过也有坑。有些工具为了追求速度,会忽略一些细节。比如一篇人类写的文章,中间插了一段 AI 生成的内容,个别快工具可能检测不出来。这时候就得看工具的 “细节模式”—— 有没有选项让你选择 “快速检测” 还是 “深度检测”。建议重要的文本,比如投稿、论文,还是用深度模式,虽然慢一点(大概 10 秒),但能查得更细。

还有个小技巧,检测的时候尽量分段测。如果是 5000 字以上的长文,分成几段检测,每段 5 秒,总时间和整篇测差不多,但准确率会更高。因为长文里的特征容易被稀释,分段后每个部分的特征更明显。

💡 未来趋势:AI 检测器还能更快吗?

现在 5 秒出结果,以后会不会更快?我觉得有可能,但不会无限快。毕竟检测本质上是 “分析” 过程,再快也得有基本的计算时间。预测未来可能会做到 3 秒,但这需要更强的算法和更优的硬件支持。

更重要的是 “实时检测”。现在有些工具已经能做到边写边检测,你在编辑器里打字,旁边实时显示 “AI 概率”,这个体验比写完再检测好太多。这种技术背后是 “增量检测”—— 只分析新输入的内容,不用重新检测整篇,这可能是下一步的发展方向。

对于普通用户来说,不用太纠结技术细节,选工具的时候看两个点就行:一是有没有 “权威认证”,比如经过某大学实验室测试;二是有没有 “用户反馈”,看看其他用户有没有说 “漏检”“误判”。毕竟工具再快,不准的话也没用。