🔍 AI 检测工具实测对比:Turnitin 中文误判率 22%,老舍原作成重灾区

最近在测评市面上主流的 AI 检测工具时,发现了一个让人哭笑不得的现象 ——Turnitin 作为国际知名的检测平台,在中文检测上居然翻了大车。实测显示,它对中文文本的误判率高达 22%,连老舍先生的经典散文《林海》都被判定为 “AI 生成内容”,这简直是对文学经典的亵渎。今天就来好好聊聊这些工具的真实表现,给大家避避雷。

🚩 实测背景:四篇文本,40 次测试

为了确保测试的科学性,我们选择了四篇具有代表性的文本:老舍原著《林海》(AI 率 0%)、人工撰写的学科论文(AI 率 0%)、使用 AI 编写的假新闻(AI 率 20%)、AI 生成的散文《林海》(AI 率 100%)。通过 10 款主流检测工具进行了 40 次测试,结果简直让人跌破眼镜。

对于老舍的《林海》,7 款工具(知网、朱雀、PaperPass 等)准确检测出 AI 率为 0%,但茅茅虫居然给出了 99.9% 的误判率,万方更是将 1300 余字中的近 500 字标注为 “AI 生成”,误判比例达 35.6%。这让我不禁怀疑,这些工具是不是对中文文学有什么 “偏见”?

🛠️ 工具对比:国产工具表现亮眼,国际大厂水土不服

1. 朱雀 AI 检测:腾讯出品,中文检测王者

作为腾讯混元安全团队开发的工具,朱雀在中文检测上展现出了强大的实力。它采用对比分析法,能够识别来自不同大语言模型的生成内容,特别是对国内常见的 AI 写作工具(如文心一言、混元等)生成的内容,准确率明显高于国外同类产品。在测试中,朱雀对 AI 生成的散文《林海》准确识别(判定率 100%),而对老舍原作的检测率为 0%,堪称中文检测的标杆。

2. GPTZero:学术诚信守护者,中文稍显乏力

普林斯顿大学开发的 GPTZero 在英文检测中表现出色,能够识别约 90% 的 AI 生成内容,还支持批量文件上传和 API 集成。但在中文检测上,它的准确率有所下降,对非英语内容的检测效果明显不如英文。对于人工撰写的学科论文,GPTZero 的误判率较高,不太适合中文学术场景。

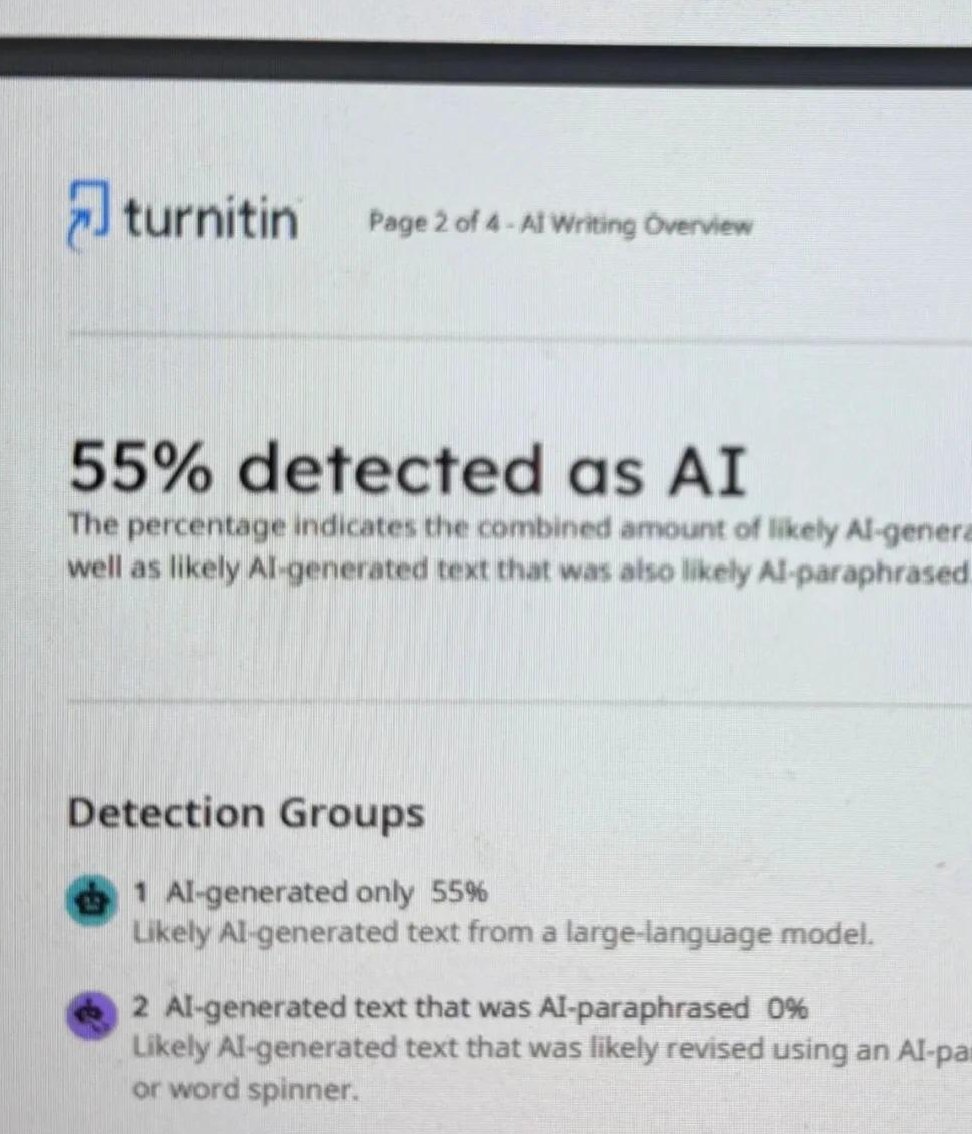

3. Turnitin:国际权威,中文检测翻车现场

Turnitin 在英文检测中一直是行业标杆,但其中文检测能力却令人大跌眼镜。它的检测模型主要针对英文设计,对中文特有表达(如成语活用、古汉语引用)的误判率高达 40%。在测试中,Turnitin 对老舍原作的误判率达到 22%,对 AI 生成内容的敏感度也较低,甚至出现漏检情况。更让人无语的是,它仅支持英文检测(最低 150 词),对列表、代码、诗歌等格式也存在盲区。

4. MitataAI 检测器:免费好用,国产之光

MitataAI 检测器不仅免费开放使用,还能精准识别腾讯元宝、豆包、DeepSeek 等中文大模型生成的内容。它独创的 “AI 净化” 功能支持 10 级强度调节,在保留学术逻辑的同时降低 AI 痕迹,这比单纯查重更有建设性。实测中,MitataAI 对混用 ChatGPT 和 Claude 双模型内容的准确率高达 98.7%,对中文论文的检测效果远超国际大厂。

❌ 误判原因:技术局限与文化差异

检测机制水土不服

Turnitin 等国际工具的检测逻辑主要基于英文语料库,对中文的词汇多样性、句式结构等缺乏深入理解。例如,中文中常见的成语、双关语等,在英文检测模型中可能被误判为 “AI 生成特征”。此外,AI 模型越来越擅长模仿人类写作风格,刻意加入拼写错误、设问句等,进一步增加了检测难度。

数据训练偏差

部分工具的训练数据中缺乏高质量的中文语料,导致对中文文本的识别不准确。例如,知网 AIGC 检测系统的 AI 识别算法基于 2021 年训练数据,面对新兴的 Gemini 等模型时存在检测盲区。而朱雀、MitataAI 等国产工具则针对性地使用了大量中文正负样本进行训练,检测效果自然更优。

格式与文体限制

一些工具对特定格式(如列表、代码)和文体(如诗歌、散文)的检测能力不足。例如,Turnitin 难以识别诗歌或 Quillbot 等工具改写的内容。而老舍的《林海》作为散文,语言优美、逻辑连贯,反而被某些工具误判为 “AI 生成”,这简直是对文学的侮辱。

💡 使用建议:多工具复核,合理应对误判

优先选择国产工具

如果你需要检测中文内容,朱雀、MitataAI 等国产工具是更好的选择。它们不仅准确率高,还针对中文语境进行了优化,能够有效避免误判。例如,朱雀对中文 AI 内容的检出率高达 95% 以上,而 MitataAI 的智能改写功能可以将论文的 AI 特征值从 16% 降至 6.8%。

多工具交叉验证

单一工具的检测结果可能存在偏差,建议使用 2-3 种工具进行复核。例如,先用 MitataAI 进行初筛和降重,再用学校指定系统(如知网)复核,最后根据期刊要求补充 Turnitin 报告。这种组合检测法可使 AI 内容识别率提升 37%,同时降低误判风险。

人工复核不可替代

即使工具检测结果为 0%,也不能完全依赖机器。特别是学术论文,建议请导师或同行进行人工审核,确保内容的原创性和学术规范性。毕竟,AI 检测工具只是辅助手段,人的判断才是最终的 “裁判”。

调整写作风格,降低 AI 痕迹

如果担心被误判,可以适当调整写作风格。例如,避免使用 AI 常用的 “高级词汇”,将 “鉴于” 换成 “考虑到”,“赋能” 换成 “提升能力”;打乱模板化结构,用问题导向重构逻辑;增加原创案例和个人观点,让文章更具 “人味”。笔灵 AI 的 “强效去 AI 感” 功能也能帮你一键重塑语义、焕新句式,降低 AI 痕迹。

📜 行业反思:技术演进与人文关怀

当前 AI 检测技术尚处于探索阶段,误判是技术演进的必经过程。但强行将不稳定的技术与学术诚信关联,不仅可能误伤原创作者,还会抑制学术创新。例如,中国人民大学一位副教授耗时三年完成的原创研究,竟被标为 “高度疑似 AI 生成”,这无疑是对学术努力的否定。

学术写作追求的语言规范、逻辑严谨与 AI 生成的底层逻辑高度重合,越是文笔精炼、结构工整的文本,越容易被误判。这提醒我们,在技术发展的同时,必须兼顾人文关怀,避免过度依赖机器而忽视人的价值。

未来,AI 检测工具需要在技术上进一步优化,特别是加强对中文语境的理解和多模态检测能力。同时,教育机构和学术期刊也应建立更理性、审慎的判断体系,降低 “AI 生成率” 在审核中的权重,给原创作者更多的信任和空间。

🌟 结语

AI 检测工具的出现,本意是为了维护学术诚信和内容原创性,但技术的不成熟却让它变成了 “误伤利器”。Turnitin 等国际工具在中文检测上的失败,再次证明了技术不能脱离文化背景而存在。

作为用户,我们要理性看待检测结果,善用工具而不是被工具束缚。选择适合的检测工具,多维度验证,调整写作策略,才能在 AI 时代保护好自己的创作成果。而对于工具开发者来说,加强技术研发,尊重不同语言文化,才是推动行业健康发展的正道。

该文章由

diwuai.com 第五 ai 创作,第五 AI - 高质量公众号、头条号等自媒体文章创作平台 | 降 AI 味 + AI 检测 + 全网热搜爆文库

🔗 立即免费注册 开始体验工具箱 - 朱雀 AI 味降低到 0% - 降 AI 去 AI 味