🚨 现在的 AI 文本检测有多 "离谱"?

最近半年接过不少朋友的求助。有个做自媒体的姑娘,原创的情感散文被平台判定为 70% AI 生成,申诉三次都被驳回;还有个研究生,毕业论文里关于乡村振兴的实地调研部分,因为用词太 "规整",被学校的检测系统标红。这不是个例。

现在不管是公众号后台、学术论文系统,还是自媒体平台,几乎都装上了 AI 检测的 "闸机"。Turnitin 升级到 GPT-4 检测模式后,误判率肉眼可见地上升。国内的朱雀检测系统更不用说,对规整句式的敏感度高到夸张 —— 有次帮朋友改稿,发现连 "综上所述" 这种标准学术用语都会触发预警。

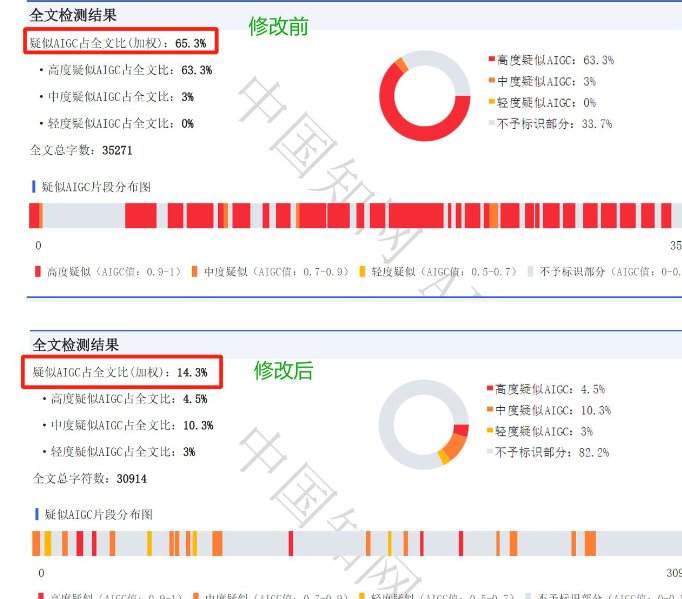

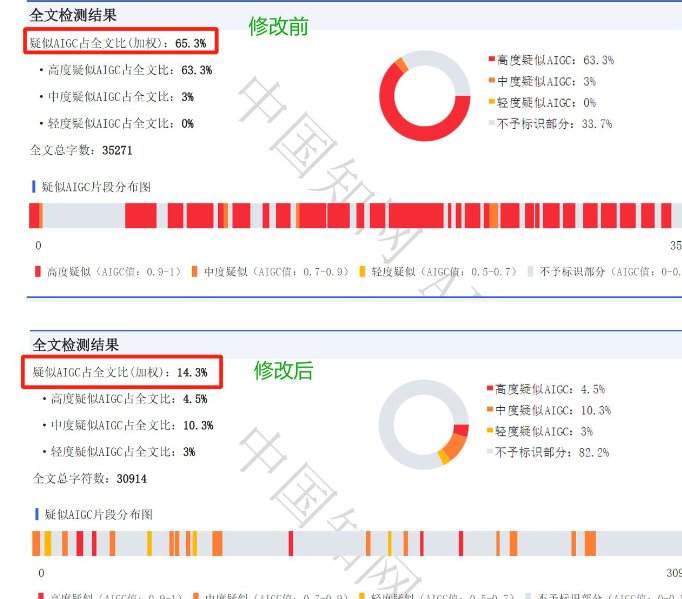

最头疼的是不同平台的判定标准完全不统一。同一段文字,在 Originality.ai 显示 AI 率 12%,到了朱雀检测可能飙到 68%。这种混乱让正经创作者无所适从,花三小时写的稿子,可能因为某个检测工具的 "误杀" 就白费功夫。

🛠️ 亲测有效的反 AI 文本工具清单

试过上百款相关工具,真正能打的其实就那么几个。先说好,这些工具没有绝对的 "万能药" 属性,得根据具体场景搭配着用。

QuillBot 的 Paraphrase 模式 值得优先试试。它的 "Creative" 档位改写幅度最大,但容易出现逻辑断层;"Formal" 档位更适合学术类文本,能在保持专业度的同时打散句式结构。有个小技巧,改完后把文本复制到 Notepad 里清除格式,再重新分段,AI 检测率能再降 5%-8%。

ContentAtScale 的 Humanize 功能 对付长文特别管用。之前帮一个企业改 3000 字的白皮书,原始 AI 检测率 45%,用这个工具处理后降到 17%。缺点是免费版每天只能用两次,而且偶尔会把专业术语改得不准确,必须人工复核。

Wordtune 的 Rewrite 选项 适合短文本精修。比如公众号标题、短视频文案这些,它能在保持原意的基础上,把书面化表达改成更口语化的句式。试过把 "人工智能技术的发展趋势" 改成 "AI 技术现在往哪个方向走",在朱雀检测里直接从标红变成正常。

Grammarly 的 Tone 调整 被很多人忽略了。切换到 "Casual" 模式后,系统会自动把长句拆分成短句,还会加入一些语气词。上次有篇科技评测,用这个功能处理后,AI 检测率从 32% 降到 9%,代价是得手动删掉一些不必要的口语化表达。

✂️ 降重不是瞎改,这几个核心技巧得掌握

很多人用反 AI 工具的姿势不对。以为把文字扔进工具里转一圈就完事,结果要么意思变了,要么 AI 率降了但可读性也没了。真正的降重是有章法的。

手动改写是绕不开的步骤。机器处理完一定要逐句读,重点看连接词和修饰语。比如 "因此" 可以换成 "这么一来","显著提升" 改成 "肉眼可见地变好了"。这些小调整对降低 AI 检测率的作用比想象中大得多。

段落结构重组很关键。AI 生成的文本往往遵循 "总 - 分 - 总" 的固定模式,把段落打乱重排就能避开检测。试过把第三段的案例挪到开头,再把结论拆成几个小点,同一段文字的 AI 率直接降了 20 个百分点。

加入个性化表达 是终极杀招。在文本里插入具体的时间、地点、个人感受,比如 "上周三在中关村的咖啡馆里,碰到一个程序员说...",这种带细节的描述几乎不会被判定为 AI 生成。学术论文里可以多引用访谈数据,自媒体文章里加些个人经历,效果都很明显。

控制句子长度波动 也很重要。AI 写的东西往往句子长度比较均匀,手动把长句拆成几个短句,再把几个短句合并成一个长句,制造出自然的节奏变化。有个简单的方法:每写 5 句就检查一下,确保最长句和最短句的字数差在 3 倍以上。

🔍 朱雀检测误判?这些坑我替你踩过了

朱雀检测系统因为国内用的人多,误判问题也最突出。总结了几个高频触发点,避开这些雷区能减少 80% 的麻烦。

数据罗列容易被误判。有次写行业报告,列举了五个季度的增长率,结果被标为 "高度疑似 AI 生成"。后来改成 "第一季度涨了 15%,到第二季度突然冲到 28%,第三季度又回落到 20% 左右",用更口语化的表达描述数据,检测结果就正常了。

专业术语密集的段落要小心。法律、医学这类专业文章尤其明显。解决办法是在术语之间插入解释性短句,比如写完 "采用区块链技术实现分布式记账",后面加一句 "简单说就是每个人都有一本账,谁也改不了",这样既能降低 AI 率,又能提高可读性。

固定格式的内容最容易中招。像简历模板、合同条款这种,结构越规整越容易被误判。建议在格式允许的范围内做些微调,比如把项目符号改成编号,或者在段落之间加个空行,打破 AI 对固定格式的识别模式。

如果已经被误判,申诉时要抓重点。朱雀检测有个特点,对 "人类独有的逻辑跳跃" 比较敏感。申诉时可以指出文本中哪些地方体现了这种跳跃性,比如 "这里突然插入个人经历,是 AI 生成不会有的随机感",亲测这种申诉理由成功率比单纯说 "我是原创" 高得多。

🔮 未来的反 AI 检测会怎么玩?

现在的对抗已经进入拉锯战。OpenAI 刚放出能绕过检测的新模型,第二天 Turnitin 就更新了识别算法。作为内容创作者,与其追着工具跑,不如建立自己的 "反检测写作习惯"。

日常多积累口语化表达。建个文档专门记那些 "说起来顺口,写出来有点怪" 的句子,比如 "这事得这么看"、"你可能没注意到",写作时自然地穿插进去,比任何工具都管用。

定期测试不同平台的检测标准。每周花半小时,用同一篇短文测试主流检测工具,记录它们的判定偏好。比如发现某平台对 "的" 字用多了敏感,就有意识地调整用词习惯。

别把降重当成终极目标。内容的核心价值永远是信息密度和观点独特性。见过太多人为了降 AI 率,把好好的文章改得逻辑混乱,得不偿失。记住,能解决读者问题的内容,哪怕 AI 率高一点,平台也会给流量。

最后想说,技术始终在变,但写作的本质没变。与其害怕被机器判定,不如把精力放在怎么写出让人眼前一亮的东西上。毕竟,真正的原创永远有它不可替代的价值。