🔍 AIGC 检测原理揭秘!2025 大模型检测短视频操作步骤详解

AIGC 技术的爆发式发展,让生成内容越来越逼真,但也带来了虚假信息、学术造假等问题。今天就带大家深入了解 AIGC 检测的核心原理,以及 2025 年大模型检测短视频的具体操作步骤。

🧠 检测原理:识别非人类创作痕迹

AIGC 检测的核心,是捕捉 AI 生成内容与人类创作的统计差异。不管是文本、图像还是视频,AI 生成的内容都有一些独特特征。

文本检测主要基于预训练模型微调。比如在人类文本和 AIGC 文本的混合数据集上,对 BERT 进行分类任务微调,让它学习区分两类文本的隐式特征。像句子结构过于规整、用词重复率高等,都是常见的 AI 痕迹。

图像检测有两种方法。一种是像素级异常检测,AI 生成的图像可能存在高频噪声、颜色分布偏移、伪影等问题。另一种是特征图模式识别,通过训练 CNN 或 ViT 模型,学习 AI 生成图像的特征图模式。比如 Google 的 “RAISR” 检测模型,就是通过分析图像超分辨率过程中的特征激活差异来识别生成痕迹。

多模态检测则是分析不同模态内容的一致性。例如,AI 生成的 “文本 + 图像” 对可能存在语义错位,像文本描述 “雪地里的红玫瑰”,但图像中玫瑰颜色偏蓝。这时候可以使用多模态模型,如 CLIP,计算文本与图像的相似度,AI 生成对的相似度通常异常偏高或偏低。

🚀 2025 大模型检测短视频操作步骤

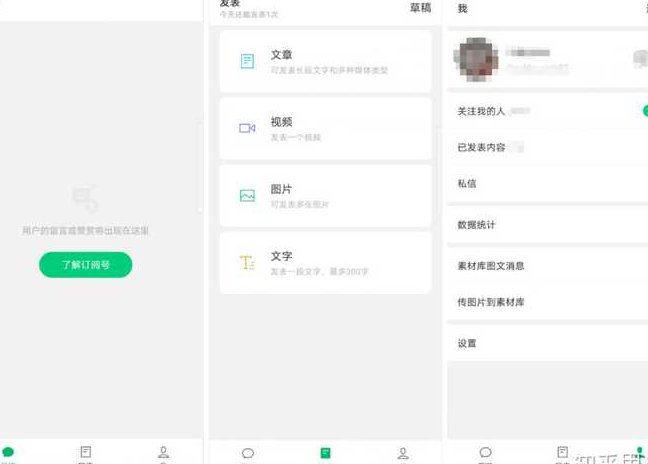

现在主流的短视频检测工具,基本都采用多模态融合的大模型技术。下面以某主流检测平台为例,详细介绍操作步骤。

第一步:上传视频

打开检测平台,点击 “上传视频” 按钮,支持 MP4、MKV 等常见格式。平台会自动解析视频,提取关键帧和音频信息。

第二步:选择检测模型

平台提供多种检测模型,包括通用模型、垂直领域模型(如教育、娱乐)和特定 AI 模型(如 ChatGPT、文心一言)。根据视频内容选择合适的模型,比如教育类视频选择教育领域模型,能提高检测准确率。

第三步:设置检测参数

可以设置检测的灵敏度,分为低、中、高三个等级。灵敏度越高,检测越严格,但误判率也可能增加。还可以选择是否检测音频中的 AI 生成内容,以及是否进行跨模态语义分析。

第四步:启动检测

点击 “开始检测” 后,平台会利用大模型对视频进行多维度分析。这个过程通常需要几分钟,具体时间取决于视频长度和复杂度。检测过程中,可以查看实时进度,了解当前分析的是视频的哪些部分。

第五步:获取检测报告

检测完成后,会生成一份详细的报告。报告中会显示视频的整体 AI 生成概率,以及每个关键帧和音频片段的 AI 特征分析。对于高概率 AI 生成的部分,会进行标记,并给出修改建议。比如,某个关键帧被判定为 AI 生成,平台会建议替换为真实拍摄的图片。

📊 检测结果处理与优化

拿到检测报告后,需要根据结果进行相应的处理。

如果视频的 AI 生成概率较低,且标记的部分不影响整体内容,可以直接使用。但如果 AI 生成概率较高,或者关键部分被标记,就需要进行优化。

手动优化是最直接的方法。对于被标记的文本部分,可以重新撰写,调整句式和用词。对于图像部分,可以替换为真实拍摄的图片,或者使用图像编辑工具进行微调。对于音频部分,可以重新录制,或者添加一些自然的背景声音。

使用工具优化也很方便。现在有很多 AI 降痕工具,如笔灵降 AIGC,能智能识别高 AI 率段落,提供专业修改建议,一键优化内容。这些工具通常支持多种格式,操作简单,几分钟就能完成优化。

加入真实元素是降低 AI 痕迹的有效方法。在视频中添加一些真实的拍摄素材、作者的出镜画面,或者用户的评论和反馈,能让视频更具真实性和可信度。

⚠️ 检测系统的局限性与应对

虽然 AIGC 检测技术不断进步,但目前仍存在一些局限性。

误判问题比较常见。比如,手持 DV 拍摄的街访视频,可能因 “画面稳定性超出人类手持极限” 被限流,而 AI 生成的虚拟主播舞蹈却畅通无阻。这是因为检测系统的训练集可能存在偏差,或者算法对某些人类创作特征不敏感。

对抗样本攻击也不容忽视。通过微小扰动修改 AIGC 内容,可能使检测模型失效。比如,在图像中添加一些特定的噪声,或者调整视频的帧率,都可能影响检测结果。

为了应对这些问题,平台和用户都需要采取一些措施。平台可以不断优化训练集,增加不同类型的真实数据,提高算法的泛化能力。用户在创作视频时,可以刻意加入一些 “人类指纹”,如镜头晃动、咳嗽喘息声,或者使用区块链存证相机,实时上传创作轨迹,以便在出现误判时提供证据。

🌟 未来趋势:多模态融合与实时检测

2025 年,AIGC 检测技术将朝着更精准、更智能的方向发展。

多模态融合将更加深入。不仅会分析文本、图像、音频的单独特征,还会挖掘它们之间的潜在联系,比如视频中人物的表情、动作与音频的情感变化是否一致。

实时检测技术将广泛应用。在视频上传的同时进行实时检测,边上传边分析,大大提高检测效率。对于直播等实时内容,也能实现即时检测,及时发现和处理虚假信息。

对抗样本防御技术将不断升级。通过对抗训练,让检测模型具备更强的鲁棒性,能够识别各种形式的对抗攻击。同时,会开发一些专门的防御工具,如噪声过滤、特征扰动等,帮助用户提高内容的安全性。

AIGC 检测技术的发展,既是挑战也是机遇。对于创作者来说,了解检测原理和操作步骤,合理使用检测工具,能够提高内容的原创性和可信度。对于平台和监管部门来说,不断优化检测技术,加强内容管理,才能营造一个健康、真实的网络环境。

该文章由

diwuai.com 第五 ai 创作,第五 AI - 高质量公众号、头条号等自媒体文章创作平台 | 降 AI 味 + AI 检测 + 全网热搜爆文库

🔗立即免费注册 开始体验工具箱 - 朱雀 AI 味降低到 0% - 降 AI 去 AI 味