现在 AI 模型是越来越 “能打” 了,从 ChatGPT 到各种大语言模型,参数规模动不动就是百亿、千亿级别。但有个事儿大家可能没太留意 —— 这些模型训练起来,能耗高得吓人。有行业数据显示,训练一个千亿参数的大模型,全程消耗的电量可能相当于几百户家庭一整年的用电量。这不仅让企业的成本居高不下,也和现在大家都在提倡的绿色发展理念不太搭。那到底怎么才能把 AI 训练的能耗降下来?传统方法和新策略比起来,谁又更高效呢?今天就来好好聊聊这个话题。

🔧 传统降低 AI 训练能耗的方法:能省点,但上限明显

提到降低 AI 训练能耗,传统思路其实很直接,大多是从硬件和基础环境下手。最常见的就是优化数据中心的散热系统。以前数据中心基本靠空调制冷,机器一跑起来,空调就得满负荷运转,有时候散热能耗能占到总能耗的 30% 以上。后来有人开始用自然冷却,比如把数据中心建在高纬度地区,像冰岛、瑞典这些地方,全年气温低,直接用室外空气给设备降温,能省不少电。国内也有企业在贵州建数据中心,利用当地的溶洞和凉爽气候,散热成本比传统空调模式降了近一半。

还有就是提升硬件利用率。很多时候,AI 训练不是 24 小时连轴转的,设备经常处于 “空跑” 状态。传统做法是通过调度系统,把不同任务错开时间安排,让 GPU、CPU 这些核心硬件尽量 “不闲着”。比如白天训练模型,晚上利用空闲算力做数据预处理,这样硬件的利用率能从原来的 50% 左右提到 70% 以上。不过这种方法有个问题 —— 它只能优化现有资源的使用效率,没法从根本上减少训练本身的计算量。就像一辆车,你把它的使用时间从每天 4 小时提到 6 小时,确实没浪费,但百公里油耗并没变。

另外,传统方法里还有 “降频降功耗” 这一招。简单说就是调低硬件的运行频率,让设备 “慢一点跑”,这样能耗能降下来。但副作用也很明显 —— 训练时间会拉长。本来 7 天能训完的模型,可能要拖到 10 天。对于需要快速迭代的 AI 项目来说,这可不是个好选择。而且现在的高端 GPU,比如 NVIDIA 的 H100,本身功耗就不低,单纯降频能省的电其实很有限。

🌿 新策略登场:从 “少用能” 到 “用对能”,思路更灵活

这两年行业里冒出了不少新策略,和传统方法比起来,它们更偏向从模型本身和训练逻辑入手。模型轻量化就是个好例子。以前大家总觉得模型参数越多性能越好,其实不是这样。现在可以通过知识蒸馏,把大模型的 “能力” 提取到小模型里。比如先用千亿参数的大模型训练出核心能力,再让一个百亿参数的小模型学习大模型的决策逻辑,最后小模型的性能能达到大模型的 80% 以上,但训练时的计算量能减少 60% 以上。谷歌之前做过实验,用这种方法训练的图像识别模型,能耗比原来降了近一半,识别精度却没怎么掉。

动态调整训练策略也很有意思。传统训练是 “一条道走到黑”,从开始到结束都用固定的参数和算力。新方法会根据训练进度 “灵活调整”。比如训练初期,模型还在 “摸索阶段”,可以用较低的精度计算,比如半精度浮点运算,这时候能耗低,还能快速收敛;到了后期需要提升精度时,再切换到高精度模式。国内一家 AI 公司试过这种方法,训练一个电商推荐模型时,整体能耗降了 35%,训练时间反而缩短了 20%。

还有个思路是 “按需分配算力”。现在有技术能实时监测模型训练中的 “冗余计算”。比如有些数据样本很简单,模型看一眼就会了,没必要反复训练;有些参数在训练中变化很小,说明已经接近最优状态,不用再投入过多算力。通过算法自动识别这些情况,把算力集中到真正需要优化的部分。有测试显示,这种方法能减少 20%-40% 的无效计算,能耗自然就降下来了。

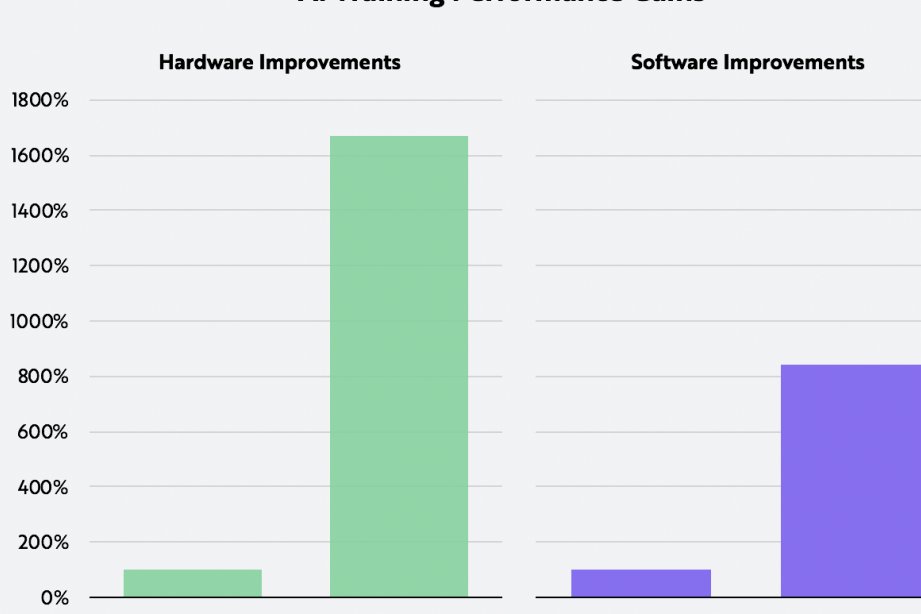

⚖️ 直接对比:新策略为啥比传统方法更高效?

从实际效果来看,新策略的优势其实很明显。传统方法更像 “被动节能”,比如优化散热、提高硬件利用率,这些做法能减少浪费,但没法改变 “训练一个大模型本身就需要大量计算” 这个核心问题。就像家里开空调,你把温度调高 1 度能省点电,但只要开着,基础能耗就在那儿。

新策略是 “主动节能”,从源头减少计算量。模型轻量化直接让需要训练的参数变少了,动态训练策略避免了无效计算,这些都是在 “减少必须消耗的能量”。有行业报告做过统计,同等条件下,用模型轻量化 + 动态训练的组合策略,比单纯优化数据中心散热和硬件利用率,能耗降低幅度要高出 2-3 倍。

成本方面也有差距。传统方法里,建一个自然冷却的数据中心,前期投入很大,选址、基建都要花钱,小公司根本扛不住。新策略大多是软件层面的优化,比如调整训练算法、做模型蒸馏,不需要额外买硬件,中小公司也能用得起。国内一家初创 AI 公司就说过,他们用知识蒸馏的方法,没增加任何硬件投入,就把模型训练成本降了 40%。

当然传统方法也不是完全没用。如果已经有了成熟的数据中心,优化散热和硬件利用率还是能立竿见影的。但要是想长期降低 AI 训练能耗,新策略肯定是更值得投入的方向。

🚀 未来趋势:“软硬结合” 才是最优解

现在行业里已经有了新的共识 —— 单靠传统方法或者单一新策略,都没法彻底解决能耗问题。最好的方式是 “软硬结合”。比如先用模型轻量化把计算量降下来,再用动态训练策略减少无效消耗,最后搭配优化过的散热系统和硬件调度,这样能把能耗降到最低。

国外有科技巨头已经这么做了。他们先通过知识蒸馏把模型参数压缩一半,再用动态精度训练,最后把数据中心的散热换成自然冷却,整套组合拳下来,AI 训练的综合能耗比原来降了 70% 以上。这种模式也被越来越多的企业效仿。

还有个值得关注的点是 “绿色算力” 的结合。现在有些地方开始用风电、光伏这些清洁能源给数据中心供电,再配合新的节能策略,相当于从 “节能” 和 “用清洁能源” 两个方向发力。有测算显示,如果 AI 训练的电力 100% 来自可再生能源,再加上模型层面的节能优化,整体碳排放量能减少 90% 以上。这可能就是未来 AI 绿色发展的大方向。

其实降低 AI 训练能耗,不只是为了省钱,更是行业可持续发展的必经之路。随着大模型越来越普及,能耗问题会越来越突出。传统方法能解决眼前的小问题,但新策略才能从根本上打破能耗瓶颈。对于企业来说,现在就该开始尝试模型轻量化、动态训练这些新方法,再结合自身硬件条件做优化。毕竟在 AI 竞争越来越激烈的当下,能把能耗降下来,就等于在成本和效率上占了先机。