伪原创工具现在在内容创作圈挺常见的,很多人用它来快速生成 “新” 内容。但你知道吗?这些工具能把一篇文章改头换面,靠的全是背后的自然语言处理技术。今天就来好好聊聊这里面的门道,让你看清这些工具到底是怎么干活的。

🛠️ 伪原创工具的 “基本功”:自然语言处理技术打底

伪原创工具的核心目标很简单,就是让改写后的内容看起来和原文不一样,但意思还得差不多。要做到这一点,没有自然语言处理技术根本玩不转。自然语言处理,简单说就是让计算机能看懂、理解人类语言的技术,它就像给工具装上了 “大脑”,能分析文字的结构、含义,再按照规则进行改造。

早期的伪原创工具技术比较糙,大多就是简单替换同义词,有时候换出来的句子根本不通顺。比如把 “我吃了饭” 改成 “我食用了米饭”,虽然词不一样了,但读起来特别别扭。这是因为那时候的自然语言处理技术只能做基础的词法分析,认不出词语在具体语境里的真正意思。

现在的工具就厉害多了。它们用到的自然语言处理技术更深入,能分析句子的语法结构,甚至理解上下文的逻辑。就拿 “他打了一场球” 来说,先进的工具不仅知道 “打” 在这里是 “进行” 的意思,还能改成 “他进行了一场球赛”,既换了说法,又不影响理解。这背后是大量的语言数据训练,让工具慢慢摸清了人类说话的规律。

🔍 词法分析:伪原创的 “换词” 密码

词法分析是自然语言处理里最基础的一步,也是伪原创工具 “换词” 的关键。它的作用是把句子拆成一个个词语,分析每个词的词性、含义,还有在句子里的作用。就像我们学语文时划分句子成分一样,计算机也得先搞清楚每个词是名词、动词还是形容词。

有了词法分析的结果,工具就能精准地替换同义词了。但这可不是随便找个近义词就行,得看语境。比如 “苹果” 这个词,在 “我吃了个苹果” 里是水果,在 “我用苹果手机” 里是品牌,词法分析能区分这两种情况,保证替换的词符合上下文。

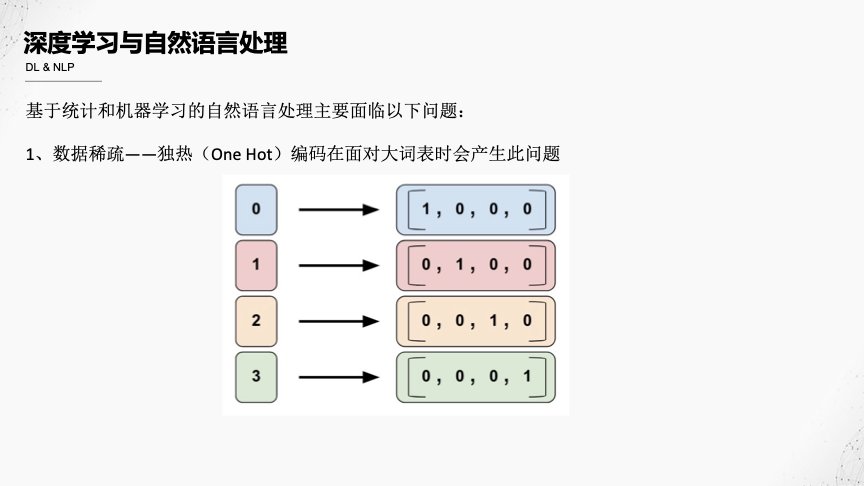

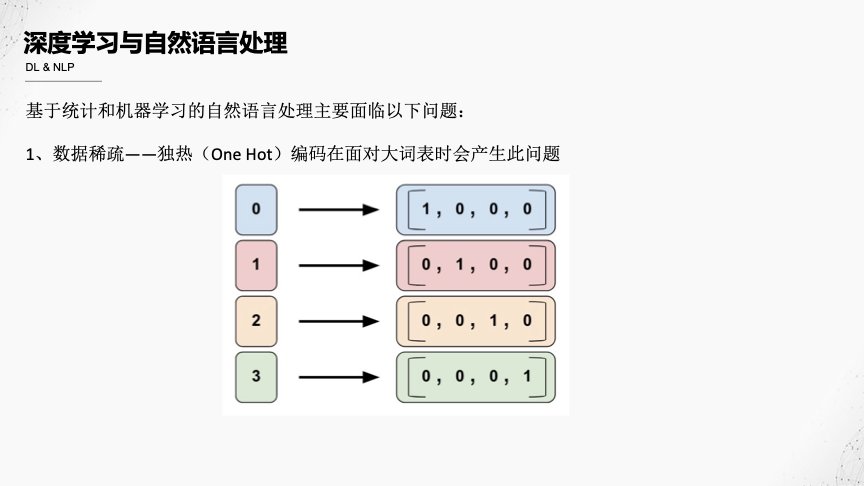

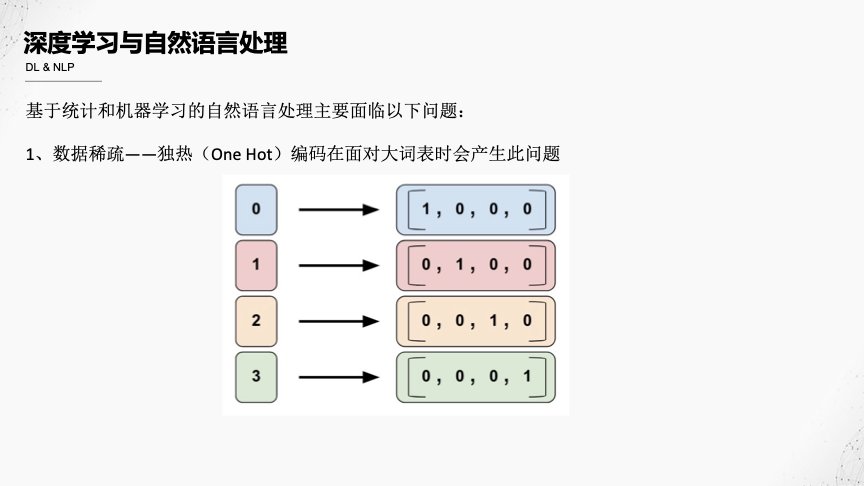

现在很多工具还用上了 “词向量” 技术。简单说,就是给每个词一个数字向量,意思越接近的词,向量越像。这样工具就能找到那些意思相近但表达方式不同的词,替换出来的效果更自然。比如 “漂亮” 和 “美丽”,“迅速” 和 “快速”,这些词在向量空间里距离很近,工具很容易就能找到它们。

不过词法分析也有局限性。遇到一些多义词或者有比喻义的词,它就可能犯迷糊。比如 “他是个老狐狸”,这里的 “老狐狸” 是比喻人狡猾,要是工具直接换成 “老松鼠”,意思就全变了。这也是为什么有些伪原创内容读起来怪怪的,就是词法分析没跟上语境的深层含义。

📝 句法分析:让句子 “换个姿势” 还通顺

光换词还不够,伪原创工具还得会改句子结构,这就靠句法分析了。句法分析能搞清楚句子里各个成分之间的关系,谁是主语,谁是谓语,谁修饰谁,就像给句子画了一张结构图。

有了这张图,工具就能对句子进行 “大手术” 了。比如把主动句改成被动句,“小明打了篮球” 改成 “篮球被小明打了”;把长句拆成短句,“在阳光明媚的下午,我和好朋友去公园散步” 改成 “下午阳光很好,我跟好朋友去公园散步”。这些变换都离不开句法分析对句子结构的精准把握。

现在高级的工具还能调整句子的语序,只要不破坏句子的核心意思就行。比如 “我昨天在超市买了牛奶和面包”,可以改成 “昨天在超市,我买了面包和牛奶”。这种调整能让句子看起来和原文差别更大,但意思一点没跑偏。

句法分析的难点在于处理复杂的长句。有些句子里有多个从句,成分嵌套,句法分析起来就很费劲。比如 “那个戴着红帽子、手里拿着一本书的女孩,是我昨天在图书馆遇到的同学”,这样的句子改起来很容易出错,要么改得逻辑混乱,要么把关键信息弄丢了。

🌐 语义理解:让伪原创不 “跑偏” 的核心

语义理解是自然语言处理里比较高级的技术,它能让工具搞懂句子和文章的真正意思,这是保证伪原创内容不 “跑偏” 的关键。如果只是机械地换词、改结构,不理解语义,很可能把原文的意思改得面目全非。

比如 “他吓得腿都软了”,这句话的核心意思是 “他很害怕”。语义理解技术能抓住这一点,在改写的时候围绕这个核心来变,比如改成 “他害怕得双腿发软”,意思没变,表达方式却不同了。要是没有语义理解,可能会改成 “他吓得腿都硬了”,那就完全错了。

现在很多伪原创工具还用上了预训练语言模型,比如 BERT、GPT 这些。这些模型在海量的文本数据上训练过,对语言的理解更深入。它们能结合上下文,判断词语的具体含义,甚至能理解一些隐晦的表达。比如 “他这是搬起石头砸自己的脚”,模型能明白这是说他做了坏事害了自己,改写的时候就不会只改字面意思。

但语义理解也不是万能的。遇到一些需要背景知识才能懂的内容,工具就可能翻车。比如 “这个方案太‘鸡肋’了”,知道 “鸡肋” 出自《三国演义》,表示食之无味弃之可惜的人,能明白意思。但工具要是没学过这个典故,可能就会改成 “这个方案太‘鸡肋骨’了”,让人看了一头雾水。

🚫 自然语言处理技术在伪原创中的局限

虽然自然语言处理技术让伪原创工具越来越好用,但它们还是有不少局限。最明显的就是对复杂逻辑的处理能力不足。比如一些议论文,里面有严密的论证过程,论点、论据、论证环环相扣,伪原创工具改完之后,很可能把逻辑链条打乱,让文章变得前言不搭后语。

还有就是对情感色彩的把握不够准。同样一句话,用不同的语气说出来,情感可能完全不同。比如 “你可真行啊”,既可以是表扬,也可以是讽刺。自然语言处理技术很难精准捕捉这种细微的情感差别,改写后的句子可能会把原来的情感弄反。

另外,伪原创工具生成的内容往往缺乏独创性。它们只是在原文的基础上做修改,很难有新的观点或者表达方式。对于一些需要深度思考和创意的内容,比如小说、散文,伪原创工具根本替代不了人工创作。而且很多平台现在都有反作弊机制,能识别出这些 “加工” 过的内容,一旦被判定为伪原创,可能会受到处罚。

🔮 未来趋势:自然语言处理技术让伪原创更 “聪明”

随着自然语言处理技术的不断发展,伪原创工具肯定会越来越 “聪明”。以后的工具可能会更好地理解上下文的逻辑关系,甚至能根据不同的文体调整改写策略。比如写新闻稿,会更注重信息的准确性和客观性;写散文,会更注重语言的美感和情感的表达。

多模态伪原创可能也是一个方向。就是不仅能处理文字,还能结合图片、视频等信息进行改写。比如给一篇带图片的文章,工具能根据图片内容调整文字描述,让改写后的内容和图片更匹配。

但不管技术怎么发展,伪原创都不能替代真正的原创。原创内容里包含着作者的思想、情感和创意,这是机器很难模仿的。自然语言处理技术更应该用在辅助创作上,比如帮作者找灵感、检查语法错误,而不是用来生产大量低质量的伪原创内容。

总的来说,伪原创工具背后的自然语言处理技术确实很强大,让内容改写变得更高效。但我们也要清楚它的原理和局限,合理使用这些工具,而不是过分依赖它们。毕竟,好的内容最终还是要靠人的思考和创造。

【该文章由diwuai.com第五 ai 创作,第五 AI - 高质量公众号、头条号等自媒体文章创作平台 | 降 AI 味 + AI 检测 + 全网热搜爆文库