手写论文过不了检测?2025AIGC 工具对比与误判原因分析

🔍 手写论文检测翻车现场:那些让人哭笑不得的误判案例

最近学术圈炸开了锅,不少同学发现自己手写的论文扫描上传后,检测系统竟判定 “AI 模仿人类潦草字迹特征明显”。江西某高校学生杨同学就遇到了这样的糟心事:同一篇论文,前一天检测 AI 率还只有 10.37%,第二天老师上传后直接飙升到 27.54%,不得不自费重新修改检测,前前后后花了小 300 元。更魔幻的是,不同平台的检测结果能差出天际 —— 有同学把爷爷三十年前的毕业论文扫描上传,知网标红全文,AI 率高达 99%,维普却只标黄摘要,AI 率仅 12%。

这类误判背后,暴露出当前 AIGC 检测技术的深层矛盾。检测系统往往通过分析文本结构、术语集中度、句式规律性等特征来判断是否为 AI 生成。但手写论文的字迹潦草、修改痕迹、口语化表达等 “人类特征”,反而可能被算法误判为 “AI 模仿人类的不完美痕迹”。比如,某位同学的手写批注被系统判定为 “机器生成的痕迹”,理由竟是 “字迹不够工整,符合 AI 模仿人类潦草的特点”。

🧠 误判根源:技术局限性与算法黑箱

为什么检测工具会对手写论文如此不友好?这要从技术原理说起。主流文本检测工具通常基于特征提取、困惑度计算、分类模型等技术,通过分析词汇集中度、句子长度分布、逻辑连贯性等指标来识别 AI 生成内容。但手写论文存在三大 “天然劣势”:

一是字迹多样性带来的识别困境。不同人的书写风格差异巨大,同一人不同时间的笔迹也会变化,再加上扫描图像可能存在模糊、光照不均等问题,手写识别准确率本就有限(复杂场景下稳定在 88%-90%)。检测系统很难从这些复杂的图像特征中准确提取文本内容,更遑论判断其是否为 AI 生成。

二是算法训练数据的偏差。多数检测工具的训练数据以机打文本为主,对手写场景覆盖不足。当遇到手写论文中的涂改痕迹、非标准句式时,系统容易将其视为 “异常波动特征”,从而误判为 AI 生成。比如,知网新系统建立的专业术语数据库,会对 “卷积神经网络”“Transformer 架构” 等高频词汇密集出现的段落触发警报,而手写论文中这些术语的自然堆砌可能被误判为 AI 生成。

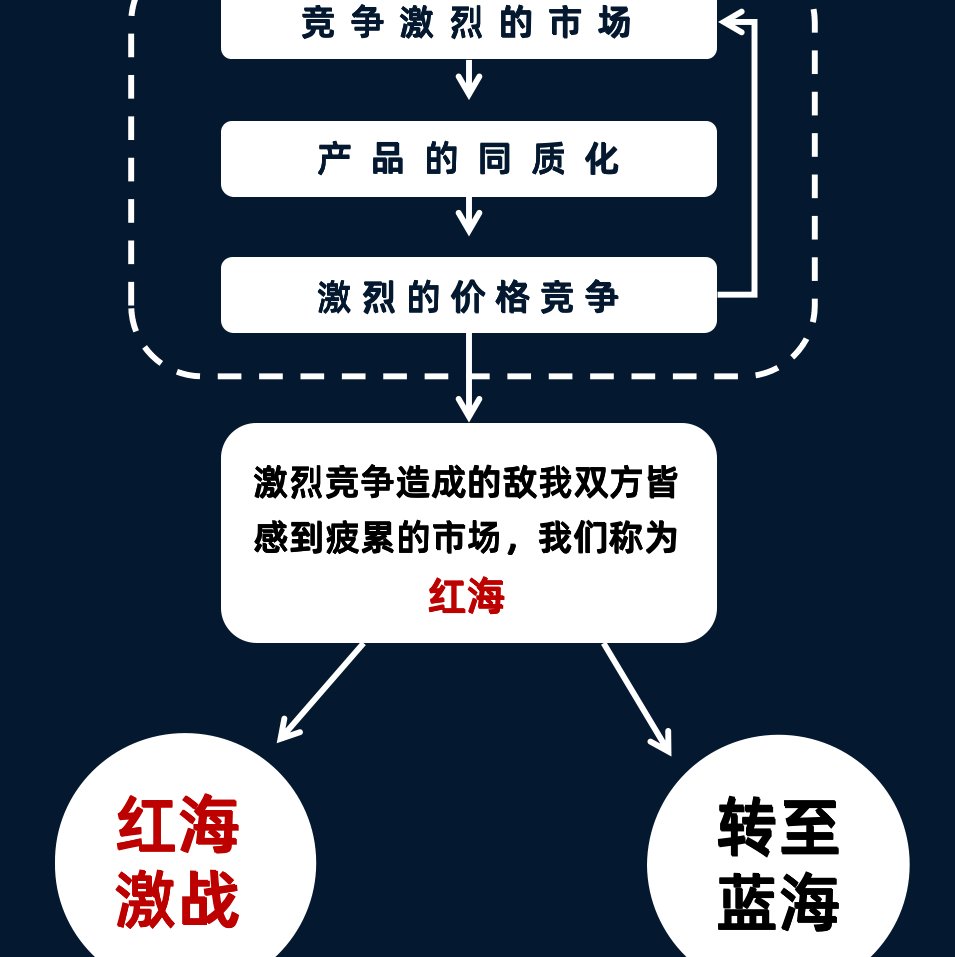

三是检测标准的模糊性。目前 AI 检测尚无统一标准,不同平台的算法逻辑差异极大。有的工具通过计算文本 “困惑度”(即流畅度)来识别 AI 内容,认为逻辑过于完美、用词平滑的文本更可能是 AI 生成;有的则依赖语义相似度分析,对人工修改后的 AI 内容敏感度较低。这种标准的不一致性,导致同一篇论文在不同平台检测结果天差地别。

🛠️ 2025 年主流 AIGC 检测工具大起底

面对五花八门的检测工具,该如何选择?我们梳理了 2025 年学术圈常用的检测平台,从准确率、功能特点、适用场景三个维度进行对比分析:

🔥 国内工具:知网、维普等老牌平台的爱恨情仇

- 知网:作为学术圈的 “老大哥”,知网检测覆盖海量学术语料库,对 AI 生成的标准学术文本识别准确率较高(如 AI 生成的散文《林海》判定率达 100%)。但对手写论文极不友好,常因术语集中、句式结构标准化等问题误判。其升级后的系统还新增了对段落逻辑链条的评估,若内容缺乏递进关系或仅堆砌信息,易被判定为 AI 生成。

- 维普:检测标准相对宽松,对人工撰写的学科论文误判率较低(部分论文 AI 检测率为 0)。但对 AI 生成内容的敏感度也较低,存在漏检现象。例如,对含 20% AI 内容的假新闻,维普的 AI 识别率偏低。

- 朱雀大模型检测:在图片检测方面表现突出,能准确识别 AI 生成图,但对 PS 后的摄影图片识别仍有难度。文本检测方面,对真实文章的误判率相对较低,但对经人工修饰的 AI 内容识别能力有限。

🌍 国外工具:Turnitin、Originality.ai 的水土不服

- Turnitin:全球使用最广泛的学术检测平台,结合传统查重与 AI 检测,能识别文本中的重复内容和生成痕迹。但对中文语境适配不足,手写论文中的方言表达、文化特色词汇易被误判。

- Originality.ai:主打高精度检测,尤其擅长识别 ChatGPT、Bard 等大模型生成的内容。但其算法对学术术语密集的文本较为敏感,手写论文中的专业表述可能被误标为 AI 生成。

- GPTZero:专门针对 GPT 系列模型设计,通过分析句子结构、用词习惯等特征识别 AI 生成内容。免费版功能有限,付费版虽能提供详细报告,但对手写论文的检测效果一般。

💡 破解误判的实用攻略:让论文 “去 AI 化”

面对检测系统的 “误伤”,我们总结了一套行之有效的应对策略,既能降低 AI 率,又能保持论文的学术规范性。

🔧 内容改造三板斧

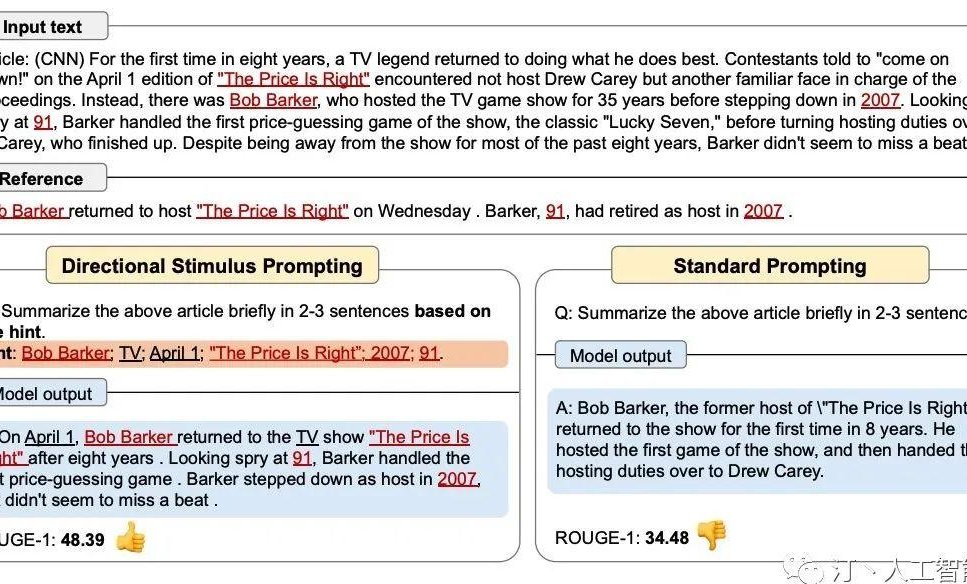

句式结构大换血

把 AI 最爱用的复合长句拆成短句,加入过渡词增强自然感。比如,将 “基于深度神经网络架构的多模态数据融合算法” 改为 “我们采用了一种深度神经网络架构。这种架构能实现多模态数据的融合,在实验中表现出了良好的性能”。同时,避免使用 “首先”“其次”“最后” 等逻辑词,改用 “从某某视角看”“进一步分析可知” 等多样化表达。

术语替换与变形

把高频术语换成近义词或生造词,打破算法的识别规律。例如,“数据挖掘” 可改为 “非结构化信息深度萃取”,“算法优化” 换成 “模型参数精细化调整”。还可以在术语后添加解释,如 “Transformer 架构(一种采用自注意力机制的深度学习模型)在自然语言处理任务中效果突出”。

注入真人味儿

在段落开头插入口语化描述,或引用导师的口头禅。比如,“讲真,数据波动比我预想的大多了”“正如 XX 教授指出,实验设计的逻辑链条需进一步强化”。这种带情绪的表达和真实细节,能有效降低系统的误判概率。

🛠️ 工具辅助降重指南

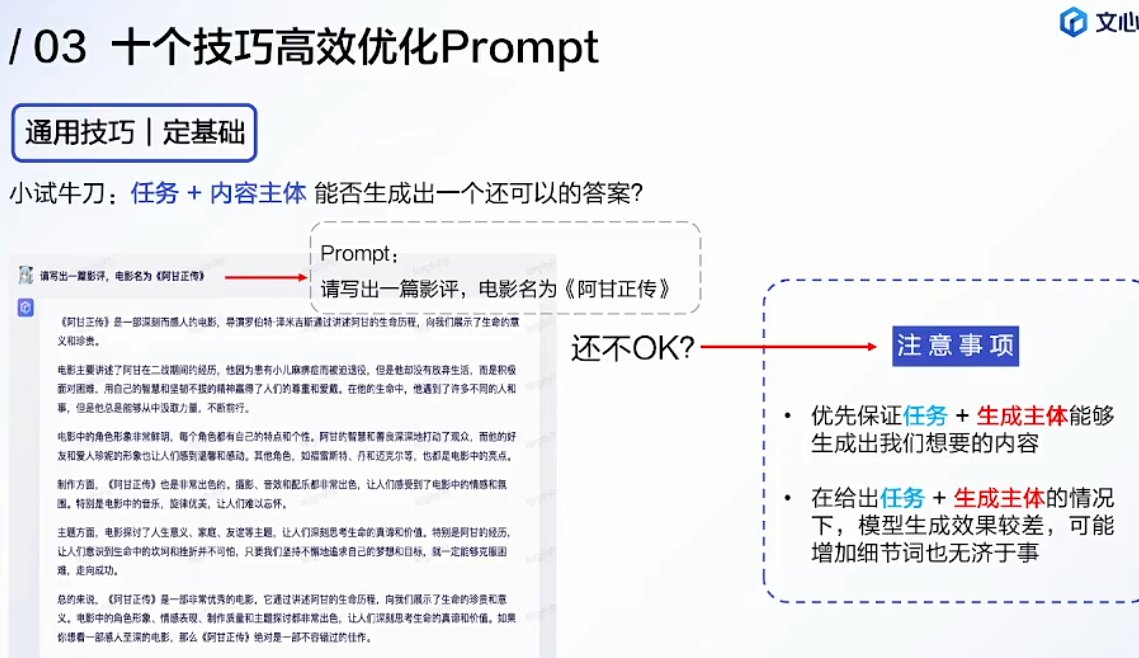

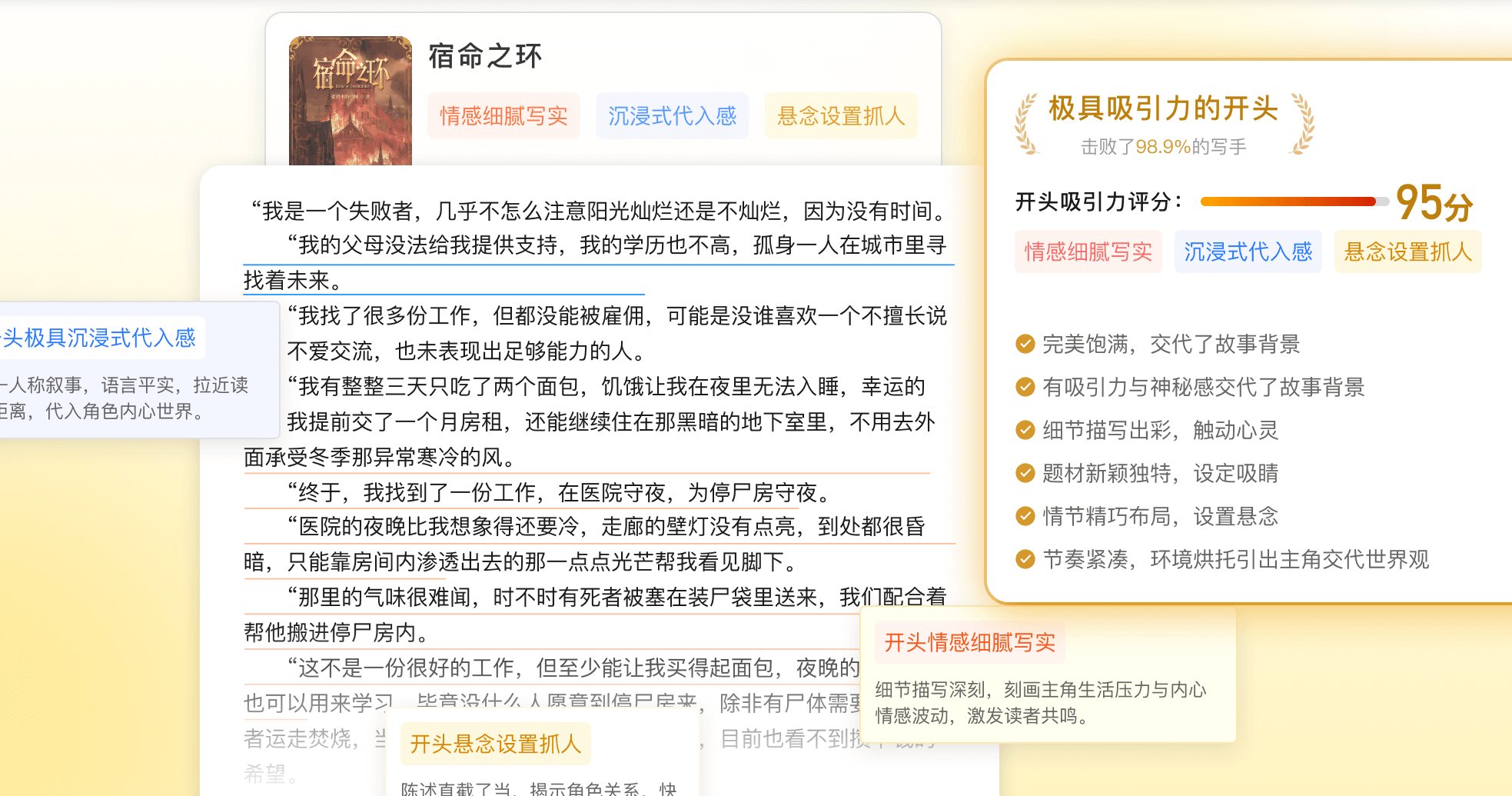

图灵论文 AI 写作助手

专为学术场景设计,支持每日无限次检测,能实时监控内容原创度。其 “深度降 AI” 模式可自动替换术语、调整句式,某用户的文献综述部分 AI 率从 82% 直降到 7.3%。检测报告还会生成三维分析图谱,直观展示疑似段落的相似度曲线与改写建议。

笔灵 AI 降重

操作简单,上传论文后十分钟即可下载修改版。实测显示,一篇 AI 率 83% 的论文经其处理后,知网检测率可降至 3.9%。工具会智能替换高频词、插入口语化表达,使内容更接近真人写作风格。

MASTER AI 率检测

支持实时反馈 AI 生成比例,并标注疑似语句。可作为预检工具,定位高风险段落,再针对性修改。其多语言混合检测能力也很实用,直接翻译外文 AI 生成内容而不调整表述,可能会触发查重警报,需特别注意。

📜 行业变革:从对抗到协同的新生态

随着《人工智能生成合成内容标识办法》的实施(2025 年 9 月 1 日生效),学术诚信治理正在迎来新的范式。办法要求 AI 生成内容需添加显式或隐式标识,这将倒逼检测工具从单纯的 “内容识别” 转向 “标识核验”。未来,检测系统可能会优先识别内容中的标识信息,而非过度依赖文本特征分析,这对手写论文来说或许是个利好消息。

与此同时,高校也在调整策略。同济大学法学院建议,避免将 AIGC 检测作为强制性毕业环节,转而引导学生合理使用 AI 工具,培养与 AI 协同的智慧生态。清华大学沈阳教授则指出,人类最终会过渡到由人提供创意、AI 做研究的模式,当前的误判只是技术演进的必经过程。

面对这场学术与技术的博弈,我们既要掌握应对误判的实用技巧,也要保持对技术发展的理性认知。毕竟,论文的核心价值在于思想深度和创新能力,而非与检测系统的 “猫鼠游戏”。正如某位专家所说:“降 AI 率不是为了糊弄系统,而是让论文更‘像人写的’—— 哪怕字丑一点、句子糙一点,但有独特的分析角度,就能过关”。

该文章由

diwuai.com第五 ai 创作,第五 AI - 高质量公众号、头条号等自媒体文章创作平台 | 降 AI 味 + AI 检测 + 全网热搜爆文库

🔗立即免费注册 开始体验工具箱 - 朱雀 AI 味降低到 0%- 降 AI 去 AI 味