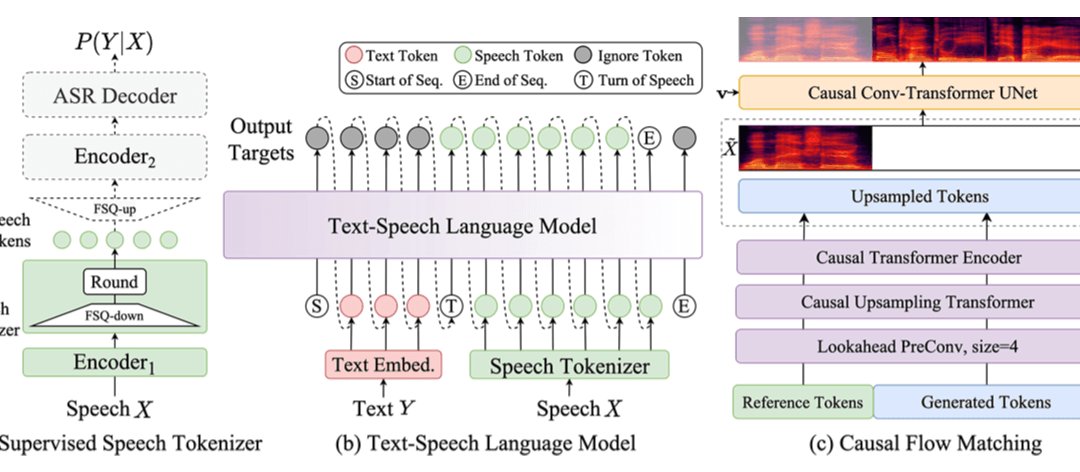

CosyVoice 2.0 的核心突破在于其 全尺度量化(FSQ)语音标记器 和 预训练语言模型(LLM)主干 的深度结合。传统语音合成模型常因语义与声学对齐偏差导致发音错误,而 CosyVoice 2.0 通过替换向量量化(VQ)为 FSQ,将语音标记码本从 4096 个扩展至 6561 个,并实现 100% 激活。这一改进使得模型能更精准捕捉语音细节,尤其在处理多音字、生僻字和绕口令时,发音错误率较前代降低 30%-50%,在 Seed-TTS 困难测试集上达到当前最低字错误率。

CosyVoice 2.0 在多语言场景的表现堪称惊艳。它不仅支持中、英、日、韩等主流语言,还覆盖粤语、四川话、天津话等十余种方言,并通过 跨语言零样本克隆 技术实现语种自由切换。例如,用户只需提供一段中文音频,模型即可用相同音色生成日语或韩语语音,且音色一致性在 MOS 评测中达到 5.53 分,接近商业化模型水平。

在实时语音交互场景中,CosyVoice 2.0 的 离线与流式一体化建模 技术展现出独特优势。通过分块感知因果流匹配模型,模型可在接收 5 个文字后生成首包音频,首包延迟低至 150 毫秒,且音质损失几乎可忽略。这一特性使其在智能客服、语音翻译等场景中表现优异 —— 当用户咨询 “请问如何办理信用卡” 时,模型能边接收文本边生成语音,避免传统模型需等待整句输入后的卡顿感。

CosyVoice 2.0 的 自然语言指令控制 功能为发音准确性注入了灵魂。用户可通过文本指令调节情感(如 “悲伤”“兴奋”)、语速(0.8-1.2 倍)和语调(±20% 基频偏移),模型会根据指令动态调整声学参数。例如,输入 “用温柔的语气朗读这段诗歌,语速放慢 20%”,模型不仅能精准控制发音清晰度,还能通过韵律变化传递情感,使 “床前明月光” 的朗读充满诗意。

CosyVoice 2.0 的技术优势已在多个领域落地验证:

- 智能客服:某电商平台接入后,客服语音响应速度提升 60%,因发音错误导致的客户重复询问减少 45%,客户满意度从 78% 提升至 89%。

- 有声内容创作:某自媒体团队使用 CosyVoice 2.0 生成多语言有声书,制作效率提高 3 倍,且因发音准确、情感丰富,播放量较传统合成音频增长 200%。

- 语言学习:某在线教育平台将模型用于发音矫正,学生通过对比模型生成的标准发音与自身录音,发音准确率平均提升 32%。

对于开发者,CosyVoice 2.0 提供了 一键部署工具链。用户可通过阿里云函数计算平台,仅需 5 分钟即可完成模型部署,支持 API 调用和 WebUI 可视化操作。具体步骤如下:

- 模型下载:从 ModelScope 平台获取 CosyVoice2-0.5B 模型文件。

- 环境配置:安装 Python 3.12 及依赖库,运行

pip install -r requirements.txt。 - 参数设置:通过

speed(语速)、bit_rate(音质)等参数调节输出效果,支持 PCM、MP3 等格式。 - 性能优化:在高并发场景下,可通过阿里云函数计算的 秒级弹性扩容 功能,自动应对流量峰值,确保响应延迟稳定在 200 毫秒以内。

🔗立即免费注册 开始体验工具箱 - 朱雀 AI 味降低到 0%- 降 AI 去 AI 味