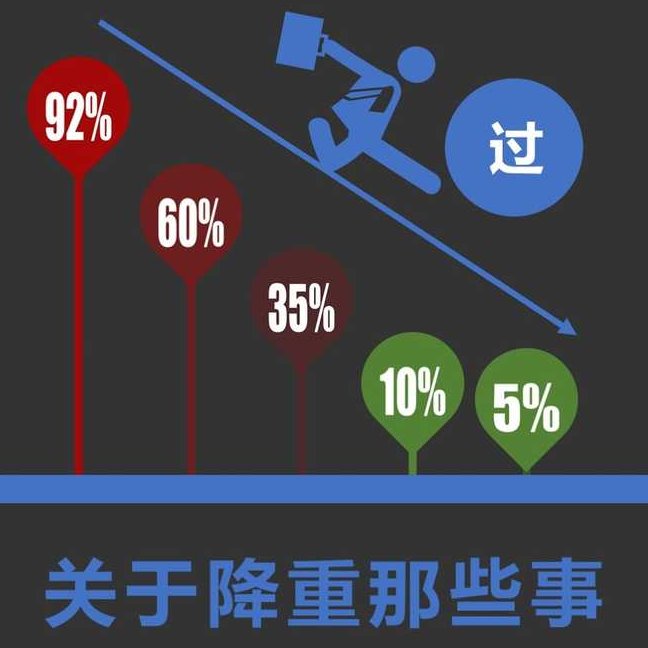

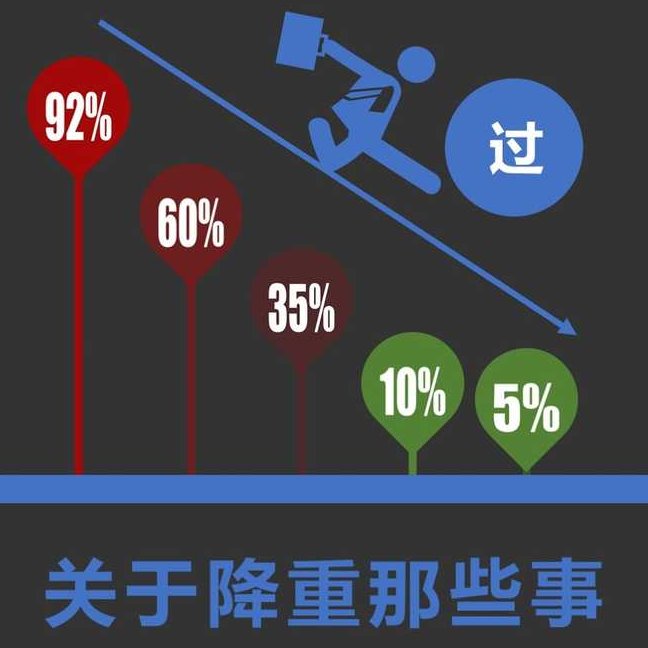

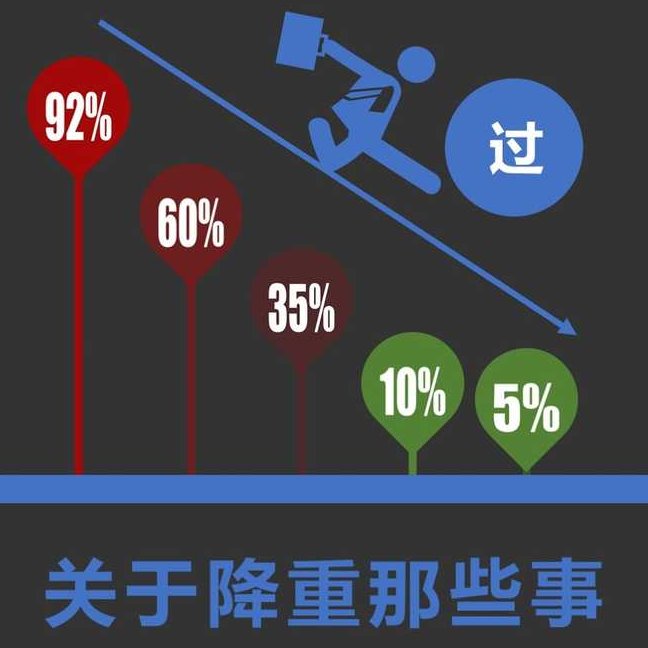

📌 别再盲目改论文了!越改重复率越高的坑,你踩中几个?

最近帮学弟看论文,他改到第三版,重复率从 20% 飙到 45%,差点哭出来。明明逐句替换了同义词,语序也打乱了,怎么就适得其反?这事儿压根不是简单换词能搞定的,今天就扒扒那些藏在降重里的暗坑,再给你一套能落地的修改逻辑。

🔍 陷阱一:同义词替换变成 “自杀式修改”

90% 的人第一步就做错了。打开百度翻译,把 “提高” 换成 “提升”,“分析” 换成 “剖析”,自以为天衣无缝。但知网、维普这些检测系统早就升级了,现在看的是语义相似度,不是单个词的匹配。

你试试把 “人工智能技术推动了医疗行业的发展” 改成 “AI 技艺促进了医疗领域的进步”。表面看每个词都换了,可系统一拆解,核心语义 “人工智能对医疗的积极影响” 没变,数据库里只要有类似表述,照样标红。更糟的是,有些同义词本身就是高频词汇,比如 “探讨”“研究”“分析” 在学术论文里重复率极高,你换得越勤,反而把不重复的地方改成了重复区。

见过最离谱的案例,有学生为了降重,把 “供应链管理” 换成 “供给链管控”,系统直接判定为错别字 + 语义模糊,不仅重复率没降,还被导师批注 “学术规范性不足”。

📝 陷阱二:语序颠倒 = 掩耳盗铃

“主谓宾” 换成 “宾谓主”,以为能骗过检测系统?太天真了。现在的算法能识别句式结构,哪怕你把 “小明吃苹果” 改成 “苹果被小明吃了”,只要核心要素没变,重复率该高还是高。

更麻烦的是,强行颠倒语序会让句子逻辑混乱。有篇经济学论文原本写 “通货膨胀导致居民消费能力下降”,改成 “居民消费能力的下降由通货膨胀造成”,读起来拗口不说,检测系统反而因为这种不自然的表达,把周边原创内容也归为疑似重复区 —— 系统会默认这种 “怪句子” 是抄袭后硬改的。

还有学生把段落里的句子打乱顺序,结果原本不重复的段落,因为和另一篇文献的句子排列逻辑撞了车,新增了 3 处标红。记住,检测系统不仅看单句,还看段落的语义流向。

✂️ 陷阱三:删减内容反而 “放大” 重复率

“把重复的地方删掉,总该降了吧?” 这是最常见的误区。假设你的论文总字数 5000 字,重复内容 1000 字,重复率 20%。如果删掉 500 字重复内容,总字数变成 4500 字,剩下的重复内容还有 500 字,重复率反而成了 11.1%?不对,这算法只适用于完全删除重复部分的理想情况。

现实是,你删掉的可能是重复和原创交织的内容。比如一段 300 字的话,150 字重复,150 字原创。删掉后,总字数减少 300,重复字数减少 150,看起来重复率不变。但关键是,剩下的论文里,其他重复内容的占比会被 “放大”。原本另一处 100 字的重复,在 5000 字里占 2%,在 4500 字里就占 2.2%,累积起来自然不降反升。

更蠢的是有人为了凑字数,删掉原创部分保留重复内容。见过一个极端案例,学生为了让论文达标,把自己写的案例分析删了,留下大段文献综述,结果重复率从 30% 涨到 60%,直接被打回重写。

🔄 陷阱四:过度依赖翻译软件搞 “机器降重”

“中文翻英文,再翻回中文,这不就原创了?” 现在的检测系统早就针对这套把戏升级了。翻译软件的逻辑是逐字转换,出来的句子往往是 “中式英语直译腔”,比如 “本文研究了……” 翻成 “This paper has studied...” 再翻回来,可能变成 “本论文已经研究了……”,语义没变化,还多了冗余词汇。

更坑的是,不同翻译软件的语料库高度重合。你用某度翻译改的段落,可能和另一篇用某道翻译降重的论文撞车,新增的重复率能让你欲哭无泪。有个学外语的同学,把摘要用 5 种语言来回翻,结果检测报告里出现了 4 处和其他论文的 “神奇重合”,全是翻译软件的锅。

而且机器翻译会毁掉专业术语的准确性。“边际效应” 被译成 “边缘影响”,“认知失调” 变成 “认识不一致”,学术严谨性没了,重复率还纹丝不动。

💡 正确修改逻辑第一步:先搞懂 “重复率” 的计算规则

别上来就改,先弄明白系统怎么算分。目前主流的检测系统(知网、维普、万方)都是用 **“连续字符匹配”+“语义指纹”** 双重判定。连续 13 个字符(汉字、英文单词、标点)和数据库重合,就会标红;同时,系统会给每句话生成 “语义指纹”,和已有文献比对,意思相近就算重复。

这意味着,改词不如改意,改句不如改逻辑。比如 “区块链技术具有去中心化、不可篡改的特点”,单纯改成 “区块键技艺具备去中心、不可变更的特征” 没用。但如果换成 “区块链通过分布式节点存储信息,既不需要中央枢纽管理,也无法单方面修改已记录的数据”,不仅语义更清晰,重复率也会大幅下降 —— 因为你重构了表达逻辑。

修改前先把检测报告里标红的句子摘出来,逐句分析:是字词重复?还是语义重复?前者好办,后者才是关键。

📊 正确修改逻辑第二步:建立 “原创表达库” 再动笔

每个专业都有独特的术语体系和表达习惯,与其对着重复句死磕,不如提前积累自己的 “话术”。比如法学论文里 “当事人应当承担举证责任”,可以换成 “举证义务由诉讼参与方自行履行”;计算机论文里 “算法复杂度为 O (n²)”,可以写成 “该算法的时间复杂度随数据量平方级增长”。

怎么建库?把近 5 年的核心期刊论文通读一遍,记录那些高频出现但表述多样的句子。比如 “研究方法包括文献分析、案例研究和问卷调查”,不同论文可能写成 “本研究综合采用文献梳理、个案剖析与问卷调研三种手段”,把这些表达整理成表格,改的时候直接替换,既保持专业度,又能避开重复。

我帮那个学弟改论文时,先让他把标红段落对应的文献找出来,对比着看人家的论证逻辑,再用自己的话重新写。比如原句抄了 “城市化进程加快导致耕地面积减少”,他改成 “随着人口向城市聚集,农村土地被征用的规模扩大,可用于耕种的土地数量逐年下降”,重复率直接从标红变成标绿(原创)。

🔗 正确修改逻辑第三步:用 “扩写 + 缩句” 调整段落结构

标红的段落别只改句子,试试调整整体结构。如果原文是 “总 - 分” 结构,你就改成 “分 - 总”;如果原文先讲现象再分析原因,你就先摆原因再描述现象。

具体操作:把标红段落拆成 “核心观点 + 论据 1 + 论据 2 + 结论”,然后给每个部分增加细节或精简表述。比如一段标红的文字:“共享单车解决了短途出行难题,但也带来了乱停放问题。” 扩写后可以变成 “在 3 公里以内的短途出行场景中,共享单车无需等待、随取随放的特点,让用户不再依赖公交或出租车。不过,由于缺乏统一的停放规范,地铁口、小区门口常常堆积大量单车,影响了行人通行和城市美观。” 字数增加了,原创度也上去了。

如果段落本身冗长,就用 “缩句 + 替换论据” 的方式。比如 “大数据技术通过收集海量用户数据,分析用户行为偏好,从而实现精准营销,这种模式在电商领域应用广泛,比如淘宝的推荐系统就是典型案例”,可以缩成 “电商平台利用大数据分析用户消费习惯,实现精准推送 —— 京东的‘猜你喜欢’功能就基于此逻辑开发。” 换掉案例,精简表述,重复率自然下降。

🎯 正确修改逻辑第四步:最后用 “反向检测” 验证效果

改完别急着提交学校检测,先用免费工具做 “反向验证”。把修改后的段落复制到百度、谷歌里搜一下,看看有没有高度相似的内容 —— 如果能搜到,说明改得还不到位。

再用 “同义词替换测试”:把你写的句子里的关键词换成同义词,看看意思是否改变。如果换了词意思就变了,说明你的表达还不够精准,可能存在语义模糊的问题,这时候要么换种说法,要么保留原词但调整前后文。

有个小技巧:把修改后的论文隔一天再看,用陌生的眼光读一遍,不通顺的地方往往就是没改彻底的 “重复隐患”。学术写作讲究 “读得顺、说得清、有新意”,做到这三点,重复率基本不会高。

最后提醒一句:降重的核心是 “重新表达”,不是 “掩盖重复”。与其花三天时间把重复率从 30% 降到 20%,不如花一天时间理解原文逻辑,用自己的专业知识重新写 —— 后者不仅重复率低,论文质量也会高一个档次。

【该文章由diwuai.com第五 ai 创作,第五 AI - 高质量公众号、头条号等自媒体文章创作平台 | 降 AI 味 + AI 检测 + 全网热搜爆文库🔗立即免费注册 开始体验工具箱 - 朱雀 AI 味降低到 0%- 降 AI 去 AI 味】