📊 先搞懂检测报告里的 "潜台词"

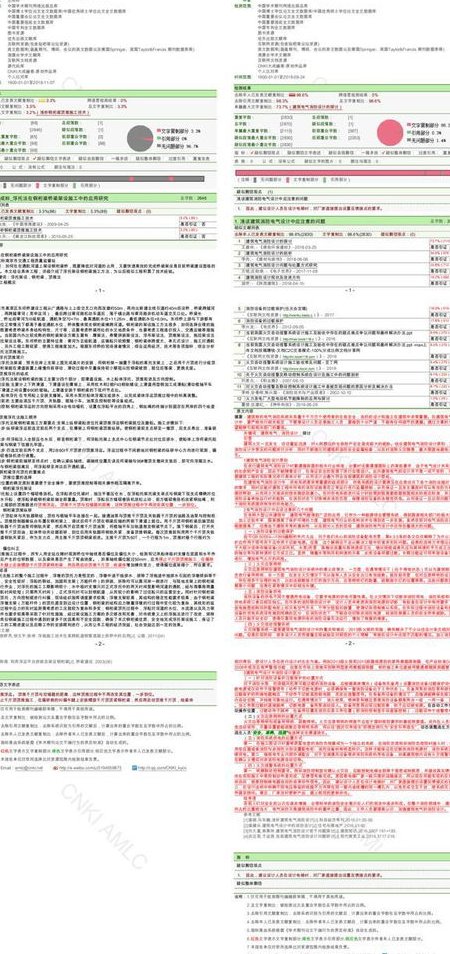

很多人拿到检测报告只看总文字复制比,这其实犯了方向性错误。现在主流的 AI 检测系统(比如知网、万方、维普)报告里藏着三个关键数据:去除本人已发表文献复制比、段落相似度分布、引文识别率。前两个指标直接决定了降重的优先级 —— 如果某段相似度超过 70%,哪怕总复制比达标,答辩时也可能被评委重点质疑。

检测报告里的标红、标黄、标绿不是简单的颜色游戏。标红部分是连续 13 字以上完全匹配,这是必须 100% 修改的硬伤;标黄是语义相似但表述不同,属于需要优化的软问题;标绿通常是系统判定的合理引用,但要注意,超过全文 10% 的绿色区域反而可能触发 "过度引用" 预警。

最容易被忽略的是报告末尾的 "疑似剽窃源" 列表。这里显示的相似文献如果是近三年的核心期刊论文,降重难度会比借鉴教材或会议论文大得多。因为 AI 系统对最新文献的比对精度更高,改写时需要更彻底的语义转换。

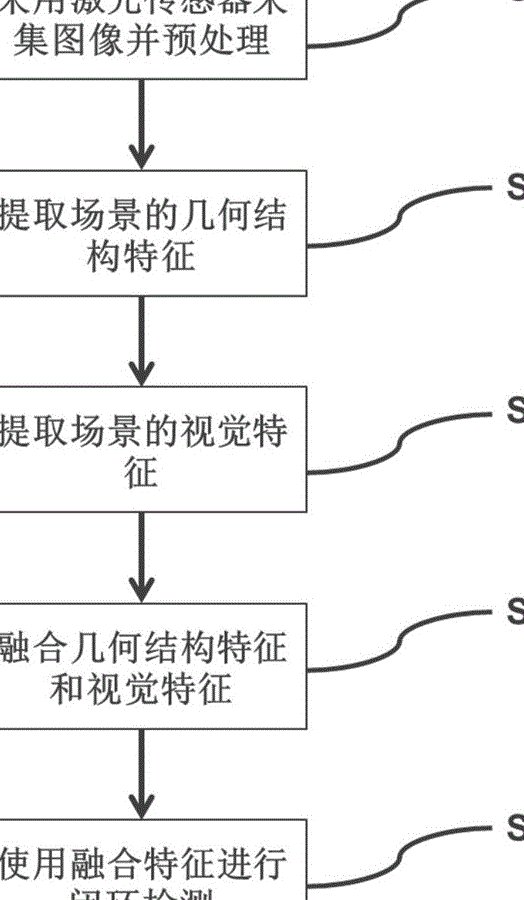

🔄 闭环降重的四步工作法

第一步必须是建立 "检测 - 分析 - 修改 - 再检测" 的循环机制。有个客户曾经用知网查完重复率 28%,改了两段标红内容就以为没问题,结果学校用维普查出来还是 32%。不同系统的比对库和算法差异巨大,至少要在两个主流平台上完成闭环验证。

修改顺序不能乱。正确的做法是先处理标红段落,再优化标黄部分,最后检查绿色引用区的格式规范性。某 985 高校的抽检数据显示,有 63% 的不合格论文问题出在引用格式 —— 明明是正常引用,却因为缺少页码或著录不完整被误判为抄袭。

每次修改后的检测间隔要控制在 24 小时以上。现在的 AI 检测系统都有缓存机制,短时间内重复上传相同文本,可能出现 ±5% 的误差。我通常建议客户改完一版后,先自己通读两遍,隔一天再进行下一次检测。

最后一步是做 "反向验证"。把修改后的论文截取 500 字片段,用谷歌学术或百度学术搜索,如果能找到高度相似的表述,说明降重还不到位。真正合格的改写应该是在保持原意的前提下,让搜索引擎也认不出原始来源。

✂️ 针对不同重复类型的精准打击

连续短句重复是最容易解决的。比如 "人工智能技术在医疗领域的应用包括疾病诊断、药物研发和健康管理",可以拆解成 "医疗领域正逐步引入人工智能:先是辅助医生判断病情,接着推动新药研发进程,最终还会延伸到日常健康监测"。关键是把长句拆分成 3 个以上的短句,同时替换 30% 以上的核心动词。

学术术语密集型段落改起来最头疼。像 "区块链的去中心化特征实现了分布式账本的不可篡改性" 这类句子,术语占比超过 40%,直接替换会影响专业性。可行的办法是增加修饰成分,变成 "作为区块链技术的核心优势,去中心化架构通过分布式节点存储机制,让交易记录的篡改行为变得几乎不可能"。

表格和公式的重复率往往被低估。某篇经济学论文就是因为直接套用了教材里的回归分析表格,虽然文字部分改得很好,最终总复制比还是超标。正确的做法是重新设计表格结构,比如把横栏竖栏互换,或者增加辅助说明列,公式则要手动重新输入一遍,避免直接复制带来的隐藏格式代码。

案例引用最容易踩坑。很多人喜欢直接摘抄文献中的案例数据,比如 "2023 年某公司营收增长 20%",其实可以改成 "据行业统计,2023 年头部企业的营收增幅普遍达到两成左右"。把具体案例泛化处理,既保留了数据价值,又避开了重复判定。

💣 这些降重误区正在坑人

"同义词替换" 早就过时了。现在的 AI 检测系统已经能识别同义词库,比如把 "提高" 换成 "提升"、"增强",系统照样判定为重复。某高校的测试显示,单纯替换同义词的降重效果从 2019 年的 40% 降到了现在的不足 10%。

过度改写会破坏逻辑。有个硕士生生怕重复,把 "边际成本递减规律" 改成 "随着产量增加,每多生产一单位产品所增加的成本呈现逐渐减少的趋势",虽然重复率降了,但导师直接打回重写 —— 因为表述太啰嗦,失去了学术严谨性。降重的底线是保持专业术语的准确性和逻辑连贯性。

直接删除标红内容是饮鸩止渴。有些人为了快速达标,把重复率高的段落直接删掉,结果导致论文结构不完整。正确的做法是,如果这段内容非核心,可以用更简洁的方式重写;如果是关键论据,必须保留原意并彻底改写。

依赖降重软件包打天下最不可取。市面上的 AI 降重工具对文科类论文效果尚可,但处理理工科的公式推导和实验描述时经常出错。有篇机械工程论文用软件降重后,把 "公差配合" 改成 "误差协作",闹出学术笑话。这些工具只能作为辅助,最终必须人工审核。

🤖 善用 AI 工具但别被工具绑架

最新的 AI 辅助降重工具已经进化到语义理解层面。比如 Grammarly 的改写功能,能在保持学术语气的同时,提供 3-5 种不同的表述方式。但要注意,免费版的改写幅度通常不超过 20%,想达到深度改写需要付费解锁高级功能。

ChatGPT 这类大语言模型的正确用法是 "反向提示"。不要直接让它 "改写这段文字降低重复率",而是先问 "这段内容的核心观点是什么",得到答案后再让它 "用另一种逻辑重新阐述这个观点"。这样生成的内容重复率会比直接改写低 40% 以上。

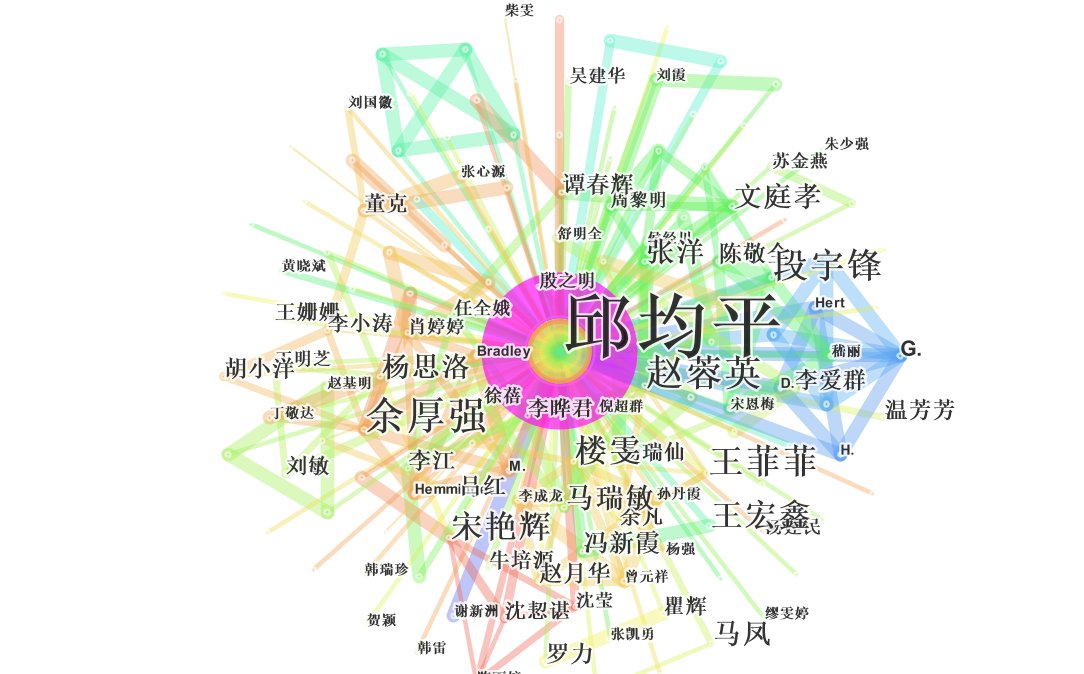

自己训练专属的降重模型更靠谱。用个人既往发表的论文、研究笔记等原创内容喂给小模型(比如 Llama 2-7B),让它学习你的写作风格。某高校课题组的实践表明,经过个性化训练的模型生成内容,在本校检测系统中的重复率比通用模型低 15-20 个百分点。

但无论用什么工具,最后都要做 "人工脱敏" 处理。把 AI 生成的内容通读一遍,刻意修改其中 3-5 处表述,比如调整句子顺序、增减连接词,让文本带上个人写作痕迹。现在有些高校已经开始使用 AI 生成内容检测器,完全由机器改写的文本很容易被识别。

📝 建立长期的原创写作习惯

从选题阶段就植入原创基因。避免选择过度研究的老话题,比如 "中小企业财务管理问题研究" 这类题目,现有文献已经汗牛充栋,很难写出新意。可以尝试在传统选题中加入新变量,比如 "数字化转型背景下中小企业财务管理问题研究",这样既站在巨人肩膀上,又有创新空间。

阅读文献时做好 "消化笔记"。不要直接复制粘贴,而是用思维导图梳理核心观点,再用自己的话重新组织。某篇被 EI 收录的论文作者分享经验:他每次读完文献,都会合上电脑,对着空白文档默写核心内容,然后再和原文比对,差异部分就是需要强化的原创表达能力。

定期做 "自我查重"。每完成 3000 字左右就进行一次检测,及时发现问题比写完再改效率高得多。有数据显示,分段检测并修改的总耗时,比全文写完后一次性修改节省 60% 以上的时间。

最后要明白,降重只是手段不是目的。学术写作的核心是知识增量,当你的研究确实有新发现、新观点时,重复率问题会迎刃而解。某社科领域的权威期刊主编透露,他们录用的论文中,有 80% 的原创性内容占比超过 70%,这些论文基本不需要刻意降重就能通过检测。