📌AIGC 内容检测新标准的诞生背景与核心要点

AIGC 技术这两年简直是坐了火箭,不管是文案、图片还是视频,AI 生成的内容在互联网上到处都是。这东西方便是方便,但问题也跟着来了。不少人用 AI 写文章应付工作、刷流量,甚至还有人用来搞学术造假。之前的检测技术根本跟不上 AI 进化的速度,很多平台都在抱怨,明明看着像 AI 写的,就是检测不出来。

也就是在这种情况下,AIGC 内容检测新标准慢慢浮出水面。这些新标准不再只盯着文字的表层特征,像句式重复率、常用词汇频率这些老办法早就过时了。现在更看重内容的逻辑连贯性、情感表达的自然度,还有和人类写作习惯的贴合程度。

就拿百度推出的新标准来说,它要求检测系统能识别出 AI 生成内容里那些 “看似合理实则矛盾” 的逻辑漏洞。比如一篇讲科技的文章,前面说某技术还在试验阶段,后面突然说已经大规模应用,人类写的时候可能会注意到这种矛盾,但 AI 有时候就会犯这种错。

还有谷歌的新标准,特别强调对 “创造性表达” 的判断。人类写作难免会有独特的比喻、个人经历的穿插,这些东西 AI 很难模仿得一模一样。新标准就要求检测工具能捕捉到这些细微的差别,区分出哪些是真正的人类原创,哪些是 AI 的 “模仿秀”。

🔍免费 AI 查重网站当前的检测困境

免费 AI 查重网站现在的日子可不好过。之前靠简单的算法就能混日子,现在面对不断进化的 AI 写作,简直是处处碰壁。

最明显的问题就是检测精度严重不足。现在的 AI 写作工具,像 GPT - 4、Claude 这些,写出来的东西越来越像人写的。有些用户还会故意对 AI 生成的内容进行 “人工润色”,改几个词,调整一下句式,免费查重网站就更难分辨了。有数据显示,去年很多免费查重网站对经过简单修改的 AI 内容,误判率超过了 40%。

数据库更新速度也是个大麻烦。AI 写作模型一直在更新,每天都在学习新的内容和表达方式。但免费查重网站资金有限,很难做到实时更新数据库。往往是这边刚把某个 AI 模型的特征录入进去,那边 AI 又升级了,检测系统直接就成了 “过时产品”。

还有就是对多模态内容的检测能力几乎为零。现在的 AI 不光能写文字,还能把文字、图片、音频混在一起生成内容。比如一篇文章里插了 AI 生成的图表,配了 AI 合成的音频解说,免费查重网站大多只能检测文字部分,对这种多模态内容根本无能为力。

用户体验也被拖累得不行。为了提高一点点检测准确率,有些免费网站不得不增加检测步骤,用户要等很久才能拿到结果。有时候还会出现 “误判”,把人类原创的内容标成 AI 生成的,不少用户都在吐槽,用着太闹心。

💡免费 AI 查重网站的技术升级路径

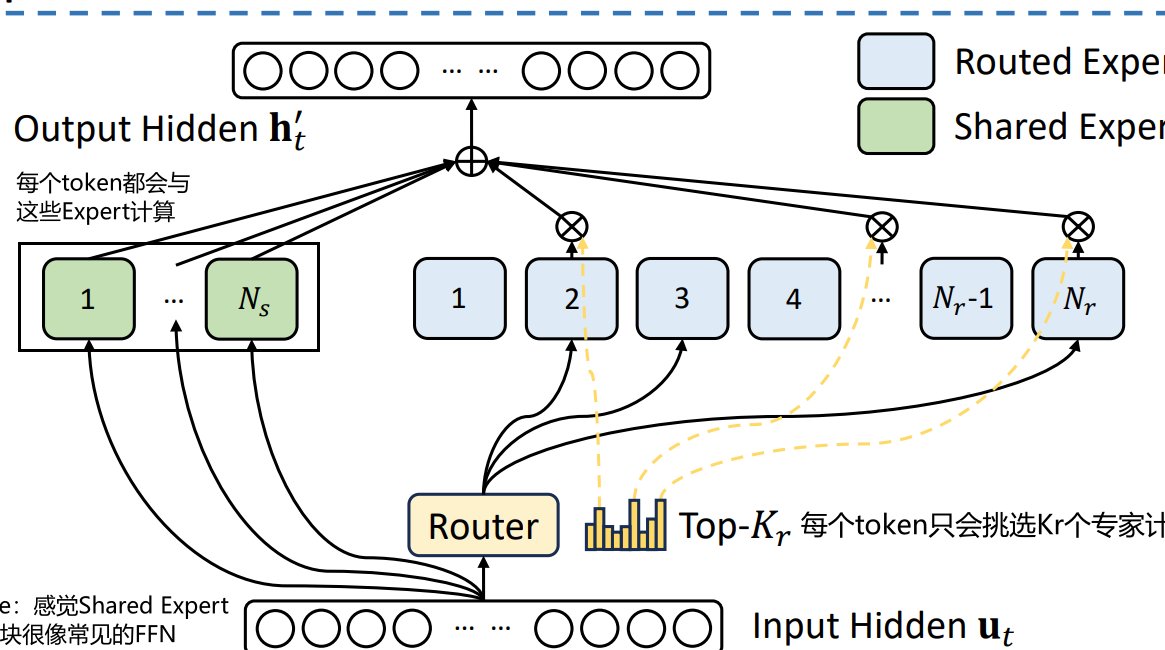

要想活下去,免费 AI 查重网站只能在技术上狠下功夫。首当其冲的就是算法重构。不能再依赖传统的比对方法了,得引入深度学习模型。比如用 Transformer 架构,让检测系统能像人类一样 “理解” 内容,而不是单纯地做文字匹配。

字节跳动旗下的某个免费查重工具已经在这么干了。他们的技术团队训练了一个专门的模型,让它每天 “阅读” 大量的人类原创和 AI 生成的内容,慢慢学会分辨两者在逻辑链条上的差异。经过半年的测试,检测准确率提高了 30% 多。

语义分析技术也得跟上。AI 生成的内容有时候在字面上挑不出毛病,但细究语义就会发现问题。比如描述一个情感场景,人类会用更细腻的词汇表达复杂的情绪,AI 可能就只会用一些通用的形容词。免费网站可以开发更精准的语义分析模块,捕捉这些差异。

实时学习机制也不能少。AI 写作在进化,检测系统也得跟着进化。可以搭建一个动态更新的数据库,把每天新出现的 AI 生成内容和人类原创内容都加进去,让检测模型每天都能学到新东西。就像 360 的免费查重平台,他们和几十家内容平台合作,实时获取最新的文本数据,检测能力一直在提升。

🤝合作与数据共享:提升检测能力的有效途径

单靠一个网站的力量很难应对 AI 写作的进化,合作才是出路。不同的免费 AI 查重网站可以抱团取暖,共享各自的检测数据和技术经验。比如 A 网站在检测 GPT 生成内容方面有优势,B 网站对 Claude 生成的内容更敏感,他们可以互相分享特征库,一起提高整体的检测水平。

和高校、研究机构合作也很有必要。这些地方有最前沿的 AI 研究成果,免费查重网站可以和他们共建实验室,把学术研究和实际应用结合起来。清华大学的自然语言处理实验室就和几个免费查重平台合作过,开发出了一种新的检测算法,对 AI 生成的诗歌、散文这类文学性内容的识别准确率提高了不少。

内容平台的数据支持也很关键。像微信公众号、知乎这些平台,每天都有海量的原创和 AI 生成内容。免费查重网站可以和它们合作,获取这些内容的标注数据,用来训练检测模型。当然,这得建立在严格的隐私保护基础上,不能泄露用户的个人信息。

行业协会也能发挥作用。可以由行业协会牵头,制定统一的数据共享标准和检测规范。避免大家各自为战,重复开发。现在已经有几个互联网行业协会在组织这方面的讨论,不少免费查重网站都表示愿意参与。

🚀未来 AIGC 内容检测的发展趋势

AIGC 内容检测肯定会朝着更智能、更精准的方向发展。多模态检测会成为主流,以后不光要检测文字,图片、音频、视频里的 AI 生成内容都得能识别。比如 AI 生成的虚拟主播视频,检测系统要能从表情、动作、语音等多个维度去判断。

实时检测也会越来越普及。用户在发布内容的时候,检测系统就能实时给出判断,而不是像现在这样,要等用户主动去查重。这就要求检测技术的响应速度更快,算法更高效。

检测标准会越来越统一。现在不同平台的检测标准五花八门,同一个内容,在这个平台被判为 AI 生成,在那个平台又说是原创。未来可能会有一个行业公认的标准,大家都按这个标准来,减少争议。

人机协同检测也可能成为一种新模式。机器负责初步筛选,把疑似 AI 生成的内容挑出来,再由人工进行复核。这样既能保证效率,又能提高准确率。特别是对于一些专业性很强的内容,像学术论文、法律文书,人工复核就显得尤为重要。

另外,用户教育也会成为检测体系的一部分。让用户了解 AI 生成内容的特点和潜在风险,鼓励大家原创。有些平台已经开始做这方面的工作,在查重结果页面加了一些科普内容,告诉用户怎么区分 AI 和人类写作。

免费 AI 查重网站要想在这场技术较量中存活下来,就得紧跟这些趋势,不断投入研发,积极合作。毕竟,AI 写作还在进化,检测技术也不能停下脚步。