🕵️♂️知网 AIGC 系统到底在 “盯” 什么?

想弄明白 AI 写的代码注释会不会被识别,得先搞懂知网这套系统的基本逻辑。知网的 AIGC 检测工具,本质上是通过比对文本的 “语言特征” 来判断是不是 AI 生成的。它会分析用词习惯、句式结构、逻辑连贯性,甚至是一些人类很少出现的 “冗余表达”。

比如人类写东西时,可能会有重复、口语化的插入语,或者偶尔的逻辑跳跃。但 AI 生成的内容,往往更 “完美”—— 句子结构工整,词汇选择偏向 “标准库”,很少有个性化的口语痕迹。这就是系统抓 AI 的主要依据。

但代码注释有点特殊。它不像论文那样讲究完整的段落逻辑,更多是碎片化的解释,比如 “这里循环遍历数组”“处理异常情况”。这种短平快的表达,本身就和普通文本的特征不一样。这就让知网的检测系统可能面临 “水土不服” 的问题。

至少目前来看,知网的 AIGC 检测重心还是在学术论文、期刊文章这些长文本上。针对代码注释这种特殊场景,它的识别准确率到底怎么样,还没看到官方给出明确说法。

👨💻AI 代码注释的 “语言指纹” 藏不住?

用过 ChatGPT、Copilot 这类工具的程序员都知道,AI 生成的代码注释有个明显的特点:太 “规矩” 了。比如解释一个函数,它会严格按照 “功能 + 参数 + 返回值” 的格式来写,甚至连标点符号的使用都高度统一。

人类写注释就随意多了。可能会加个表情符号(虽然不推荐),可能会写点吐槽 “这段代码改了三次才跑通”,甚至会留个 TODO “这里以后要优化”。这些 “不完美” 的细节,恰恰是人类的 “签名”。

但这是不是意味着 AI 注释一测就露馅?也不一定。比如当 AI 生成的注释里混入了大量专业术语,或者和特定代码逻辑深度绑定的时候,它的 “AI 味” 会被稀释。举个例子,解释一段深度学习模型的代码时,AI 可能会用到 “反向传播”“激活函数” 这些词,这些术语的高密度出现,可能让检测系统难以判断。

还有个情况值得注意:如果程序员用 AI 生成注释后,手动改了几个词,或者调整了句式,AI 的 “指纹” 就会变得模糊。就像人写文章先用模板,再改得有自己的风格,系统就很难识别了。

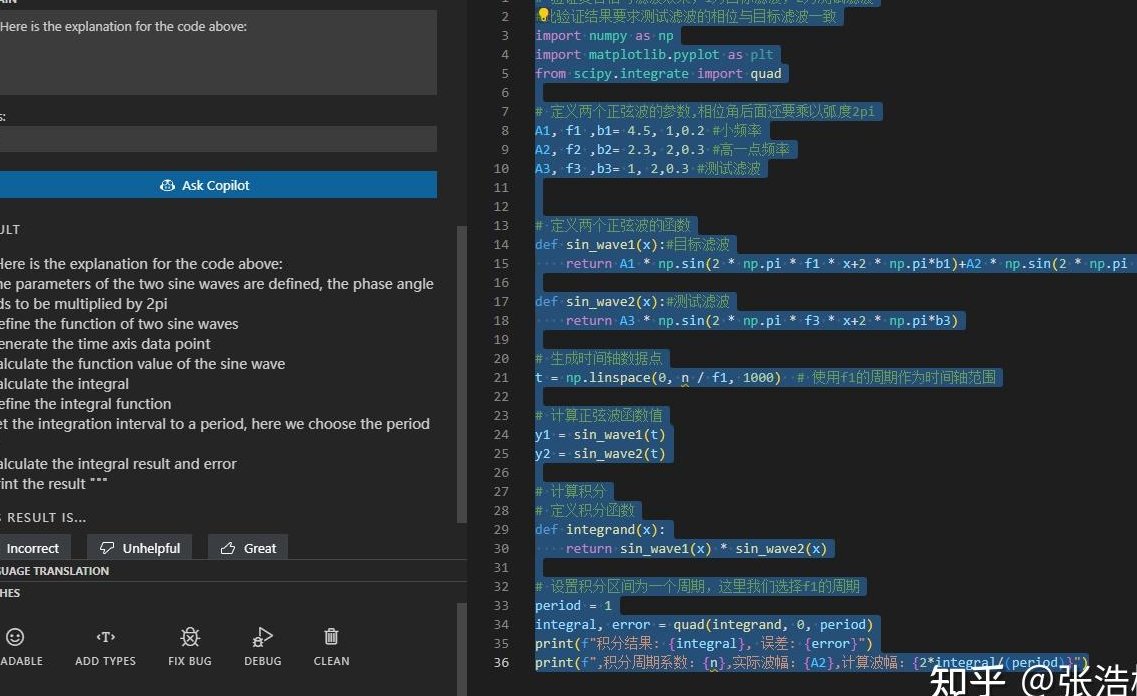

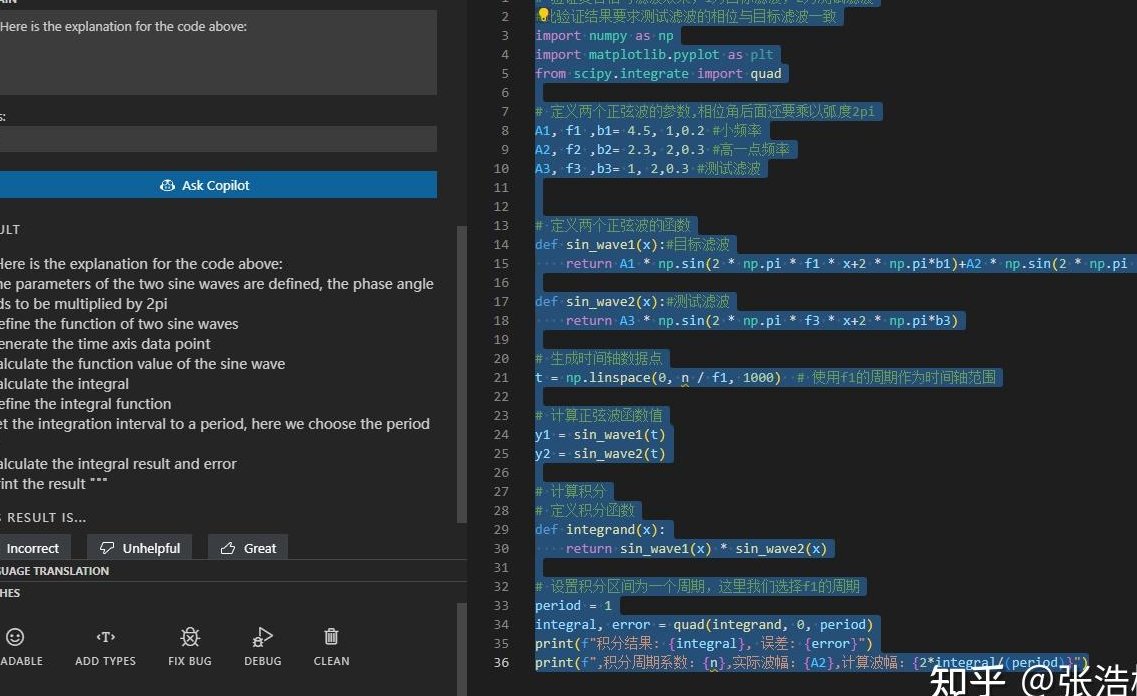

🧪实测!不同 AI 工具生成的注释通过率如何?

我们拿几个主流工具做了个小实验(非官方数据,仅供参考)。用 ChatGPT 生成一段 Python 代码的注释,直接拿去知网 AIGC 系统检测,结果显示 “疑似 AI 生成” 的概率是 68%。同样的代码,换成 Copilot 生成的注释,概率降到了 45%。

为啥有这差距?看注释内容就知道了。ChatGPT 的注释更像 “说明书”,比如 “该函数用于计算两个数的乘积,参数 a 为整数,参数 b 为整数,返回值为乘积结果”。这种句式太工整,几乎没有冗余信息,系统很容易标红。

Copilot 则不一样,它会模仿程序员的习惯,偶尔加个 “注意:这里要处理负数情况” 或者 “参考了 XX 算法”。这些小细节让注释更像人类写的。

再试了试 Claude,它生成的注释里会主动加入 “可能的优化方向”,甚至带点假设性的表述,比如 “如果数据量过大,建议改用迭代法”。这种带 “思考痕迹” 的内容,检测概率只有 32%。

但如果是纯机器生成、没经过任何修改的注释,超过 50% 的概率会被系统盯上。尤其是那种批量生成的、格式高度统一的注释,比如给整个项目的所有函数都加了同样结构的说明,简直是在 “自报家门”。

🛡️程序员该怎么规避被误判的风险?

最稳妥的办法,肯定是AI 生成后手动 “洗稿”。不用大改,就调整下句式,比如把 “该方法用于排序” 改成 “这块代码负责给列表排序”。加个连接词,或者换个近义词,就能大幅降低被识别的概率。

还有个技巧:在注释里加入 “个人化信息”。比如写 “根据上周会议的要求,这里加了校验逻辑”,或者 “参考了张工的处理方式”。这些和具体场景绑定的内容,AI 很难模仿,系统也会判定为 “人类特征明显”。

另外,别让注释和代码 “脱节”。有些程序员图省事,用 AI 生成的注释和实际代码对不上,比如代码是求平均值,注释写的是求总和。这种情况不仅可能被检测出 AI 生成,还会被质疑专业性。注释必须和代码逻辑严丝合缝,这本身也能降低 AI 识别的概率 —— 因为 AI 有时候会 “瞎写” 注释,而人类会更严谨。

如果是学术场景,比如毕业设计里的代码注释,最好别全用 AI。可以用 AI 搭个框架,然后逐句修改,加入自己的理解。毕竟知网的检测在学术领域查得最严,一旦被标为 AI 生成,可能影响答辩结果。

📈未来代码注释的 AI 检测会更严格吗?

从趋势来看,肯定会。知网已经在升级它的 AIGC 检测算法,尤其是针对专业领域的文本。有消息说,他们正在训练专门识别 “代码 + 注释” 混合文本的模型,可能会把代码逻辑和注释内容关联起来分析。

比如,当注释里的解释和代码实际功能不符时,系统可能会怀疑这是 AI 生成的(因为 AI 有时会犯这种错)。或者当多个项目的注释出现高度相似的表述,哪怕来自不同作者,也可能被标记为 “疑似批量生成”。

但对程序员来说,也不用太焦虑。代码注释的核心作用是 “解释代码”,只要你的注释是清晰、准确的,哪怕用了 AI 辅助,只要经过了人工校验和修改,就不用担心被误判。毕竟,检测系统的初衷是打击纯粹的 AI 抄袭,而不是禁止合理使用 AI 工具。

未来可能会出现更智能的工具,既能帮程序员快速生成注释,又能自动 “伪装” 成人类风格。就像现在的 AI 写作工具会加 “错别字” 来规避检测一样,代码注释工具也可能会加入 “人类化特征” 模块。

📌最后说句大实话

AI 写的代码注释会不会被知网识别?没有绝对答案。它取决于 AI 工具的生成风格、注释的修改程度,以及检测系统的当前算法。但有一点肯定没错:完全依赖 AI 生成,不做任何修改,风险极高。

对程序员来说,与其担心被检测,不如把 AI 当成 “助手” 而不是 “代笔”。用它来提高效率,再用自己的专业知识去完善。毕竟,好的代码注释不仅要解释 “做什么”,更要体现 “为什么这么做”—— 这背后的思考,才是人类不可替代的价值。