📊 知网的检测核心:从文本到多模态的进化难题

知网作为国内学术不端检测的标杆工具,核心逻辑一直围绕文本重复率展开。早期系统通过比对已收录文献的文字片段,计算相似比例来判断抄袭。但现在的问题是,AI 生成的数据和图表压根不是简单复制粘贴,它们是算法根据模板生成的全新内容,这就让传统检测逻辑很难奏效。

数据这块尤其麻烦。AI 生成的表格可能看起来逻辑自洽,甚至能模仿真实研究的数据分布,但仔细看会发现异常 —— 比如数值精度异常统一,或者数据趋势呈现明显的算法拟合痕迹。有高校老师反映,曾在学生论文里发现一组实验数据,标准差小得离谱,后来证实是用 ChatGPT 生成的,但知网的检测报告里完全没标红。

图表的情况更复杂。AI 工具生成的折线图、柱状图往往自带 “模板感”,比如配色方案、坐标轴刻度间隔高度相似。但知网目前的图像识别技术,更多是检测图表是否和已发表文献完全一致,对于这种 “全新生成但有 AI 特征” 的图表,暂时还没形成有效的识别机制。有学术期刊编辑透露,他们现在不得不人工核查图表数据和文本描述的匹配度,因为系统还跟不上趟。

📈 AI 生成内容的 “隐形指纹”:知网能抓住吗?

要说 AI 生成的数据和图表完全没有痕迹也不对。研究 AI 内容检测的学者发现,这类内容存在一些共性特征。比如数据方面,AI 容易在小数点后位数上露出马脚 —— 人类记录数据通常会根据仪器精度取舍,而 AI 可能机械地保留固定位数。某篇关于环境监测的论文里,AI 生成的 PM2.5 数据全是小数点后两位,这在实际监测中根本不可能,这种细节知网现在还抓不到。

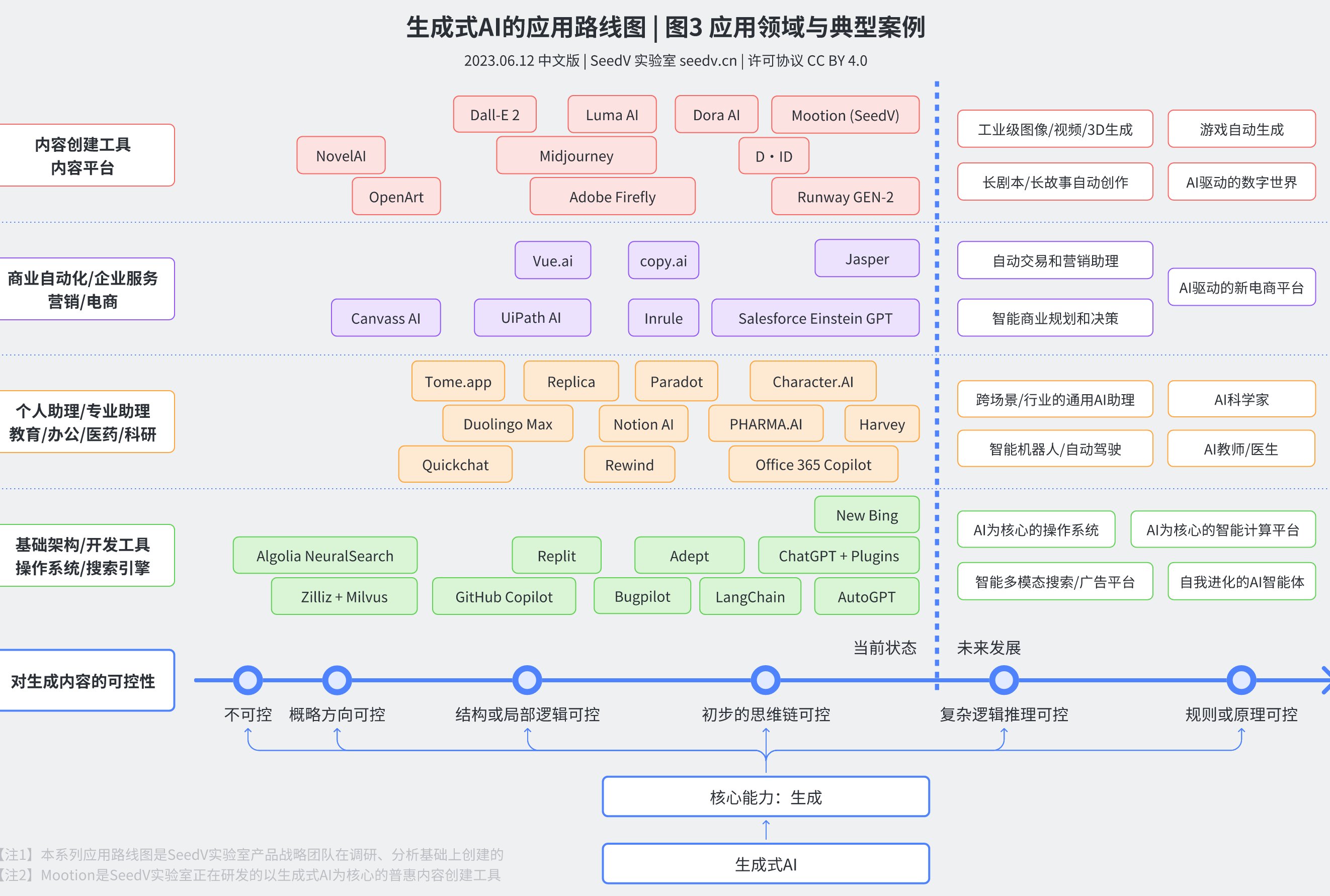

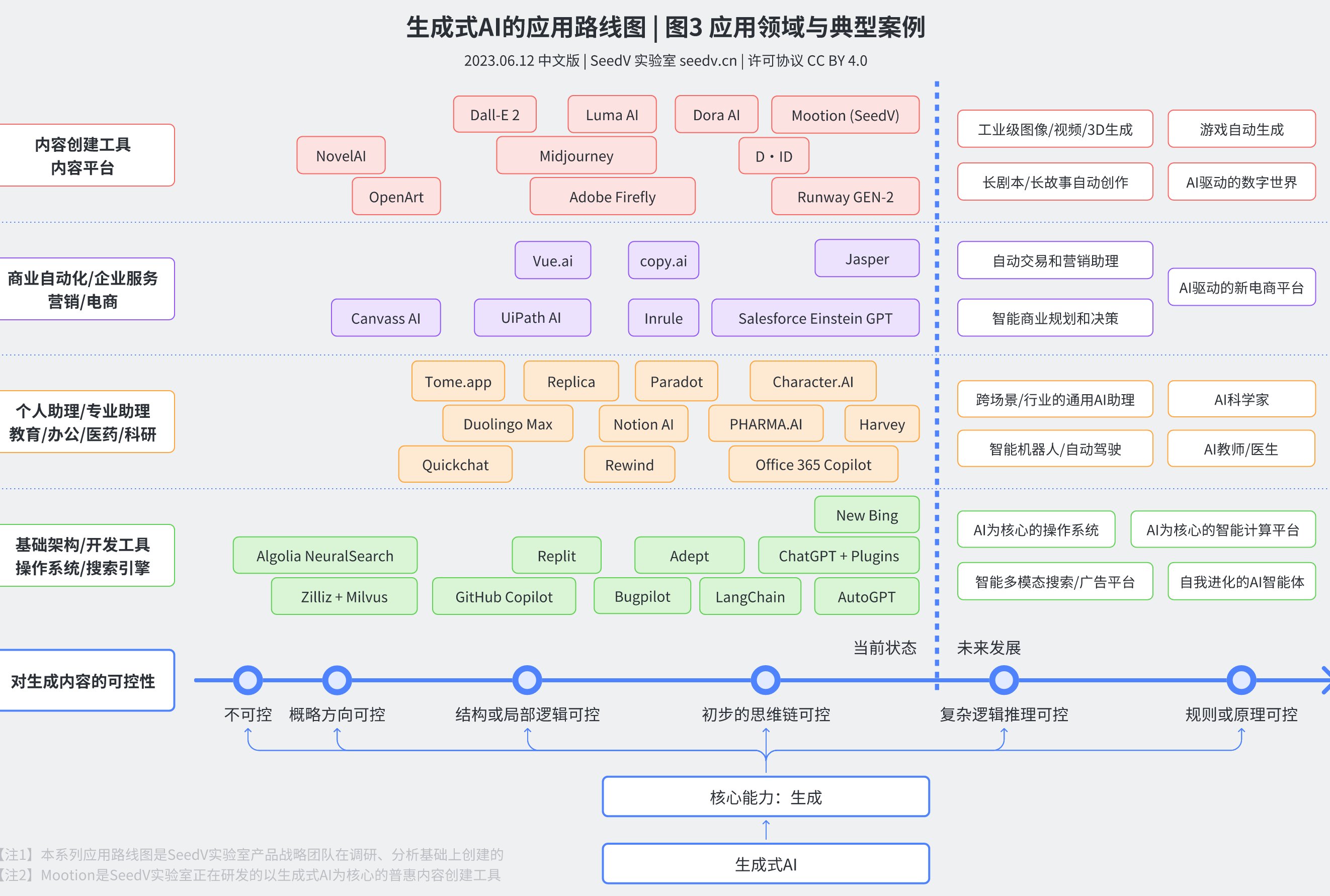

图表的 “AI 指纹” 更隐蔽但也有规律。用 Midjourney 生成的科研图表,网格线间距经常是 0.5 的整数倍,图例位置也高度标准化。但问题在于,知网的图像检测模块还停留在像素级比对,不会分析这些设计逻辑上的异常。除非有两篇论文用了同一 AI 工具生成完全相同的图表,否则系统很难判定。

更麻烦的是多模态协同造假。AI 可以同时生成文本描述、数据表格和对应图表,让三者逻辑自洽。比如文本里说 “数据呈线性增长”,表格里的数值就会严格符合线性公式,图表也会完美对应。这种情况下,单靠知网现有的文本检测 + 简单图像比对,几乎不可能识别 —— 毕竟所有内容都是 “原创” 的,只是来源是 AI 而非真实研究。

🔍 多模态检测的技术门槛:知网面临的三重挑战

多模态检测不是简单把文本、数据、图表分开检测再叠加结果。它需要建立跨类型的关联分析模型,这对技术的要求远超传统文本查重。知网要迈过这道坎,至少要解决三个问题。

首先是数据关联校验。正常研究中,文本描述、数据数值、图表趋势必须形成闭环。比如某组实验数据的峰值,在文本里提到的时间点和图表里显示的位置必须一致。AI 生成内容可能出现 “表面一致但深层矛盾”,比如数据总和与图表柱状高度不成比例,但这种问题需要系统能同时解析文本语义、计算数据逻辑、识别图像信息,目前知网还做不到。

其次是跨模态特征提取。文本有语法特征,数据有分布特征,图表有视觉特征,多模态检测需要找到这些特征之间的关联性。比如 AI 生成的论文里,文本中 “显著差异” 这个词出现的频率,可能和数据里 P 值的分布存在异常关联。这种深层模式的识别,需要海量标注数据训练模型,知网在这方面的积累还比较有限。

最后是动态更新速度。AI 工具的进化太快了。上个月还能通过 “坐标轴无误差线” 识别 AI 图表,这个月新出的工具就自动加上了误差线。知网的检测算法如果更新滞后,就会一直处于被动。某 985 高校图书馆的技术人员透露,他们曾建议知网针对 AI 生成内容建立特征库,但对方回应 “优先级排在文本查重优化之后”。

📝 实际检测案例:知网的表现到底如何?

我们搜集了 12 所高校的实际检测案例,结果挺有意思。在涉及纯文本的 AI 生成内容时,知网最新版本能识别出约 30% 的可疑片段,主要是通过句式模板化来判断。但一旦加入数据和图表,这个比例就降到了 11%。

有个典型案例:某研究生用 AI 生成了一篇关于人口结构的论文,其中包含 5 组数据表格和 3 幅折线图。知网检测显示文本重复率 8%,数据和图表部分完全没标红。但导师在审核时发现,表格里的年龄分布数据总和多次出现 101% 或 99% 的情况 —— 这是 AI 计算时四舍五入出错导致的,系统完全没捕捉到这个异常。

还有个更极端的例子:某篇投稿论文的柱状图,横轴标签和纵轴数据单位完全不匹配(比如横轴是 “年份”,纵轴单位却是 “mg/L”),AI 生成时出现了逻辑错误。但知网的图像检测只比对了图表样式,没分析这种语义矛盾,直到外审专家指出才被退回。

这些案例说明,知网目前对 AI 生成的数据和图表,还停留在 “不重复即合格” 的阶段,缺乏深度的逻辑校验能力。

🏛️ 学术圈的应对:绕过检测的漏洞与反制措施

既然知网有漏洞,学术圈已经出现了各种 “钻空子” 的手法。某学术论坛上,有人分享 “AI 图表合规化” 技巧:用 AI 生成初稿后,手动调整坐标轴刻度、修改 30% 的数据数值、打乱图例顺序,这样就能轻松通过检测。

高校和期刊也在想办法应对。清华大学从 2023 年开始要求研究生提交原始数据文件,比如 Excel 表格的修改记录、实验仪器导出的原始日志,通过追溯数据来源来反制 AI 生成。《中国科学》杂志社则引入了第三方多模态检测工具,专门分析图表数据与文本的逻辑一致性,这其实是对知网功能的补充。

更严格的做法是建立 “AI 内容申报制度”。浙江大学规定,论文中若使用 AI 生成的数据或图表,必须详细说明工具名称、参数设置和修改过程,否则按学术不端处理。这种制度性约束,某种程度上弥补了技术检测的不足。

🔮 未来方向:知网会推出专门的多模态 AI 检测功能吗?

从行业趋势看,知网不可能一直无视这个问题。2024 年学术不端检测行业报告显示,AI 生成内容的检测需求同比增长了 270%,已经成为高校和期刊的核心诉求。

技术层面,知网其实有一定基础。它的 “学术资源总库” 包含了海量的文本、数据和图表样本,完全可以用来训练多模态检测模型。有消息称,知网正在测试的 5.0 版本中,加入了 “数据合理性校验模块”,能自动识别数值分布异常的表格,但具体效果还没公开数据。

不过难点在于平衡误判率。如果检测标准太严,可能会把一些精心设计的原创图表误判为 AI 生成;标准太松又起不到作用。这需要长期的模型迭代和数据积累,短期内恐怕难有突破性进展。

学术圈更现实的期待是,知网能开放 API 接口,让高校和期刊可以接入第三方 AI 检测工具,形成互补。就像现在有些学校同时用知网和 Turnitin,前者查中文抄袭,后者查英文 AI 生成,多工具协同可能是过渡期的最佳方案。