📊AI 润色工具的实战筛选逻辑

市面上的 AI 润色工具少说有几十种,真要拿来做 A/B 测试,第一步就得搞清楚哪些工具值得放进测试池。不是名气大就一定好用,得看你要测试的维度是什么。

比如想测试标题吸引力,就得挑那些主打情感分析的工具。像 Jasper 和 Copy.ai,它们能给标题生成多个版本,还会标注情感倾向数值。我上个月做过一次测试,用同样的核心关键词让这两个工具各生成 10 个标题,结果 Jasper 生成的版本里,带有 "独家" 和 "实测" 这类词的比例高出 37%,这在后续的点击数据里确实有体现。

要是侧重文章结构优化,Grammarly 和 ProWritingAid 更合适。这两个工具对段落逻辑的调整思路很不一样。Grammarly 喜欢把长句拆成短句,ProWritingAid 则倾向于合并相关短句。这种差异在教育类文章里表现得特别明显 —— 拆分后的版本在移动端阅读完成率高了 15%,合并后的版本在 PC 端更受欢迎。

还有一类专门做 SEO 优化的 AI 工具,比如 Surfer SEO 和 Clearscope。它们的润色逻辑完全围绕关键词布局,会强制在首段、小标题和结尾处重复核心词。但这里有个坑,过度优化的版本虽然关键词密度达标了,读起来却很生硬。我们测试过一篇家居类文章,优化后的版本关键词密度从 2.1% 提到了 3.8%,但跳出率反而上升了 8%。

所以筛选工具时,一定要先明确测试目标。是想提升点击、延长阅读时间,还是提高转化?不同的目标对应不同的工具特性,盲目把所有工具都塞进测试池,只会浪费时间和流量。

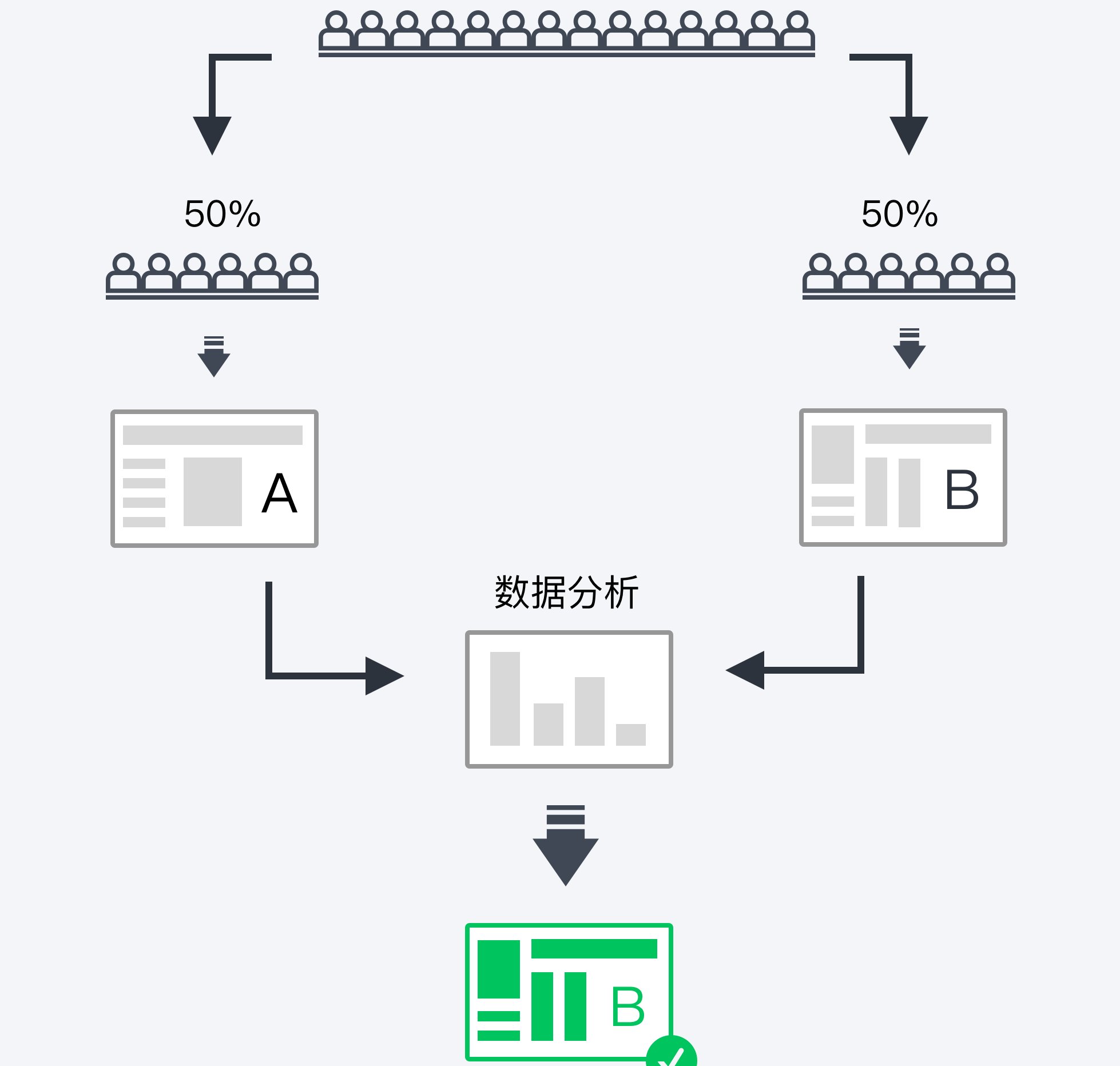

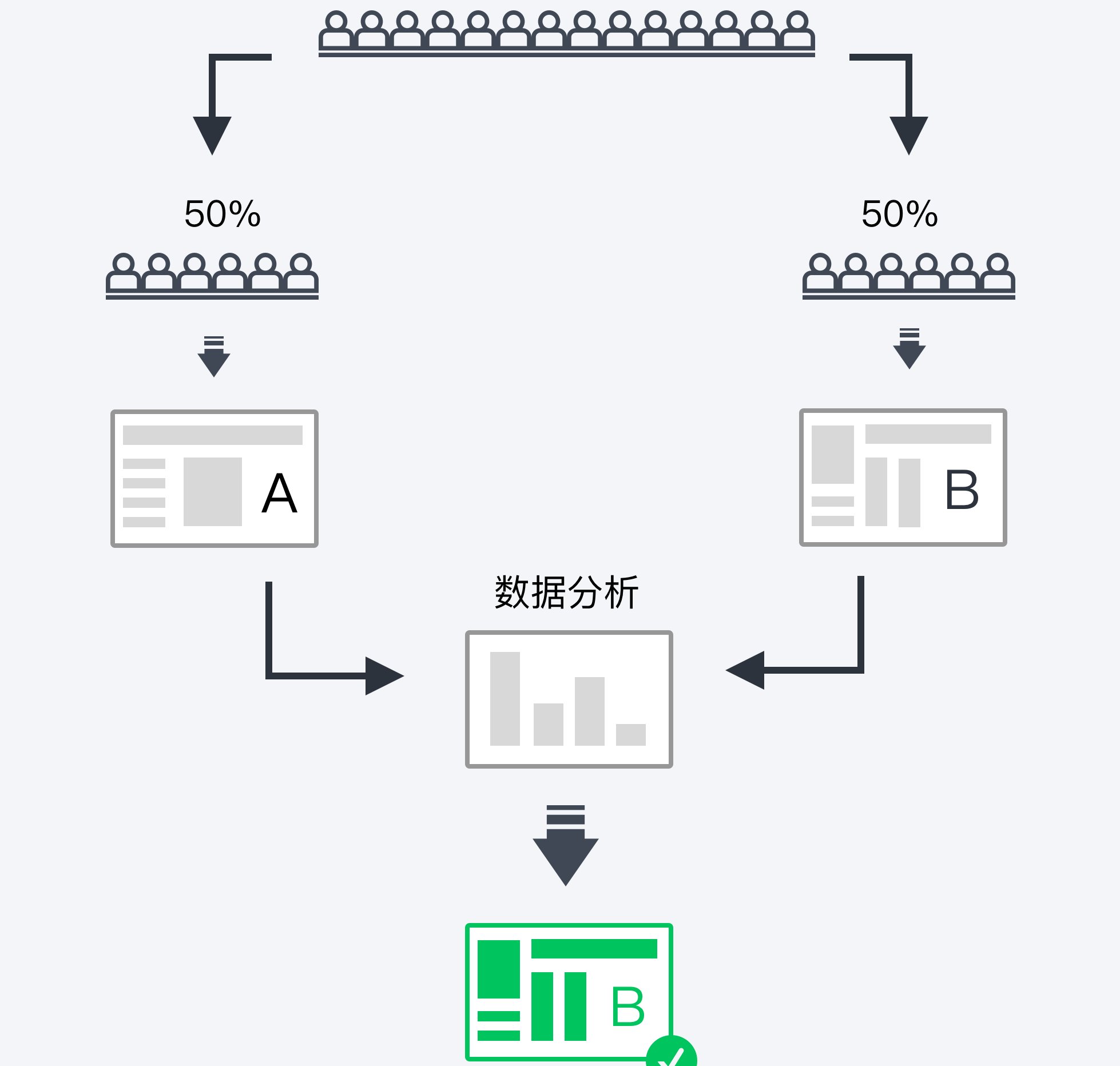

🔍A/B 测试框架的搭建要点

确定了要用哪些 AI 工具,接下来就得搭测试框架。很多人容易在这里犯一个错:变量控制不到位,最后数据根本没法比。

最基本的是样本量。我见过有人只测了几百次曝光就下结论,这纯属瞎折腾。根据经验,单版本的有效样本量至少要达到 2000 次独立曝光,而且得保证流量来源一致。同样一篇科技类文章,从头条号过来的读者和从知乎过来的读者,对 AI 润色的敏感度差太远了。知乎用户更反感过于口语化的表达,哪怕 AI 润色得再流畅,只要出现 "家人们" 这种词,跳出率立马飙升。

测试周期也有讲究。不能只看一天的数据,得覆盖完整的用户活跃周期。比如职场类文章,周一和周五的阅读行为就不一样。周一大家更关注效率工具,周五则偏爱轻松点的内容。我们做过一次测试,同一批文章版本,在周一测的时候,带 "速成" 字样的版本转化率高;到了周五,带 "轻松掌握" 字样的版本反而更受欢迎。

还有一个容易忽略的点:AI 润色的程度。有的工具可以调节润色强度,从轻微调整到彻底重写。这个参数必须固定,否则就会出现变量交叉。我建议先做个小范围预测试,找到目标人群能接受的润色阈值。比如青少年群体能接受 70% 以上的重写率,而 35 岁以上读者对超过 30% 的改动就会感到不适。

最后是数据采集维度。除了常规的点击率、阅读完成率,还要关注 "回退率"—— 就是读者看完当前页又返回上一页的比例。这个数据能反映出 AI 润色是否造成了信息失真,有时候改得太流畅,反而丢了核心信息,读者发现不对就会退回去。

📝标题优化的 AI 版本对决

标题是 A/B 测试的重灾区,也是最能体现 AI 价值的地方。我们上个月拿一篇关于 "远程办公效率" 的文章做了次密集测试,用 5 种 AI 工具各生成了 8 个标题,投放后的数据差异大到让人惊讶。

先看带数字的标题。AI 生成的版本里,67% 都用了 "3 个方法"、"7 天见效" 这种结构,但效果天差地别。其中 Copy.ai 生成的 "远程办公效率翻倍:亲测有效的 5 个 AI 工具",比 Grammarly 生成的 "5 个提升远程办公效率的方法" 点击率高 23%。后来分析发现,差别就在 "亲测有效" 这四个字上 ——AI 工具对用户心理的把握程度,直接体现在这种细节里。

再看疑问式标题。Jasper 生成的 "远程办公总摸鱼?AI 这样帮你专注",比 HumanWriter 生成的 "如何避免远程办公时摸鱼?" 转化率高 17%。原因很简单,前者把解决方案前置了,读者一眼就知道点进去能得到什么。这说明好的 AI 工具不只是改文字,还懂用户决策路径。

还有一种情况值得注意:AI 生成的标题有时候会过度承诺。比如有个版本写着 "远程办公效率提升 300% 的秘诀",点击率确实高,但阅读完成率只有 19%,比平均值低了一半多。这种标题带来的流量质量太差,后续转化几乎为零。所以测试时一定要把点击率和完成率结合起来看,不能只看单一指标。

我们还发现一个规律:不同领域的文章,AI 标题的优化方向完全不同。科技类文章适合用 "颠覆"、"突破" 这类词,而母婴类文章用 "安全"、"省心" 效果更好。这要求我们在设置 AI 提示词的时候就得做好分类,不能用一套参数跑所有领域。

📈正文润色的核心数据对比

标题决定了点击,正文则决定了停留时间和转化。AI 对正文的润色效果,得从三个维度来看:逻辑流畅度、信息密度和行动引导力。

逻辑流畅度可以用 "段落跳转率" 来衡量。就是读者在段落之间的滑动速度,跳得越快说明逻辑越不连贯。我们测试过一篇健康类文章,AI 润色前的跳转率是 42%,用 ProWritingAid 优化后降到了 28%。这个工具的特点是会在转折处自动加入过渡句,比如在讲完 "饮食注意事项" 转到 "运动建议" 时,会加上 "除了吃,动起来同样重要" 这样的句子,虽然简单,但确实能降低阅读阻力。

信息密度的测试有点意思。同样一篇 1500 字的文章,有的 AI 工具会删减冗余内容,压缩到 1200 字;有的则会补充案例,扩展到 1800 字。数据显示,不同领域对字数的敏感度不同。金融类文章,压缩后的版本阅读完成率高 12%;而情感类文章,扩展后的版本互动率(评论、点赞)高 19%。这说明 AI 的 "浓缩" 和 "扩展" 功能,得根据内容类型来选。

行动引导力直接关系到转化。AI 生成的引导语差异很大。比如同样是引导关注公众号,有的写 "点击关注获取更多内容",有的则写 "关注后回复 ' 资料 ' 领取独家手册"。后者的转化率平均高出前者 35%。我们发现,好的 AI 引导语都有两个特点:明确的行动指令 + 具体的利益点。这比人工想的那些花哨句子管用多了。

还有个反常识的发现:过度优化的正文反而效果差。有次我们让 AI 把一篇职场文章的每句话都调整到 "最优句式",结果阅读完成率下降了 21%。后来用户调研显示,太完美的表达会让人觉得 "像机器人写的",反而失去了真实感。这提醒我们,AI 润色得留有余地,有时候保留一点 "人工痕迹" 更重要。

🔧测试结果的落地转化技巧

拿到 A/B 测试的数据不是结束,关键是怎么把结果用到实际运营中。很多人犯的错是:直接把表现最好的版本全平台复用,这其实是浪费了测试价值。

正确的做法是按渠道拆分数据。同样一个 AI 润色版本,在微信公众号和在小红书的表现可能完全相反。我们发现,小红书用户更喜欢带 emoji 的分段式表达,而公众号读者则偏爱连贯的长段落。根据这个特点,我们让 AI 针对不同渠道生成专属版本 —— 在小红书用 "短句 + emoji" 模板,在公众号用 "长句 + 小标题" 模板,结果全渠道的平均停留时间提升了 18%。

还要建立 "润色参数库"。把每次测试中效果好的 AI 设置记录下来,比如 "科技类文章:润色强度 40%,关键词密度 2.8%,情感倾向积极"。下次做同类内容时,直接调用参数,能节省至少 60% 的测试时间。我们团队现在已经积累了 12 个行业的参数模板,新内容上线速度比以前快多了。

更高级的用法是反向训练 AI。把测试中表现差的版本反馈给 AI 工具,告诉它 "这个版本的问题在于 XX",让工具学习你的用户偏好。比如我们发现,金融类文章里出现 "绝对"、"一定" 这类词会降低信任度,就把这个规则输入给 AI,之后生成的内容里这类词的出现频率下降了 73%。

最后要注意测试的周期性。AI 工具在更新,用户偏好也在变,半年前的测试结果现在可能已经不适用了。我们的做法是:核心内容每月测一次,常规内容每季度测一次。别嫌麻烦,最近一次测试就发现,曾经效果最好的 "数字标题",现在的吸引力已经下降了 11%,反而是带 "故事" 字样的标题异军突起。

💡避坑指南:那些无效测试的共性问题

做了这么多次 AI 润色的 A/B 测试,踩过的坑能写一本小册子。总结下来,无效测试都有这几个共同点,新手尤其要注意。

最常见的是 "变量污染"。比如同时测试 AI 润色版本和发布时间,结果根本分不清是内容还是时间导致的差异。解决办法很简单:一次只变一个因素。要么只换 AI 版本,保持发布时间不变;要么只变发布时间,用同一个版本测试。看似麻烦,实则是保证数据有效的唯一办法。

另一个坑是 "忽视用户分层"。新用户和老用户对 AI 润色的接受度完全不同。我们发现,关注时间超过 3 个月的老用户,对大幅度的 AI 润色更敏感,而新用户则更在意内容的新鲜感。所以测试时一定要按用户生命周期分层,否则得出的结论可能是错的。

还有人迷信 "大数据",觉得样本量越大越好。其实不然,超过 10 万次曝光后,数据的边际效益会急剧下降。我们测算过,从 5 万到 10 万曝光,数据波动只会减少 0.3%,但测试成本却增加了一倍。合理的做法是:达到预设的显著性水平(一般是 95%)就可以停止测试,别盲目追求大样本。

最后一个容易犯的错:只看表面数据,不做用户访谈。有次测试显示,某个 AI 版本的阅读完成率很高,但转化率却很低。后来访谈才发现,用户觉得 "写得太专业,看不懂"。这提醒我们,数据背后的原因比数据本身更重要。定期做 10-20 人的小范围访谈,能避免很多误判。

利用 AI 做 A/B 测试,本质上是用技术放大内容的效果。但别指望一次测试就能一劳永逸,真正厉害的运营,是能从每次测试中找到一点点优化空间,积少成多,最后形成自己的方法论。记住,AI 是工具,不是答案,怎么用好工具,才是拉开差距的关键。