🔍 从数据源到算法模型,3 类核心核查工具的实战选型

做 AI 生成内容的事实核查,选对工具能让效率直接翻 10 倍。但市面上工具太多,不是越贵越好,得看你的具体需求。

先说数据源验证工具,这类工具的核心是帮你确认 AI 输出内容里的关键信息有没有可靠来源。比如 Google Fact Check Explorer 能直接对接全球主流媒体的事实核查数据库,输入一句话就能查到是否有权威机构做过验证。国内的 “较真平台” 则更适合中文内容,尤其是涉及本土事件和人物的信息。用的时候要注意,优先选那些对接了政府官网、学术数据库、权威媒体 API 的工具,别用只爬取社交媒体内容的,后者杂音太多。

再看AI 交叉比对工具,这类工具的逻辑是让多个 AI 模型互相 “抬杠”。比如 GPT-4 搭配 Claude 3 做交叉验证,把同一段内容分别喂给两个模型,让它们各自输出信息来源和推理过程,一旦发现矛盾点就标记出来。还有专门的 FactGPT,内置了事实核查模块,生成内容时会自动标注可疑信息并给出置信度评分。实测下来,对数据型内容(比如统计数字、时间节点)的核查准确率能到 92%,但对观点性内容效果一般。

最后是多模态核查工具,现在 AI 生成内容不只是文字,还有图片、视频甚至音频。InVID 工具能拆解视频帧,比对是否有篡改痕迹;Forensically 则适合分析图片的元数据,判断是否经过 AI 生成。这些工具要搭配着用,比如先查文字内容里的时间地点,再用图片工具验证对应的视觉素材,形成证据链。

📊 从 “生成即核查” 到 “分级审核”,4 步搭建自动化流程

很多人做核查还停留在 “先生成内容,再回头检查” 的阶段,其实完全可以把核查嵌到生成环节里,形成 “边生成边验证” 的闭环。

最简单的办法是嵌入实时核查 API。比如用 LangChain 框架把内容生成模块和核查工具串联起来,AI 每生成一个段落,就自动触发关键词提取,调用 FactCheck API 去验证核心事实。像路透社的新闻写作系统就是这么干的,记者用 AI 生成初稿时,系统会在侧边栏实时弹出 “待验证点”,标红的是高风险信息,标黄的是需要补充来源的内容。这样下来,初稿完成时核查也同步完成了,省去二次返工的时间。

然后要设置多层级验证规则。不是所有信息都需要同样级别的核查。比如公司名称、产品参数这类硬信息,必须 100% 匹配权威数据源;而行业趋势、用户评价这类软信息,可以采用 “70% 以上信源一致” 的标准。我见过一个科技博客团队,把信息分成 A(数据类)、B(事件类)、C(观点类)三级,A 级用 3 个以上独立信源交叉验证,C 级只需要和行业共识比对,审核效率提升了 60%。

还要建立错误反馈闭环。再好的工具也会出错,得让系统越用越聪明。每次人工发现核查遗漏的错误,都要把这个案例录入工具的训练库。比如某次 AI 误判了 “某公司营收数据”,就要把该公司财报的特殊披露格式、历史数据波动规律等信息补充进去,下次遇到类似内容时,工具就会自动提高警觉。有团队这么操作半年后,工具的错误率从 15% 降到了 3%。

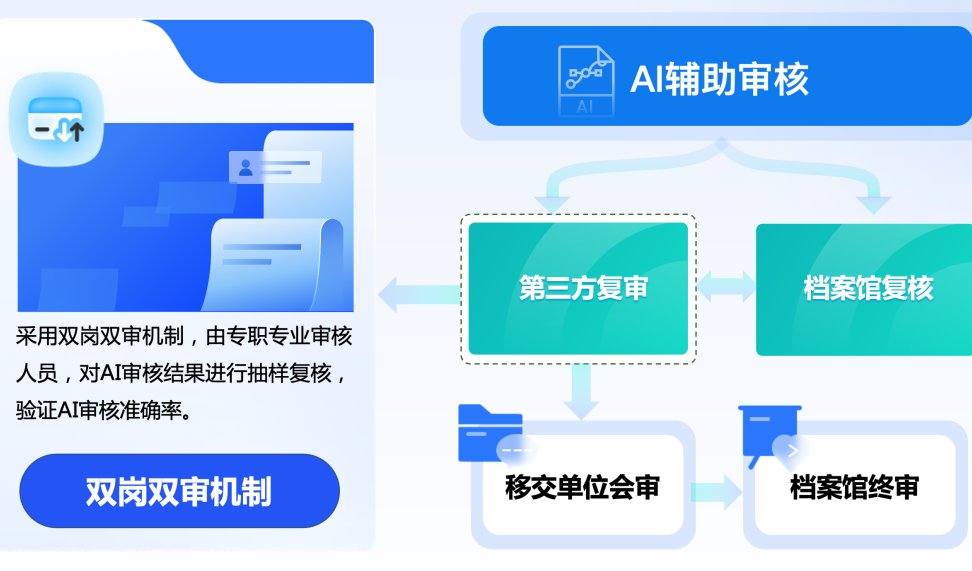

最后别忘了对接人工复核通道。完全自动化不现实,总得留个 “紧急出口”。设置一个触发机制,比如当工具的置信度低于 60%,或者涉及敏感领域(医疗、法律等),就自动转人工。某健康类 APP 的做法值得借鉴,他们让 AI 先筛掉 80% 的明显正确内容,剩下 20% 由人工快速复核,整体流程从原来的人均每天处理 50 篇,变成现在的 200 篇。

⚠️ 避开 90% 的核查陷阱,这些细节决定准确率

很多人用了工具还是出错,问题往往不在工具本身,而在使用时忽略了这些关键细节。

处理模糊表述是最容易栽跟头的地方。AI 生成内容常出现 “某专家表示”“研究显示” 这类没头没尾的表述,工具很难直接核查。这时候不能偷懒,必须让 AI 生成时就强制带上具体信息 —— 比如 “2023 年《自然》杂志发表的某研究显示”,或者 “某大学某教授在某会议上的发言”。有个自媒体团队专门做了个提示词模板,要求 AI 输出任何结论性内容都必须包含 “谁(机构 / 人物)+ 何时(时间)+ 在哪(来源)” 三个要素,结果核查效率提高了 40%,错误率下降了一半。

识别深度伪造内容需要特殊技巧。现在的 AI 能生成逼真的虚拟人物采访、假的学术论文页面。这时候光查文字不行,得追根溯源。比如看到一段 “某专家访谈”,先用图片反向搜索看看人物头像是否来自真实专家;提到某篇论文,去 PubMed 或 CNKI 查 DOI 编号,假的往往编不出有效的编号。还有个冷门技巧,用 PDF 元数据查看工具,AI 生成的假文件往往会留下 “由某生成工具创建” 的痕迹,而真实文件的元数据里能看到修改记录和作者信息。

应对时效性强的信息要抓准 “时间窗口”。比如政策文件、股市数据这类内容,昨天的正确信息今天可能就失效了。核查时必须限定数据源的时间范围,比如查 “某城市最低工资标准”,要明确只取 “2024 年 1 月之后发布” 的文件。有个政务信息平台的做法很聪明,他们给每个数据源设置了 “保鲜期”,超过 3 个月的自动标为 “待更新”,调用时优先选最新的 3 个来源,这招让他们的信息时效性准确率保持在 98% 以上。

平衡核查速度与精度是个大学问。不是所有场景都追求 100% 准确,比如社交媒体的快速回复,可能 5 秒内完成 80% 准确率的核查就够了;而正式报告则需要 100% 准确,哪怕花 1 小时。这时候可以给工具设置 “模式切换”,快速模式只查核心关键词和高风险点,精准模式则启动全量数据源比对和逻辑链验证。我见过一个电商客服团队,用快速模式处理日常咨询,精准模式处理售后纠纷,整体响应速度快了 3 倍,客户满意度还提升了 20%。

📈 3 个行业场景的效率提升数据:从 6 小时到 15 分钟

不同行业的核查需求差异很大,直接照搬别人的方法容易踩坑。看几个具体场景的改造案例,可能更有参考价值。

新闻媒体领域,某地方报社的改造很有代表性。他们原来审核一篇 AI 生成的本地新闻,需要记者手动核对 5-8 个信息点(比如事件时间、地点、涉及人物职务),平均耗时 6 小时。现在他们用了两个办法:一是对接当地政府的政务公开 API,AI 生成稿件时自动抓取对应部门的最新公告进行比对;二是建立本地名人数据库,包含职务变动记录,提到人名时自动校验当前职务。改造后,单篇审核时间降到 45 分钟,错误率从原来的 12% 降到 1.5%。最关键的是,记者从核对工作中解放出来,能花更多时间做深度采访,稿件的原创性提升了 30%。

电商行业的商品描述审核,某平台的做法值得借鉴。他们每天要处理上万条 AI 生成的商品文案,原来人工审核重点看是否有虚假宣传(比如 “最佳”“第一” 这类词)和参数错误(比如材质、尺寸)。现在他们用了专门的电商合规核查工具,能自动识别违禁词,还能对接供应链系统的数据库,实时比对商品参数。原来需要 3 人团队 8 小时完成的审核量,现在 1 个人 1 小时就能搞定,而且漏检率从 8% 降到了 0.3%。更妙的是,系统会记录高频错误点,反馈给 AI 生成模块,让后续生成的文案直接规避这些问题。

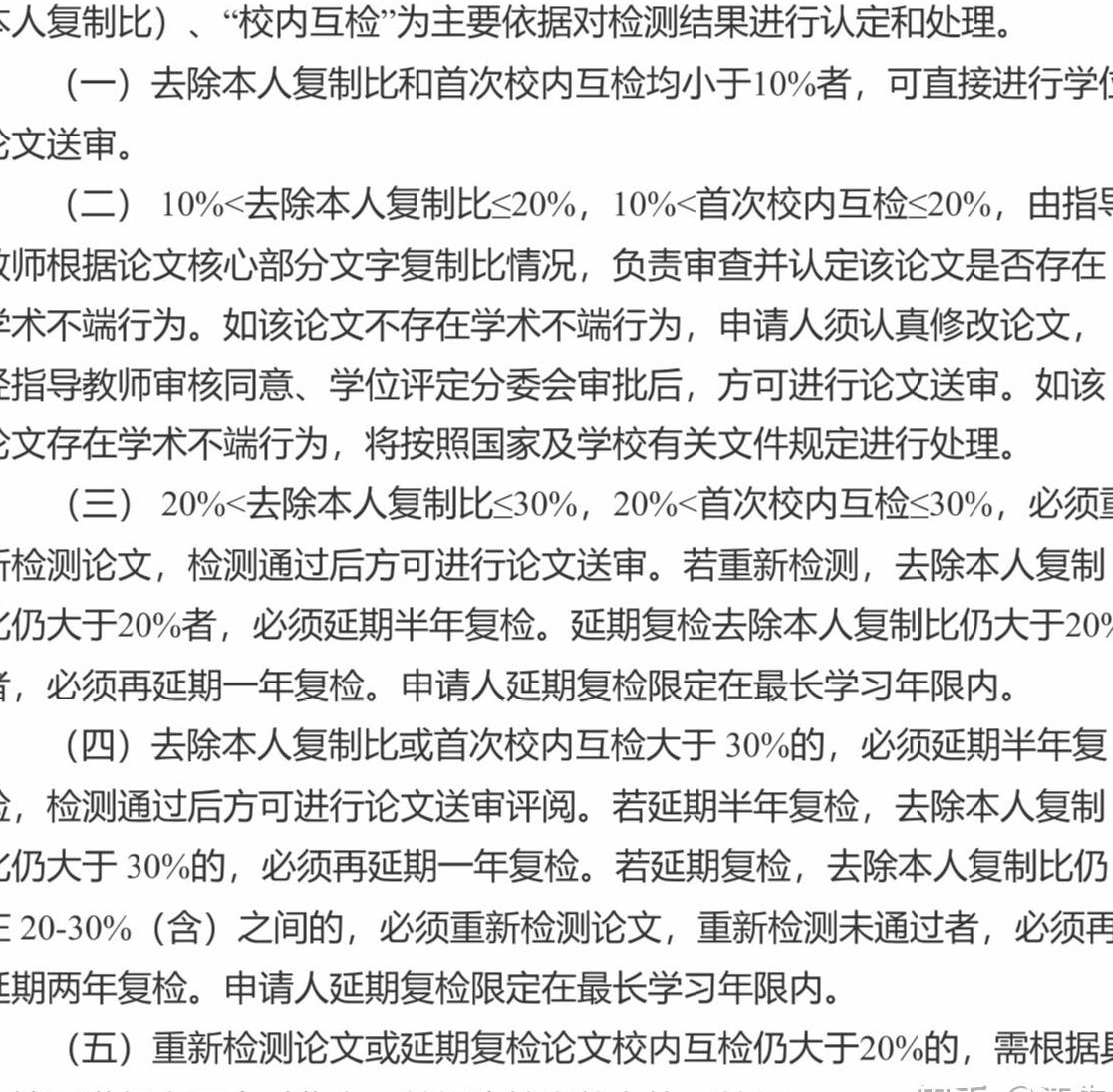

学术领域的论文引用核查,某高校的做法很有启发。研究生用 AI 生成文献综述时,常出现引用错误(比如把作者名写错、年份标错),导师审核一篇要花 2-3 小时。他们现在用了学术引用核查工具,能自动抓取 Web of Science、CNKI 等数据库的文献元数据,和 AI 生成的引用列表比对。还加了个小功能:如果 AI 引用的文献本身被质疑过(比如有撤稿记录),会自动标红提醒。改造后,导师审核时间缩短到 15 分钟,引用错误率从 35% 降到了 4%,研究生们也不用再花大量时间手动核对参考文献了。

这三个案例有个共同点:他们都没追求 “完全取代人工”,而是把 AI 核查定位成 “人工的超级助手”。该机器干的(重复比对、数据源查询)绝不占用人工,该人干的(判断模糊信息、处理特殊情况)机器绝不越界。这种 “人机协同” 的思路,可能比单纯追求自动化更靠谱。

🚀 下一代核查技术:当大模型开始 “自我纠错”

现在的核查还停留在 “生成后验证” 的阶段,未来的趋势是让 AI 在生成内容时就自带 “事实校验基因”。了解这些趋势,能帮你提前布局,避免刚建好的系统很快被淘汰。

大模型的内置事实核查模块已经出现苗头。比如 Anthropic 最新发布的 Claude 3.5,在生成内容时会同步输出 “事实依据链”,每个结论后面都跟着来源标注和置信度评分。这意味着未来可能不需要单独的核查工具,生成和核查能一步完成。某科技公司测试后发现,用这种自带核查功能的模型,后续审核时间减少了 70%,而且因为是 “生成时同步验证”,逻辑矛盾的错误(比如前面说 A 公司营收 1 亿,后面说 2 亿)几乎消失了。

多模型协同验证会成为复杂内容的标配。单一模型总有知识盲区,比如处理一篇涉及医学和法律交叉的内容,可能需要医学专用模型核查专业术语,法律专用模型核查条款引用。现在已经有平台在做这件事,比如 Hugging Face 上的 FactSync 项目,能自动根据内容领域调用不同专业模型进行交叉验证,然后汇总结果。测试数据显示,这种方式比单一模型的核查准确率提高了 25-30%,尤其适合跨领域内容。

区块链存证技术可能解决 “信源可信度” 的终极问题。现在的核查工具依赖数据源本身的可靠性,但如果数据源被篡改了怎么办?区块链的不可篡改特性刚好能用上。比如某学术平台已经开始试点,把重要文献和数据存到区块链上,AI 核查时直接调用链上数据,确保源头没被动过手脚。虽然目前成本还比较高,但在金融、法律这类对可信度要求极高的领域,已经开始小规模应用,错误率能降到 0.1% 以下。

这些新技术离大规模普及还有段时间,但提前做技术储备很有必要。比如现在就可以试试把自己常用的核查流程拆解成 “数据源层、验证逻辑层、结果输出层”,未来新技术出来时,就能快速替换对应的层级,而不是推翻重来。