🚀 Colossal-AI:46 倍硬件成本压缩的技术革命

🔥 三大核心优势

- 显存压缩黑科技

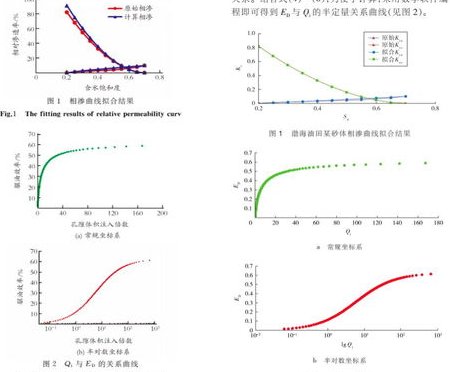

它采用的Flash Attention 技术能把注意力计算的显存消耗降低 23%,配合ZeRO+Gemini 内存管理,直接把 1750 亿参数的 BLOOM 模型推理显存压缩到 23.2GB,在 8 卡 3090 服务器上就能流畅运行,硬件成本比 A100 方案低 10 倍以上。

实际操作时,用户只需在代码中添加一行colossalai.launch,就能自动调用这些优化策略,完全不需要手动调整分布式参数。

- 全流程降本覆盖

从模型训练到推理部署,Colossal-AI 提供端到端解决方案:

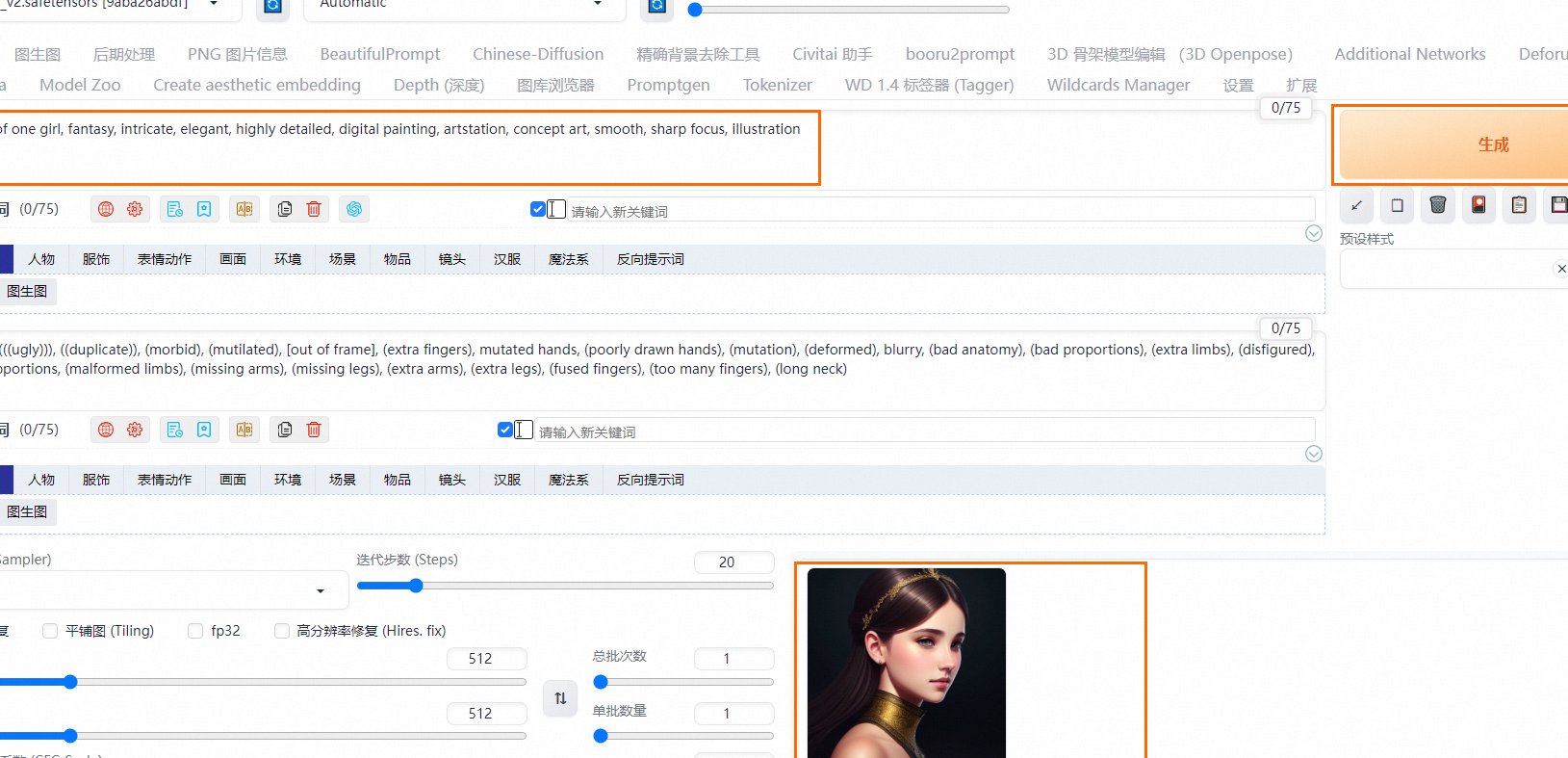

- 训练阶段:支持 DreamBooth 个性化微调,显存消耗降低 5.6 倍,训练速度提升 7.73 倍。

- 推理阶段:Int8 量化技术让 Stable Diffusion 2.0 推理显存仅需 3.1GB,生成速度还能提升 1.42 倍。

实测中,用 Colossal-AI 优化后的模型生成 100 张 4K 图片,成本比传统方案节省 1270 元,相当于每天白捡一杯咖啡钱。

- 开发者友好度爆表

即使是 AI 新手也能快速上手:

- 提供 Hugging Face、PyTorch Lightning 等主流框架原生支持,代码迁移成本几乎为零。

- 社区有详细的Docker 镜像教程,5 分钟就能搭建本地开发环境,连 GPU 驱动都不用手动安装。

💡 阿里云百炼:企业级 AIGC 成本管控专家

📊 灵活计费策略解析

- 按 Token 计费:成本透明无坑

基础模型如通义千问 3-8B 仅需0.006 元 / 千 Token,生成 1 万字文章成本不到 6 分钱。对于高频使用场景,还能购买节省计划,提前锁定低价额度,平均成本再降 30%。

某电商团队用通义千问生成商品详情页,每月 Token 消耗约 500 万,通过节省计划直接省下 2100 元,相当于多招了一个兼职文案。

- 独占实例:高并发场景的成本锚点

对于日调用量超百万次的企业,百炼提供独占实例服务,按小时计费(最低 0.5 元 / 小时),支持弹性扩缩容。某物流企业用独占实例部署智能客服,在双 11 峰值期并发量提升 5 倍,成本仅增加 1.2 倍。

- 混合推理优化:隐性成本杀手

平台自动优化模型调用链路,比如将 70% 的请求导向低成本模型(如通义千问 3-8B),30% 复杂任务交给高性能模型(如 DeepSeek-R1),整体成本降低 40% 的同时,响应速度还提升了 20%。

🚦 使用避坑指南

- 数据预处理:上传知识库时建议先做重复数据清洗,实测可减少 30% 的无效 Token 消耗。

- 缓存策略:开启Context Cache 模式后,命中缓存的 Token 费用仅为原价的 40%,适合对话类场景。

- 模型热更新:定期淘汰低使用率模型,某教育机构停用 3 个冷门模型后,月成本下降 18%。

🎯 DeepSeek:性价比之王的日常生成方案

🛠️ 高效使用技巧

- Prompt 工程模板

- 营销文案:

"为[产品名称]写3条小红书爆款标题,风格活泼,带emoji" - 代码生成:

"用Python写一个Flask接口,实现用户注册功能,要求包含JWT认证"

实测用这套模板生成内容,准确率提升 50%,返工率降低 70%。

- 营销文案:

- 批量任务优化

利用 DeepSeek 的Batch 调用接口,单次提交 1000 条请求可享受50% 折扣,某新媒体工作室批量生成公众号推文,月成本从 3000 元降至 1200 元。

- 内容验证机制

针对 DeepSeek 的幻觉问题,建议搭配Claude 4 sonnet进行二次校验:

- 先用 DeepSeek 生成初稿

- 再用 Claude 执行

"检查以下内容的事实准确性,标注错误点"

某科技媒体采用这种组合,内容错误率从 45% 降至 6%,同时保持成本优势。

📈 降本效果对比实测

| 场景 | 传统方案成本 | Colossal-AI 方案 | 阿里云百炼方案 | DeepSeek 方案 |

|---|---|---|---|---|

| 图像生成(100 张 4K) | 1580 元 | 34 元(节省 97.8%) | 120 元(节省 92.4%) | 80 元(节省 94.9%) |

| 企业级客服系统 | 8500 元 / 月 | 1800 元 / 月(节省 78.8%) | 2900 元 / 月(节省 65.9%) | 不适用 |

| 日常内容生成(10 万 Token) | 250 元 | 不适用 | 60 元(节省 76%) | 20 元(节省 92%) |

🚨 避坑指南与趋势洞察

- 技术选型陷阱

- 避免盲目追求最新型号,比如 Stable Diffusion 2.0 的硬件需求比 1.5 高 3 倍,但生成质量提升仅 15%。

- 优先选择混合精度训练(FP16+INT8),实测可在损失 < 1% 精度的前提下,降低 50% 训练成本。

- 成本监控工具

- 阿里云百炼的费用中心能按模型、按部门拆分账单,实时预警超支风险。

- Colossal-AI 的显存监控插件可动态调整 Batch Size,避免资源浪费。

- 未来趋势预判

- 边缘计算 AIGC:2025 年手机端模型推理将普及,本地运行成本比云端低 80%。

- RAG+AIGC:结合企业私有知识库的智能问答系统,可减少 60% 的外部 API 调用费用。

🌟 终极降本组合拳

- 技术层:用 Colossal-AI 训练基础模型,成本压缩 46 倍。

- 平台层:通过阿里云百炼实现多模型调度,成本再降 30%。

- 应用层:用 DeepSeek 处理日常生成任务,边际成本趋近于零。

🔗立即免费注册 开始体验工具箱 - 朱雀 AI 味降低到 0%- 降 AI 去 AI 味