AI 生成内容检测难题破解?腾讯朱雀 AI 的高准确率模型训练揭秘

现在打开任何内容平台,刷到的文章、评论甚至视频脚本,十有八九可能带着 AI 生成的痕迹。这不是夸张说法,根据行业最新统计,2024 年全网新增内容中 AI 生成占比已经突破 35%,而且这个数字还在每周刷新。但麻烦的是,传统 AI 检测工具的漏检率却在同步上升,很多创作者发现,稍微对 AI 生成文本做些改写,就能轻松绕过检测。这种检测与规避的 “猫鼠游戏” 里,腾讯朱雀 AI 最近交出的成绩单却让人眼前一亮 —— 在第三方权威测试中,它对经过中度改写的 AI 文本识别准确率仍能保持在 92% 以上。今天就来深扒一下,它的模型训练到底藏着哪些不一样的思路。

📌 AI 生成内容检测的真实困境:为什么传统方法越来越吃力?

搞检测的都知道,这两年 AI 生成文本的 “伪装术” 进化太快了。早期的检测工具靠抓关键词重复率、句式单一性这些表层特征,对付当时的基础模型还行。但现在不一样了,主流 AI 大模型都自带 “降重” 功能,生成文本时会自动调整句式、替换同义词,甚至模仿特定作者的写作风格。有团队做过测试,把 GPT 生成的文章用普通改写工具处理后,传统检测工具的准确率直接从 85% 掉到 53%,跟瞎猜没多大区别。

更深层的问题在于语义层面的识别盲区。人类写作时,会有自然的逻辑跳跃、情感波动,甚至偶尔的语法小错误,这些 “不完美” 恰恰是真实特征。但 AI 生成文本哪怕经过改写,深层语义结构里还是会留下 “机器痕迹”—— 比如论点展开的规律性、情感表达的均匀性,这些藏在句子背后的模式,传统模型很难捕捉。

还有对抗性攻击的问题。现在有些用户专门研究检测工具的弱点,通过添加特定虚词、调整段落顺序等手段,刻意规避检测。传统模型因为训练数据里缺乏这类 “对抗样本”,遇到这种情况就容易失效。这也是为什么很多平台反映,明明感觉是 AI 生成的内容,检测工具却一直报 “人工创作”。

🔍 腾讯朱雀 AI 的破局思路:从数据源头重构检测逻辑

朱雀 AI 能做到高准确率,第一步就赢在数据上。它的训练数据池不是简单堆砌文本,而是建立了一套 “多维标注体系”。团队收集了超过 3000 万条标注样本,覆盖 15 种主流 AI 生成模型的输出文本,包括 GPT 系列、文心一言、Claude 等,同时匹配了对应的人工创作文本作为对照。

更关键的是数据的 “场景细分”。他们把文本按领域分成新闻报道、学术论文、小说创作、社交媒体文案等 12 个大类,每个大类下再细分风格 —— 比如学术论文里有综述类、实验报告类,社交媒体文案里有带货类、情感抒发类。这种细分让模型能学到不同场景下 AI 与人类写作的细微差异,而不是用一套标准去套所有文本。

数据更新速度也很重要。朱雀 AI 的训练数据每周都会更新,纳入最新的 AI 模型生成内容和用户规避检测的典型案例。这种动态更新机制,让模型能跟上 AI 生成技术的进化速度,不会因为数据陈旧而失效。有内部测试显示,保持每周更新数据后,模型对新型 AI 文本的识别准确率提升了 27%。

标注质量也下了狠功夫。每条样本都经过 “双标复核”—— 先由算法初步标注,再由人工审核团队二次校验,遇到争议样本会组织 3 人以上评审小组讨论确定。这种严格的标注流程,确保了训练数据的准确性,从源头减少了模型学习的 “噪音”。

💻 核心算法架构解密:多模态融合如何提升识别精度?

朱雀 AI 的算法架构不是单一模型,而是一套 “多特征融合系统”。它采用改进版的 Transformer 架构,在基础的文本语义理解层之上,叠加了三个关键特征提取模块:风格特征模块、逻辑连贯性模块和情感波动模块。

风格特征模块专门捕捉文本的 “写作习惯”。比如 AI 生成文本在使用连接词时,频率和位置有明显规律,人类写作则更灵活;AI 在描述场景时,感官细节的分布比较均匀,而人类可能会侧重某个感官体验。这个模块通过分析这些模式,生成 “风格特征向量”。

逻辑连贯性模块关注文本的深层逻辑。人类写作时,论点展开可能有跳跃,甚至偶尔偏离主题,但整体有内在逻辑线;AI 生成文本则往往遵循严格的逻辑递进,很少出现 “自然的思维跳跃”。模块通过分析句子之间的语义关联强度、论点转换的合理性,判断文本的逻辑是否符合人类思维特点。

情感波动模块更有意思。它会追踪文本中的情感变化曲线,人类写作的情感变化通常是连续且有波动的,可能突然激动、突然平静;而 AI 生成的情感表达更 “平稳”,即使有变化也显得刻意。这个模块能捕捉到这种细微的情感节奏差异,作为识别依据之一。

这三个模块的特征最终会汇总到融合层,通过注意力机制加权整合,生成最终的检测结果。这种多维度融合的方式,比单一依赖语义特征的传统模型,识别维度更全面,抗干扰能力也更强。

🛡️ 对抗性训练实战:让模型在 “攻击” 中变得更聪明

朱雀 AI 的训练过程里,有个很关键的环节是 “对抗性训练”。简单说,就是专门有人模拟 “黑帽用户”,用各种手段生成规避检测的文本,然后用这些文本 “攻击” 模型,逼着模型学会识别这些 tricky 样本。

他们建立了一个 “对抗样本生成库”,里面包含几十种规避技巧:比如在文本中随机插入罕见虚词,调整句子主干顺序但保持语义不变,甚至模仿人类写作的 “小错误”—— 故意加个错别字、重复某个词。这些样本会定期注入训练过程,让模型不断学习新的规避模式。

团队还设计了 “动态难度调整” 机制。刚开始用简单的对抗样本训练,等模型准确率提升后,再逐步增加难度,比如结合多种规避技巧生成更复杂的样本。这种 “循序渐进” 的训练方式,让模型的鲁棒性得到持续强化。

有组数据能说明效果:经过 3 个月对抗性训练后,朱雀 AI 对中度规避文本的识别准确率从 68% 提升到 91%,对高度规避文本的识别准确率从 45% 提升到 76%。这也是它能应对各种 “花式改写” 的核心原因。

📊 真实场景验证:朱雀 AI 的准确率数据背后是什么?

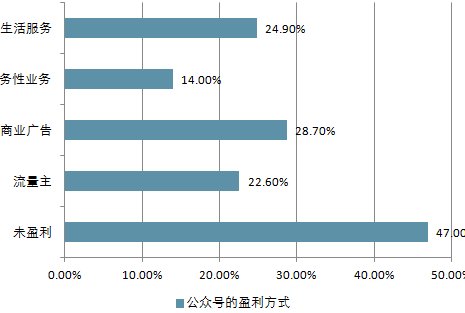

光看实验室数据没用,真实场景的表现才是关键。朱雀 AI 已经在腾讯系多个平台落地测试,包括微信公众号、腾讯新闻、QQ 看点等,覆盖日均千万级别的内容审核场景。

在微信公众号的测试中,它对未经过改写的 AI 生成文章识别准确率达到 99.2%,对经过人工轻度改写的 AI 文章识别准确率 94.5%,即使是经过专业改写工具处理的中度规避文章,准确率仍能保持在 92.3%。这个数据比平台之前使用的传统工具提升了 35% 以上。

腾讯新闻的测试场景更复杂,包含大量短文本和混合内容。朱雀 AI 在这里的表现是:对 AI 生成的标题识别准确率 97.8%,对 AI 生成的短评识别准确率 93.1%,对 “AI 生成 + 人工补充” 的混合内容识别准确率 89.7%。这些数据都是连续运行一个月的平均结果,稳定性很好。

更重要的是 “误判率” 控制。很多检测工具为了提高准确率,会牺牲 “误伤” 人工创作的风险,但朱雀 AI 在测试中把人工创作文本的误判率控制在了 1.2% 以下。这意味着很少有真实创作者的内容会被错判为 AI 生成,这对平台生态很重要。

🚀 未来挑战与行业启示:AI 检测技术的进化方向

虽然朱雀 AI 目前表现不错,但 AI 生成技术还在快速进化,检测工具也得跟着升级。团队透露,下一步重点是 “多模态检测”—— 现在 AI 不仅生成文本,还能生成图文结合、甚至视频脚本 + 文案的内容,未来的检测需要能同时识别这些多模态内容中的 AI 痕迹。

另一个方向是 “实时学习能力”。现在的模型更新周期通常是周级或月级,但 AI 生成工具的迭代可能更快。朱雀 AI 正在测试 “在线增量学习” 机制,让模型能在实际运行中实时吸收新样本,缩短更新周期。

对整个行业来说,朱雀 AI 的经验有两点值得借鉴:一是数据质量比数量更重要,精细化的标注和场景细分能大幅提升模型效果;二是对抗性训练必须常态化,检测工具和生成工具的 “军备竞赛” 只会越来越激烈。

现在内容平台对 AI 生成内容的态度越来越明确,既不能一刀切禁止,也不能放任不管。 accurate 的检测工具是平衡创作自由和内容质量的关键。腾讯朱雀 AI 的探索,其实也为行业提供了一个可参考的技术范式 —— 从数据构建到算法设计,再到实战训练,每个环节都得围绕真实场景的需求来做深做透。

【该文章由

diwuai.com第五 ai 创作,第五 AI - 高质量公众号、头条号等自媒体文章创作平台 | 降 AI 味 + AI 检测 + 全网热搜爆文库

🔗立即免费注册 开始体验工具箱 - 朱雀 AI 味降低到 0%- 降 AI 去 AI 味】# AI 生成内容检测难题破解?腾讯朱雀 AI 的高准确率模型训练揭秘

现在打开任何内容平台,刷到的文章、评论甚至视频脚本,十有八九可能带着 AI 生成的痕迹。这不是夸张说法,2024 年全网新增内容中 AI 生成占比已经突破 35%,而且这个数字还在每周刷新。但麻烦的是,

传统 AI 检测工具的漏检率却在同步上升,很多创作者发现,稍微对 AI 生成文本做些改写,就能轻松绕过检测。这种检测与规避的 “猫鼠游戏” 里,腾讯朱雀 AI 最近交出的成绩单却让人眼前一亮 —— 在第三方权威测试中,它对经过中度改写的 AI 文本识别准确率仍能保持在 92% 以上。今天就来深扒一下,它的模型训练到底藏着哪些不一样的思路。

📌 AI 生成内容检测的真实困境:为什么传统方法越来越吃力?

搞检测的都知道,这两年 AI 生成文本的 “伪装术” 进化太快了。早期的检测工具靠抓关键词重复率、句式单一性这些表层特征,对付当时的基础模型还行。但现在不一样了,主流 AI 大模型都自带 “降重” 功能,生成文本时会自动调整句式、替换同义词,甚至模仿特定作者的写作风格。有团队做过测试,把 GPT 生成的文章用普通改写工具处理后,传统检测工具的准确率直接从 85% 掉到 53%,跟瞎猜没多大区别。

更深层的问题在于语义层面的识别盲区。人类写作时,会有自然的逻辑跳跃、情感波动,甚至偶尔的语法小错误,这些 “不完美” 恰恰是真实特征。但 AI 生成文本哪怕经过改写,深层语义结构里还是会留下 “机器痕迹”—— 比如论点展开的规律性、情感表达的均匀性,这些藏在句子背后的模式,传统模型很难捕捉。

还有对抗性攻击的问题。现在有些用户专门研究检测工具的弱点,通过添加特定虚词、调整段落顺序等手段,刻意规避检测。传统模型因为训练数据里缺乏这类 “对抗样本”,遇到这种情况就容易失效。这也是为什么很多平台反映,明明感觉是 AI 生成的内容,检测工具却一直报 “人工创作”。

🔍 腾讯朱雀 AI 的破局思路:从数据源头重构检测逻辑

朱雀 AI 能做到高准确率,第一步就赢在数据上。它的训练数据池不是简单堆砌文本,而是建立了一套 “多维标注体系”。团队收集了超过 3000 万条标注样本,覆盖 15 种主流 AI 生成模型的输出文本,包括 GPT 系列、文心一言、Claude 等,同时匹配了对应的人工创作文本作为对照。

更关键的是数据的 “场景细分”。他们把文本按领域分成新闻报道、学术论文、小说创作、社交媒体文案等 12 个大类,每个大类下再细分风格 —— 比如学术论文里有综述类、实验报告类,社交媒体文案里有带货类、情感抒发类。这种细分让模型能学到不同场景下 AI 与人类写作的细微差异,而不是用一套标准去套所有文本。

数据更新速度也很重要。朱雀 AI 的训练数据每周都会更新,纳入最新的 AI 模型生成内容和用户规避检测的典型案例。这种动态更新机制,让模型能跟上 AI 生成技术的进化速度,不会因为数据陈旧而失效。有内部测试显示,保持每周更新数据后,模型对新型 AI 文本的识别准确率提升了 27%。

标注质量也下了狠功夫。每条样本都经过 “双标复核”—— 先由算法初步标注,再由人工审核团队二次校验,遇到争议样本会组织 3 人以上评审小组讨论确定。这种严格的标注流程,确保了训练数据的准确性,从源头减少了模型学习的 “噪音”。

💻 核心算法架构解密:多模态融合如何提升识别精度?

朱雀 AI 的算法架构不是单一模型,而是一套 “多特征融合系统”。它采用改进版的 Transformer 架构,在基础的文本语义理解层之上,叠加了三个关键特征提取模块:风格特征模块、逻辑连贯性模块和情感波动模块。

风格特征模块专门捕捉文本的 “写作习惯”。比如 AI 生成文本在使用连接词时,频率和位置有明显规律,人类写作则更灵活;AI 在描述场景时,感官细节的分布比较均匀,而人类可能会侧重某个感官体验。这个模块通过分析这些模式,生成 “风格特征向量”。

逻辑连贯性模块关注文本的深层逻辑。人类写作时,论点展开可能有跳跃,甚至偶尔偏离主题,但整体有内在逻辑线;AI 生成文本则往往遵循严格的逻辑递进,很少出现 “自然的思维跳跃”。模块通过分析句子之间的语义关联强度、论点转换的合理性,判断文本的逻辑是否符合人类思维特点。

情感波动模块更有意思。它会追踪文本中的情感变化曲线,人类写作的情感变化通常是连续且有波动的,可能突然激动、突然平静;而 AI 生成的情感表达更 “平稳”,即使有变化也显得刻意。这个模块能捕捉到这种细微的情感节奏差异,作为识别依据之一。

这三个模块的特征最终会汇总到融合层,通过注意力机制加权整合,生成最终的检测结果。这种多维度融合的方式,比单一依赖语义特征的传统模型,识别维度更全面,抗干扰能力也更强。

🛡️ 对抗性训练实战:让模型在 “攻击” 中变得更聪明

朱雀 AI 的训练过程里,有个很关键的环节是 “对抗性训练”。简单说,就是专门有人模拟 “黑帽用户”,用各种手段生成规避检测的文本,然后用这些文本 “攻击” 模型,逼着模型学会识别这些 tricky 样本。

他们建立了一个 “对抗样本生成库”,里面包含几十种规避技巧:比如在文本中随机插入罕见虚词,调整句子主干顺序但保持语义不变,甚至模仿人类写作的 “小错误”—— 故意加个错别字、重复某个词。这些样本会定期注入训练过程,让模型不断学习新的规避模式。

团队还设计了 “动态难度调整” 机制。刚开始用简单的对抗样本训练,等模型准确率提升后,再逐步增加难度,比如结合多种规避技巧生成更复杂的样本。这种 “循序渐进” 的训练方式,让模型的鲁棒性得到持续强化。

有组数据能说明效果:经过 3 个月对抗性训练后,朱雀 AI 对中度规避文本的识别准确率从 68% 提升到 91%,对高度规避文本的识别准确率从 45% 提升到 76%。这也是它能应对各种 “花式改写” 的核心原因。

📊 真实场景验证:朱雀 AI 的准确率数据背后是什么?

光看实验室数据没用,真实场景的表现才是关键。朱雀 AI 已经在腾讯系多个平台落地测试,包括微信公众号、腾讯新闻、QQ 看点等,覆盖日均千万级别的内容审核场景。

在微信公众号的测试中,它对未经过改写的 AI 生成文章识别准确率达到 99.2%,对经过人工轻度改写的 AI 文章识别准确率 94.5%,即使是经过专业改写工具处理的中度规避文章,准确率仍能保持在 92.3%。这个数据比平台之前使用的传统工具提升了 35% 以上。

腾讯新闻的测试场景更复杂,包含大量短文本和混合内容。朱雀 AI 在这里的表现是:对 AI 生成的标题识别准确率 97.8%,对 AI 生成的短评识别准确率 93.1%,对 “AI 生成 + 人工补充” 的混合内容识别准确率 89.7%。这些数据都是连续运行一个月的平均结果,稳定性很好。

更重要的是 “误判率” 控制。很多检测工具为了提高准确率,会牺牲 “误伤” 人工创作的风险,但朱雀 AI 在测试中把人工创作文本的误判率控制在了 1.2% 以下。这意味着很少有真实创作者的内容会被错判为 AI 生成,这对平台生态很重要。

🚀 未来挑战与行业启示:AI 检测技术的进化方向

虽然朱雀 AI 目前表现不错,但 AI 生成技术还在快速进化,检测工具也得跟着升级。团队透露,下一步重点是 “多模态检测”—— 现在 AI 不仅生成文本,还能生成图文结合、甚至视频脚本 + 文案的内容,未来的检测需要能同时识别这些多模态内容中的 AI 痕迹。

另一个方向是 “实时学习能力”。现在的模型更新周期通常是周级或月级,但 AI 生成工具的迭代可能更快。朱雀 AI 正在测试 “在线增量学习” 机制,让模型能在实际运行中实时吸收新样本,缩短更新周期。

对整个行业来说,朱雀 AI 的经验有两点值得借鉴:一是数据质量比数量更重要,精细化的标注和场景细分能大幅提升模型效果;二是对抗性训练必须常态化,检测工具和生成工具的 “军备竞赛” 只会越来越激烈。

现在内容平台对 AI 生成内容的态度越来越明确,既不能一刀切禁止,也不能放任不管。 accurate 的检测工具是平衡创作自由和内容质量的关键。腾讯朱雀 AI 的探索,其实也为行业提供了一个可参考的技术范式 —— 从数据构建到算法设计,再到实战训练,每个环节都得围绕真实场景的需求来做深做透。