🕵️♂️ 大模型文本的 "照妖镜":朱雀 AI 检测到底是什么

现在网上随便刷篇文章、看段评论,你都可能在想 —— 这玩意儿是不是 AI 写的?ChatGPT、文心一言这些大模型越来越能 "装人",生成的文本有时候比真人写的还流畅。但问题来了,学术论文里的 AI 代写、营销号的批量生成内容、甚至新闻报道里的机器创作,这些东西混在真人文本里,早就开始扰乱信息环境了。

朱雀 AI 检测就是冲着这个问题来的。简单说,它是一款专门用来识别文本是否由大语言模型生成的工具。不管是 ChatGPT 的 "严谨风",还是 Claude 的 "口语化",只要是 AI 写的,它都能扒出痕迹。别以为这只是个简单的文字比对工具,它背后的技术复杂度,其实和那些生成文本的大模型不相上下。

有意思的是,朱雀 AI 检测的诞生本身就带着点 "对抗" 意味。大模型在不断优化自己的 "伪装术",让生成文本更像人类创作;而朱雀这类工具就在同步升级 "识别术",专挑 AI 暴露的马脚。现在业内都在说,这俩就像矛和盾,逼着对方不停进化。

🧠 看穿 AI 的 "语言密码":朱雀检测的核心原理

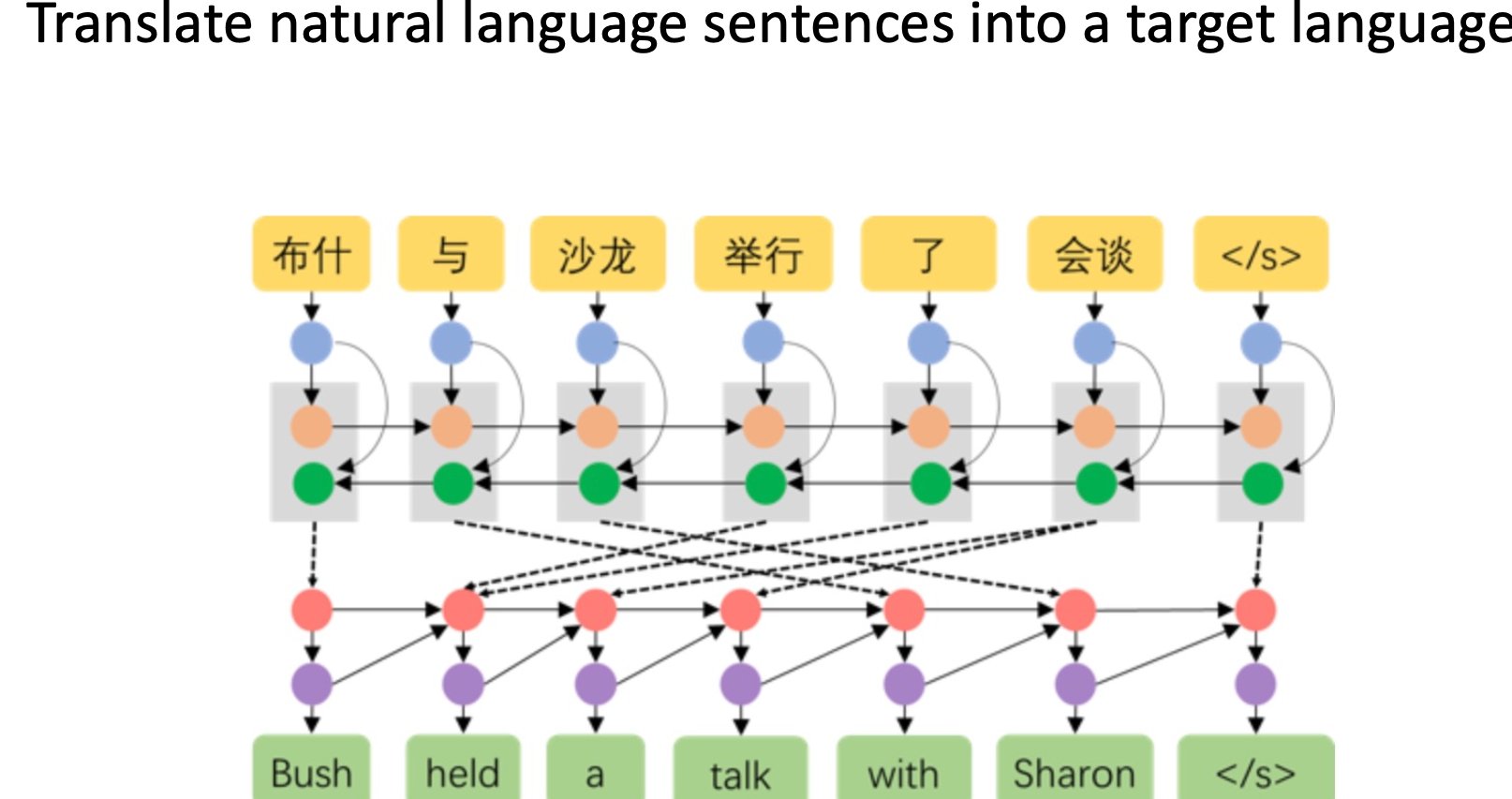

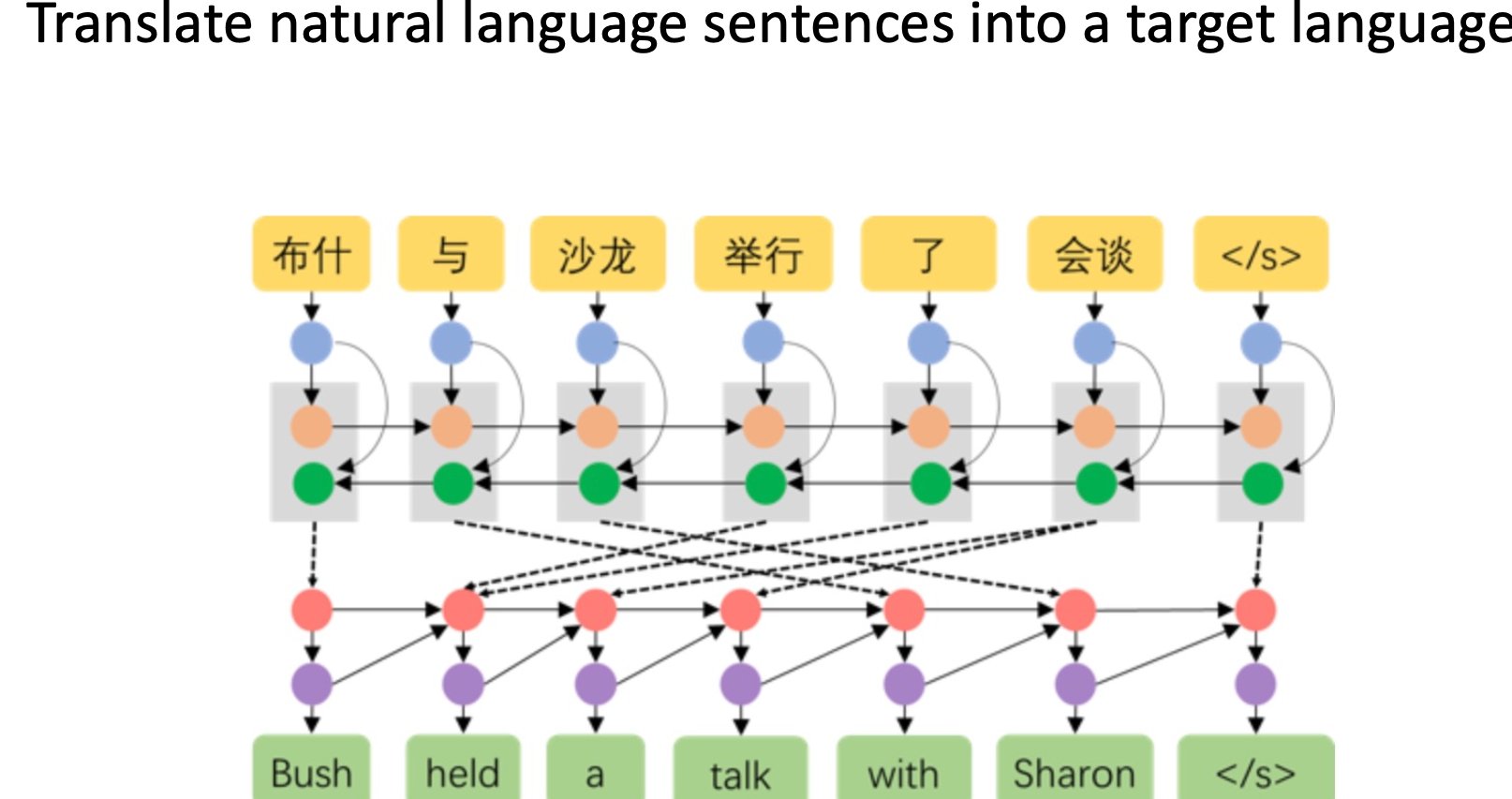

想知道朱雀怎么认出 AI 文本的?得先明白大模型写东西和人有啥不一样。人类写作时,脑子里的想法是跳跃的,可能突然加个短句,可能某个词用得特别随意,甚至偶尔出现点小语病。但 AI 不一样,它生成文本更像是在 "计算概率",总是倾向于选最可能的词、最顺的句式,反而少了人类那种自然的 "不完美"。

朱雀 AI 检测的第一个撒手锏,就是捕捉这种 "过度完美" 的语言模式。它会分析文本里的词汇选择频率、句式结构变化、语义转折的自然度。比如某个话题下,人类可能会交替使用 "人工智能" 和 "AI",但 AI 可能更倾向于保持一致性。这种细微的差异,朱雀能通过大数据训练出来的模型精准识别。

再深一层,它还会看语义连贯性的 "断层"。大模型虽然能把句子接得很顺,但长文本里经常出现 "表面连贯,深层脱节" 的情况。比如写一篇关于环保的文章,人类可能会从个人行为跳到政策影响,中间带点主观感受;AI 却可能在逻辑转换上显得生硬,或者在某个论点上重复啰嗦。朱雀能抓住这些隐藏的 "逻辑裂缝"。

还有个关键技术叫特征指纹提取。不同大模型生成的文本,其实都带着自己的 "指纹"。就像每个人的笔迹有特点,ChatGPT 和通义千问的 "笔风" 也有差异。朱雀通过分析海量标注数据,已经给主流大模型建立了特征库,只要文本里出现对应模型的典型特征,就能快速匹配识别。

🚀 凭什么比别人强?朱雀的技术优势拆解

市面上 AI 检测工具不少,朱雀能站稳脚跟,靠的是实打实的技术硬实力。最让人服气的一点,是它对新模型的快速适配能力。大模型更新换代太快了,上个月刚吃透 GPT-4 的特点,这个月 GPT-4o 又出来了。朱雀背后的团队好像总能跟上节奏,基本上新模型发布后一周内,就能完成检测算法的更新。

这背后是它的动态学习架构在起作用。普通检测工具可能用固定的算法模型,遇到新类型的 AI 文本就容易 "失灵"。但朱雀采用的是持续迭代的训练模式,每天都会用最新的 AI 生成文本和人类创作内容进行对比学习。就像一个经验丰富的侦探,每天都在研究新的犯罪手法,自然不容易被蒙骗。

检测准确率是另一个撒手锏。现在行业内公开的数据里,朱雀对主流大模型生成文本的识别率能稳定在 95% 以上,哪怕是经过人工轻微修改的 AI 文本,也有超过 80% 的检出率。这比很多同类工具高出一大截。更关键的是误判率极低,不到 3%—— 意思是把真人写的文本错当成 AI 的概率很小,这对学术论文检测这类场景来说太重要了。

还有个细节能看出技术功底:朱雀能识别出文本里 "AI + 人类" 混合创作的情况。现在很多人喜欢用 AI 写初稿,自己再改改。这种 "半 AI" 文本,普通工具要么全算 AI,要么全算人类。但朱雀能标出哪些段落更可能是 AI 生成的,哪些明显经过人类修改,给用户一个更精细的判断依据。

📊 不止于 "识别":朱雀的场景化应用价值

别以为朱雀 AI 检测只适合学术打假,其实它的应用场景比想象中广得多。现在很多内容平台都在担心 AI 生成内容泛滥,比如自媒体平台如果全是机器写的水文,用户迟早会跑光。朱雀能帮这些平台建立内容过滤机制,给 AI 生成的内容打上标签,或者限制过度发布。

教育领域更是刚需。大学里的论文查重早就不够用了,现在老师更怕学生用 AI 写作业、写论文。有学校已经开始试点,要求学生提交作业时必须附带朱雀的检测报告。这不是不信任学生,而是想在 AI 时代守住学术诚信的底线。有意思的是,自从用了这个工具,学生们写东西反而更认真了 —— 知道 AI 代写容易被抓,不如自己踏踏实实写。

营销行业也在悄悄用。有些公司发现,用 AI 批量生成的推广文案,转化率其实不如真人写的。他们就用朱雀检测自家的营销内容,找出那些 "AI 感太重" 的段落,再让文案师重新润色。结果发现,经过 "去 AI 化" 处理的内容,用户停留时间能提高 30% 以上。

甚至连出版社都开始用它。现在很多畅销书背后都有 AI 辅助写作,但读者其实更想知道哪些部分是作者亲笔,哪些是 AI 帮忙的。有出版社尝试在书的后记里附上朱雀的检测分析,反而提升了读者的信任感。

⚔️ 对抗升级:AI 检测与大模型的 "军备竞赛"

大模型不会坐以待毙,这是肯定的。现在已经有模型开始专门训练 "反检测" 能力了。比如有些工具声称能让 AI 生成的文本躲过检测,方法五花八门 —— 有的故意加几个错别字,有的打乱句式结构,有的甚至模仿人类写作时的犹豫和重复。

朱雀团队的应对策略挺有意思,他们不搞 "以不变应万变",而是主动拥抱这种对抗。他们专门建了个 "对抗样本库",收集各种经过伪装的 AI 文本,每天用这些样本训练检测模型。就像病毒和疫苗的关系,新的 "病毒变种" 出来,对应的 "疫苗" 很快就跟上。

这种对抗其实推动了整个行业的进步。大模型为了躲过检测,不得不让生成文本更接近人类真实表达,少了些机械感;而检测工具为了提高识别率,也在不断深化对人类语言规律的理解。长远看,这种 "互相较劲" 反而可能让 AI 生成内容的质量更高,更符合人类的阅读习惯。

不过话说回来,AI 检测工具也有自己的边界。现在业内有个共识:没有 100% 准确的检测工具。毕竟人类写作风格千差万别,有些人写的东西比 AI 还规整,有些人又喜欢用很跳脱的表达方式。所以朱雀这类工具更像是个 "辅助判断" 的角色,最终还是需要人来做决策。

💡 普通人该怎么用?朱雀的实用技巧

如果你只是想偶尔查查某段文字是不是 AI 写的,朱雀的基础功能其实很简单。打开官网,把文本粘贴进去,点一下检测按钮,几秒后就能看到结果。报告里会标出来文本的 AI 概率,还会用不同颜色标出可疑段落,红色表示 "极可能是 AI 生成",黄色是 "有 AI 特征",绿色就是 "更像人类创作"。

但想用好这个工具,还是有技巧的。比如检测长文本时,最好分段检测。因为有些文章可能前半部分是真人写的,后半部分用了 AI 辅助,整段检测容易出现偏差。分段查能更精准地定位 AI 生成的部分。

还有个小窍门:如果检测结果显示 "AI 概率中等",可以试着把文本换几种格式再测。比如把段落拆成短句,或者合并几个句子,有时候格式变化会让检测结果更清晰。这不是说工具不准,而是因为 AI 生成文本的特征有时候和格式相关。

对于经常需要处理大量文本的人,比如编辑、老师,可以试试 API 接口。把朱雀的检测功能集成到自己常用的软件里,比如 Word 插件、浏览器扩展,这样不用来回切换页面,效率能提高不少。现在很多教育机构和媒体都这么做,已经成了行业里的小趋势。

最后想说的是,用这类工具别太较真。它本质上是个辅助工具,不是绝对权威。有时候人类写出的句子也会被标为 "可疑",这很正常 —— 毕竟语言这东西,本来就没有绝对的 "人类模式" 或 "AI 模式"。